PyTorch模型验证:回调函数在验证过程中的进阶应用

发布时间: 2024-12-11 15:01:27 阅读量: 14 订阅数: 16

PyTorch模型Checkpoint:高效训练与恢复的策略

# 1. PyTorch模型验证的基础知识

## 1.1 模型验证的必要性

在深度学习模型开发过程中,模型验证是一个关键步骤,它确保模型在未知数据上的表现与在训练数据上一样优秀。验证不仅可以评估模型的泛化能力,还能够帮助我们在模型过拟合和欠拟合之间找到平衡点。

## 1.2 PyTorch中的验证方法

PyTorch提供了多种工具和函数来支持模型验证。最常用的包括`torch.utils.data.DataLoader`用于数据加载,`torch.nn.Module`中的方法用于定义模型结构,以及`torch.optim`模块中的优化器来调整模型权重。PyTorch的验证方法不仅限于简单的损失计算,还包括了自定义的回调函数,这样可以灵活地在验证过程中加入各种自定义的验证步骤和逻辑。

## 1.3 验证流程概览

一个典型的PyTorch模型验证流程包括以下步骤:

1. 数据准备:使用`DataLoader`加载验证集数据。

2. 模型评估:设置模型为评估模式(`model.eval()`),关闭如Dropout和Batch Normalization中的随机操作。

3. 验证循环:遍历验证数据集,计算模型的预测结果和验证指标。

4. 结果记录:记录验证结果,如准确率和损失值,用于分析模型性能。

```python

# 示例代码:简单的PyTorch验证循环

model.eval() # 将模型设置为评估模式

total_loss = 0

correct = 0

with torch.no_grad(): # 关闭梯度计算,节省内存

for data, target in validation_loader:

output = model(data)

loss = criterion(output, target)

total_loss += loss.item() * data.size(0)

pred = output.argmax(dim=1, keepdim=True)

correct += pred.eq(target.view_as(pred)).sum().item()

avg_loss = total_loss / len(validation_loader.dataset)

print(f'Validation set: Average loss: {avg_loss:.4f}, Accuracy: {correct}/{len(validation_loader.dataset)} ({100. * correct / len(validation_loader.dataset):.0f}%)')

```

该代码段展示了如何在PyTorch中执行一个简单的验证流程,包括模型评估模式的设置、损失计算、预测结果统计以及输出验证结果。

通过本章的学习,读者将对PyTorch模型验证的基本概念有一个清晰的理解,为后续深入讨论回调函数的应用打下坚实的基础。

# 2. 回调函数的理论与实践

## 2.1 回调函数的基本概念

### 2.1.1 回调函数定义与重要性

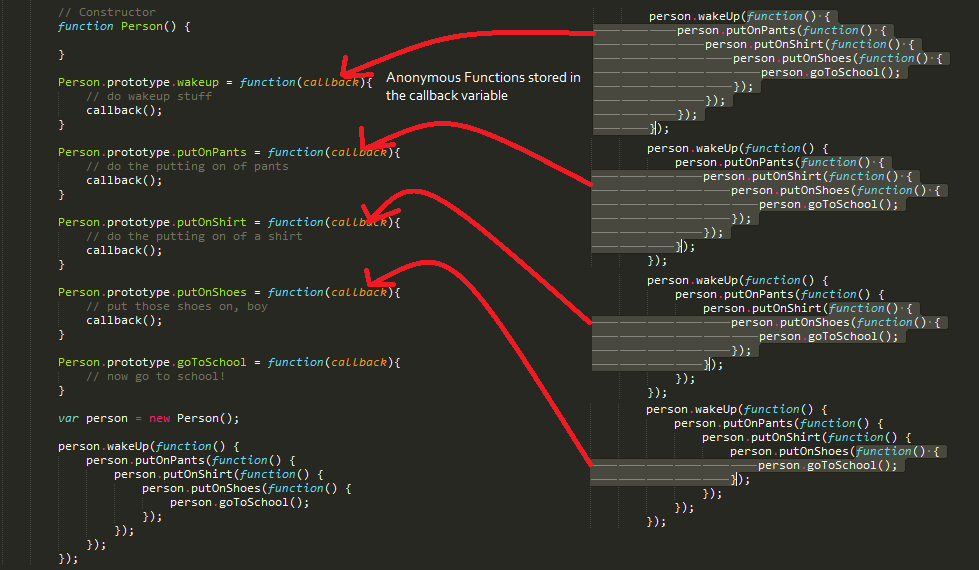

回调函数在计算机编程中是一种常见的设计模式,用于在特定时刻被调用以执行代码。其重要性在于,它允许程序员在不直接修改原始函数或者模块的情况下,提供自定义的处理逻辑。在深度学习框架如PyTorch中,回调函数通常在训练循环的特定阶段被触发,如每个epoch后,使得开发者可以插入自定义的代码块,比如模型保存、性能评估、早停等操作。

回调函数的定义简单来说就是:一个作为参数传递给其他函数的函数。当其他函数需要执行时,它们会在合适的时间执行这个回调函数。在PyTorch中,回调函数通常与`Trainer`对象关联,可以在模型训练的特定时刻被触发。

### 2.1.2 回调函数在PyTorch中的实现原理

在PyTorch中,回调函数的实现依托于`Trainer`对象,该对象在训练过程中会不断调用不同的回调方法。这些回调方法定义在`Callback`类中,包括但不限于`on_train_start`, `on_epoch_end`, `on_train_end`等。自定义的回调函数可以通过继承`Callback`类并重写这些方法来实现。

当训练开始时,`Trainer`会遍历所有注册的回调对象,并在适当的时间点调用这些对象的相应方法。由于这些方法都带有`@trainer.on_phase`这样的装饰器,所以它们的调用时机是预定义好的。例如,`on_epoch_end`会在每个epoch结束时被调用,而开发者可以在其中插入任何需要在epoch结束时执行的逻辑。

```python

class CustomCallback(Callback):

def on_epoch_end(self, trainer, model):

# 自定义的回调逻辑,在每个epoch结束时执行

# 例如保存当前最佳模型

current_loss = trainer.state.metrics['loss']

if current_loss < trainer.best_loss:

trainer.best_loss = current_loss

# 保存模型

torch.save(model.state_dict(), "best_model.pth")

```

## 2.2 实践案例:自定义回调函数

### 2.2.1 创建一个简单的回调函数

为了演示回调函数的实际应用,我们可以创建一个简单的回调函数,该函数会在每个epoch结束时打印当前的训练损失。这个回调函数将继承自`Callback`类,并实现`on_epoch_end`方法。这个过程可以向开发者展示如何通过继承和方法重写来构建自定义的回调函数。

```python

class LossPrinter(Callback):

def on_epoch_end(self, trainer, model):

print(f"Epoch {trainer.state.epoch} complete. Loss: {trainer.state.metrics['loss']}")

```

### 2.2.2 回调函数在训练过程中的应用

在PyTorch的`Trainer`对象中,回调函数被注册后,在相应的时机就会被自动调用。为了应用我们刚刚创建的`LossPrinter`回调,我们需要在训练开始前将其添加到`Trainer`的回调列表中。一旦训练开始,`Trainer`会管理回调的执行,并将训练状态信息作为参数传递给这些回调函数。

```python

trainer = Trainer(callbacks=[LossPrinter()])

```

### 2.3 高级应用:动态调整学习率

在深度学习模型训练中,学习率的调整对模型性能有重要影响。通过自定义回调函数,我们可以实现学习率的动态调整策略,如学习率衰减或者周期性调整。

#### 2.3.1 学习率调整策略

学习率调整策略是深度学习训练中的关键技术之一。常见的策略包括学习率衰减、学习率预热等。回调函数可以用来实现这些策略,在适当的时机调整优化器的学习率参数。

#### 2.3.2 实现自适应学习率调整的回调

为了实现自适应学习率调整的回调,我们可以创建一个新的回调类,并在其`on_epoch_end`方法中实现学习率调整逻辑。例如,我们可以在每个epoch结束时检查模型的验证损失,如果损失没有下降,则减小学习率。

```python

class AdaptiveLearningRate(Callback):

def __init__(self, factor=0.1):

self.factor = factor

def on_epoch_end(self, trainer, model):

if trainer.state.metrics['val_loss'] > trainer.state.metrics['val_loss_prev']:

for param_group in trainer.optimizer.param_groups:

param_group['lr'] *= self.factor

```

回调函数在模型训练中扮演着灵活且强大的角色,使得我们能够更好地控制训练流程,并在必要时进行调整优化。在接下来的章节中,我们将深入探讨回调函数在模型验证中的应用以及如何优化和调试这些回调函数。

# 3. 回调函数在模型验证中的应用

## 3.1 验证过程中的关键回调函数

### 3.1.1 验证准确率跟踪回调

在模型训练过程中,跟踪验证集上的准确率是一个关键步骤,它允许我们监控模型在未知数据上的性能,以便调整训练策略。在PyTorch中,这通常是通过在每个验证周期结束时计算准确率并记录下来来实现的。

为了实现这一回调,我们需要自定义一个类,继承自`torch.utils训练.回调训练Hook`,并实现其`on_validation_end`方法。在这个方法中,我们将执行以下操作:

1. 计算验证集上的准确率。

2. 将准确率记录到日志中。

```python

import torch

from torch.utils训练.回调训练Hook import Callback

class AccuracyCallback(Callback):

def on_validation_end(self, trainer, pl_module):

val_loader = trainer.val_dataloaders

total, correct = 0, 0

pl_module.eval()

with torch.no_grad():

for inputs, targets in val_loader:

outputs = pl_module(inputs)

_, predicted = torch.max(outputs, 1)

total += targets.size(0)

correct += (predicted == targets).sum().item()

val_accuracy = correct / total

print(f"Validation Accuracy: {val_accuracy:.4f}")

pl_module.log("val_accuracy", val_accuracy)

```

在这个示例中,`AccuracyCallback`类覆盖了`on_validation_end`方法,在每个验证周期结束时被调用。它遍历验证数据加载器,计算模型的准确率,并将其记录下来。

### 3.1.2 验证集损失监控回调

除了准确率之外,验证集上的损失也是评估模型性能的重要指标。我们通常希望看到随着训练的进行,损失值逐渐降低,这表明模型正在学习和改进。

为了实现监控验证集损失的回调,我们可以创建一个类似于准确率回调的类,但这次我们关注的是损失值。

```python

class LossCallback(Callback):

def on_validation_end(self, trainer, pl_module):

val_loader = trainer.val_dataloaders

val_loss = 0

pl_module.eval()

with torch.no_grad():

for inputs, targets in val_loader:

outputs = pl_module(inputs)

loss = pl_module.loss_function(outputs, targets)

val_loss += loss.item()

avg_val_loss = val_loss / len(val_loader)

print(f"Validation Loss: {avg_val_loss:.4f}")

pl_module.log("val_loss", avg_val_loss)

```

在这个`LossCallback`类中,我们遍历了验证数据集,并计算了平均损失,然后将这个值记录下来。这样,我们就可以在训练过程中持续跟踪验证损失,以了解模型是否在学习或过拟合。

## 3.2 模型保存与早停策略

#

0

0