【HDFS NameNode高可用性最佳实践】:Zookeeper到故障切换策略的深度解析

发布时间: 2024-10-28 19:08:02 阅读量: 22 订阅数: 31

# 1. HDFS NameNode的高可用性概念

## 1.1 HDFS NameNode的单点故障问题

Hadoop分布式文件系统(HDFS)依赖于NameNode来管理文件系统命名空间和客户端对文件的访问。在早期的Hadoop版本中,NameNode是单点故障(SPOF)的根源,因为如果它失败,整个文件系统将无法访问。这种设计限制了系统的可靠性,因为NameNode的故障会导致整个Hadoop集群停止工作。

## 1.2 高可用性架构的设计目标和关键组件

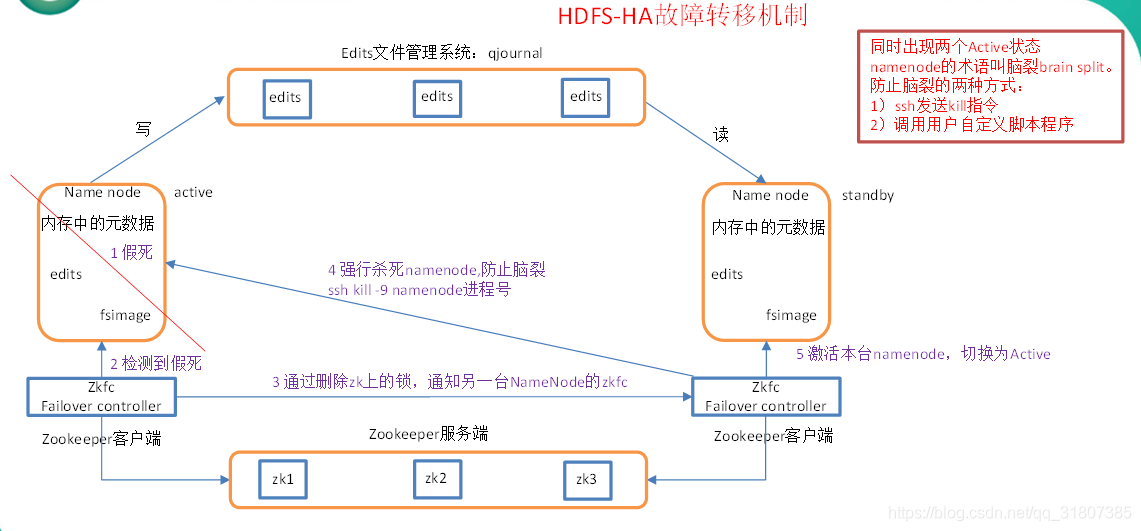

为了解决单点故障问题,Hadoop社区开发了高可用性(HA)架构,其设计目标是消除单点故障,确保HDFS的高可用性和可靠性。关键组件包括两个NameNode(活动和备用),它们共同工作以实现无缝切换和状态同步,以及支持故障转移的外部组件如Zookeeper和JournalNodes。通过这种方式,HDFS可以容忍NameNode节点的故障,而不会影响整体服务的可用性。

## 1.3 高可用性架构的优势

高可用性架构为HDFS提供了多个层次的容错机制,不仅包括对NameNode的故障转移支持,还提高了整个系统的稳定性和可靠性。在HA架构下,通过持续的健康检查和自动故障恢复,数据的完整性和系统的可用性得到了保障。此外,HA架构也为数据管理和负载均衡提供了新的可能性,从而支持了大数据处理对稳定性和扩展性的更高要求。

# 2. 高可用性架构的理论基础

## 2.1 Hadoop高可用性架构概述

### 2.1.1 HDFS NameNode的单点故障问题

Hadoop分布式文件系统(HDFS)的NameNode是整个分布式文件系统的核心,它负责管理文件系统的命名空间以及客户端对文件的访问。在早期版本的HDFS中,NameNode是单点的,即集群中只有一个NameNode实例。这样的架构设计带来了明显的单点故障(SPOF)问题,一旦NameNode发生故障,整个HDFS集群将无法正常工作,这严重威胁了大规模数据存储的可靠性。

单点故障的主要原因是缺乏冗余设计,任何硬件故障、软件bug或网络问题都可能导致NameNode不可用。这种单点故障对于需要长时间运行并且对稳定性要求极高的企业级应用来说是不可接受的。

### 2.1.2 高可用性架构的设计目标和关键组件

为了解决单点故障问题,高可用性(High Availability,HA)架构应运而生。高可用性架构的设计目标是实现故障的快速检测和无缝切换,以保证HDFS服务的持续可用性。其关键组件包括:

- **Active和Standby NameNode**:通过使用两个或多个NameNode实例,其中一个处于活跃状态(Active),处理客户端请求,而其他的处于待命状态(Standby),随时准备接管服务。

- **共享存储系统**:用于存储NameNode元数据,保证在主备切换时元数据的一致性。Hadoop社区常用的是QJM(Quorum-based Journal Manager)。

- **故障检测机制**:监控NameNode状态,并在检测到故障时触发切换流程。

- **自动故障切换**:一旦发现活跃的NameNode出现故障,自动将一个待命的Standby NameNode提升为活跃状态,以继续提供服务。

## 2.2 Zookeeper的介绍与作用

### 2.2.1 Zookeeper的基本原理和特点

Zookeeper是一个开源的分布式协调服务,它为分布式应用提供一致性服务,如命名服务、配置管理、同步服务和群组服务等。Zookeeper设计之初就考虑到了高可用性、高吞吐量、低延迟和严格的一致性。

Zookeeper的几个核心特点包括:

- **顺序访问控制**:Zookeeper为所有更新操作提供全局单调递增的事务ID(zxid)。

- **强一致性**:Zookeeper保证在任何时刻对同一数据项的读操作都会返回最新的更新。

- **高可用性**:通过集群形式部署多个Zookeeper服务器,能够容忍部分服务器的失效。

### 2.2.2 Zookeeper在HDFS NameNode中的角色

在HDFS高可用性架构中,Zookeeper扮演着至关重要的角色。它主要有以下几个作用:

- **管理NameNode状态**:Zookeeper用来记录每个NameNode实例的角色(Active或Standby)和健康状态。

- **协调切换流程**:当活跃的NameNode发生故障时,Zookeeper负责协调和触发故障切换流程。

- **维护共享存储的元数据一致性**:通过Zookeeper的锁服务和监听机制,确保当多个NameNode同时操作元数据时,数据不会发生冲突。

## 2.3 高可用性系统的关键技术

### 2.3.1 心跳检测机制

心跳检测是一种常用的故障检测方法,通过周期性地发送消息来判断一个节点是否仍然活跃。在HDFS NameNode的高可用性架构中,心跳机制用于检测NameNode实例的健康状况。

- **Active NameNode的心跳**:Active NameNode会定期向Zookeeper发送心跳,表明自己仍然可以正常工作。

- **Standby NameNode的心跳**:Standby NameNode也会向Zookeeper发送心跳,保持与Zookeeper的连接,并获取关于集群状态的更新。

### 2.3.2 自动故障检测与切换的实现原理

当Zookeeper在预定时间内没有收到活跃的NameNode的心跳信息时,它会认为该NameNode发生了故障。此时,Zookeeper会触发自动故障切换的流程:

1. **故障检测**:Zookeeper检测到活跃NameNode故障后,会通知所有Standby NameNode。

2. **角色转换**:Zookeeper帮助协调Standby NameNode之间进行角色争夺,成功获得锁的Standby NameNode将成为新的活跃节点,其他节点继续保持待命状态。

3. **数据同步**:新的活跃NameNode会从共享存储系统中读取最新的元数据,并对外提供服务。

4. **集群状态更新**:Zookeeper更新集群状态信息,客户端和相关组件会根据新的状态信息调整它们的行为。

通过这样的故障检测和自动切换机制,HDFS的NameNode可以实现无缝的高可用性保障,大大降低了服务中断的风险。

以上内容为你提供了一个关于Hadoop高可用性架构理论基础的详细介绍。在接下来的章节中,我们将深入探讨故障切换策略、实践应用以及未来的发展方向。

# 3. 故障切换策略的详细解析

在分布式系统中,故障切换(Failover)是一种重要的容错机制,它能够在发生故障时自动将服务从一个失败的节点切换到一个健康的节点上。故障切换策略是确保Hadoop分布式文件系统(HDFS)高可用性的核心组件。本章节将深入探讨故障切换策略的各个细节,包括主备切换的流程与机制、Zookeeper在故障切换中的作用以及高级故障切换策略。

## 3.1 主备切换的流程与机制

### 3.1.1 NameNode状态同步机制

HDFS NameNode的状态同步是确保高可用性的基石。主备两个NameNode节点之间需要实时同步状态信息,以便在发生故障时能够迅速地切换到备份节点,继续提供服务。

状态同步通常依赖于JournalNode集群,它负责在主NameNode上发生的所有命名空间变更(编辑日志)的记录。这些记录会实时同步到JournalNode集群中,并由备份的NameNode读取,以此保证两个节点的状态一致。

```bash

# 配置JournalNode集群的命令

hdfs --daemon start journalnode

```

上述命令启动了JournalNode服务。JournalNode集群通常设置为奇数个节点,以利用多数派协议确保数据的一致性。编辑日志同步的流程可以分为以下几个步骤:

1. 主NameNode将变更操作写入本地磁盘的编辑日志。

2. 同步操作通过RPC传输到JournalNode集群。

3. JournalNode集群成员将变更操作写入自己的磁盘。

4. 备份NameNode从JournalNode集群读取变更操作。

5. 备份NameNode应用变更操作到自己的命名空间,达到状态同步。

### 3.1.2 切换过程中的数据一致性保障

切换过程中,确保数据一致性是另一个关键挑战。HDFS通过一系列机制来保证这一点,包括FsImage和编辑日志。

- FsImage:存储了HDFS文件系统的完整快照,包括文件系统的目录结构、文件属性等信息。

- 编辑日志:记录了自FsImage生成以来对文件系统所作的更改。

在切换发生时,备份NameNode首先会使用最新的 FsImage 和编辑日志重新构建文件系统的状态,然后继续读取从上一次 checkpoint 以来的编辑日志,以确保数据的一致性。

```java

// NameNode启动时加载FsImage和编辑日志的伪代码

FileStatus[] status = filesystem.listStatus(new Path("/"));

// 加载FsImage

// 应用编辑日志

```

## 3.2 Zookeeper在故障切换中的作用

0

0