MATLAB优化算法实战:解决复杂问题的利器

发布时间: 2024-06-15 16:31:12 阅读量: 83 订阅数: 42

Matlab在优化问题中的应用

# 1. MATLAB优化算法基础**

**1.1 优化问题的定义和分类**

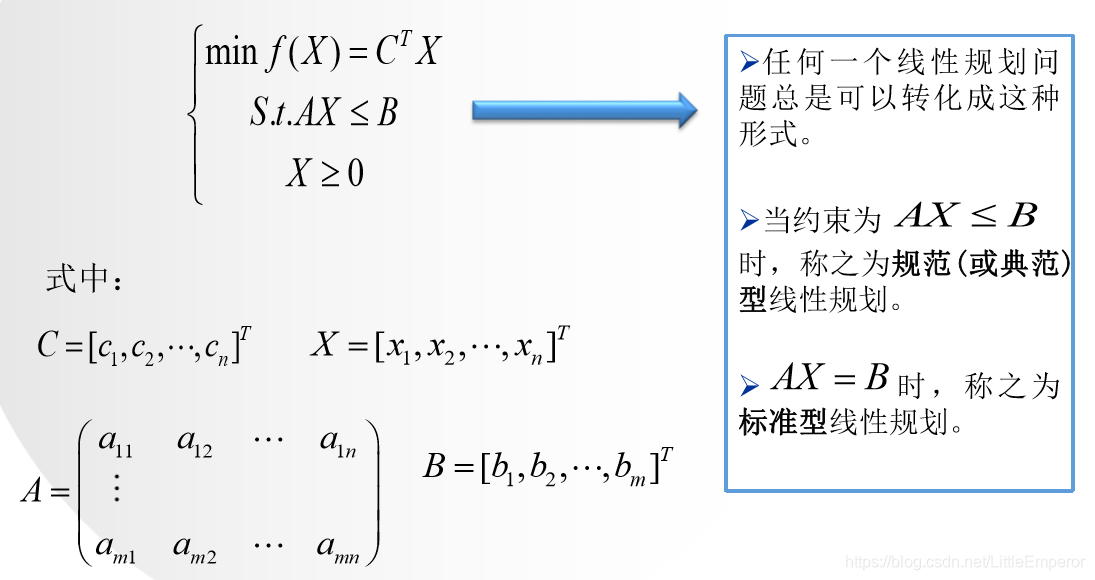

优化问题是指在给定约束条件下,寻找一个目标函数的最佳值。MATLAB优化算法可以解决各种优化问题,包括线性规划、非线性规划和约束优化。

**1.2 MATLAB优化算法概述**

MATLAB提供了一系列优化算法,包括:

- 线性规划:单纯形法

- 非线性规划:梯度下降法、牛顿法、拟牛顿法

- 约束优化:内点法、罚函数法

- 元启发式优化:粒子群优化算法、遗传算法

# 2. 线性规划和非线性规划算法

### 2.1 线性规划算法:单纯形法

#### 2.1.1 单纯形法的基本原理

单纯形法是一种解决线性规划问题的经典算法。其基本原理是通过迭代的方式,将线性规划问题转化为一系列等价的线性规划问题,并通过求解这些等价问题的最优解,最终得到原始问题的最优解。

#### 2.1.2 单纯形法的步骤和求解过程

单纯形法的求解过程可以分为以下几个步骤:

1. **建立初始可行解:**将线性规划问题转化为标准形式,并构造一个初始的可行解。

2. **寻找最优解:**通过计算每个变量的**约简成本**,确定当前解是否为最优解。如果当前解不是最优解,则选择一个约简成本为负的变量进入基。

3. **进行基变换:**将进入基的变量与基中的一个变量进行交换,形成一个新的可行解。

4. **重复步骤2和步骤3:**重复步骤2和步骤3,直到找到最优解或证明问题无界。

### 2.2 非线性规划算法:梯度下降法

#### 2.2.1 梯度下降法的基本原理

梯度下降法是一种解决非线性规划问题的迭代算法。其基本原理是沿着目标函数梯度的负方向进行迭代,逐步逼近最优解。

#### 2.2.2 梯度下降法的变种:牛顿法和拟牛顿法

梯度下降法有两种常见的变种:牛顿法和拟牛顿法。

* **牛顿法:**牛顿法利用目标函数的二阶导数信息来加速收敛。

* **拟牛顿法:**拟牛顿法在没有二阶导数信息的情况下,通过近似牛顿法来加速收敛。

**代码块:**

```

% 定义目标函数

f = @(x) x^2 + 2*x + 1;

% 定义梯度函数

grad_f = @(x) 2*x + 2;

% 初始化学习率

alpha = 0.01;

% 初始化当前点

x = 0;

% 迭代更新

for i = 1:1000

% 计算梯度

g = grad_f(x);

% 更新当前点

x = x - alpha * g;

end

% 输出最优解

disp(x);

```

**代码逻辑分析:**

该代码实现了梯度下降法求解一元非线性规划问题。

1. 定义目标函数 `f(x)` 和梯度函数 `grad_f(x)`。

2. 初始化学习率 `alpha` 和当前点 `x`。

3. 进入迭代循环,在每次迭代中:

- 计算当前点的梯度 `g`。

- 根据梯度下降公式更新当前点 `x`。

4. 循环迭代直到达到收敛条件。

5. 输出最优解 `x`。

**参数说明:**

* `f`: 目标函数。

* `grad_f`: 目标函数的梯度函数。

* `alpha`: 学习率,控制更新步长。

* `x`: 当前点。

# 3. 约束优化算法

**3.1 有约束优化问题类型**

有约束优化问题是指在优化目标函数的同时,还需要满足一定的约束条件。约束条件可以是线性或非线性,等式或不等式。有约束优化问题分为以下几类:

- 线性约束优化问题:目标函数和约束条件都是线性的。

- 非线性约束优化问题:目标函数或约束条件是非线性的。

- 等式约束优化问题:约束条件都是等式。

- 不等式约束优化问题:约束条件都是不等式。

- 混合约束优化问题:约束条件既有等式又有不等式。

**3.2 线性约束优化算法:内点法**

内点法是一种求解线性约束优化问题的算法。它的基本原理是将可行域的内部点逐步向最优解移动。内点法的求解过程如下:

1. 初始化:选择一个可行点作为初始点。

2. 求解:求解一个线性规划子问题,得到一个新的可行点。

3. 更新:将新的可行点作为当前点,并更新约束条件。

4. 重复步骤2和步骤3,直到满足终止条件。

**代码块:**

```matlab

function [x, fval, exitflag] = interiorPoint(f, A, b, lb, ub)

% interiorPoint 求解线性约束优化问题

% 输入:

% f: 目标函数

% A: 约束矩阵

% b: 约束向量

% lb: 下界

% ub: 上界

% 输出:

% x: 最优解

% fval: 最优目标函数值

% exitflag: 退出标志

% 初始化

x0 = (lb + ub) / 2;

t = 1;

maxIter = 100;

% 求解

for iter = 1:maxIter

% 求解线性规划子问题

[x, fval, exitflag] = linprog(f, [], [], A, b, lb, ub);

if exitflag ~= 1

break;

end

% 更新

t = t / 2;

lb = x - t * (x - lb);

ub = x + t * (ub - x);

end

end

```

**逻辑分析:**

该代码块实现了内点法求解线性约束优化问题。首先,初始化可行点、步长和最大迭代次数。然后,循环求解线性规划子问题,更新可行点和约束条件。当满足终止条件(例如达到最大迭代次数或目标函数值不再变化)时,退出循环并返回最优解。

**参数说明:**

- `f`: 目标函数,是一个函数句柄。

- `A`: 约束矩阵,是一个 m x n 矩阵,其中 m 是约束条件的个数,n 是变量的个数。

- `b`: 约束向量,是一个 m 维向量。

- `lb`: 下界,是一个 n 维向量。

- `ub`: 上界,是一个 n 维向量。

**3.3 非线性约束优化算法:罚函数法**

罚函数法是一种求解非线性约束优化问题的算法。它的基本原理是将约束条件加入到目标函数中,形成一个新的目标函数。新的目标函数被称为罚函数,它随着约束条件违反的程度而增加。罚函数法的求解过程如下:

1. 初始化:选择一个初始点和罚函数参数。

2. 求解:求解罚函数,得到一个新的可行点。

3. 更新:将新的可行点作为当前点,并更新罚函数参数。

4. 重复步骤2和步骤3,直到满足终止条件。

**代码块:**

```matlab

function [x, fval, exitflag] = penaltyMethod(f, c, A, b, lb, ub, penalty)

% penaltyMethod 求解非线性约束优化问题

% 输入:

% f: 目标函数

% c: 约束函数

% A: 约束矩阵

% b: 约束向量

% lb: 下界

% ub: 上界

% penalty: 罚函数参数

% 输出:

% x: 最优解

% fval: 最优目标函数值

% exitflag: 退出标志

% 初始化

x0 = (lb + ub) / 2;

t = 1;

maxIter = 100;

% 求解

for iter = 1:maxIter

% 求解罚函数

fun = @(x) f(x) + penalty * sum(c(x).^2);

[x, fval, exitflag] = fminunc(fun, x0);

if exitflag ~= 1

break;

end

% 更新

t = t / 2;

penalty = penalty * t;

end

end

```

**逻辑分析:**

该代码块实现了罚函数法求解非线性约束优化问题。首先,初始化可行点、罚函数参数和最大迭代次数。然后,循环求解罚函数,更新可行点和罚函数参数。当满足终止条件(例如达到最大迭代次数或目标函数值不再变化)时,退出循环并返回最优解。

**参数说明:**

- `f`: 目标函数,是一个函数句柄。

- `c`: 约束函数,是一个函数句柄,返回一个向量,表示约束条件的违反程度。

- `A`: 约束矩阵,是一个 m x n 矩阵,其中 m 是约束条件的个数,n 是变量的个数。

- `b`: 约束向量,是一个 m 维向量。

- `lb`: 下界,是一个 n 维向量。

- `ub`: 上界,是一个 n 维向量。

- `penalty`: 罚函数参数,是一个正数。

# 4. 元启发式优化算法

### 4.1 元启发式优化算法概述

元启发式优化算法是一种基于自然界中生物进化、物理现象或社会行为等启发式原理设计的算法,用于解决复杂优化问题。与传统优化算法相比,元启发式算法具有以下特点:

- **全局搜索能力强:**元启发式算法通过随机搜索和迭代更新,能够有效探索搜索空间,避免陷入局部最优。

- **对目标函数的依赖性低:**元启发式算法不需要目标函数的梯度或导数信息,因此适用于各种非光滑、非凸的目标函数。

- **鲁棒性强:**元启发式算法对噪声和不确定性具有较强的鲁棒性,能够在复杂环境中保持较好的性能。

常见的元启发式优化算法包括粒子群优化算法、遗传算法、蚁群算法、模拟退火算法等。

### 4.2 粒子群优化算法

#### 4.2.1 粒子群优化算法的基本原理

粒子群优化算法(PSO)是一种基于鸟群觅食行为的元启发式算法。在PSO算法中,每个粒子代表一个潜在解,粒子群则代表所有潜在解的集合。每个粒子具有自己的位置、速度和适应度值。

PSO算法的迭代过程如下:

1. **初始化:**随机初始化粒子群的位置和速度。

2. **适应度计算:**计算每个粒子的适应度值,即目标函数的值。

3. **局部最优更新:**每个粒子更新自己的局部最优解(pbest),即适应度值最优的解。

4. **全局最优更新:**粒子群更新全局最优解(gbest),即所有局部最优解中适应度值最优的解。

5. **速度更新:**每个粒子更新自己的速度,速度更新公式为:

```

v_i(t+1) = w * v_i(t) + c1 * r1 * (pbest_i(t) - x_i(t)) + c2 * r2 * (gbest(t) - x_i(t))

```

其中:

- `v_i(t)` 表示粒子 `i` 在时间 `t` 的速度

- `w` 表示惯性权重,控制速度更新的惯性

- `c1` 和 `c2` 表示学习因子,控制粒子向局部最优解和全局最优解移动的程度

- `r1` 和 `r2` 表示 [0, 1] 之间的随机数

- `pbest_i(t)` 表示粒子 `i` 在时间 `t` 的局部最优解

- `gbest(t)` 表示粒子群在时间 `t` 的全局最优解

- `x_i(t)` 表示粒子 `i` 在时间 `t` 的位置

6. **位置更新:**每个粒子更新自己的位置,位置更新公式为:

```

x_i(t+1) = x_i(t) + v_i(t+1)

```

7. **重复:**重复步骤 2-6,直到达到终止条件(例如达到最大迭代次数或适应度值收敛)。

#### 4.2.2 粒子群优化算法的求解过程

**1. 初始化:**

```matlab

% 粒子数量

num_particles = 100;

% 搜索空间维度

num_dimensions = 2;

% 初始化粒子群

particles = zeros(num_particles, num_dimensions);

for i = 1:num_particles

particles(i, :) = rand(1, num_dimensions) * 10;

end

% 初始化速度

velocities = zeros(num_particles, num_dimensions);

% 初始化局部最优解

pbest = particles;

% 初始化全局最优解

gbest = pbest(1, :);

```

**2. 适应度计算:**

```matlab

% 目标函数

fitness_function = @(x) sum(x.^2);

% 计算每个粒子的适应度值

fitness = zeros(num_particles, 1);

for i = 1:num_particles

fitness(i) = fitness_function(particles(i, :));

end

```

**3. 局部最优更新:**

```matlab

% 更新每个粒子的局部最优解

for i = 1:num_particles

if fitness(i) < fitness_function(pbest(i, :))

pbest(i, :) = particles(i, :);

end

end

```

**4. 全局最优更新:**

```matlab

% 更新全局最优解

[~, best_index] = min(fitness);

gbest = pbest(best_index, :);

```

**5. 速度更新:**

```matlab

% 惯性权重

w = 0.7298;

% 学习因子

c1 = 1.4962;

c2 = 1.4962;

% 更新每个粒子的速度

for i = 1:num_particles

velocities(i, :) = w * velocities(i, :) + ...

c1 * rand(1, num_dimensions) .* (pbest(i, :) - particles(i, :)) + ...

c2 * rand(1, num_dimensions) .* (gbest - particles(i, :));

end

```

**6. 位置更新:**

```matlab

% 更新每个粒子的位置

for i = 1:num_particles

particles(i, :) = particles(i, :) + velocities(i, :);

end

```

**7. 重复:**

重复步骤 2-6,直到达到终止条件。

### 4.3 遗传算法

#### 4.3.1 遗传算法的基本原理

遗传算法(GA)是一种基于自然界中生物进化原理的元启发式算法。在GA算法中,每个个体代表一个潜在解,种群则代表所有潜在解的集合。每个个体由一组基因组成,基因的值决定了潜在解的特征。

GA算法的迭代过程如下:

1. **初始化:**随机初始化种群。

2. **适应度计算:**计算每个个体的适应度值,即目标函数的值。

3. **选择:**根据适应度值,选择种群中的个体进行繁殖。适应度值越高的个体被选中的概率越大。

4. **交叉:**将两个被选中的个体进行交叉,产生新的个体。交叉操作可以交换两个个体的基因,从而产生新的潜在解。

5. **变异:**对新的个体进行变异,即随机改变个体的某些基因。变异操作可以引入新的基因组合,增加种群的多样性。

6. **替换:**将新的个体替换掉种群中适应度值最低的个体。

7. **重复:**重复步骤 2-6,直到达到终止条件(例如达到最大迭代次数或适应度值收敛)。

#### 4.3.2 遗传算法的求解过程

**1. 初始化:**

```matlab

% 种群数量

population_size = 100;

% 染色体长度

chromosome_length = 10;

% 初始化种群

population = zeros(population_size, chromosome_length);

for i = 1:population_size

population(i, :) = randi([0, 1], 1, chromosome_length);

end

```

**2. 适应度计算:**

```matlab

% 目标函数

fitness_function = @(x) sum(x.^2);

% 计算每个个体的适应度值

fitness = zeros(population_size, 1);

for i = 1:population_size

fitness(i) = fitness_function(population(i, :));

end

```

**3. 选择:**

```matlab

% 选择概率

selection_probabilities = fitness / sum(fitness);

% 随机选择个体

selected_individuals = zeros(population_size, chromosome_length);

for i = 1:population_size

selected_individuals(i, :) = population(roulette_wheel_selection(selection_probabilities), :);

end

```

**4. 交叉:**

```matlab

% 交叉概率

crossover_probability = 0.8;

% 单点交叉

for i = 1:2:population_size

if rand() < crossover_probability

crossover_point = randi([1, chromosome_length - 1]);

temp = selected_individuals(i, crossover_point:end);

selected_individuals(i, crossover_point:end) = selected_individuals(i+1, crossover_point:end);

selected_individuals(i+1, crossover_point:end) = temp;

end

end

```

**5. 变异:**

```matlab

% 变异概率

mutation_probability

# 5. MATLAB优化算法实践**

**5.1 MATLAB优化算法工具箱介绍**

MATLAB提供了丰富的优化算法工具箱,涵盖了线性规划、非线性规划、约束优化和元启发式优化等多种算法。这些工具箱提供了易于使用的函数和方法,可以帮助用户快速高效地解决优化问题。

**5.2 优化算法在实际问题中的应用**

**5.2.1 股票组合优化**

股票组合优化问题是指在给定的风险水平下,寻找一组股票的最佳组合,以最大化投资回报率。可以使用MATLAB的fmincon函数,通过非线性约束优化算法求解该问题。

```matlab

% 定义目标函数(最大化投资回报率)

objective = @(x) -sum(x .* log(x));

% 定义约束条件(风险水平)

constraints = @(x) sum(x.^2) - 0.05;

% 初始解

x0 = ones(1, 10) / 10;

% 优化算法参数

options = optimoptions('fmincon', 'Algorithm', 'interior-point');

% 求解优化问题

[x, fval] = fmincon(objective, x0, [], [], [], [], zeros(1, 10), ones(1, 10), constraints, options);

% 输出最优解

disp('最优股票组合:');

disp(x);

disp('最优投资回报率:');

disp(-fval);

```

**5.2.2 神经网络参数优化**

神经网络参数优化问题是指在给定的训练数据集上,寻找一组神经网络参数,以最小化网络的损失函数。可以使用MATLAB的trainNetwork函数,通过元启发式优化算法求解该问题。

```matlab

% 导入训练数据集

data = load('training_data.mat');

% 创建神经网络

net = feedforwardnet([10, 10]);

% 定义损失函数(均方误差)

loss = @(y, t) mean((y - t).^2);

% 优化算法参数

options = trainingOptions('adam', 'MaxEpochs', 1000, 'MiniBatchSize', 128);

% 训练神经网络

net = trainNetwork(data.inputs, data.targets, net, options);

% 输出训练结果

disp('训练后的神经网络:');

disp(net);

disp('训练损失:');

disp(loss(net(data.inputs), data.targets));

```

0

0