【代码实现指南】:RNN从理论到实践的步骤详解

发布时间: 2024-09-05 12:56:14 阅读量: 54 订阅数: 45

白色大气风格的旅游酒店企业网站模板.zip

# 1. RNN基础理论简介

## 1.1 循环神经网络的起源与概念

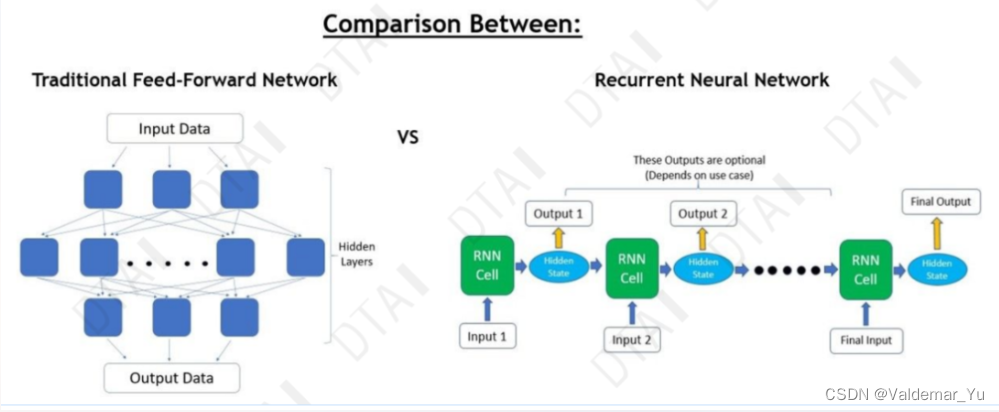

循环神经网络(Recurrent Neural Networks,RNNs)是深度学习领域的一种重要网络结构,用于处理序列数据。它通过保留上一个时间步的信息,为当前时间步输入增加了上下文信息,从而捕捉数据的时序特性。

## 1.2 RNN的工作原理

RNN的核心在于其循环连接,这种连接使得网络具备了处理可变长度输入的能力。在训练过程中,RNN通过时间展开来处理序列,每个时间步的输出可以作为下一个时间步的输入,实现信息的持续传递。

## 1.3 RNN的应用场景

RNN广泛应用于语音识别、自然语言处理、时间序列分析等领域。其对于上下文敏感的特性,使其在处理有时间关联性的数据时表现出色。比如,RNN能够根据前文内容预测文本或语言中的下一个词。

# 2. RNN的数学原理和模型结构

### 2.1 RNN的数学基础

#### 2.1.1 序列数据和时间步的概念

序列数据是一种按特定顺序排列的数据集合,例如时间序列数据、文字、音视频信号等。这些数据的共同特点在于,它们都具有时间或序列上的相关性,这种相关性在时间维度上连续的序列数据中尤为明显。时间步(timestep)是序列数据的一个基本单位,用于表示序列中的每个时间点,数据在这个时间点的值构成了序列中的一个元素。

在RNN中,时间步是描述数据流中单个时刻的重要概念。网络在每个时间步接收一个输入并生成一个输出,同时内部状态会根据输入和前一时间步的状态进行更新。这种设计使得RNN能够处理任意长度的序列数据。

#### 2.1.2 循环神经网络的前向传播

循环神经网络的前向传播是数据在时间步上通过网络的流动过程。在时间步`t`,RNN接受当前的输入`x_t`和前一时间步的隐藏状态`h_{t-1}`,并产生当前时间步的隐藏状态`h_t`和输出`o_t`。数学表达式如下:

```math

h_t = f(W \cdot h_{t-1} + U \cdot x_t + b)

```

其中,`f`代表激活函数(如tanh或ReLU),`W`和`U`是权重矩阵,`b`是偏置向量。隐藏状态`h_t`是网络记忆的中间表示,它捕捉了历史信息,并影响当前和未来的输出。

### 2.2 RNN核心模型的构建

#### 2.2.1 基本RNN单元的工作原理

基本RNN单元通过在时间维度上复制参数来处理不同时间步的输入,这个复制参数的设计允许网络存储和访问之前的序列信息。在每个时间步,单元将当前输入和前一个时间步的状态作为输入,通过权重矩阵将它们映射到输出。

#### 2.2.2 RNN单元在数学上的表达

用数学符号表达,RNN单元的计算如下:

```math

h_t = \phi(W \cdot [h_{t-1}, x_t])

```

这里的`[h_{t-1}, x_t]`是前一个隐藏状态和当前输入的拼接,`W`是权重矩阵,`φ`是作用在加权输入上的激活函数。

#### 2.2.3 长短期记忆网络(LSTM)和门控循环单元(GRU)

由于基本RNN单元容易受到梯度消失或爆炸的问题影响,研究者提出了LSTM和GRU两种RNN变体,以改善序列数据学习的效率和准确性。LSTM通过引入“门”的概念控制信息流,而GRU简化了这种门机制。

LSTM单元包括遗忘门、输入门和输出门,这些门决定了信息的保留和更新。GRU则融合了更新门和重置门,简化了LSTM的结构,同时保留了其处理长序列的能力。

### 2.3 RNN的变体与优化

#### 2.3.1 RNN常见的问题和限制

尽管RNN在处理序列数据上表现出色,但它也面临着一些固有问题,如梯度消失和梯度爆炸。这些问题导致RNN难以学习长距离的依赖关系,使得网络难以捕捉序列中的长期依赖信息。

#### 2.3.2 RNN变体的性能比较和选择

由于基本RNN存在局限性,多种变体被开发出来以应对不同的挑战。例如,LSTM和GRU是两种流行的变体,它们在保持长距离依赖学习能力的同时,简化了参数结构,提高了训练效率。

选择RNN变体时,需要考虑数据的特性、训练的复杂度以及所追求的性能指标。如果数据中的时间依赖性较长,建议使用LSTM或GRU。对于简单任务,基本RNN或其变体可能已经足够。

在下一章节,我们将深入探讨RNN的编程实现和训练技巧。

# 3. RNN编程实现与训练技巧

## 3.1 RNN的编程实践

### 3.1.1 使用Python和TensorFlow实现RNN

在这一节中,我们将通过实际的代码示例,展示如何使用Python和TensorFlow框架来实现RNN网络。TensorFlow是谷歌开发的开源机器学习库,提供了全面的工具来构建和部署机器学习模型。

首先,确保安装了TensorFlow库。在Python环境中,可以使用pip安装TensorFlow:

```python

pip install tensorflow

```

接下来,我们将构建一个基本的RNN模型。这里使用的是`tf.keras`模块,它是TensorFlow 2.x版本推荐的高级API,可以让模型构建过程更加直观和简洁。

```python

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import SimpleRNN, Dense

# 定义序列长度、特征数量和输出类别数量

sequence_length = 10

feature_size = 5

output_size = 1

# 实例化一个序贯模型

model = Sequential()

# 添加一个RNN层,其中units参数为RNN单元的数量

model.add(SimpleRNN(units=32, input_shape=(sequence_length, feature_size)))

# 添加一个全连接层,输出大小为output_size

model.add(Dense(output_size, activation='sigmoid'))

# 编译模型,指定损失函数、优化器和评价指标

***pile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy'])

# 模型摘要信息

model.summary()

```

在这个例子中,我们首先导入了必要的TensorFlow模块。随后创建了一个`Sequential`模型,并添加了一个`SimpleRNN`层,其中`u

0

0