【梯度消失挑战】:深入理解RNN中的梯度消失问题及解决方案

发布时间: 2024-09-05 12:09:19 阅读量: 71 订阅数: 40

# 1. 循环神经网络(RNN)基础

## 1.1 RNN的定义和应用场景

循环神经网络(Recurrent Neural Network,RNN)是一类用于处理序列数据的神经网络。与传统的前馈神经网络不同,RNN具有内部状态(记忆)可以利用之前的信息进行决策,非常适合处理和预测序列数据。例如,在自然语言处理(NLP)中,RNN可以用于语音识别、语言模型、机器翻译等任务;在时间序列分析中,它可以用于股票价格预测、天气变化预测等。

## 1.2 RNN的工作原理

RNN通过隐藏层的循环连接来传递上一时刻的信息。在时间步t,RNN将当前输入向量x_t与上一时间步的隐藏状态h_(t-1)结合起来产生当前时间步的隐藏状态h_t,然后再利用这个隐藏状态产生输出。数学表示如下:

```

h_t = f(W * h_(t-1) + U * x_t + b)

```

其中,f是激活函数,W和U是权重矩阵,b是偏置项。这种结构使得RNN能够将先前的信息记忆起来,影响当前的输出。

## 1.3 RNN的挑战:梯度消失问题

尽管RNN在理论上非常强大,但在实际应用中往往遇到梯度消失问题,这会导致网络难以学习到长距离依赖关系。随着序列长度的增加,反向传播时计算得到的梯度越来越小,使得权重更新变得不明显,网络难以学习到有效的长期依赖关系。这是RNN设计和优化中的关键挑战之一,将在后续章节深入分析。

# 2. 梯度消失问题的理论分析

梯度消失问题是循环神经网络(RNN)和其他深度神经网络中常见的一个难题,尤其是在处理序列数据时。这一问题极大地影响了网络的训练效率和最终性能。理解梯度消失问题及其理论基础,是有效解决这一问题的前提。

## 2.1 梯度消失问题的定义和影响

### 2.1.1 反向传播算法中的梯度计算

在深度学习模型训练中,反向传播算法是核心环节。它通过计算损失函数相对于网络参数的梯度来更新参数,从而最小化损失函数。这一过程涉及到链式法则的连续应用。链式法则允许我们通过复合函数的求导规则来计算梯度。在计算过程中,如果梯度的每一项都小于1,经过多次连乘后,梯度可能会指数级地减小,最终趋向于零。这就导致了梯度消失问题。

### 2.1.2 梯度消失的直观解释

直观上讲,梯度消失问题可以理解为,在一个很深的网络中,随着层数的增加,从输出层向输入层传播的梯度值不断减小。这种梯度的逐层衰减使得靠近输入层的层很难学习到数据的有效表示,从而影响整个网络的训练过程。在极端情况下,这些层的参数几乎不会被更新,导致模型无法学习到时间序列数据中的长距离依赖关系。

## 2.2 梯度消失的数学原理

### 2.2.1 权重矩阵和激活函数的选择

权重矩阵的初始化对梯度消失问题有很大影响。如果初始化时权重值过小,那么经过多层连乘后,梯度值将会变得非常小。此外,激活函数的选择也至关重要。例如,使用Sigmoid或Tanh激活函数时,因为这些函数在输入值较大或较小时其导数接近于零,它们容易导致梯度消失。这使得使用ReLU或其变体成为一种解决梯度消失问题的流行策略,因为ReLU的导数要么是1,要么是0,从而减少梯度消失的风险。

### 2.2.2 长期依赖问题与梯度传播

在序列数据处理中,长期依赖问题是一个核心挑战。梯度消失会导致网络难以捕捉序列中的长距离依赖关系,即模型难以学习到序列开始部分的信息,因为它对输出的影响逐渐衰减。这在自然语言处理等任务中尤为明显,其中整个句子的语义往往取决于首尾单词的关联。

## 2.3 神经网络中的梯度流分析

### 2.3.1 梯度的链式法则

梯度的链式法则在深度网络中非常关键。随着层数的增加,梯度将通过多次链式法则的计算。如果我们设有L层的网络,那么从输出层到输入层的梯度流可以通过以下公式表示:

\[ \frac{\partial L}{\partial w^{(l)}} = \left(\prod_{l'=l+1}^{L} \frac{\partial h^{(l'+1)}}{\partial h^{(l')}} \right) \frac{\partial L}{\partial h^{(l+1)}} \]

这里,\( w^{(l)} \) 表示第 \( l \) 层的权重,\( h^{(l)} \) 表示第 \( l \) 层的激活函数的输出。如果在每一步的导数都小于1,那么最终的梯度值将非常小。

### 2.3.2 梯度消失在深层网络中的表现

在深层网络中,梯度消失的问题尤为显著。这可以由以下方程式表示:

\[ \frac{\partial L}{\partial w^{(l)}} = \frac{\partial L}{\partial h^{(l+1)}} \cdot \frac{\partial h^{(l+1)}}{\partial h^{(l)}} \cdot \frac{\partial h^{(l)}}{\partial w^{(l)}} \]

如果 \( \frac{\partial h^{(l+1)}}{\partial h^{(l)}} \) 的值小于1,随着 \( l \) 的增加,梯度将会逐渐消失。梯度消失不仅会导致学习速度变慢,还可能造成网络学习不到有效的特征表示,因为梯度更新几乎为零。

通过以上分析,我们可以看到梯度消失问题对深度学习模型训练的潜在影响。这促使研究者和工程师开发出各种技术来缓解和解决这一问题,这将在后续章节中详细讨论。

# 3. 梯度消失问题的实践诊断

## 3.1 诊断梯度消失的工具和方法

### 3.1.1 使用可视化工具观察梯度

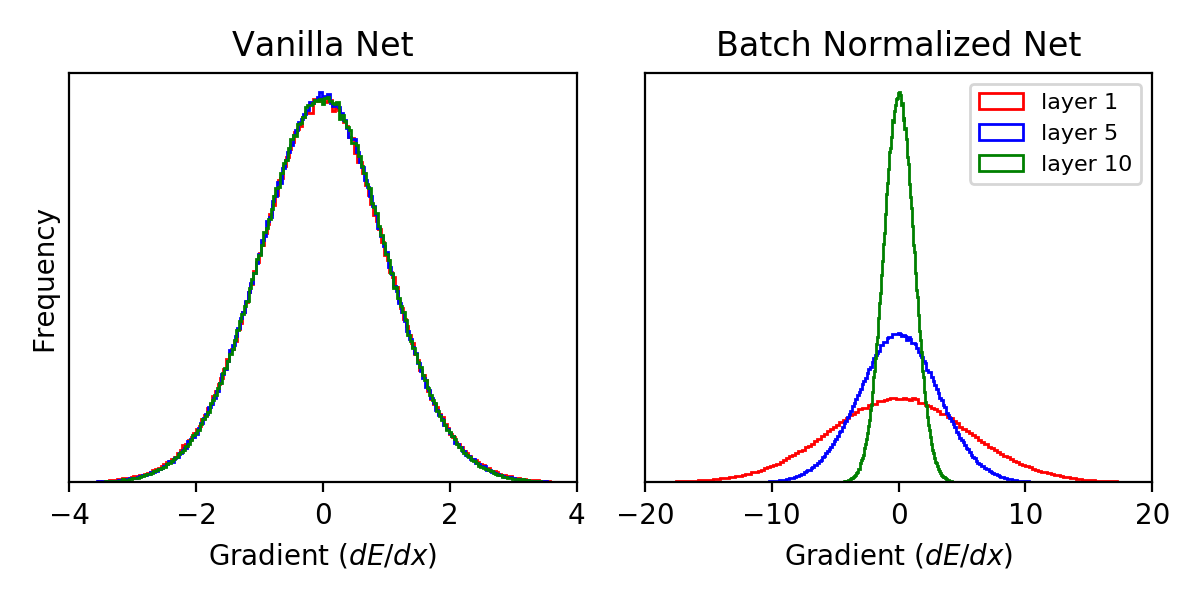

在实际的神经网络训练过程中,诊断梯度消失问题首先需要能够观察到梯度的分布情况。一种常用的方法是利用可视化工具,如TensorBoard,来观察训练过程中的梯度流。通过这样的工具,我们可以直观地看到不同层之间的梯度是如何随时间变化的,是否存在某些层的梯度明显比其他层小很多,从而判断出梯度消失的发生。

```python

# 示例代码:使用TensorBoard记录和观察梯度

from tensorflow.keras.callbacks import TensorBoard

import tensorflow as tf

# 假设模型已经被构建好并且赋值给变量model

model = create_model() # 创建模型的函数

# 配置TensorBoard回调函数

tensorboard_callback = TensorBoard(log_dir='./logs', histogram_freq=1)

# 训练模型

model.fit(X_train, Y_train, epochs=10, callbacks=[tensorboard_callback])

# 启动TensorBoard查看日志

%load_ext tensorboard

%tensorboard --logdir ./logs

```

### 3.1.2 通过实验数据识别梯度消失

除了可视化工具之外,通过分析模型训练时的实验数据也可以诊断出梯度消失问题。梯度消失的直接表现之一是模型训练非常缓慢,或者在多次迭代后模型的损失函数值几乎不下降。我们可以通过设置监控点,记录不同训练阶段模型的性能指标,并与理论预期进行比较来发现梯度消失的迹象。

```python

# 示例代码:记录并分析梯度消失现象

# 定义损失函数和优化器

loss_function = keras.losses.SparseCategoricalCrossentropy(from_logits=True)

optimizer = keras.optimizers.Adam()

# 记录损失的历史值

loss_history = []

# 训练过程中的损失记录

for epoch in range(NUM_EPOCHS):

for batch in range(NUM_BATCHES_PER_EPOCH):

with tf.GradientTape() as tape:

logits = model(X_batch)

loss_value = loss_function(Y_batch, logits)

gradients = tape.gradient(loss_value, model.trainable_weights)

optimizer.

```

0

0