Hadoop中Snappy压缩对MapReduce作业的性能影响分析

发布时间: 2024-10-27 06:56:51 阅读量: 26 订阅数: 23

# 1. Hadoop与MapReduce概述

## 1.1 Hadoop与MapReduce简介

Hadoop是一个由Apache基金会开发的开源框架,它允许用户存储和处理大数据。它包含两个主要部分:HDFS和MapReduce。HDFS是分布式存储系统,能够存储大量数据,而MapReduce是一种编程模型,用于处理和生成大数据集的算法。

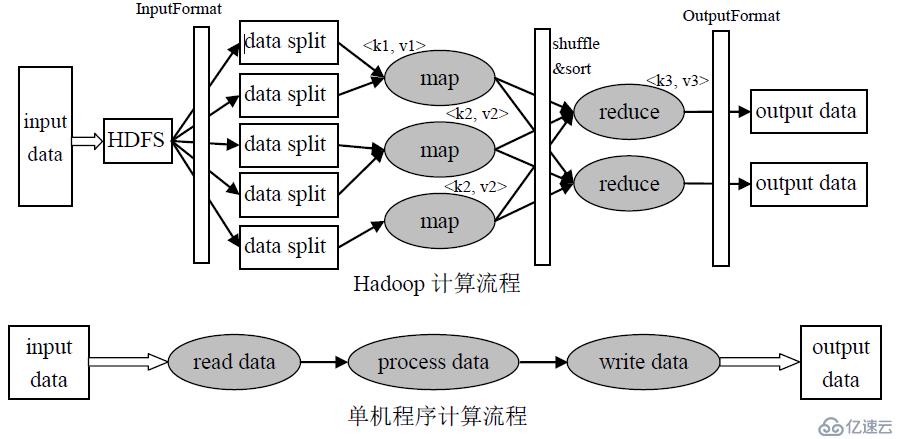

## 1.2 MapReduce的工作原理

MapReduce的工作原理是将复杂的任务分解为两个阶段:Map阶段和Reduce阶段。在Map阶段,它会对输入数据进行处理,生成中间键值对。在Reduce阶段,它会合并中间结果,生成最终的输出数据。

## 1.3 Hadoop与MapReduce的关系

Hadoop和MapReduce是相互依赖的。Hadoop提供了存储和处理大数据的环境,而MapReduce为处理这些数据提供了编程模型。MapReduce是Hadoop能够处理大数据的关键技术之一。

# 2. Snappy压缩算法原理与实现

## 2.1 Snappy压缩的基本原理

### 2.1.1 压缩与解压过程分析

Snappy压缩算法是由Google开发的,旨在提供快速压缩和解压速度,而不牺牲过多的压缩比。Snappy的设计目标是优化CPU使用效率,尤其适合用于内存中的数据压缩,以及实时数据处理场景。

在压缩阶段,Snappy会将输入的数据流划分为一系列的数据块,对每个数据块执行压缩。它使用了一系列优化策略,包括固定大小的哈希表和重复数据的引用。Snappy的压缩过程不会试图找到数据中的长期依赖关系,而是关注于短范围内的模式识别。这使得Snappy能够在不牺牲太多压缩率的情况下,实现高速压缩。

解压过程是压缩的逆过程。Snappy算法设计得足够聪明,使得解压所需的信息与压缩数据一起存储在压缩后的数据块中。因此,解压算法不需要额外的字典或查找表,这大大加快了解压速度,使得Snappy非常适合于实时压缩/解压的场景。

### 2.1.2 Snappy压缩的优势与局限性

Snappy的压缩比通常不会很高,但是它的压缩和解压速度非常快,这是它最大的优势。例如,在某些基准测试中,Snappy的压缩速度可以达到250MB/s到500MB/s,而解压速度更是高达1000MB/s以上。对于需要快速读写大量数据的应用,如Hadoop MapReduce作业,这种快速压缩与解压能力是至关重要的。

然而,Snappy也有其局限性。由于设计的简单性,它不支持一些复杂的压缩特性,如长距离依赖和复杂的压缩算法优化。这意味着Snappy的压缩率通常不如LZ77、LZMA等算法高,可能不是存储优化的理想选择。

### 2.1.3 Snappy压缩效率的实现机制

Snappy之所以能够实现高效的压缩效率,主要得益于其以下几个设计机制:

- **固定大小哈希表**:Snappy在处理数据块时使用了一个固定大小的哈希表来存储之前出现的字符串。这使得算法能够在常数时间内找到重复的数据,并进行引用,而不必依赖于复杂的字典结构。

- **单一编码方案**:Snappy采用了一种简单的编码方案,将数据块中的重复字符串替换为一个较短的引用。这种方法避免了复杂的编码决策过程,从而加快了压缩速度。

- **不记录字典**:与某些其他压缩算法不同,Snappy在压缩数据时不会记录额外的压缩字典,这减少了压缩数据的大小,同时使得解压过程无需额外的查找表。

## 2.2 Snappy在Hadoop中的集成与配置

### 2.2.1 配置Hadoop以支持Snappy压缩

Hadoop是一个广泛使用的分布式存储与计算平台,支持多种压缩算法,包括Snappy。要在Hadoop中使用Snappy压缩,首先需要确保Snappy的Java实现库已经添加到项目的依赖中。例如,在Maven项目中,可以通过添加以下依赖来实现:

```xml

<dependency>

<groupId>org.xerial.snappy</groupId>

<artifactId>snappy-java</artifactId>

<version>*.*.*.*</version>

</dependency>

```

接着,在Hadoop的配置文件(如`core-site.xml`)中,需要设置`***pression.codecs`参数来指定Snappy的编解码器:

```xml

<property>

<name>***pression.codecs</name>

<value>

***press.DefaultCodec,

***press.GzipCodec,

***press.BZip2Codec,

***press.SnappyCodec

</value>

</property>

```

这样配置之后,Hadoop将能够识别Snappy压缩格式,并在读写数据时使用它。

### 2.2.2 Hadoop中Snappy压缩的使用场景

在Hadoop生态系统中,Snappy压缩通常适用于需要快速处理大量数据的场景。在MapReduce作业中,尤其是在数据倾斜或网络I/O成为性能瓶颈的情况下,Snappy能够提供出色的性能提升。

例如,在数据导入导出、数据存储和传输过程中,使用Snappy压缩可以减少磁盘空间的占用,加快数据在网络中的传输速度,并且由于其快速的解压特性,可以加速数据处理和分析。

此外,由于Snappy的压缩和解压速度非常快,它也常被用于实时计算场景,如实时数据清洗、数据流处理等。在这些场景中,Snappy能够在不显著影响总体性能的情况下,提供合理的压缩率和数据传输效率。

接下来,让我们看看Snappy压缩对MapReduce性能的影响。

# 3. Snappy压缩对MapReduce性能的影响

随着大数据处理的不断深入,压缩技术在提高存储效率、减少网络传输开销以及提升数据处理速度方面发挥了重要作用。在Hadoop生态系统中,Snappy作为高效压缩和解压库,在MapReduce作业中的应用对于提升整体性能有着直接的影响。本章将深入分析Snappy压缩对MapReduce性能影响的理论基础,并设计实验以对比分析Snappy压缩效果。

## 3.1 理论分析:压缩对资源消耗的影响

### 3.1.1 压缩率与CPU负载的关系

Snappy压缩技术通过实现快速压缩算法来确保数据压缩与解压的速度。通过减少计算复杂度,Snappy能达到极高的压缩和解压速度,这在理论上会减轻CPU的工作负载。然而,对于MapReduce作业而言,数据压缩与解压会增加CPU周期的消耗,尤其是在数据处理的I/O密集型阶段。通过分析不同

0

0