【语义理解】:R085带你探索NLP的核心算法

发布时间: 2024-12-14 09:28:01 阅读量: 6 订阅数: 14

大数据与数据挖掘技术 人工智能NLP自然语言处理技术研究 问句中并列结构的识别 共18页.pptx

参考资源链接:[【R085】自然语言处理导论【张奇&桂韬&黄萱菁】.pdf](https://wenku.csdn.net/doc/6o0isosga3?spm=1055.2635.3001.10343)

# 1. 自然语言处理(NLP)概览

自然语言处理(NLP)是计算机科学与语言学领域相结合的交叉学科,它旨在实现人与计算机之间自然语言的交流和处理。近年来,随着深度学习技术的飞速发展,NLP已经取得了显著的进步,并广泛应用于搜索引擎、语音识别、机器翻译以及情感分析等众多领域。本章将对NLP技术进行初步介绍,探讨其在现代技术中的重要性,并为后续章节中对NLP核心算法、实践应用以及面临的挑战和优化方向的深入探讨奠定基础。

在接下来的章节中,我们将详细地阐述NLP的基本理论和实践应用,如语言模型、词嵌入、序列模型等核心算法,同时还会讨论这些技术在文本分类、机器翻译、问答系统等任务中的实际应用。此外,我们还将探讨NLP面临的挑战,如模型优化、长文本处理,以及多语言处理,并展望NLP技术的未来发展方向。

# 2. NLP核心算法的理论基础

## 2.1 语言模型和概率分布

语言模型是自然语言处理领域中的一个基本概念,它涉及到对单词或句子出现概率的预测。在自然语言处理任务中,如语音识别、机器翻译、文本生成等,良好的语言模型是提高任务准确性的关键。

### 2.1.1 马尔可夫链与隐马尔可夫模型

马尔可夫链是一种统计模型,描述了一系列事件中的状态转移概率。隐马尔可夫模型(Hidden Markov Model, HMM)是马尔可夫链的一种扩展,它假定状态是不可见的(即“隐藏”的),我们只能看到事件的结果。

- **模型组成**:HMM由以下三个基本部分组成:

- **状态集合**:每个状态代表某个可能发生的事件或某种状态。

- **观测集合**:可能观察到的事件结果,通常与状态不直接对应。

- **状态转移概率矩阵**:从一个状态转移到另一个状态的概率。

- **观测概率矩阵**(发射概率):在给定状态下产生特定观测的概率。

- **初始状态概率分布**:模型开始时各个状态的概率。

- **应用**:HMM广泛应用于语音识别、自然语言处理和生物信息学等。在文本处理中,HMM可以用来识别句子中的词性标注。

```python

# 示例:使用Python的hmmlearn库来构建和训练一个简单的HMM模型

from hmmlearn import hmm

# 设定模型参数

n_components = 3 # 三个隐状态

model = hmm.GaussianHMM(n_components=n_components, covariance_type="diag", n_iter=1000)

# 输入观测序列,这里随机生成一组数据作为示例

import numpy as np

观测序列 = np.random.randn(100, 2) # 模拟两个维度的观测数据

# 训练模型

model.fit(观测序列)

# 预测状态序列

观测序列 = np.random.randn(50, 2) # 新的观测数据

hidden_states = model.predict(观测序列)

```

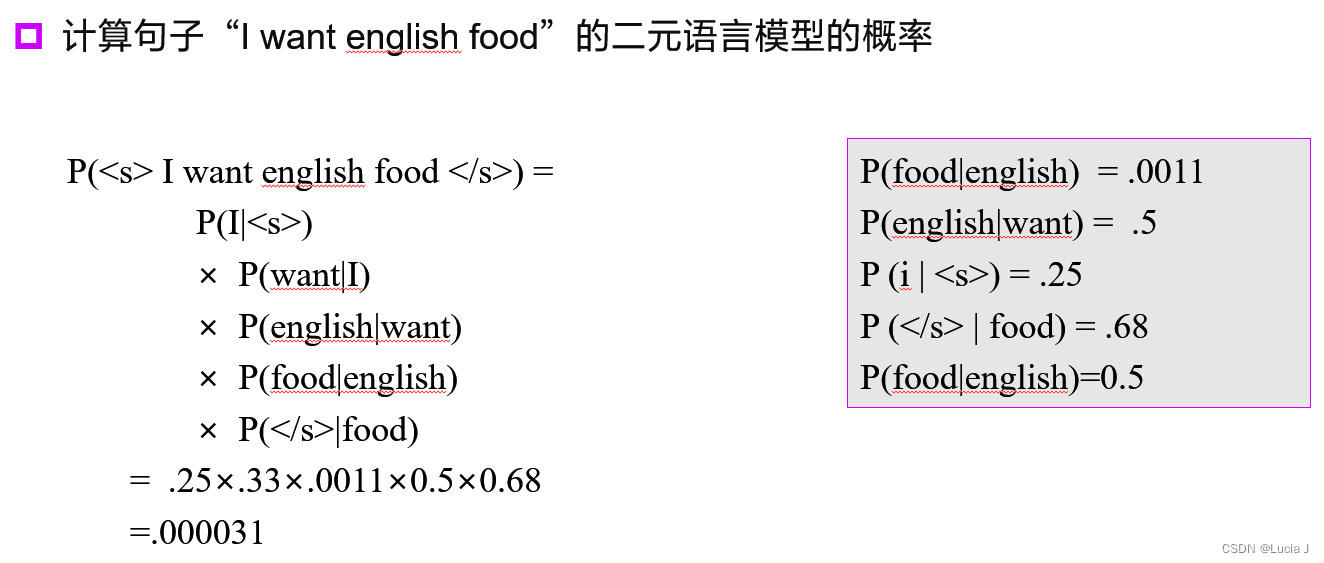

### 2.1.2 n-gram模型的原理与应用

n-gram模型是一种基于统计的语言模型,它基于一个假设:一个词的出现仅依赖于它前面的n-1个词。n-gram模型广泛应用于文本生成、拼写校正等任务。

- **模型描述**:n-gram模型通过计算词序列的概率来进行预测。例如,对于一个三元组(或称为三元组模型),“the cat sat”将基于前面的词对“the cat”和“cat sat”出现的概率来估计整个序列的概率。

- **应用**:在搜索引擎、语音识别等系统中,n-gram模型用于预测下一个可能出现的词,以改进查询自动补全、拼写检查等。

```python

# 示例:使用Python中的NLTK库来训练和评估一个bigram模型

from nltk import bigrams, FreqDist, ConditionalFreqDist

from nltk.util import ngrams

from collections import Counter

# 准备语料库

语料库 = "this is a sample text with simple bigrams and trigrams"

# 生成n-grams

bigram = bigrams(语料库.split(), n=2)

trigram = bigrams(语料库.split(), n=3)

# 计算频率分布

bigram_freq = FreqDist(bigram)

trigram_freq = FreqDist(trigram)

# 评估概率

print(bigram_freq['this', 'is']) # 输出'this is'的出现次数

print(trigram_freq['this', 'is', 'a']) # 输出'this is a'的出现次数

```

在自然语言处理中,n-gram模型的一个主要挑战是数据稀疏性,特别是对于较大数据的n值。这可以通过平滑技术来解决,例如拉普拉斯平滑、Good-Turing平滑等。

## 2.2 词嵌入与分布式表示

词嵌入(Word Embeddings)是自然语言处理中的一个关键概念,它指的是将词映射到连续的向量空间中,使得语义上相似的词在向量空间中也彼此接近。这使得计算机能够处理单词之间的语义关系。

### 2.2.1 Word2Vec的数学原理

Word2Vec是Google开发的一种词嵌入模型,它利用深度学习方法,通过训练神经网络学习到每个词的向量表示。该模型有两个架构:

- **CBOW(Continuous Bag of Words)**:给定一个词的上下文(上下文词的集合),预测中间的词。

- **Skip-gram**:给定一个词,预测它的上下文词。

- **数学原理**:Word2Vec使用一个浅层的神经网络,其中隐藏层的权重矩阵实际上是词向量的集合。通过梯度下降优化方法调整词向量,使得具有相似上下文的词在向量空间中的距离更近。

```python

# 示例:使用gensim库训练Word2Vec模型

from gensim.models import Word2Vec

from nltk.tokenize import word_tokenize

# 准备文本数据

text = "this is a sample sentence for demonstrating word embeddings"

# 分词

words = word_tokenize(text)

# 训练Word2Vec模型

model = Word2Vec([words], min_count=1)

# 获取词向量

word_vector = model.wv['sample']

print(word_vector)

```

### 2.2.2 GloVe模型与预训练词向量

GloVe(Global Vectors for Word Representation)模型是由斯坦福大学的Jeffrey Pennington、Richard Socher和Christopher Manning提出的另一种词嵌入模型。与Word2Vec不同,GloVe是一种基于全局矩阵分解的方法,它利用整个语料库中的词共现信息来生成词向量。

- **模型原理**:GloVe模型的核心思想是构建一个全局单词-单词共现矩阵,并通过矩阵分解(如奇异值分解)来得到词向量。这些向量捕捉了单词之间的统计关系,并在某种程度上包含了语义信息。

- **预训练词向量**:目前,许多研究机构和公司已经发布了预训练的词向量模型,这些模型通常基于非常大的语料库进行训练,因此能够捕获词汇丰富的语义信息。著名的预训练词向量包括Google的Word2Vec预训练模型和斯坦福的GloVe预训练模型。

```python

# 示例:加载预训练的GloVe词向量

from gensim.scripts.glove2word2vec import glove2word2vec

from gensim.models import KeyedVectors

# 下载预训练的GloVe模型

glove_file = 'glove.6B.100d.txt'

word2vec_file = 'glove.6B.100d.txt.word2vec'

glove2word2vec(glove_file, word2vec_file)

# 加载词向量

model = KeyedVectors.load_word2vec_format(word2vec_file, binary=False)

# 获取词向量

glove_vector = model['sample']

print(glove_vector)

```

词嵌入和分布式表示的提出显著提升了NLP中的多种任务性能,包括文本分类、情感分析、机器翻译等。借助预先训练好的词向量,研究人员可以在有限的数据集上更快地获得更好的结果。

# 3. NLP核心算法的实践应用

## 3.1 文本分类任务

### 3.1.1 朴素贝叶斯文本分类器

朴素贝叶斯分类器是一种基于贝叶斯定理的简单概率分类器,它假设特征之间相互独立。在文本分类任务中,每个特征可以看作是一个单词,而其出现的概率是在文档中出现该单词的频率。

```python

from sklearn.feature_extraction.text import CountVectorizer

from sklearn.naive_bayes import MultinomialNB

from sklearn.pipeline import make_pipeline

from sklearn.metrics import classification_report

# 示例文本数据

texts = [

"The weather is sunny and bright",

"The weather is cloudy and rainy",

"The weather is sunny but cold",

"The weather is cloudy but warm",

]

# 对应标签

labels = ['positive', 'negative', 'positive', 'negative']

# 创建管道:计数向量化 + 朴素贝叶斯分类器

model = make_pipeline(CountVectorizer(), MultinomialNB())

# 训练模型

model.fit(texts, labels)

# 预测

predicted = model.predict(texts)

# 输出性能报告

print(classification_report(labels, predicted))

```

上述代码块演示了如何使用`sklearn`库训练一个简单的朴素贝叶斯文本分类器。`CountVectorizer`用于将文本数据转换为数值型特征向量,而`MultinomialNB`则是实现的朴素贝叶斯分类器。`classification_report`函数用于生成性能评估报告,包括精确度、召回率、F1分数等指标。

### 3.1.2 深度学习在文本分类中的应用

深度学习模型,如卷积神经网络(CNN)和循环神经网络(RNN),在文本分类任务中取得了显著的成效。CNN能有效提取局部特征,而RNN擅长捕捉序列数据中的时间依赖性。

```python

import torch

from torch import nn

from torchtext.legacy import data, datasets

# 定义数据集字段和批量大小

TEXT = data.Field(tokenize='spacy', tokenizer_language='en_core_web_sm')

LABEL = data.LabelField(dtype=torch.float)

train_data, test_data = datasets.IMDB.splits(TEXT, LABEL)

BATCH_SIZE = 64

# 创建迭代器

train_iterator, test_iterator = data.BucketIterator.splits(

(train_data, test_data),

batch_size=BATCH_SIZE,

device=device)

class TextClassificationModel(nn.Module):

def __init__(self, vocab_size, embed_dim, num_class):

super().__init__()

self.embedding = nn.Embedding(vocab_size, embed_dim)

self.fc = nn.Linear(embed_dim, num_class)

def forward(self, text):

embedded = self.embedding(text)

return self.fc(embedded.mean(1))

# 实例化模型

model = TextClassificationModel(len(TEXT.vocab), 100, 1)

# 定义损失函数和优化器

criterion = nn.BCEWithLogitsLoss()

optimizer = torch.optim.Adam(model.parameters())

```

在上面的代码中,我们使用`torchtext`库加载了IMDB数据集,并定义了一个简单的文本分类模型。该模型包含一个嵌入层和一个全连接层,用于预测文本的情感类别。通过定义损失函数`BCEWithLogitsLoss`(二元交叉熵损失),我们为模型提供了一个适合二分类任务的优化器。

## 3.2 机器翻译技术

### 3.2.1 基于规则的翻译系统

基于规则的机器翻译系统利用人类制定的语法规则和双语对照词典来翻译文本。尽管这种方法在早期的机器翻译研究中占主导地位,但它的局限性在于难以覆盖语言的所有规则和例外情况,以及维护更新规则的成本很高。

### 3.2.2 神经机器翻译系统的实践

神经机器翻译(NMT)是通过使用深度学习架构,尤其是序列到序列(seq2seq)模型,来实现翻译的。这种模型由编码器和解码器组成,能够捕捉输入和输出序列之间的复杂映射。

```python

import torch

import torch.nn as nn

impor

```

0

0