【序列标注】:NLP深度学习应用详解——R085技术深度解析

发布时间: 2024-12-14 09:20:12 阅读量: 6 订阅数: 14

R语言大会-自然语言处理 深度学习在NLP结构化模型中的应用 共50页.pdf

参考资源链接:[【R085】自然语言处理导论【张奇&桂韬&黄萱菁】.pdf](https://wenku.csdn.net/doc/6o0isosga3?spm=1055.2635.3001.10343)

# 1. 序列标注技术简介

序列标注是一种将标签序列分配给输入序列的技术,广泛应用于自然语言处理(NLP)中,用于识别文本中的实体和结构。作为理解文本的基础,序列标注在文本挖掘、信息提取、语音识别等领域扮演着核心角色。本章旨在概述序列标注技术的基础知识,为深入理解后续章节中的复杂模型和应用案例奠定基础。通过对序列标注基本概念和常用技术的介绍,我们将引导读者掌握序列标注的初步概念和应用价值。接下来的章节将会深入探讨深度学习在序列标注中的应用,为IT专业人员提供一条全面掌握最新序列标注技术的学习路径。

# 2. 深度学习基础与NLP

### 2.1 深度学习的基本概念

深度学习是一种通过构建人工神经网络模拟大脑处理信息方式的机器学习方法。其基本单元是人工神经元,而这些神经元通过层次结构相互连接,形成不同的网络拓扑结构,以学习数据的特征表示。

#### 2.1.1 人工神经网络原理

人工神经网络(ANN)是深度学习的基础,由大量简单的人工神经元构成。这些神经元通过可训练的权重与偏置进行相互连接,模拟生物神经网络的运算过程。一个典型的神经网络包含输入层、多个隐藏层和输出层。

```

# 伪代码展示人工神经网络的基本构成

class ArtificialNeuron:

def __init__(self):

self.weights = [] # 权重列表

self.bias = 0 # 偏置值

def feedforward(self, inputs):

# 计算加权输入和输出

output = 0

for i in range(len(inputs)):

output += self.weights[i] * inputs[i]

output += self.bias

# 应用激活函数

return activation_function(output)

def activation_function(x):

# 这里是简单的Sigmoid激活函数

return 1 / (1 + exp(-x))

```

在上述伪代码中,`ArtificialNeuron` 类定义了一个简单的人工神经元,`feedforward` 方法执行了信号的前馈传递,同时包含一个激活函数来模拟神经元的非线性响应。权重和偏置是需要在训练过程中通过反向传播算法调整的参数。

#### 2.1.2 前馈神经网络与反向传播

前馈神经网络是最初级的神经网络模型,信号以单向方式从输入层流向输出层,中间没有循环。前馈神经网络的训练通常依赖于反向传播算法,这是一种高效的方法,能够通过链式法则计算损失函数对于网络权重的梯度,从而指导网络权重的调整。

```

# 伪代码展示反向传播算法的简化过程

def backward_pass(neural_network, inputs, outputs, learning_rate):

# 计算输出层误差和梯度

output_layer = neural_network.layers[-1]

error = calculate_error(output_layer, outputs)

gradients = calculate_gradients(output_layer, error)

# 更新输出层权重

output_layer.weights -= learning_rate * gradients

# 逐层反向传播误差和梯度

for i in range(len(neural_network.layers) - 2, -1, -1):

layer = neural_network.layers[i]

error = back_propagate_error(layer, gradients)

gradients = calculate_gradients(layer, error)

# 更新权重和偏置

layer.weights -= learning_rate * gradients

def calculate_error(layer, expected_output):

# 这里计算输出层误差,例如均方误差

return expected_output - layer.output

def back_propagate_error(layer, gradients):

# 这里用于计算传递给前一层的误差

return gradients # 简化示例,具体取决于激活函数

```

在上述伪代码中,`backward_pass` 函数执行了一个简化版的反向传播过程。它首先计算输出层的误差和梯度,然后将误差反向传播至隐藏层,并更新各层的权重。

### 2.2 自然语言处理(NLP)概述

自然语言处理是计算机科学、人工智能和语言学交叉的一个领域,旨在使计算机能够理解人类的语言。

#### 2.2.1 NLP的重要性与发展历程

自然语言处理的重要性在于它能够为计算机系统提供理解和处理人类语言的能力。从早期的基于规则的系统到基于统计的模型,再到当前的深度学习模型,NLP领域经历了快速的发展和变革。深度学习的引入显著提升了NLP任务的处理能力。

#### 2.2.2 NLP中的常见任务和模型

NLP中的任务涵盖了从文本分类到语义理解的各个层面。常见的NLP任务包括机器翻译、情感分析、命名实体识别等。近年来,预训练语言模型如BERT、GPT等在NLP任务中取得了突破性的性能,极大地推动了NLP技术的发展。

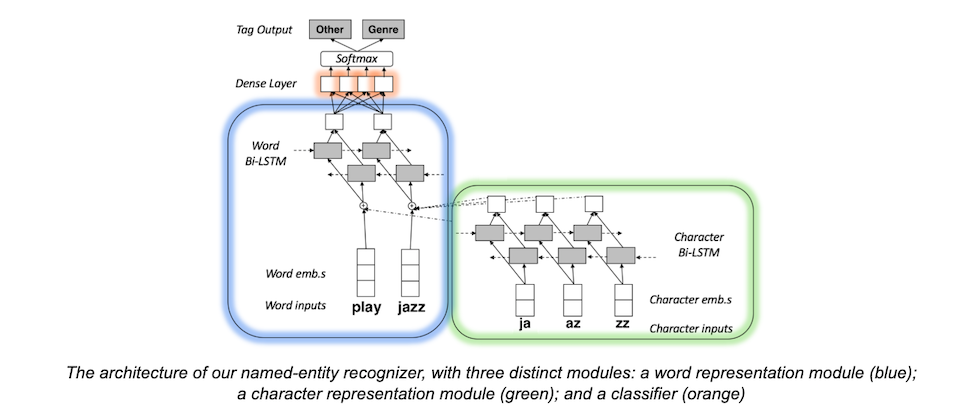

### 2.3 深度学习在NLP中的应用

深度学习不仅改进了NLP任务的性能,还引入了新的模型和方法,比如词嵌入和基于注意力的模型等。

#### 2.3.1 词嵌入和语言模型

词嵌入是一种将单词转换为密集向量的技术,使得语义上相近的词在向量空间中也相近。这一技术极大地改善了对自然语言的理解。语言模型如RNN、LSTM等则为理解语言序列提供了强大的计算框架。

```

# 使用Word2Vec生成词嵌入的简化示例

def train_word2vec(corpus, dimensions):

model = Word2VecModel(dimensions)

model.train(corpus)

return model

```

在上述伪代码中,`train_word2vec` 函数表示训练一个Word2Vec模型的过程。它接受语料库和向量维度作为输入,返回训练好的模型。这个模型可以将单词转换为密集的向量表示,以便用于后续的NLP任务。

#### 2.3.2 循环神经网络(RNN)与序列处理

循环神经网络特别适用于处理序列数据,如文本。RNN通过在时间步上共享权重来处理不同长度的序列,能够捕捉到序列中的时间依赖关系。RNN在语言模型、语音识别等领域得到了广泛应用。

```

# RNN用于序列数据处理的伪代码

def simple_rnn(input_sequence, weights, bias):

output_sequence = []

hidden_state = zeros(len(weights[0])) # 初始化隐藏状态

for input in input_sequence:

# 计算当前时间步的隐藏状态

hidden_state = tanh(dot(weights[0], input) + dot(weights[1], hidden_state) + bias)

output_sequence.append(hidden_state)

return output_sequence

```

在上述伪代码中,`simple_rnn` 函数实现了RNN的基本操作。它通过循环对输入序列进行处理,并在每个时间步更新隐藏状态,最终产生一个序列的输出。这里的激活函数使用了双曲正切函数(tanh

0

0