分词技术精讲:NLP领域的关键步骤详解

发布时间: 2024-09-02 15:39:40 阅读量: 63 订阅数: 45

# 1. 分词技术概述

## 1.1 分词技术简介

分词技术是自然语言处理(NLP)领域的一项基础而核心的技术,其主要任务是将连续的文本切分为有意义的最小语言单位——词。在中文等没有明显单词界限的语言中,分词尤其重要。正确分词是实现后续文本分析、搜索、翻译等功能的前提。

## 1.2 分词技术的应用价值

分词技术在搜索引擎、语音识别、文本分析、机器翻译等多个领域发挥着至关重要的作用。一个精确的分词系统能够显著提升下游任务的性能,例如,在搜索引擎中,分词质量直接影响搜索结果的相关性与准确性。

## 1.3 分词技术的发展与挑战

随着技术的发展,分词算法不断进步,从最初的基于规则的方法,到基于统计的模型,再到如今以深度学习为基础的模型。然而,分词技术仍然面临诸多挑战,如处理未登录词、跨领域适应性等。后续章节将对这些挑战和解决方案进行深入探讨。

# 2. 分词技术的理论基础

## 2.1 自然语言处理简介

### 2.1.1 自然语言处理的基本概念

自然语言处理(Natural Language Processing,NLP)是计算机科学、人工智能以及语言学领域的一个交叉学科,其目的是让计算机能够理解和生成人类语言。NLP 不仅包括文本的处理,还涵盖了语音识别、语音合成、机器翻译等多种应用。

自然语言处理的核心在于模拟人类语言的理解和表达能力,这涉及到对自然语言中的语法、语义和语境等信息的处理。为了达到这个目标,NLP 技术通常需要解决诸如语言的歧义、上下文依赖、不规则表达等问题。

### 2.1.2 自然语言处理的发展历史

自然语言处理的研究可以追溯到20世纪中叶,当时的研究主要集中在语言学理论和结构分析上。随着计算机技术的发展,NLP开始从理论转向实践,并逐渐演变为一个涉及计算机科学、人工智能和语言学等多个学科的综合性领域。

早期的NLP应用主要基于规则系统,依赖于明确的语言学规则来解析和理解自然语言。随着时间的推移,统计学方法开始被广泛应用于NLP,尤其是在机器翻译和语音识别等领域。近年来,随着深度学习技术的崛起,NLP领域也经历了革命性的变化,特别是在语言模型和语义理解方面取得了显著的进展。

## 2.2 分词技术的重要性

### 2.2.1 分词在NLP中的角色

分词(Tokenization)是自然语言处理中的一个基本环节,它将连续的文本切分成有意义的最小单位——词或词素。在中文、日语和朝鲜语等没有明显单词边界的语言中,分词尤为重要,因为计算机无法像人类一样直观地识别单词的边界。

分词技术在NLP中扮演着至关重要的角色。例如,在文本检索、信息抽取、机器翻译等应用中,正确地将文本切分成词是构建后续NLP模块的基础。如果分词不准确,后续处理环节的性能将受到严重影响。

### 2.2.2 分词技术的挑战与机遇

尽管分词是NLP的基础,但其自身也存在诸多挑战。由于语言的多样性和复杂性,分词过程可能面临多种歧义问题,如交集型歧义和组合型歧义。这些问题需要借助更高级的算法来解决。

同时,分词技术的发展也带来了新的机遇。随着深度学习等技术的引入,分词模型可以更加精准地捕捉语言的深层语义,为自然语言处理的其他任务提供更优质的服务。未来,分词技术的发展将更多地依靠大数据和算法的创新。

## 2.3 分词算法的分类与原理

### 2.3.1 基于规则的分词方法

基于规则的分词方法依赖于语言学家制定的一系列规则,这些规则包括词的组合、构词法等,用以判断词的边界。这种方法的优点在于可以准确处理一些复杂的语言现象,如成语和专有名词等。

然而,基于规则的分词方法有其局限性。首先,规则的制定往往需要耗费大量的人力和时间。其次,规则法很难适应语言的多样性和动态变化,尤其是对于多义词和新词的处理较为困难。

### 2.3.2 基于统计的分词方法

与基于规则的方法不同,基于统计的分词方法通过大量的语言材料来统计词的出现频率,以此来判断词的边界。这种方法的一个重要组成部分是统计模型,如隐马尔可夫模型(HMM)和条件随机场(CRF)。

基于统计的分词方法能够更好地适应语言的变化,尤其在处理歧义问题时表现得更为出色。不过,该方法也存在缺陷,比如需要大量的标注数据来训练模型,且对未见过的词或新词的处理能力有限。

### 2.3.3 基于机器学习的分词方法

随着机器学习和深度学习技术的发展,基于机器学习的分词方法逐渐成为主流。这些方法通常依赖于大规模的语料库和先进的算法来自动学习语言的规律。

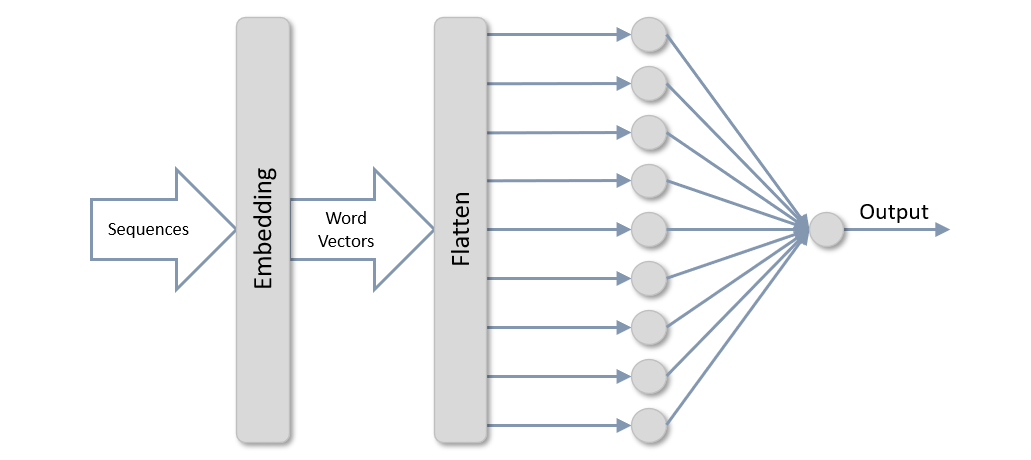

其中,深度学习模型,如循环神经网络(RNN)、长短时记忆网络(LSTM)以及最近兴起的Transformer模型和BERT,为分词技术带来了前所未有的精度和灵活性。基于深度学习的分词模型不仅能够处理歧义问题,还能够通过上下文信息推断新词,极大地提高了分词的准确性和效率。

# 3. 分词技术实践应用

## 3.1 分词工具的选择与使用

### 3.1.1 常见中文分词工具的比较

在处理中文文本时,选择合适的分词工具对于提高后续处理的效率和准确性至关重要。中文分词工具众多,每种工具有其独特的优势和应用场景。以下是几种常见的中文分词工具及其对比分析:

- **HanLP**:HanLP是由一系列模型与算法组成的Java库,它支持多种分词模式,具有较高的准确率,并且性能优异,特别适合需要在Java环境中进行中文分词的场景。

- **jieba**:jieba分词是一款流行的Python中文分词库,它提供了简体中文分词功能,支持繁体分词、关键词提取、词性标注等功能。由于其易于使用和扩展性好,特别受到Python开发者的青睐。

- **THULAC**:THULAC(THU Lexical Analyzer for Chinese)是由清华大学自然语言处理与社会人文计算实验室开发的一款中文分词和词性标注工具。它的分词准确率高,词性标注准确率也相当不错,并且速度较快。

- **ICTCLAS**:ICTCLAS是中科院计算所开发的中文分词系统,其特点是速度快,分词准确,得到了广泛的应用。它也是较早被研发并被集成到许多中文处理系统中的分词工具。

上述工具各有千秋,选择时需根据实际需求、性能考量以及开发环境的偏好进行选择。HanLP和ICTCLAS更适合企业级应用,jieba由于其语言优势,在研究和原型开发中较为流行。THULAC则在学术研究与教育领域中使用较多。

### 3.1.2 分词工具的实际操作流程

以jieba分词为例,其操作流程大致分为安装、基本分词、关键词提取等步骤。以下为操作步骤及其代码逻辑分析:

```python

# 安装jieba分词库

!pip install jieba

# 导入jieba库

import jieba

# 对一段文本进行基本分词

sentence = "我爱北京天安门。"

words = jieba.lcut(sentence)

print(words)

# 对一段文本进行关键词提取

keywords = jieba.analyse.extract_tags(sentence)

print(keywords)

```

逻辑分析:

- 第一步是安装jieba库,这可以通过Python的包管理工具pip来完成。

- 第二步是导入jieba库,使其可以在我们的脚本中使用。

- 第三步是使用`lcut`函数对给定的句子进行分词,并打印结果。`lcut`是`list`和`cut`的结合,意味着它会返回一个包含所有分词结果的列表。

- 第四步是使用`analyse.extract_tags`函数提取句子中的关键词,并打印结果。这个函数默认使用TF-IDF算法来计算关键词的重要性。

需要注意的是,jieba分词还支持自定义词典,当处理特定领域的文本时,导入相关专业术语的词典可以显著提高分词的准确率。

## 3.2 分词技术在文本处理中的应用

### 3.2.1 文本分类与主题建模

文本分类和主题建模是自然语言处理中常见的两种应用方式。分词技术在其中扮演着至关重要的角色,因为它们需要先将文本转换为机器可理解和处理的形式。

文本分类通常指的是将文本内容划分到特定的类别中,例如新闻分类、垃圾邮件检测等。进行文本分类时,需要先对文本进行分词处理,然后提取特征,并最终通过机器学习模型进行分类。

```python

# 假设使用jieba进行分词

from sklearn.feature_extraction.text import CountVectorizer

from sklearn.naive_bayes import MultinomialNB

from sklearn.pipeline import make_pipeline

# 一些用于分类的简单文本数据

data = [

"爱编程爱生活",

"热爱编程热爱生活",

"生活不止眼前的苟且",

"还有诗和远方的田野"

]

# 使用jieba分词后,结合CountVectorizer转换文本为向量形式

# 使用多项式朴素贝叶斯进行分类

model = make_pipeline(CountVectorizer(tokenizer=jieba.lcut), MultinomialNB())

# 训练模型

model.fit(data, ['编程', '生活', '生活', '诗和远方'])

# 分类新的文本

print(model.predict(["学习编程改变生活"]))

```

0

0