意图识别在NLP中的应用:方法与实践深入解析

发布时间: 2024-09-02 16:18:06 阅读量: 148 订阅数: 50

人工智能-项目实践-意图识别-基于意图识别和命名实体识别的多轮对话场景设计.zip

# 1. 意图识别在自然语言处理中的重要性

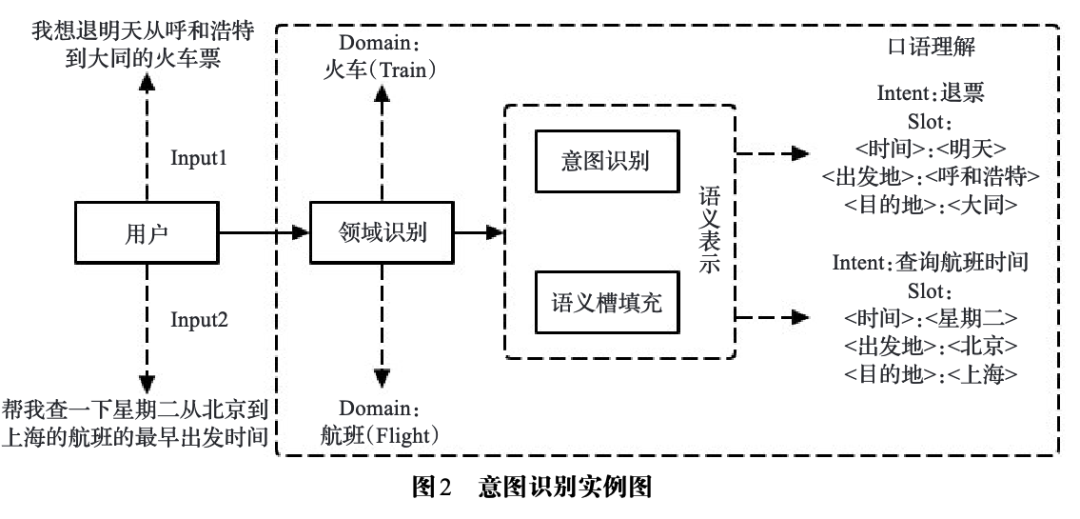

意图识别是自然语言处理(NLP)领域中的关键任务,其目的在于理解用户表达的意图并作出相应的响应。在人机交互、客服自动化、智能推荐系统等多个应用中,意图识别都扮演着至关重要的角色。随着人工智能技术的不断进步,对意图识别的准确性和效率提出了更高的要求,它不仅能够提升用户体验,还能够在商业智能、数据分析等领域发挥巨大潜力。因此,研究意图识别的原理与方法,对于推动整个自然语言处理技术的发展具有重要的意义。本章将对意图识别的重要性进行详细介绍,并探讨其在各行业中的应用前景。

# 2. 意图识别的技术基础

## 2.1 机器学习与深度学习理论

### 2.1.1 监督学习与无监督学习

监督学习是机器学习中的一种范式,它使用标记的训练数据来训练模型,模型通过学习输入和输出之间的映射关系进行预测。在监督学习中,数据集被分为输入变量(通常表示为X)和输出变量(通常表示为Y)。模型通过在训练数据上进行学习,以预测新的数据点的输出。

无监督学习则与监督学习不同,它不依赖于标记数据,而是使用未标记的数据来发现数据内在的结构和模式。无监督学习的常见任务包括聚类、关联规则学习和降维等。无监督学习能够发现数据的内在分布,对于理解数据的底层结构和进行探索性数据分析特别有用。

### 2.1.2 神经网络的基本原理

神经网络是一种由大量相互连接的节点(或称为神经元)组成的计算模型,模仿了人脑神经元的工作方式。在机器学习中,特别是深度学习中,神经网络是一系列非线性变换,这些变换能够将输入数据转换为输出结果。

在最基本的层次上,神经网络包括输入层、隐藏层(可以有多个)和输出层。每个层包含一系列神经元,而神经元之间的连接则通过权重参数来表示。在训练过程中,通过反向传播算法对权重进行调整,使得模型的预测结果尽可能接近真实值。

### 2.1.3 深度学习在意图识别中的作用

深度学习在意图识别中的作用是巨大的。与传统的机器学习方法相比,深度学习模型能更有效地处理非结构化数据,如文本和语音。利用深度学习模型,如循环神经网络(RNN)和长短期记忆网络(LSTM),可以捕捉语言中的长距离依赖关系,这对于理解句子的语义至关重要。

深度学习还可以通过端到端学习直接从原始数据到最终决策,减少了特征工程的需要。这意味着模型可以在没有人为干预的情况下学习到数据中的复杂模式,从而提高意图识别的准确性。

## 2.2 意图识别的预处理技术

### 2.2.1 文本清洗与标准化

文本清洗是意图识别前的必要步骤,目的是移除或替换文本中影响模型处理的噪声元素。常见的文本清洗步骤包括去除停用词(如“的”、“和”等常见词汇)、标点符号和数字,以及统一词的大小写。标准化涉及将文本转换为标准格式,如将所有的中文字符统一为简体或繁体,处理同义词或近义词问题等。

```python

import jieba

# 示例代码:中文文本清洗与标准化

def clean_and_normalize_text(text):

# 分词

words = jieba.cut(text)

# 移除停用词

stop_words = set(["的", "和", "是"])

words = [word for word in words if word not in stop_words]

# 连接成标准化文本

normalized_text = " ".join(words)

return normalized_text

text = "这是一个示例文本,用于展示文本清洗和标准化的过程。"

normalized_text = clean_and_normalize_text(text)

print(normalized_text)

```

### 2.2.2 分词技术与词性标注

分词是中文意图识别中最重要的预处理步骤之一。中文文本不同于英文,不以空格分隔词汇,因此需要通过分词算法将句子切分为单词或短语。分词之后,通常还会进行词性标注,即为每个词赋予相应的词性(如名词、动词、形容词等)。

```python

import jieba.posseg

# 示例代码:中文分词与词性标注

def segment_and_pos_tag(text):

words = jieba.posseg.cut(text)

result = [(word.word, word.flag) for word in words]

return result

text = "我爱北京天安门"

segments = segment_and_pos_tag(text)

print(segments)

```

### 2.2.3 词向量表示与嵌入

在深度学习中,词向量表示是一个关键的技术。词向量(Word Embeddings)是将词语转换为密集的实数向量的技术,向量通常通过词嵌入(Word Embeddings)模型如Word2Vec、GloVe等训练得到。词向量能够捕捉词语之间的语义关系和语法规则,对模型理解句子的深层含义非常有帮助。

```python

from gensim.models import Word2Vec

# 示例代码:训练词向量模型

# 假设已有分词后的句子列表

sentences = [["我", "爱", "北京", "天安门"], ["天安门", "上", "太阳", "升"]]

# 训练Word2Vec模型

model = Word2Vec(sentences, vector_size=100, window=5, min_count=1, workers=4)

# 查看词向量

word_vector = model.wv['天安门']

print(word_vector)

```

## 2.3 特征工程与模型选择

### 2.3.1 特征提取方法

在意图识别中,特征提取是一个关键步骤,它将原始数据转换为模型可以处理的数值特征。常见的特征提取方法包括基于词袋(Bag of Words, BoW)的表示,TF-IDF(Term Frequency-Inverse Document Frequency),以及词向量表示等。

```python

from sklearn.feature_extraction.text import TfidfVectorizer

# 示例代码:使用TF-IDF进行特征提取

corpus = ["我爱北京天安门", "天安门上太阳升"]

vectorizer = TfidfVectorizer()

X = vectorizer.fit_transform(corpus)

print(X.toarray())

```

### 2.3.2 模型评估标准

模型评估标准用于衡量意图识别模型的性能。常用的评估指标包括准确率(Accuracy)、精确率(Precision)、召回率(Recall)和F1分数等。准确率表示模型正确预测的数量占总样本数量的比例,而精确率和召回率则分别关注模型预测的准确性和完整性。F1分数是精确率和召回率的调和平均数,提供了单一的性能度量。

### 2.3.3 模型选择与超参数调优

在构建意图识别模型时,选择合适的算法和调整超参数是非常关键的。不同的机器学习和深度学习模型都有其特点和适用场景,如朴素贝叶斯适合文本分类,而循环神经网络(RNN)和长短期记忆网络(LSTM)则适合处理序列数据。通过交叉验证和网格搜索等方法,可以系统地选择模型并调优超参数,以获得最优的性能。

```python

from sklearn.model_selection import GridSearchCV

from sklearn.svm import SVC

# 示例代码:使用网格搜索进行模型超参数调优

parameters = {'C': [1, 10, 100], 'gamma': [0.01, 0.001]}

svc = SVC()

clf = GridSearchCV(svc, parameters, cv=5)

clf.fit(X, y) # 假设X为TF-IDF转换后的特征,y为目标标签

print(clf.best_params_)

```

以上章节介绍了意图识别技术基础的核心概念和方法,通过以上内容的深入理解,为构建实际的意图识别系统打下坚实的基础。

# 3. 意图识别的实践应用

## 3.1 基于规则的意图识别系统

意图识别是自然语言处理(NLP)中的关键任务,其目的是从用户的查询或句子中识别出背后的具体意图。基于规则的意图识别系统依赖于预定义的规则集来识别意图,这在领域相对封闭且规则较为固定的场景下表现良好。

### 3.1.1 规则定义与匹配算法

在基于规则的方法中,规则定义通常涉及到正则表达式、关键词匹配或者基于语法的模板匹配。这些规则用于提取用户输入中的关键信息,进而识别出用户的意图。

#### 正则表达式

正则表达式是通过一组字符来定义一个文本模式,然后用来检查、分割或替换那些符合这个模式的字符串。例如,如果意图是“查询天气”,我们可能会定义如下的正则表达式规则:

```regex

天气查询: 查询(天气|气象)

```

在这个规则中,“查询(天气|气象)”会匹配所有含有“查询天气”或“查询气象”的文本片段。

#### 关键词匹配

关键词匹配是基于规则系统中常用的技术。通过为每个意图定义一组关键词或者短语,系统将检查用户输入中是否包含这些关键词来识别意图。例如:

```regex

转账: 转账|汇款|支付

```

用户输入“我需要向朋友转账”将被识别为“转账”意图。

#### 模板匹配

模板匹配将意图和用户输入的形式化为模板,当用户输入与某个模板相匹配时,相应的意图被识别。例如,针对“预订酒店”的意图,可以定义如下模板:

```regex

预订酒店: 我要订一个房间|帮我预定房间|我想预订酒店

```

#### 匹配算法

实现关键词和模板匹配的算法通常涉及字符串匹配和模式匹配技术。一个常见的算法是Levenshtein距离(编辑距离),它衡量两个字符串之间的差异,有助于在用户输入和模板之间实现模糊匹配。

### 3.1.2 系统构建与案例分析

构建一个基于规则的意图识别系统涉及到将上述规则应用到一个编程框架中,并提供必要的接口来接收用户输入和返回意图识别结果。

#### 系统架构

```mermaid

graph LR

A[用户输入] -->|字符串| B[预处理]

B --> C[规则引擎]

C -->|匹配结果| D[意图输出]

```

#### 案例分析

考虑一个简单的例子,一个基于规则的意图识别系统可以处理以下输入:

- “我想查看明天的天气预报。”

- “请帮我订一个去上海的机票。”

在这个例子中,系统将基于定义好的规则集来识别“查询天气”和“预订机票”的意图。

### 3.2 基于机器学习的意图识别系统

虽然基于规则的方法简单明了,但它缺乏灵活性,尤其对于开放域的对话系统而言。因此,越来越多的意图识别系统采用机器学习方法,尤其是在数据丰富的领域。

#### 3.2.1 算法实现与框架选择

使用机器学习算法的意图识别,涉及到特征提取和模型训练。以下是常用的方法和框架。

##### 特征提取方法

在机器学习方法中,特征提取至关重要。文本数据通常被转换为数值型特征向量,这可以使用诸如词袋模型(Bag of Words)、TF-IDF(Term Frequency-Inverse Document Frequency)或者词嵌入(如Word2Vec、GloVe)。

```python

from sklearn.feature_extraction.text import TfidfVectorizer

# 示例数据

documents = [

'我想查询天气预报',

'请帮我订一个去上海的机票',

# ...

]

# 初始化TF-IDF向量化器

vectorizer = TfidfVectorizer()

# 词频特

```

0

0