机器翻译探索:跨越语言界限的NLP挑战

发布时间: 2024-09-02 16:13:42 阅读量: 24 订阅数: 50

生成式语言模型与通用人工智能:内涵、路径与启示.pdf

# 1. 机器翻译概述及应用背景

## 1.1 机器翻译的定义

机器翻译(Machine Translation,简称MT)是利用计算机技术,将一种自然语言转换成另一种自然语言的过程。其核心是模拟人类的语言理解和语言生成过程,通过算法和模型,将源语言的文本或话语自动转化为目标语言的对应文本或话语。

## 1.2 应用背景

随着全球化和信息化的快速发展,语言交流的需求日益增长,机器翻译应运而生。它广泛应用于国际商务、外交、学术研究、多语言互联网信息处理等多个领域。机器翻译不但可以提高翻译效率,降低翻译成本,还可以帮助人们跨越语言障碍,实现更广泛的交流与合作。

## 1.3 发展历程

机器翻译的发展始于20世纪中叶,经历了从基于规则的翻译系统,到统计机器翻译(SMT),再到近年来的神经机器翻译(NMT)的演变。当前,以深度学习为基础的NMT以其更佳的翻译质量和对语境的理解能力,已经成为行业标准。未来,随着技术的不断进步,机器翻译有望实现更自然、更准确的语言转换。

```

(注:以上内容为示例性质,后续章节内容将按照实际提供的目录结构进行详细展开)

```

# 2. 机器翻译的理论基础

### 2.1 语言学与机器翻译

#### 2.1.1 语言学对机器翻译的影响

语言学作为研究人类语言的科学,为机器翻译提供了理论支持和方法论指导。机器翻译系统需要理解语言的本质,包括语法、语义和语用等方面,才能准确地翻译语言。语言学理论对于自然语言处理(NLP)技术的发展起到了关键作用,尤其是在句法分析和语义理解方面。早期的机器翻译系统主要依赖于规则,这些规则大多基于语言学理论构建。例如,在基于规则的翻译系统中,词性标注和依存关系解析是常见的语言学概念应用。

#### 2.1.2 语言模型在机器翻译中的作用

语言模型是机器翻译系统的核心组成部分,它负责评估句子的流畅性和自然度。传统的n-gram语言模型通过统计大量的文本语料,预测一个词序列出现的概率。现代机器翻译系统更多地采用基于神经网络的语言模型,例如RNN、LSTM和Transformer模型,这些模型不仅考虑了词的局部序列信息,还能够捕捉长距离的依赖关系。语言模型的进步极大地推动了机器翻译质量的提升。

```python

# 一个简单的n-gram语言模型示例代码

from collections import defaultdict

import math

def train_ngram_model(text, n):

model = defaultdict(lambda: defaultdict(lambda: 0))

for i in range(len(text) - n):

model[text[i:i+n]][text[i+n]] += 1

# 转换为概率

for word_list in model:

total_count = float(sum(model[word_list].values()))

for word in model[word_list]:

model[word_list][word] /= total_count

return model

def ngram_probability(model, sequence):

try:

prob = 1.0

for i in range(len(sequence)-1):

prob *= model[sequence[i]][sequence[i+1]]

except KeyError:

prob = 0

return prob

text = "machine translation is an area of computer science"

trained_model = train_ngram_model(text, 2) # train a bigram model

print(ngram_probability(trained_model, text.split()[:3])) # calculate the probability of the first two words

```

在上述代码中,我们训练了一个简单的二元语言模型,并计算了文本中前两个词的出现概率。该模型基于统计方法,不需要复杂的神经网络结构。

### 2.2 翻译模型的数学原理

#### 2.2.1 统计机器翻译的数学基础

统计机器翻译(SMT)是基于概率论和统计学原理的翻译方法。其核心思想是找到最有可能产生原文的译文,也就是最大化译文的条件概率。这一过程涉及到对翻译模型、语言模型和解码算法的数学建模。在统计机器翻译中,翻译模型描述了源语言和目标语言之间的对齐关系,而语言模型则用来评估翻译结果的流畅性。

#### 2.2.2 神经机器翻译的数学模型

神经机器翻译(NMT)使用深度学习技术,特别是神经网络模型来学习源语言和目标语言之间的映射关系。其数学基础通常依赖于序列到序列(seq2seq)的学习框架,其中包含了编码器(encoder)和解码器(decoder)两个关键部分。编码器负责将源语言句子编码成一个连续的向量表示,而解码器则基于这个表示来生成目标语言句子。这些过程是通过优化损失函数来实现的,损失函数通常与目标句子的概率分布有关。

```python

# 简单的序列到序列模型的结构表示

# 伪代码,展示了编码器和解码器的结构

class Encoder(nn.Module):

def __init__(self):

super(Encoder, self).__init__()

# ... (encoder layer definitions)

def forward(self, src):

# ... (forward pass, encoding the source sentence)

return encoded_state

class Decoder(nn.Module):

def __init__(self):

super(Decoder, self).__init__()

# ... (decoder layer definitions)

def forward(self, encoded_state):

# ... (forward pass, decoding from the encoded state)

return output_sentence

encoder = Encoder()

decoder = Decoder()

source_sentence = "machine translation"

encoded_state = encoder(source_sentence)

translated_sentence = decoder(encoded_state)

```

在这个结构示例中,我们定义了一个编码器类和一个解码器类,它们共同构成了一个简单的seq2seq模型。这种模型的结构设计允许我们使用深度学习框架(如PyTorch)来处理自然语言处理任务。

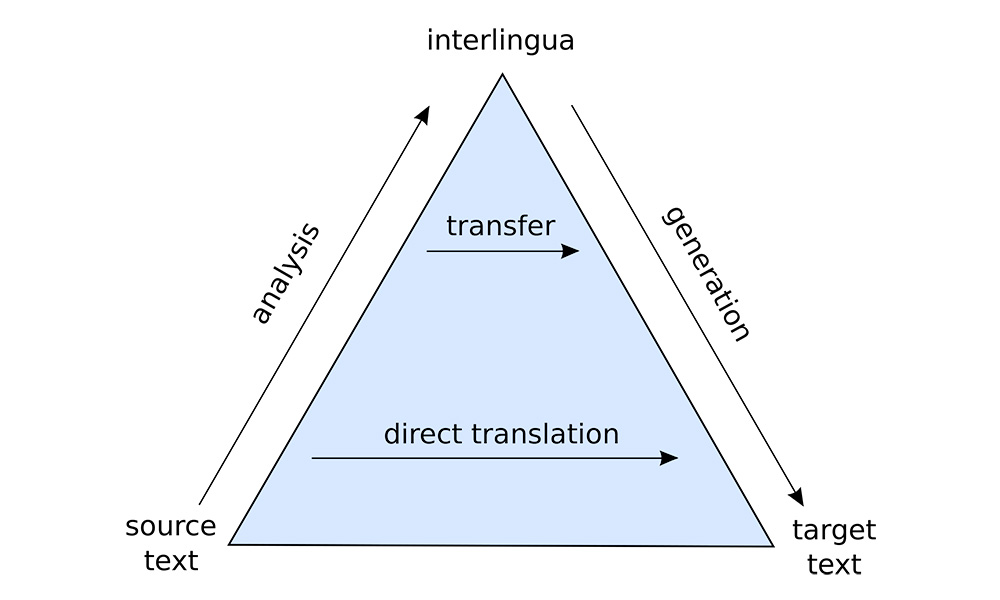

### 2.3 机器翻译技术的发展历程

#### 2.3.1 从规则到统计

早期的机器翻译系统依赖于规则,即一组明确的语法规则和词汇转换规则。但这种方法的局限性在于它无法有效处理语言的多样性和复杂性,因此难以覆盖所有可能的语言表达。随着计算能力的提升和可获取的数据量的增加,统计方法开始被引入到机器翻译中。统计机器翻译利用大规模的双语语料库,通过统计方法来发现语言规律,并自动学习翻译模型。

####

0

0