语音识别技术深度解读:自然语言处理与语音数据的完美融合

发布时间: 2024-11-21 14:22:11 阅读量: 68 订阅数: 41

解析深度学习:语音识别实践

# 1. 语音识别技术概述

语音识别技术是计算机科学与人工智能领域中的一项关键技术,它涉及到计算机理解和处理人类语音信号的能力。这项技术的实现需要跨越多个学科,包括信号处理、机器学习、自然语言处理以及人机交互等。随着智能设备的普及和人工智能技术的发展,语音识别技术已经在各个行业中扮演着越来越重要的角色,比如在智能家居、客户服务以及辅助残障人士等领域提供了颠覆性的应用价值。

## 1.1 语音识别技术的起源与发展

语音识别技术的历史可以追溯到20世纪50年代,当时的科学家们开始探索计算机对人类语音的识别可能性。早期的研究集中在识别特定的单词或者短语,并且受限于当时的计算能力和语音处理技术,识别准确率相对较低。进入21世纪后,随着计算能力的飞速提升和大数据技术的发展,以及深度学习技术的兴起,语音识别技术的准确率得到了显著提升,使得该技术的应用范围迅速扩大。

## 1.2 语音识别的应用领域

语音识别技术的应用领域十分广泛,从最初的军事和科研领域逐渐渗透到日常生活中。在移动设备中,语音识别技术使得语音助手成为可能,用户可以通过语音命令进行搜索、设定提醒或控制其他智能设备。在医疗领域,语音识别可以帮助医生记录病人的病例信息,提高工作效率。在教育领域,语音识别技术可以辅助语言学习,提升学生的学习体验。此外,语音识别技术还在汽车、交通、通信、无障碍服务等多个领域展现出巨大的潜力。

# 2. 自然语言处理基础

## 2.1 自然语言处理的理论基础

### 2.1.1 语言学的组成要素

自然语言处理(Natural Language Processing, NLP)是计算机科学和语言学领域中一个交叉的研究领域。其核心目标是使计算机能够理解、解释和生成人类语言。要深入理解NLP,我们首先需要了解语言学的几个基本组成要素:语音、语法、语义和语用。

- **语音(Phonetics)**:指的是语言的声音系统,它涉及人类发声器官产生的声音及其在语言中的功能。在NLP中,语音的分析和处理通常通过声学模型来进行,声学模型能够识别和区分发音。

- **语法(Grammar)**:描述了词语如何组合成句子的规则。在NLP中,语法的分析对于理解句子结构和意图至关重要,是词性标注和句法分析的基础。

- **语义(Semantics)**:涉及到词和句子的意义。NLP中语义理解是识别和提取文本中的概念、实体以及它们之间关系的过程。

- **语用(Pragmatics)**:研究在特定语境下语言的使用。NLP中的语用分析可以涉及对话行为、情感分析以及多模态分析等。

为了全面理解语言,NLP研究者和工程师不仅需要具备计算机科学的专业知识,还需对语言学有所了解,以便能够构建出能够处理自然语言中这些复杂现象的算法和系统。

### 2.1.2 语言模型与统计学

语言模型是NLP的核心部分,它能够计算一个词序列出现的概率。语言模型对于许多NLP应用至关重要,例如自动语音识别(ASR)、机器翻译(MT)和语音合成(TTS)。早期的语言模型是基于规则的,但现代语言模型大多是基于统计学原理构建的。

- **基于统计的语言模型**:通常用大量语料库来训练统计模型,如隐马尔可夫模型(HMM)和n-gram模型。这些模型通过计算历史信息来预测下一个词或符号出现的概率。

- **基于神经网络的语言模型**:近年来,随着深度学习的兴起,基于神经网络的语言模型,如循环神经网络(RNN)和变换器(Transformer)模型,因其强大的表示能力和优秀的性能而变得流行。

接下来,我们将深入探讨自然语言处理的核心技术,这些技术是建立在理论基础上的实现,并在实际应用中发挥着关键作用。

## 2.2 自然语言处理的核心技术

### 2.2.1 分词与词性标注

分词和词性标注是NLP中对文本进行基本处理的两个重要步骤。

- **分词(Tokenization)**:由于中文等语言没有空格来明确标记词与词之间的界限,因此分词是中文处理的第一步。分词的目的是将连续的文本字符串切分成有意义的词语单元。例如,在中文分词中,“今天天气不错”可能会被切分为“今天/天气/不错”。

```python

# 示例代码:使用jieba进行中文分词

import jieba

sentence = "今天天气不错"

words = jieba.cut(sentence)

print(list(words)) # 输出分词结果

```

- **词性标注(Part-of-Speech Tagging, POS Tagging)**:分词之后,对句子中的每个词语进行词性标注,即标记出每个词在句中的语法角色,如名词、动词、形容词等。准确的词性标注对于理解句子结构和语义至关重要。

```python

# 示例代码:使用NLTK进行英文词性标注

import nltk

from nltk.tokenize import word_tokenize

sentence = "Natural language processing combines computer science and linguistics."

words = word_tokenize(sentence)

nltk.download('averaged_perceptron_tagger')

pos_tags = nltk.pos_tag(words)

print(pos_tags) # 输出词性标注结果

```

### 2.2.2 句法分析与依存关系

句法分析是分析句子的结构,并且了解句子中词语之间的关系。它帮助我们构建起词语之间连接的“骨架”。

- **句法分析(Syntactic Analysis)**:涉及构建一棵表示词语之间关系的解析树或图,通常使用句法分析算法如CKY、Earley或者依存句法分析。句法分析对于理解句子结构、歧义消解和语义分析等NLP任务至关重要。

```mermaid

graph TD;

A[句子] --> B[主语]

A --> C[谓语]

A --> D[宾语]

C --> E[动词]

C --> F[助动词]

E --> G[是]

F --> H[很]

B --> I[计算机]

D --> J[专家]

```

- **依存关系(Dependency Relations)**:依存句法分析关注词语之间的依存关系,比如哪个词修饰哪个词,哪个词是动词的主语或宾语等。依存分析有助于捕捉长距离依赖关系,是很多现代NLP系统的核心部分。

### 2.2.3 语义理解与表示

语义理解是NLP领域中最具挑战性的任务之一。它要求计算机不仅能够“看到”文字,还要能够“理解”文字背后的含义。

- **语义理解**:语义理解关注的是如何从字面意义到深层含义进行解读。它涉及到识别命名实体、情感分析、指代消解以及抽象概念的理解等。

- **知识表示**:为了实现语义理解,需要对知识进行有效的表示,常用的知识表示方法包括本体(ontology)、知识图谱、语义网络和逻辑表示等。

```python

# 示例代码:使用Spacy进行命名实体识别(NER)

import spacy

nlp = spacy.load('en_core_web_sm')

sentence = "Apple is looking at buying U.K. startup for $1 billion"

doc = nlp(sentence)

for ent in doc.ents:

print(ent.text, ent.label_) # 输出实体及其类型

```

## 2.3 自然语言处理的应用实例

### 2.3.1 机器翻译技术

机器翻译是将一种自然语言文本自动翻译成另一种自然语言的过程。自从1950年代出现第一个机器翻译系统以来,这个领域经历了从基于规则到基于统计,再到当前基于神经网络的发展。

```mermaid

graph LR;

A[源语言文本] -->|翻译模型| B[目标语言文本]

```

### 2.3.2 文本摘要与信息检索

文本摘要旨在从文本中提取核心信息,生成简短的摘要,帮助用户快速获取信息。信息检索则是从大量数据中快速找到用户需要的信息。

```python

# 示例代码:使用Gensim的文本摘要功能

from gensim.summarization import summarize

document = """

Text summarization is the process of distilling the most important information from a source document

to produce an abridged version for a particular user or task.

summary = summarize(document, ratio=0.5)

print(summary) # 输出文本摘要

```

文本摘要和信息检索的实现通常涉及复杂的算法,比如基于TF-IDF权重的关键词提取、主题模型、聚类算法和神经网络模型。

通过本章节的介绍,我们了解了自然语言处理的理论基础,核心技术及其在实际应用中的实例。下一章节我们将继续探讨这些技术是如何与语音识别相结合,以实现更加自然和高效的交互方式。

# 3. 语音识别的系统架构

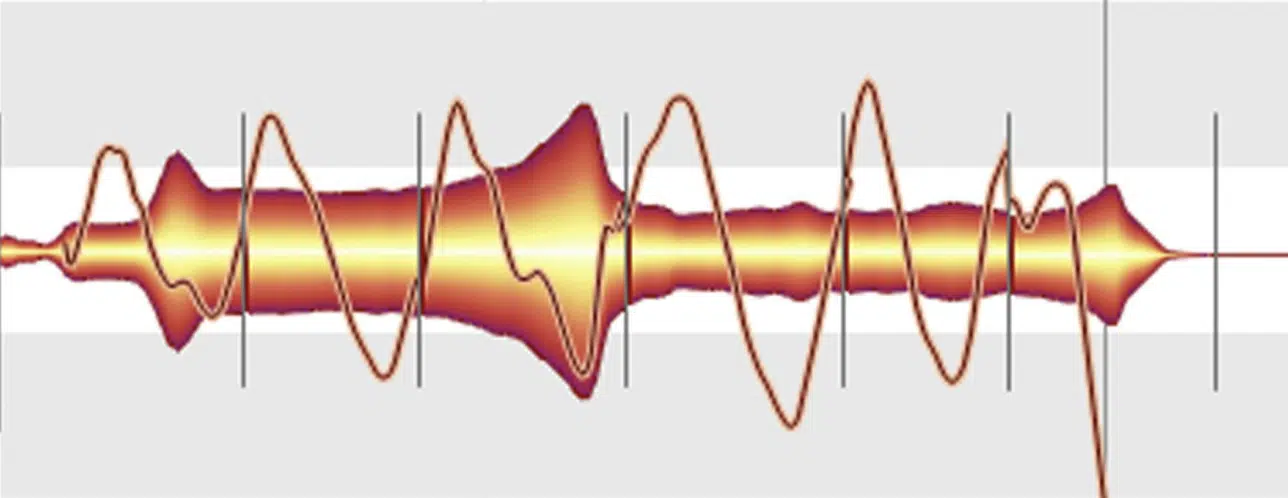

## 3.1 语音信号的预处理

在语音识别的系统架构中,预处理是一个关键步骤,它直接影响到后续语音识别的效果和准确性。语音信号预处理的目的在于改善信号质量,去除噪声,以便提取出更纯净的语音特征。预处理通常包括信号增强与去噪、特征提取等环节。

### 3.1.1 信号增强与去噪

在实际应用中,语音信号往往会被环境噪声所干扰,这会严重影响识别系统的性能。信号增强与去噪技术可以提升语音信号的清晰度,减少背景噪声的干扰。常见的方法有谱减法(Spectral Subtraction)、Wiener滤波和波束形成技术等。

谱减法是一种经典的声音增强技术,它基于噪声估计,从带噪语音信号中减去噪声的频谱估计,以此来恢复干净的语音信号。其核心思想是利用噪声和语音在时频空间中的差异性。

Wiener滤波则是一种线性滤波器,它能根据输入信号的统计特性来最小化估计误差的均方值。Wiener滤波器是根据噪声和语音信号的频谱特性进行设计,以期达到最佳的去噪效果。

波束形成技术通过在空间不同位置上设置麦克风阵列,利用信号传播时间差来增强特定方向的信号,同时抑制其他方向的噪声和干扰。

```python

# 代码展示:使用Python实现谱减法去噪

import numpy as np

import librosa

def spectral_subtraction(y, frame_length=1024, frame_stride=512, num_ho=4):

# 加载语音信号

audio, sr = librosa.load(y, sr=None)

# 假设噪声能量已经预先估计好了

# 这里简化处理,认为噪声能量为0

noise_energy = np.zeros_like(audio)

# 初始化去噪后的信号

y_denoise = np.zeros_like(audio)

# 对信号分帧处理

for i in range(num_ho, len(audio) - frame_length):

# 切片当前帧信号

frame = audio[i-num_ho:i+frame_length-num_ho]

frame FOURIER = np.fft.fft(frame, frame_length)

# 计算噪声能量

noise_energy[i-num_ho:i+frame_length-num_ho] = np.abs(frame FOURIER) ** 2 / frame_length

# 噪声估计

noise_estimate = np.mean(noise_energy, axis=0)

# 谱减法去噪

noise_estimate = np.sqrt(noise_estimate)

frame FOURIER = np.fft.fft(audio, frame_length)

frame FOURIER = np.maximum(np.abs(frame FOURIER) - noise_estimate, 0) * np.exp(1j * np.angle(frame FOURIER))

# 反变换

y_denoise = np.real(np.fft.ifft(frame FOURIER, fram

```

0

0