NLP项目管理圣经:高效规划与执行自然语言处理项目的终极秘籍

发布时间: 2024-11-21 14:59:49 阅读量: 24 订阅数: 44

自然语言处理与NLP项目.zip

# 1. NLP项目管理概览

在本章中,我们将概览自然语言处理(NLP)项目管理的关键概念,为接下来更深入的技术讨论和项目执行流程打下基础。自然语言处理是计算机科学和人工智能领域的一个分支,专注于让计算机理解人类语言。在管理一个NLP项目时,涉及到的任务不仅包括技术层面,还包含项目管理和团队协作。

## 1.1 项目管理的核心要素

NLP项目的核心要素包括理解项目范围、制定明确的目标和定义里程碑。这些要素有助于在项目初期确立项目的愿景和路线图。有效的项目管理应该涉及跨学科团队的协作,包括数据科学家、语言学家和软件开发人员。

## 1.2 沟通与协作的重要性

沟通是NLP项目成功的关键。项目管理者需要确保团队成员之间、以及与利益相关者之间的沟通畅通无阻。这通常意味着需要一个高效的协作平台和适当的流程,以促进信息的透明和共享。

## 1.3 项目管理的最佳实践

针对NLP项目,管理者应该采纳包括敏捷开发方法和持续集成/持续部署(CI/CD)在内的最佳实践。敏捷方法能够使项目更加灵活,并能够快速应对需求的变化。而CI/CD则保证了代码质量并缩短了从开发到部署的时间。

# 2. 理论基础与技术栈准备

## 2.1 自然语言处理基础概念

### 2.1.1 语言模型和预训练技术

语言模型是自然语言处理(NLP)中至关重要的基础。在构建模型时,理解语言的统计特性和结构是至关重要的。语言模型通过计算词语序列出现的概率,来预测下一个单词或短语。在自然语言处理任务中,比如机器翻译、语音识别、拼写检查等,语言模型都扮演了关键角色。

预训练技术则是通过在大规模语料库上预训练模型,再在特定任务上进行微调,这种方法在NLP领域尤其流行。例如,BERT(Bidirectional Encoder Representations from Transformers)模型就利用了预训练技术,在多项NLP任务上取得了卓越性能。预训练模型通过学习语言中的深层次语义关系,使得在特定任务上的微调变得更为有效。

```mermaid

graph LR

A[大规模语料库] -->|预训练| B[预训练模型]

B --> C[任务微调]

C --> D[特定NLP任务]

```

### 2.1.2 词法分析和句法分析

词法分析与句法分析是NLP中的另一项基础任务。词法分析涉及将句子分解为一系列词元(tokens),例如单词、标点符号等,同时也包括去除停用词、词干提取等操作。句法分析则更进一步,尝试理解句子中各个词元的句法结构,例如哪些词是动词、哪些是名词,词与词之间的依存关系。

例如,在依存句法分析(Dependency Parsing)中,需要识别句子中的每个词如何与其他词相互连接,形成一个树状结构,从而构建句子的句法结构。这项技术在构建语言理解和生成系统中是不可或缺的。

```mermaid

graph LR

A[句子] -->|词法分析| B[词元序列]

B -->|句法分析| C[依存树]

C --> D[句法结构表示]

```

## 2.2 关键技术栈和工具选择

### 2.2.1 深度学习框架对比

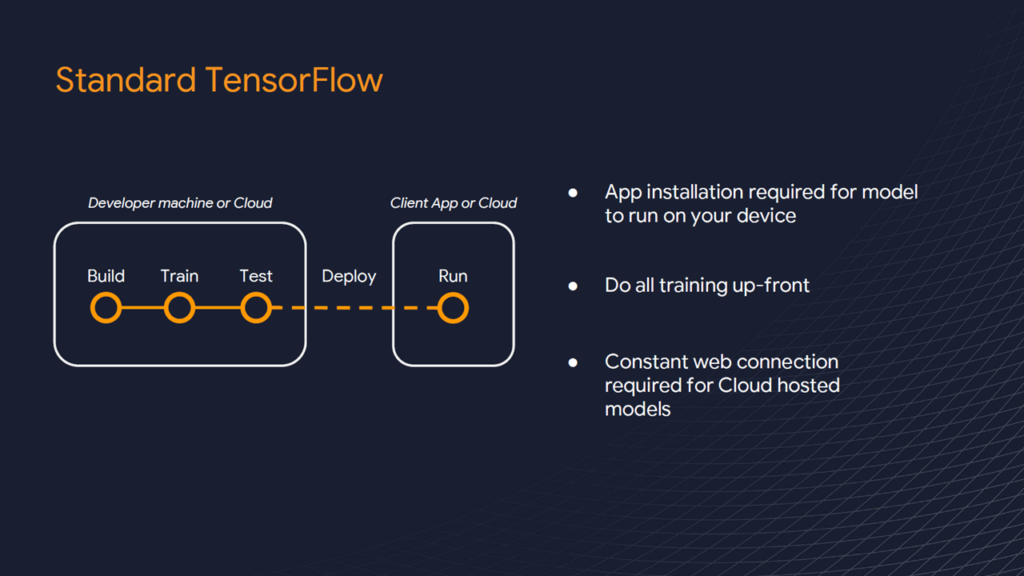

深度学习框架在NLP项目中是核心工具,许多研究和应用都依赖于它们。TensorFlow和PyTorch是当前两个最流行的选择,它们各自有其特点和优势。TensorFlow由Google开发,以其在生产环境中的稳定性著称,而PyTorch则因其动态计算图和灵活性而受到研究社区的青睐。

选择哪个框架取决于项目需求、团队经验和对框架的熟悉程度。在性能、易用性和生态系统支持等方面,两者都有广泛的社区和教程可供学习。通常,项目团队会对两者进行评估,然后选择最适合他们项目的框架。

```mermaid

graph TD

A[深度学习框架选择] --> B[TensorFlow]

A --> C[PyTorch]

B --> D[稳定性]

C --> E[灵活性]

```

### 2.2.2 数据处理和模型训练工具

处理大量数据和训练复杂的模型是NLP项目中的常规操作。在这方面,Hadoop和Spark等大数据处理工具提供了扩展性和灵活性,而工具如MLflow和TensorBoard则专注于实验跟踪和模型训练监控。

数据处理工具,如Pandas和Apache Beam,能够帮助数据科学家有效地进行数据清洗、探索性数据分析以及特征工程。模型训练工具,如Kubeflow或Paperspace Gradient,提供了云平台服务,使得大规模分布式训练变得简单。

### 2.2.3 自然语言处理库和APIs

NLP库和APIs为开发人员提供了大量便捷的工具和函数,使得开发复杂的NLP应用更加高效。NLTK(Natural Language Toolkit)和spaCy是两个非常受欢迎的库。NLTK以其丰富的语料库和教学材料著称,而spaCy则以其性能和易用性著称。API方面,Google的自然语言API和IBM Watson是商业API服务,它们提供了强大的NLP功能,如情感分析、实体识别等。

在选择NLP库和API时,要考虑到其支持的语言、功能丰富度以及是否开源等因素。开源库如spaCy支持多种语言模型,并不断更新维护,而商业API则可能提供更好的性能和更多的服务支持。

```markdown

| 库/服务 | 支持语言 | 功能丰富度 | 开源支持 |

|----------|----------|------------|----------|

| NLTK | 多种 | 丰富 | 是 |

| spaCy | 多种 | 高性能 | 是 |

| Google | 英语主导 | 高级 | 否 |

| IBM Watson | 多种 | 高级 | 否 |

```

## 2.3 数据集构建和预处理

### 2.3.1 数据集的选择和构建原则

数据集的选择是NLP项目成功的关键因素之一。高质量和代表性强的数据集能够帮助模型更好地理解语言的多样性和复杂性。在构建数据集时,需要遵循一定的原则:首先是数据多样性,确保覆盖不同的语言风格、领域以及用例;其次是数据量,充足的样本能够帮助模型更好地泛化;最后是数据质量,需要保证数据的准确性和一致性。

构建数据集时,可以利用公开数据集作为起点,然后针对具体任务进行扩充或清洗。工具如Label Studio可用于数据标注,而自定义数据集则可以使用Python脚本手动构建。

### 2.3.2 数据清洗和标注技巧

数据清洗是NLP项目中极为重要的一步,需要移除无关数据、纠正错误、处理缺失值等。数据清洗过程中可以使用如Pandas这样的工具进行有效操作。数据标注是另一种类型的数据清洗,特别是在需要人工干预的情况下。通过正确地标注数据,可以教会模型区分语义和上下文。

标注数据时,可以采用BIO标注体系(B- Beginning, I-Inside, O-Out)来标注实体和关系,或者使用更复杂的体系,如SpaCy的命名实体识别(NER)模型。标注工具如BRAT(Brat Rapid Annotation Tool)或Doccano可以帮助开发人员以高效的方式进行文本标注。

```python

import pandas as pd

# 示例代码:使用Pandas进行数据清洗

data = pd.read_cs

```

0

0