文本数据处理指南:机器学习模型优化必知

探索序列到序列模型:机器学习中的Seq2Seq机制与应用

1. 文本数据处理基础与重要性

1.1 文本数据的定义和特征

文本数据是由字符序列构成的数据类型,它是计算机处理和分析的主要对象之一。文本数据广泛存在于社交媒体、新闻报道、书籍、研究报告等各种形式的文献中。与数值型数据不同,文本数据的非结构化特征使得直接用于分析和挖掘存在一定的困难,这就需要进行文本数据处理。

1.2 文本数据处理的意义

文本数据处理的目的在于将非结构化的文本信息转换为可用于数据分析和机器学习的结构化数据。在这个过程中,可以提取有价值的信息和知识,例如,情感倾向、主题内容、实体信息等。有效的文本数据处理不仅能够帮助我们理解文本数据的深层含义,还能够在各种实际场景中如社交媒体监控、市场趋势分析、智能搜索和推荐系统等方面提供有力的支持。

1.3 文本数据处理的基本步骤

文本数据处理通常包括以下基本步骤:

- 文本预处理:包括去除噪声数据、文本规范化、分词等步骤。

- 向量化过程:将文本转换为数值型数据,常见方法包括词袋模型(Bag of Words)和TF-IDF权重计算。

- 高级文本分析:通过主题建模、情感分析和实体识别等方法深入理解文本内容。

- 特征提取与选择:从文本数据中提取有效特征,并通过各种方法选择最有代表性的特征。

- 数据集准备与优化:准备训练数据集、验证集和测试集,进行数据增强和模型评估。

在接下来的章节中,我们将详细探讨这些步骤,并提供实践中的技巧和优化方法。

2. 文本预处理技术

文本预处理是任何文本分析流程的第一步,对于提高模型性能至关重要。本章节详细探讨了文本预处理的几个关键技术:清洗与规范化、分词技术以及向量化过程,为后续分析打下坚实的基础。

2.1 清洗与规范化

2.1.1 去除噪声数据

在收集到文本数据之后,第一步是要去除那些可能干扰分析的噪声。噪声数据可以包括无关的标点、数字、特殊符号,或者不规则的空格。去除这些噪声,可以提升后续步骤的准确性。

- import re

- # 示例代码用于清除文本数据中的噪声

- def clean_text(text):

- # 使用正则表达式去除数字

- text = re.sub(r'\d+', '', text)

- # 去除标点和特殊符号

- text = re.sub(r'[^\w\s]', '', text)

- # 去除多余的空格

- text = re.sub(r'\s+', ' ', text).strip()

- return text

- # 示例文本

- dirty_text = " This is# an example! of @text with $noise... 123 "

- cleaned_text = clean_text(dirty_text)

- print(cleaned_text)

2.1.2 文本规范化方法

文本规范化包含诸如转换为统一大小写、词形还原(lemmatization)、词干提取(stemming)等步骤,以确保模型处理的是一致性和规范化的词汇形式。

- from nltk.stem import WordNetLemmatizer

- from nltk.stem import PorterStemmer

- # 示例代码展示词形还原和词干提取

- lemmatizer = WordNetLemmatizer()

- stemmer = PorterStemmer()

- # 词形还原和词干提取示例

- words = ['running', 'ran', 'runner']

- lemmatized_words = [lemmatizer.lemmatize(word) for word in words]

- stemmed_words = [stemmer.stem(word) for word in words]

- print("Lemmatized Words: ", lemmatized_words)

- print("Stemmed Words: ", stemmed_words)

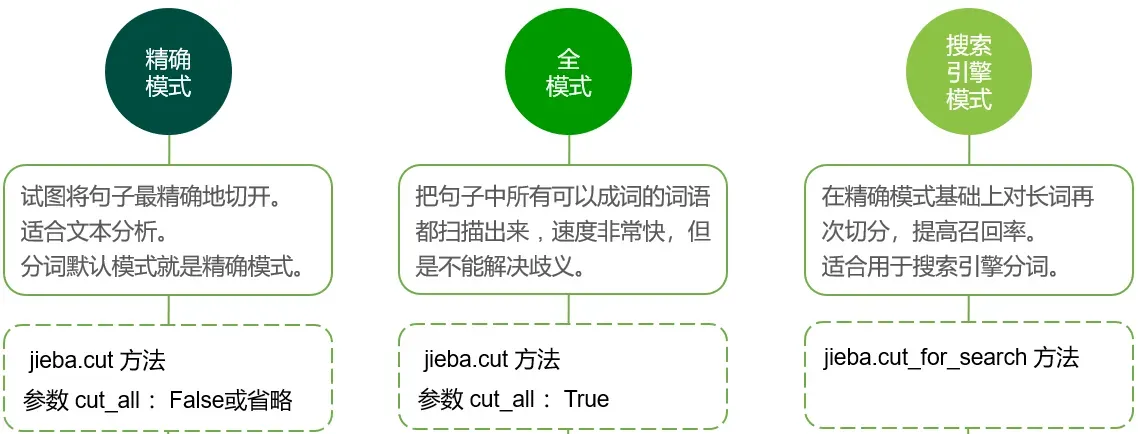

2.2 分词技术

2.2.1 分词基础

分词是将文本拆分成有意义的单位(如单词、短语或句子)。不同语言的分词方法大相径庭,特别是中文,因为中文书写没有空格分隔。

2.2.2 语言依赖性与分词工具

不同的语言对分词的要求不同。英语等分隔性语言相对容易,而中文、日文等则需要复杂的分词算法。

- import jieba

- # 中文分词示例

- text = "我爱北京天安门。"

- seg_list = jieba.lcut(text)

- print(seg_list)

2.3 向量化过程

2.3.1 词袋模型

词袋模型(Bag of Words, BoW)是文本向量化中最简单的方法之一,它忽略文本中单词的顺序和语法,将文本转换为单词出现频率的向量。

- from sklearn.feature_extraction.text import CountVectorizer

- # 词袋模型示例

- corpus = [

- 'This is the first document.',

- 'This document is the second document.',

- 'And this is the third one.',

- 'Is this the first document?',

- ]

- vectorizer = CountVectorizer()

- X = vectorizer.fit_transform(corpus)

- print(vectorizer.get_feature_names_out())

2.3.2 TF-IDF权重计算

TF-IDF(Term Frequency-Inverse Document Frequency)通过降低常见词汇的权重并提升重要词汇的权重,进一步优化向量表示。

- from sklearn.feature_extraction.text import TfidfVectorizer

- # TF-IDF权重计算示例

- vectorizer = TfidfVectorizer()

- X = vectorizer.fit_transform(corpus)

- print(vectorizer.get_feature_names_out())

通过文本预处理技术,我们可以将非结构化的文本数据转换为可被机器学习模型处理的结构化数据。以上展示了如何清洗文本数据,执行分词操作,并进行向量化处理。在下一章中,我们将继续深入探讨高级文本分析方法。

3. 高级文本分析方法

3.1 主题建模

3.1.1 LDA模型简介

主题建模是一种无监督的学习方法,用于从文档集合中发现潜在的主题信息。它假设文档由主题构成,而这些主题则由词项构成。拉普拉斯分布算法(Latent Dirichlet Allocation,LDA)是最常用的主题建模技术之一。LDA是一个概率模型,假设每个文档中的词是通过从主题中随机抽取,每个主题是通过从词的分布中随机抽取形成的。LDA试图为每个文档提供一组主题的分布,同时为每个主题提供一组词的分布。

3.1.2 实现主题建模的步骤

实现LDA模型通常包含以下步骤:

- 数据准备:需要有一组文档集合,每个文档都应预处理为词袋形式(即将文本转化为词的集合)。

- 选择主题数:确定模型中潜在主题的数量(通常使用如自动词汇索引(Automatic Topic Indexing)等方法帮助选择)。

- 模型训练:使用LDA算法对文档进行建模,得到文档-主题和主题-词的分布。

- 评估和优化:评估模型的性能,并调整参数以优化结果。

- 结果解释:将得到的主题分布转换为可读形式,对每个主题下的高概率词进行解读。

以下是一个使用Python的gensim库实现LDA模型的简单代码示例:

- import gensim

- from gensim import corpora

- from nltk.tokenize import RegexpTokenizer

- from nltk.corpus import stopwords

- from nltk.stem.porter import PorterStemmer

- # 初始化分词器、停用词和词干提取器

- tokenizer = RegexpTokenizer(r'\w+')

- en_stop = set(stopwords.words('english'))

- p_stemmer = PorterStemmer()

- # 准备文本数据

- texts = [['human', 'interface', 'computer'],

- ['user', 'computer', 'system', 'response', 'time'],

- ['user', 'interface', 'system', 'response', 'trees']]

- # 词干处理和停用词过滤

- processed_texts = []

- for i in range(len(texts)):

- text = texts[i]

- text = [p_stemmer.stem(word) for word in text if word not in en_stop and len(word) > 3]

- processed_texts.append(text)

- # 创建词典和语料库

- dictionary = corpora.Dictionary(processed_texts)

- corpus = [dictionary.doc2bow(text) for text in processed_texts]

- # 使用LDA模型

- ldamodel = gensim.models.ldamodel.LdaModel(corpus, num_topics=2, id2word = dictionary, passe