【多分类评估新策略】:扩展ROC曲线在复杂场景的应用

发布时间: 2024-11-21 08:35:28 阅读量: 26 订阅数: 39

mlinsights:通过新模型,变形器,度量标准,绘图扩展了scikit学习

# 1. 多分类评估新策略概述

在机器学习和数据科学领域,分类问题一直是一个重要的研究方向,尤其在多分类场景中,评估模型性能变得更为复杂。传统的评估指标如准确率、精确度等,难以全面反映模型在多分类问题上的真实能力。因此,多分类评估新策略的出现,旨在提供更为全面和精确的模型性能评估。

新策略的核心在于利用更高级的评价指标,例如混淆矩阵、精确率-召回率曲线(PR曲线)、以及重点强调的接收者操作特征曲线(ROC曲线)等。其中,ROC曲线和其下的面积(AUC)已经成为业界公认的评估标准,尤其适用于处理具有两个以上分类结果的问题。本章将为读者详细解读这一策略,并探讨其在多分类问题中的应用场景。

# 2. ROC曲线的基础理论

## 2.1 分类问题的基本概念

### 2.1.1 分类评估的指标简介

在机器学习中,分类问题一直占据着举足轻重的地位。正确评估分类器的性能是模型训练和参数调整过程中的关键步骤。评估指标不仅帮助我们了解模型的优劣,而且指导我们改进模型。常见的评估指标包括精确率(Precision)、召回率(Recall)、F1分数(F1-Score)和ROC曲线。

精确率衡量了模型预测为正样本中实际为正样本的比例,而召回率则衡量了实际为正样本中模型预测为正样本的比例。F1分数是精确率和召回率的调和平均数,是这两个指标的综合表现。相比单一指标,F1分数能更好地处理不均衡数据集中的类别分布问题。

```python

from sklearn.metrics import precision_score, recall_score, f1_score

# 假设y_true是真实标签,y_pred是模型预测的标签

y_true = [1, 1, 0, 0, 1]

y_pred = [1, 0, 0, 1, 1]

# 计算精确率、召回率和F1分数

precision = precision_score(y_true, y_pred)

recall = recall_score(y_true, y_pred)

f1 = f1_score(y_true, y_pred)

# 输出结果

print(f'Precision: {precision}')

print(f'Recall: {recall}')

print(f'F1 Score: {f1}')

```

在上述代码示例中,我们使用了sklearn库来计算精确率、召回率和F1分数。需要注意的是,这些指标都需要在模型训练完成后,通过模型的预测结果与真实标签进行计算得出。

### 2.1.2 二分类问题中的ROC曲线

ROC(接收者操作特征)曲线是评估二分类模型性能的有力工具。它通过绘制不同分类阈值下的真正例率(True Positive Rate, TPR)和假正例率(False Positive Rate, FPR)来展示模型的分类能力。ROC曲线下的面积(Area Under Curve, AUC)则可以作为模型性能的总体指标。

ROC曲线越接近左上角,表示模型性能越好,因为这意味着模型能够在较低的FPR下达到较高的TPR。理想情况下,模型的ROC曲线应该是一条从原点到左上角再到右上角的折线,但实际上,大多数模型的ROC曲线都是平滑的曲线。

```python

from sklearn.metrics import roc_curve, auc

import matplotlib.pyplot as plt

# 假设y_true是真实标签,y_scores是模型给出的分类概率得分

y_true = [1, 1, 0, 0, 1]

y_scores = [0.9, 0.8, 0.3, 0.4, 0.85]

# 计算FPR和TPR

fpr, tpr, thresholds = roc_curve(y_true, y_scores)

# 计算AUC

roc_auc = auc(fpr, tpr)

# 绘制ROC曲线

plt.figure()

plt.plot(fpr, tpr, color='darkorange', lw=2, label=f'AUC = {roc_auc:.2f}')

plt.plot([0, 1], [0, 1], color='navy', lw=2, linestyle='--')

plt.xlim([0.0, 1.0])

plt.ylim([0.0, 1.05])

plt.xlabel('False Positive Rate')

plt.ylabel('True Positive Rate')

plt.title('Receiver Operating Characteristic')

plt.legend(loc="lower right")

plt.show()

```

在上述代码中,我们首先使用`roc_curve`函数计算了FPR和TPR,然后使用`auc`函数计算了AUC值。接着,我们用matplotlib库绘制了ROC曲线,并将AUC值标示在图例中。ROC曲线和AUC值为我们提供了对模型性能的直观理解。

## 2.2 ROC曲线的工作原理

### 2.2.1 曲线绘制方法

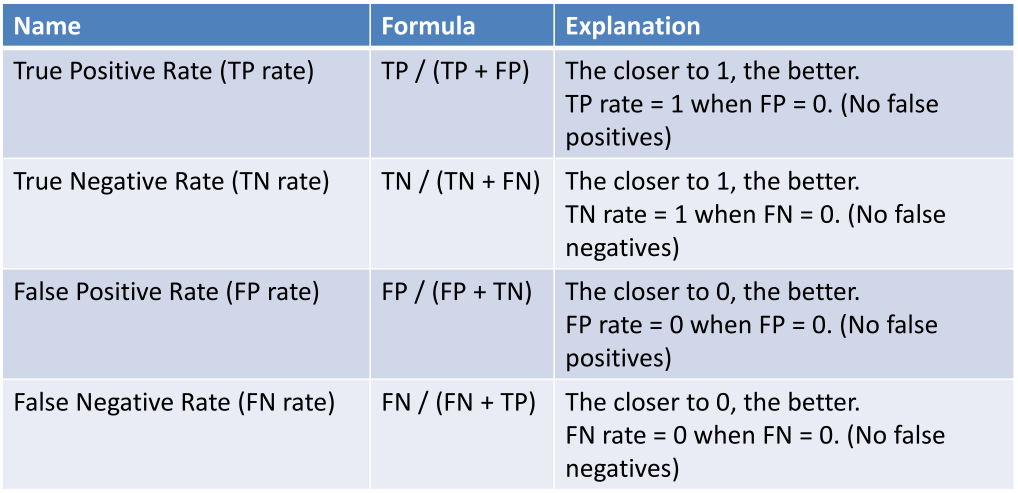

ROC曲线的绘制方法基于不同决策阈值对分类结果的影响。对于一个二分类问题,我们可以变动决策阈值,从0到1,计算每个阈值下的TPR和FPR。TPR(真正例率)是TP/(TP+FN),其中TP是真阳性数,FN是假阴性数;FPR(假正例率)是FP/(FP+TN),其中FP是假阳性数,TN是真阴性数。

绘制ROC曲线时,横坐标代表FPR,纵坐标代表TPR。每个点对应一个特定的阈值,从而形成一条平滑的曲线。理想模型的ROC曲线会紧贴左上角,实际模型通常表现为曲线稍微向右下方弯曲。

```mermaid

graph TD;

A[开始] --> B[收集数据]

B --> C[计算TPR和FPR]

C --> D[改变决策阈值]

D --> E[绘制ROC曲线]

E --> F[分析模型性能]

```

这个流程图描述了ROC曲线绘制的基本步骤。从开始收集数据开始,通过计算不同阈值下的TPR和FPR,改变决策阈值来探索模型的不同性能,最终绘制ROC曲线,并据此分析模型的分类性能。

### 2.2.2 曲线下面积(AUC)的意义

AUC,即ROC曲线下面积,是一个重要的量化指标。它衡量了分类器在所有可能的正负样本分布中,随机选取一个正样本和一个负样本,分类器将正样本排在负样本前面的概率。AUC值的范围从0到1,一个完全随机的模型的AUC值为0.5,而一个完美的模型的AUC值为1。

AUC值越高,表明模型区分正负样本的能力越强。通常,AUC值高于0.7被视为有较好的分类性能。AUC值提供了一个不依赖于单一阈值的评价标准,因此它在比较不同模型时非常有用。

## 2.3 ROC曲线的局限性分析

### 2.3.1 多分类问题的挑战

虽然ROC曲线在二分类问题中的应用相当成熟,但在多分类问题中,它面临挑战。多分类问题有不止两个类别,每个类别之间可能存在不平衡,而ROC曲线无法直接展示出这种不平衡性。此外,对于多个类别,需要为每个类别都绘制一个ROC曲线,这样会使得问题变得复杂,难以直观展示所有类别的性能。

为解决这个问题,研究人员提出了多种方法来扩展ROC曲线到多分类场景,例如一对一(One-vs-One, OvO)和一对多(One-vs-All, OvA)方法。这些方法将多分类问题转化为多个二分类问题来处理,然后综合这些二分类问题的ROC曲线结果。

### 2.3.2 常规ROC的扩展难题

在扩展ROC曲线到多分类问题时,我们面临的一个难题是如何综合多个ROC曲线。一个直观的想法是为每个类别绘制一个ROC曲线,然后取这些曲线的平均值。但是,这样的平均可能会导致信息的丢失,尤其是当类别不平衡时,少数类别的信息可能被忽视。

另一个难题是如何考虑类别之间的关系。在多分类问题中,类别之间可能不是完全互斥的。例如,在情感分析中,文本可能同时包含“悲伤”和“愤怒”两种情感。这种类别间的重叠关系在ROC曲线下难以被合理地表达和评估。

为了克服这些难题,研究人员提出了不同的方法和策略,比如计算宏平均和微平均ROC曲线,或者采用多标签学习方法来处理类别之间的关系。这些方法尽管在一定程度上解决了问题,但都具有一定的局限性,需要根据实际应用场景进行权衡选择。

# 3. 复杂场景中的ROC曲线扩展方法

在机器学习和数据科学中,模型评估是一个至关重要的环节。传统的ROC曲线,尽管在二分类问题中广为应用,但在处理多分类问题时却遇到了诸多挑战。本章节将深入探讨在复杂场景中如何扩展ROC曲线的应用,并介绍相关的处理策略和优化算法。

## 3.1 多分类问题的ROC曲线处理策略

在多分类问题中,我们面临着分类器需要区分多个类别的情况。在这种场景下,ROC曲线的扩展变得尤为重要。多分类问题的ROC曲线处理策略主要分为一对一(OvO)和一对多(OvM)方法,这两种方法从不同的角度扩展了传统的ROC曲线。

### 3.1.1 一对一(OvO)和一对多(OvM)方

0

0