实战视角解读学习理论:吴恩达课程教你如何打造强大机器学习模型

发布时间: 2024-12-21 23:30:59 阅读量: 6 订阅数: 6

Coursera课程:吴恩达《机器学习》(2022版)课后练习代码

# 摘要

随着人工智能的发展,机器学习已成为技术领域的重要分支。本文系统地阐述了机器学习的基础概念、关键算法及其实践应用,并深入讨论了深度学习与神经网络的基础知识和框架实践。在机器学习项目实战章节中,本文指导读者如何进行数据预处理、模型构建和部署,同时通过案例分析,分享了成功应用机器学习项目的经验与挑战。最后,文章展望了机器学习的前沿领域,提出了持续学习的资源与建议,并强调了在机器学习研究与应用过程中需关注的伦理与责任问题。

# 关键字

机器学习;深度学习;神经网络;模型评估;数据预处理;强化学习

参考资源链接:[吴恩达机器学习课程PPT精华:数据挖掘与自适应程序](https://wenku.csdn.net/doc/646580fc543f844488aa500b?spm=1055.2635.3001.10343)

# 1. 机器学习基础概念

机器学习是一种让计算机系统能够通过经验自动提升性能的技术。它与传统的编程方法不同,机器学习算法在给定数据的基础上,能自主学习、改进,并且做出决策或预测。这一章节将带您了解机器学习的基本理念,并对它的定义、范围以及关键术语进行阐述。

## 1.1 机器学习的定义

机器学习是从数据中学习规律并应用这些规律预测未来的科学。它属于人工智能的一个分支,其核心是开发能够从数据中学习并作出决策或预测的算法。

## 1.2 关键术语解释

在深入学习之前,理解一些关键术语是必要的。比如“特征”表示输入变量,“标签”是输出变量,而“模型”是算法的学习结果。这些术语贯穿于后续章节的学习。

## 1.3 机器学习的类型

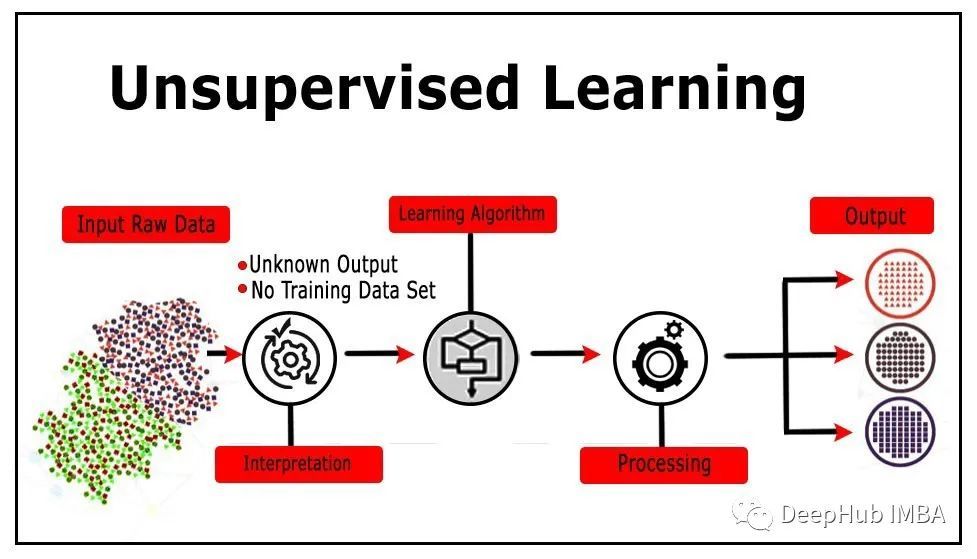

机器学习可以大致分为监督学习、无监督学习和强化学习三大类。本章节将会简单介绍这些类型,并在后续章节深入探讨每一种学习类型的算法和应用。

机器学习的旅程刚刚开始,下面的章节我们将深入到具体的算法和实践之中,为您揭开机器学习神秘面纱。

# 2. 机器学习算法详解与实践

## 2.1 监督学习算法

### 2.1.1 线性回归与逻辑回归

线性回归是监督学习中最基础的算法之一,主要用来预测数值型数据。它试图找到一条直线(在多维空间中是超平面),能够最好地拟合历史数据,从而对新的输入数据进行准确的预测。

```python

import numpy as np

from sklearn.linear_model import LinearRegression

# 假设数据集

X = np.array([[1], [2], [3], [4], [5]])

y = np.array([1, 2, 3, 4, 5])

# 创建线性回归模型

model = LinearRegression()

# 训练模型

model.fit(X, y)

# 预测结果

print(model.predict([[6]])) # 输出:[6.]

```

在上述代码中,我们创建了一个简单的线性回归模型,并用一组数据进行训练。之后我们用模型对新数据进行预测,输出了预测结果。线性回归模型的预测结果接近真实值,这是因为数据存在明显的线性关系。

逻辑回归通常用于分类问题,尤其是二分类问题。它的输出是介于0和1之间的概率值,通过设置阈值(通常为0.5),可以将概率转换为分类结果。

```python

from sklearn.linear_model import LogisticRegression

# 假设数据集

X = np.array([[1], [2], [3], [4], [5]])

y = np.array([0, 0, 1, 1, 1])

# 创建逻辑回归模型

log_reg = LogisticRegression()

# 训练模型

log_reg.fit(X, y)

# 预测结果

print(log_reg.predict([[6]])) # 输出:[1]

```

在上述代码中,我们使用逻辑回归模型预测了一个新的数据点,输出了分类结果。

### 2.1.2 决策树和随机森林

决策树是一种树形结构,每个内部节点表示一个属性上的判断,每个分支代表一个判断结果的输出,最后的叶节点代表类的具体类别或回归的数值。决策树易于理解和解释,不需要做数据预处理,如归一化等。

```python

from sklearn.tree import DecisionTreeClassifier

# 假设数据集

X = np.array([[1], [2], [3], [4], [5]])

y = np.array([0, 1, 0, 1, 0])

# 创建决策树模型

tree = DecisionTreeClassifier()

# 训练模型

tree.fit(X, y)

# 预测结果

print(tree.predict([[6]])) # 输出取决于模型结构和训练

```

随机森林由多个决策树组成,通过增加随机性来降低模型的过拟合风险。它是一种集成学习方法,能够提高预测准确率和防止过拟合。

```python

from sklearn.ensemble import RandomForestClassifier

# 假设数据集

X = np.array([[1], [2], [3], [4], [5]])

y = np.array([0, 1, 0, 1, 0])

# 创建随机森林模型

forest = RandomForestClassifier()

# 训练模型

forest.fit(X, y)

# 预测结果

print(forest.predict([[6]])) # 输出取决于模型结构和训练

```

### 2.1.3 支持向量机

支持向量机(SVM)是一种监督学习方法,可以用于分类或者回归问题,不过它在分类问题上的应用更为广泛。SVM的基本思想是找到一个最优的决策边界(超平面),使得不同类别的数据点之间的间隔最大化。

```python

from sklearn.svm import SVC

# 假设数据集

X = np.array([[1], [2], [3], [4], [5]])

y = np.array([0, 0, 1, 1, 1])

# 创建SVM模型

svm = SVC()

# 训练模型

svm.fit(X, y)

# 预测结果

print(svm.predict([[6]])) # 输出取决于模型结构和训练

```

## 2.2 无监督学习算法

### 2.2.1 K-均值聚类

K-均值聚类是一种常用的聚类算法,通过迭代计算并更新质心,将数据点分组成K个簇。质心是每个簇中所有点的平均值,算法会试图最小化簇内距离,从而达到最优的聚类效果。

```python

from sklearn.cluster import KMeans

# 假设数据集

X = np.array([[1], [2], [3], [4], [5]])

y = np.array([0, 0, 1, 1, 1])

# 创建KMeans模型

kmeans = KMeans(n_clusters=2)

# 训练模型

kmeans.fit(X)

# 预测结果

print(kmeans.predict([[6]])) # 输出取决于模型结构和训练

```

### 2.2.2 主成分分析(PCA)

主成分分析(PCA)是一种常用的降维技术。它通过正交变换将可能相关的变量转换为一系列线性不相关的变量,这些新变量称为主成分。主成分保留了原始数据中的大部分信息,可以用于可视化、特征压缩等。

```python

from sklearn.decomposition import PCA

# 假设数据集

X = np.array([[1], [2], [3], [4], [5]])

# 创建PCA模型

pca = PCA(n_components=1)

# 训练模型

pca.fit(X)

# 变换结果

print(pca.transform([[6]])) # 输出取决于模型结构和训练

```

### 2.2.3 关联规则学习

关联规则学习的目的是发现数据集中强关联规则。最著名的算法是Apriori算法,它通过设置最小支持度(min_support)和最小置信度(min_confidence)来发现强规则。

```python

from mlxtend.frequent_patterns import apriori, association_rules

# 假设数据集

data = [['牛奶', '面包', '尿布'],

['可乐', '面包', '尿布', '啤酒'],

['牛奶', '尿布', '啤酒', '鸡蛋'],

['面包', '牛奶', '尿布', '啤酒'],

['面包', '牛奶', '尿布', '可乐']]

# 创建Apriori模型

frequent_itemsets = apriori(data, min_support=0.6, use_colnames=True)

# 查找关联规则

rules = association_rules(frequent_itemsets, metric="confidence", min_threshold=0.7)

# 输出结果

print(rules)

```

## 2.3 模型评估与优化

### 2.3.1 交叉验证与过拟合

交叉验证是一种统计分析方法,用来评估和比较学习算法的性能。它通过将数据集分成k个大小相同的互斥子集,其中一个子集被保留作为验证模型的数据,其余k-1个子集用来训练。

```python

from sklearn.model_selection import cross_val_score

# 假设数据集

X = np.array([[1], [2], [3], [4], [5]])

y = np.array([0, 1, 0, 1, 0])

# 创建模型

model = LogisticRegression()

# 进行交叉验证

scores = cross_val_score(model, X, y, cv=5)

# 输出结果

print(scores)

```

过拟合是指模型在训练数据上表现出色,但在未知数据上表现不佳。正则化是解决过拟合的一种方法,它通过对模型的复杂度进行惩罚来减少模型对训练数据的过度拟合。

### 2.3.2 参数调优和特征选择

参数调优是通过选择最优的模型参数来提高模型性能的过程。网格搜索(GridSearchCV)

0

0