机器人视觉系统设计大揭秘:MATLAB案例研究精讲

发布时间: 2025-01-02 21:21:09 阅读量: 18 订阅数: 14

《机器人控制系统的设计与Matlab仿真 》仿真程序

# 摘要

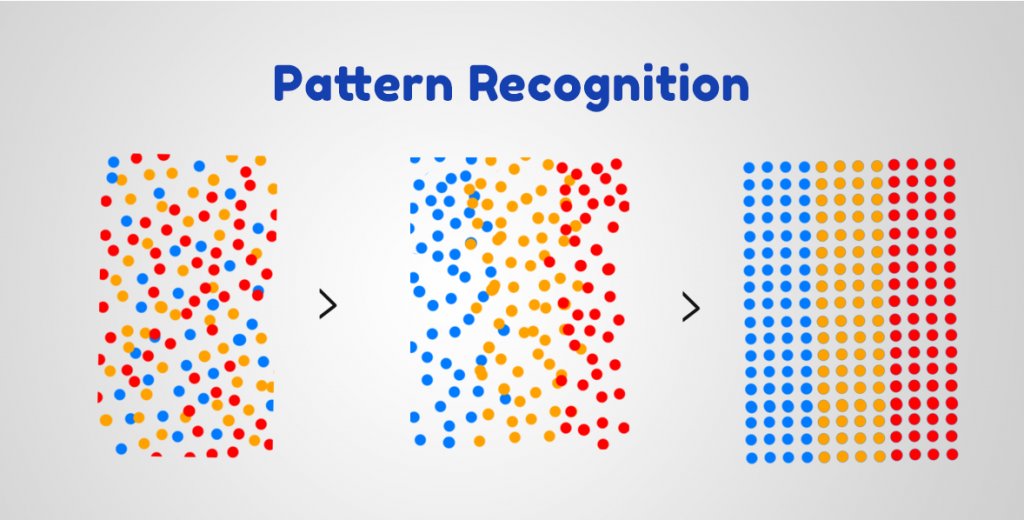

机器人视觉系统是现代机器人技术中的核心组成部分,它通过图像处理和分析来实现对环境的理解和交互。本文首先介绍了机器人视觉系统的原理与组成,然后重点讲解了使用MATLAB进行图像处理的基础知识和应用。接着,文章深入探讨了视觉系统数据采集和预处理技术,包括相机选择、视频流捕获及图像处理的相关技术和方法。此外,本文详细分析了机器人视觉系统中的识别与跟踪技术,涉及模式识别的应用、运动目标检测与跟踪算法以及3D视觉技术。最后,通过案例研究,展示了MATLAB在实际机器人视觉系统设计中的具体应用,并对未来技术的发展趋势进行了展望。

# 关键字

机器人视觉;MATLAB图像处理;数据采集;图像预处理;模式识别;运动目标跟踪;3D视觉技术

参考资源链接:[PSIM用户指南:数据输出与FFT到Excel的导入教程](https://wenku.csdn.net/doc/5bmwopuf37?spm=1055.2635.3001.10343)

# 1. 机器人视觉系统的原理与组成

## 1.1 机器人视觉系统概述

机器人视觉系统是赋予机器人“看”的能力的核心技术,它通过模仿人类视觉的方式来理解和解释周围环境。这种系统通常由硬件和软件两部分组成,硬件部分包括光源、相机和其他传感器,而软件部分则是高级图像处理、模式识别和决策算法的集合体。

## 1.2 视觉系统的关键组件

在机器人视觉系统中,关键组件包括相机、镜头、光源以及图像采集卡等硬件设备。其中相机负责捕获图像数据,镜头调整焦距和视角,光源提供必要的照明以增强图像质量,图像采集卡则负责将相机捕获的模拟信号转换为数字信号供处理。此外,软件算法负责处理这些数字信号,以识别、分类和跟踪目标物体。

## 1.3 系统的工作原理

机器视觉系统的工作原理可以被概括为三个主要步骤:数据采集、图像处理和图像分析。首先,相机捕获的图像数据通过图像采集卡送入计算机。然后,图像处理算法对数据进行预处理,如图像校正、增强和去噪。最后,图像分析算法通过特征提取和识别技术,进行目标检测、识别和跟踪。

通过这样的流程,机器人视觉系统可以实现对周围环境的感知和理解,为机器人的决策和行动提供依据。在后续章节中,我们将详细探讨如何使用MATLAB工具对机器人视觉系统进行图像处理和分析。

# 2. MATLAB基础与图像处理入门

随着机器视觉领域的发展,MATLAB作为一种广泛使用的数值计算和编程环境,已成为工程师和研究人员在进行图像处理任务时不可或缺的工具。在这一章中,我们将详细介绍MATLAB的基础知识以及如何使用MATLAB进行图像处理的入门级方法。

### 2.1 MATLAB的环境和基本操作

#### 2.1.1 MATLAB的安装与配置

MATLAB的安装过程相对简单。首先,下载对应操作系统的安装包,然后按照安装向导的指引进行操作。安装完成后,用户需要进行基本的配置工作,例如设置工作路径,配置环境变量以及安装必要的工具箱。以下是一个示例代码,展示如何检查MATLAB的安装状态和配置环境变量:

```matlab

% 检查MATLAB是否安装成功

if exist('ver', 'file')

disp('MATLAB 已安装并配置成功。');

else

disp('请安装MATLAB或检查安装路径。');

end

% 添加MATLAB的执行路径,确保系统可以找到MATLAB的可执行文件

addpath('C:\Program Files\MATLAB\R2021a\bin');

```

对于环境变量的配置,用户通常需要在操作系统的环境变量设置中添加MATLAB的路径,确保系统能够识别并运行MATLAB命令。

#### 2.1.2 MATLAB命令窗口和脚本编写

MATLAB的命令窗口是用户输入指令和查看输出结果的主要界面。通过简单的命令,用户可以执行计算、调用函数、运行脚本等。编写脚本是自动化重复任务的一个重要手段,MATLAB脚本文件通常以“.m”为扩展名。

编写脚本的基本步骤如下:

1. 打开MATLAB的编辑器。

2. 输入MATLAB命令和注释。

3. 保存为“filename.m”文件。

4. 在命令窗口中输入“filename”并按回车执行。

```matlab

% 示例:一个简单的MATLAB脚本,用于计算并显示1到10的平方

for i = 1:10

square = i^2;

fprintf('The square of %d is %d.\n', i, square);

end

```

### 2.2 MATLAB中的图像处理基础

#### 2.2.1 图像的导入与显示

图像处理的第一步是将图像导入到MATLAB环境中。MATLAB提供了多种函数来处理不同格式的图像文件,例如`imread`用于读取图像,`imshow`用于显示图像。

```matlab

% 读取并显示图像的代码示例

img = imread('example.jpg');

imshow(img);

```

#### 2.2.2 图像的类型与数据结构

在MATLAB中,图像可以是灰度图、二值图、RGB图等不同类型的图像。每种图像类型对应不同的数据结构,如矩阵、三维数组等。

```matlab

% 判断图像类型并显示其数据结构

if size(img, 3) == 1

fprintf('这是一张灰度图像。\n');

elseif size(img, 3) == 3

fprintf('这是一张RGB图像。\n');

end

```

#### 2.2.3 基本图像操作和函数

MATLAB提供了许多图像处理的基础函数,如`imcrop`用于裁剪图像,`imresize`用于调整图像大小等。

```matlab

% 裁剪图像并调整大小的示例代码

img_cropped = imcrop(img, [x y width height]); % [x, y] 为裁剪区域左上角坐标,width和height为裁剪区域的宽度和高度

img_resized = imresize(img_cropped, 0.5); % 将裁剪后的图像缩小到原来的一半大小

imshow(img_resized);

```

### 2.3 MATLAB图像处理工具箱

#### 2.3.1 工具箱的介绍和功能概述

MATLAB的图像处理工具箱是一套功能强大的函数和应用程序集合,旨在解决图像处理和分析中的常见问题。该工具箱提供了从基本图像操作到复杂的图像分析功能。

#### 2.3.2 核心函数和工具的使用方法

工具箱中的核心函数包括但不限于:`edge`用于边缘检测、`imbinarize`用于二值化处理、`regionprops`用于区域属性分析等。

```matlab

% 使用边缘检测函数检测图像边缘

edges = edge(img, 'Sobel'); % 使用Sobel算子进行边缘检测

imshow(edges);

```

本章节的介绍旨在为读者提供一个全面的MATLAB图像处理基础入门。在下一章节中,我们将继续深入探讨机器人视觉系统的数据采集与预处理方法,包括视觉系统的数据采集技术、图像预处理技术的应用以及特征提取与分析。

# 3. 机器人视觉系统的数据采集与预处理

## 3.1 视觉系统的数据采集技术

在这一部分,我们将深入探讨机器人视觉系统数据采集技术的细节,了解如何为处理和分析过程选择合适的相机设备,并获取高质量的视频流。

### 3.1.1 相机的选择与配置

选择合适的相机是获取优质视频流的关键。首先需要明确应用场景,这包括了光照条件、拍摄对象的移动速度以及所需的图像分辨率等。例如,在高速运动物体跟踪的场景下,高速相机是必需的。根据这些需求,可以选择不同类型的相机,如工业相机、网络相机或者高速相机。

除了相机类型的选择,分辨率、帧率和传感器尺寸都是影响最终结果的重要参数。例如,更高的分辨率可以捕捉更多的细节,但也会增加数据处理的负担。

在配置相机时,要考虑到镜头的选择,因为镜头焦距和光圈大小直接影响到视场(FOV)和景深。此外,还需要设置合适的曝光时间来保证图像质量,避免过曝或欠曝的情况。

```markdown

| 参数 | 描述 | 示例值 |

|----------------|--------------------------------------------------------------|-----------|

| 相机类型 | 根据应用场景选择,如工业相机、网络相机、高速相机等 | 工业相机 |

| 分辨率 | 摄像机的图像清晰度,单位为像素,影响图像的细节捕捉能力 | 1920x1080 |

| 帧率 | 单位时间内可以拍摄的图片数量,单位为帧/秒 | 60帧/秒 |

| 传感器尺寸 | 影响到相机的视场和景深,常见的有1/2", 2/3"等规格 | 1/2" |

| 镜头焦距 | 决定视场的宽窄,焦距越短,视场越宽 | 50 mm |

| 光圈大小 | 影响通光量和景深,光圈越大,通光量越多,但景深越小 | F2.8 |

| 曝光时间 | 感光元件接收光线的时间,影响图像的明暗 | 1/120秒 |

```

### 3.1.2 视频流的捕获与同步

获取视频流后,正确地捕获和同步这些数据流是至关重要的。在多相机系统中,这一步骤尤为关键,因为需要确保不同相机拍摄的图像能够被同步处理。

同步可以通过软件或硬件的方法实现。软件方法通常是通过时间戳来同步视频流,而硬件方法则依赖于外部设备,如触发器或者信号分配器来控制相机的拍摄。在同步过程中,需要考虑到时钟漂移和数据传输延迟等问题。

对于视频流的捕获,常见的采集方式包括使用专用的视频采集卡或者利用通用的网络接口。在软件层面,可以使用专门的库函数来读取和处理视频流,如OpenCV库。

## 3.2 图像预处理技术的应用

### 3.2.1 图像去噪与增强技术

图像在采集过程中往往受到各种噪声的影响,这些噪声会干扰视觉系统的判断。因此,进行图像去噪是预处理过程中的重要一环。常用的去噪方法包括均值滤波、高斯滤波、中值滤波等。

图像增强技术用于改善图像的视觉效果,增强图像中的某些特征,便于后续处理。例如,对比度调整可以提高图像的清晰度,锐化处理则可以突出图像的边缘。

以下是一个简单的图像去噪和增强的代码示例:

```matlab

% MATLAB中进行图像去噪与增强

img = imread('noisy_image.jpg'); % 读取带有噪声的图像

% 使用高斯滤波器进行去噪

filtered_img = imgaussfilt(img, 2);

% 使用直方图均衡化增强图像对比度

enhanced_img = histeq(filtered_img);

% 显示原图和处理后的图像

subplot(1,3,1), imshow(img), title('Original Image');

subplot(1,3,2), imshow(filtered_img), title('Gaussian Filtered Image');

subplot(1,3,3), imshow(enhanced_img), title('Contrast Enhanced Image');

```

### 3.2.2 图像的校正和转换

图像校正通常包括几何校正和色彩校正。几何校正用于修正镜头畸变和视角引起的图像变形,而色彩校正则用于调整图像的色温或色彩平衡。

图像转换则涉及到将图像从一种颜色空间转换到另一种,如从RGB颜色空间转换到HSV颜色空间,以便于处理图像中的特定颜色特征。

## 3.3 特征提取与分析

### 3.3.1 边缘检测与特征点提取

在视觉系统中,边缘检测是识别图像中物体轮廓的关键步骤。常用的边缘检测算法有Sobel、Prewitt和Canny边缘检测等。

特征点提取则用于从图像中提取出具有区分度的点,以便于物体识别和匹配。特征点检测算法如SIFT(尺度不变特征变换)和SURF(加速稳健特征)提供了一种强大的特征检测和描述方法。

以下是一个使用MATLAB进行边缘检测的代码示例:

```matlab

% 使用Canny边缘检测算法

img = imread('image.jpg'); % 读取图像

gray_img = rgb2gray(img); % 转换为灰度图像

edges = edge(gray_img, 'canny'); % 应用Canny边缘检测

% 显示原图和边缘检测结果

subplot(1,2,1), imshow(img), title('Original Image');

subplot(1,2,2), imshow(edges), title('Edge Detected Image');

```

### 3.3.2 形状与纹理特征的分析

形状特征通常用于描述图像中对象的外形,例如面积、周长、形状描述符等。这些特征对于图像中的物体分类和识别至关重要。在MATLAB中,可以通过区域属性函数来提取形状特征。

纹理特征描述的是图像中像素值的空间分布模式。常见的纹理特征包括对比度、均匀性、相关性和能量等。使用如灰度共生矩阵(GLCM)可以有效提取纹理特征。

本章节中,我们深入探讨了机器人视觉系统数据采集的关键技术和图像预处理的方法。从相机的选择、视频流的捕获和同步,到图像的去噪、增强、校正和特征提取,每一步都是整个视觉系统准确性的基础。通过这些高级技术,可以确保机器人视觉系统能够处理复杂多变的现实环境,为后续的识别、分析和决策提供了坚实的基础。

# 4. 机器人视觉系统的识别与跟踪技术

## 4.1 模式识别在视觉中的应用

模式识别在机器人视觉系统中是关键的一环,它使得机器人可以准确地从环境中的图像识别出目标物体和特征。模式识别技术包括模板匹配、特征匹配、分类器设计等多种方法。

### 4.1.1 模板匹配与特征匹配技术

模板匹配是一种基本的图像识别技术,它通过将模板图像与场景图像进行逐像素比较,来找到匹配度最高的区域。而在特征匹配中,通常会提取关键点,然后对这些关键点进行匹配来实现识别。

在模板匹配中,使用MATLAB进行匹配的一个简单示例代码如下:

```matlab

function [score, loc] = template_match(img, template)

[score, loc] = normxcorr2(template, img);

end

```

参数说明:

- `img`:输入的场景图像;

- `template`:要匹配的模板图像;

- `score`:匹配分数,表示相似度;

- `loc`:匹配位置。

逻辑分析:

- 使用`normxcorr2`函数可以进行归一化的互相关匹配,它对输入图像和模板图像进行逐像素比较,计算它们的相关性,`score`值越大表示匹配度越高。

- `loc`变量会返回模板在场景图像中的位置,这对于机器人视觉系统中定位任务非常重要。

### 4.1.2 分类器设计与训练方法

分类器设计是为了让机器人能够区分和识别不同的图像类别。分类器的设计方法多种多样,常见的有支持向量机(SVM)、随机森林、神经网络等。

以SVM分类器为例,MATLAB中实现一个简单的SVM分类器的代码如下:

```matlab

% 假设已经有了特征向量和标签

features = ...; % 特征矩阵

labels = ...; % 标签向量

% 创建SVM分类器

svmModel = fitcsvm(features, labels);

% 使用分类器进行预测

predictions = predict(svmModel, new_features);

```

逻辑分析:

- `fitcsvm`函数用于训练SVM模型,需要输入特征向量和对应的标签。

- 训练完成后,可以使用`predict`函数对新的图像特征进行分类预测。

- 特征提取对于分类器的性能至关重要,通常需要经过大量的数据预处理和特征选择。

## 4.2 运动目标的检测与跟踪

在动态环境中,运动目标的检测与跟踪是机器人视觉系统中一个重要的功能,它允许机器人理解动态场景并作出相应反应。

### 4.2.1 运动估计与背景建模

运动估计是通过分析连续图像帧之间的差异来检测场景中移动物体的过程。背景建模则是建立一个场景的稳定背景模型,以便于从中检测出前景运动物体。

一个基于背景减除的方法示例代码如下:

```matlab

% 假设bg_model已经建立

bg_model = ...; % 背景模型

% 当前图像帧

current_frame = ...;

% 运动目标检测

diff_frame = abs(current_frame - bg_model);

bw_frame = imbinarize(diff_frame);

motion_objects = bw_frame > threshold;

```

逻辑分析:

- 背景模型`bg_model`可以使用多种方法建立,如高斯混合模型、中值滤波等。

- `imbinarize`函数用于将差异帧转换为二值图像,从而突出运动区域。

- 运动检测的准确性依赖于阈值`threshold`的设定,这需要根据实际情况动态调整。

### 4.2.2 跟踪算法的原理与实现

跟踪算法是指在视频序列中连续地定位和识别运动目标的过程。常用的跟踪算法包括KLT(Kanade-Lucas-Tomasi)特征跟踪器和Mean Shift等。

下面展示如何使用MATLAB的`vision.PointTracker`对象来实现基于特征点的跟踪:

```matlab

% 创建特征点跟踪器对象

tracker = vision.PointTracker('MaxBidirectionalError', 2);

% 初始化跟踪器

initialize(tracker, points, img);

% 对于后续的每帧图像

for i = 1:length(videoReader)

frame = readFrame(videoReader);

[points, isFound] = tracker.step(frame);

% 显示跟踪结果

visPoints = insertMarker(frame, points, '+');

imshow(visPoints);

end

```

逻辑分析:

- `vision.PointTracker`对象是MATLAB内置的点跟踪器,可以处理视频流中的特征点跟踪。

- `initialize`函数用于初始化跟踪器,它需要传入初始的特征点和初始帧图像。

- `tracker.step`函数用于在连续帧中更新特征点位置,`points`是跟踪到的新位置,`isFound`标记了哪些特征点被成功跟踪。

- 特征点的选择对跟踪效果有着显著影响,常用的特征检测器有Shi-Tomasi角点检测器。

## 4.3 3D视觉和深度信息处理

随着深度摄像头等硬件设备的普及,3D视觉技术在机器人视觉系统中的应用越来越广泛,它为机器人提供了立体的世界观。

### 4.3.1 立体视觉的原理与实现

立体视觉是通过两个相机从不同角度拍摄同一场景,并通过计算两幅图像中特征点的视差来重建场景三维结构的过程。

MATLAB中实现立体匹配的一个简单代码如下:

```matlab

% 假设已经获得了左右相机的图像和摄像头参数

left_img = ...;

right_img = ...;

cameraParams = ...;

% 进行立体匹配

matchedPoints = estimateStereoDisparity(left_img, right_img, cameraParams);

% 计算点云数据

pointCloud = reconstructScene(matchedPoints, cameraParams);

```

逻辑分析:

- `estimateStereoDisparity`函数用来估计左右图像之间的视差,它是通过比较两幅图像中同一特征点的位置差异来实现的。

- 视差图与摄像头参数相结合,可以使用`reconstructScene`函数进行三维场景重建,得到场景的点云数据。

### 4.3.2 深度图的获取与应用

深度图是3D视觉中的一个关键数据结构,它直接表示了场景中每个像素点距离相机的距离信息。深度图可以用于3D建模、空间定位等多种应用。

深度图获取的一个简单示例代码如下:

```matlab

% 假设已有深度摄像头获取的深度图像

depth_image = ...;

% 将深度图像转换为3D点云

pc = pointCloud(depth_image);

```

逻辑分析:

- 深度摄像头直接输出深度图,深度图中每个像素值表示对应位置点到摄像头的距离。

- 利用`pointCloud`函数,可以将深度图像转换为点云数据,这在三维重建和物体识别中非常有用。

> 请注意,以上示例代码仅为说明如何在MATLAB中使用相关函数进行模式识别、运动目标检测与跟踪以及深度信息处理的过程。实际应用中,这些代码需要根据具体的项目需求进行相应的调整和优化。

# 5. 案例研究:MATLAB在机器人视觉系统中的实践

## 5.1 实际项目中的视觉系统设计流程

### 5.1.1 需求分析与方案制定

在开展任何机器人视觉系统项目之前,需求分析是至关重要的一步。这一阶段涉及对项目目的、预期结果、必要条件、可用资源以及潜在障碍的深入理解。例如,假设我们要开发一个能够从传送带上识别并分类不同产品的机器人视觉系统,我们需要分析传送带的速度、产品的种类、形状、尺寸、颜色等信息,以便制定出合适的视觉检测方案。

需求分析之后,我们需要制定一个初步的方案,方案中应该明确指出选用的硬件设备(如相机的分辨率、焦距、是否需要彩色/黑白相机等),软件工具(如是否使用MATLAB进行图像处理和算法开发),以及系统的工作流程(从图像采集到识别分类的过程)。方案制定过程中,应特别注意系统对实时处理的需求,以及在各种环境条件下的鲁棒性。

### 5.1.2 系统集成与调试步骤

一旦方案确定,下一步就是系统集成和调试。在本案例中,我们将使用MATLAB来集成视觉系统,并通过编写脚本来控制图像采集和后续处理。我们将首先安装和配置必要的硬件,如工业相机和照明设备,然后在MATLAB中编写脚本来与相机通信和捕获图像。

集成过程中,我们需要进行初步的图像采集,以确保摄像头的视角和照明条件能够满足识别和分类的要求。接下来,我们会进行图像预处理,包括调整图像大小、校正畸变等,以获得更适合处理的图像数据。

调试步骤包括:

1. 验证图像采集系统能否持续稳定地提供高质量图像。

2. 实施预处理算法,并检验其效果。

3. 测试特征提取算法,并根据结果调整参数。

4. 开发和测试识别分类算法,并在实际产品流中进行验证。

5. 逐步迭代以上步骤,直到系统性能满足项目要求。

## 5.2 MATLAB在视觉系统中的应用案例

### 5.2.1 机器人引导与路径规划

在自动化工业领域,机器人引导是机器人视觉系统常见的应用场景之一。MATLAB可以在这个过程中发挥其强大的图像处理和计算能力。以一个简单的例子说明,假设我们要引导一个机器人在工厂中沿着预设路径移动,需要根据视觉信息判断机器人的相对位置。

在MATLAB中,首先可以利用图像处理工具箱中的函数进行路径的提取和特征点的识别。例如,使用`edge`函数来识别路径的轮廓,然后利用`regionprops`来提取路径的特征点。通过这些特征点,我们可以构建路径模型,并使用MATLAB中的路径规划算法来计算机器人的最优移动路径。

一个简单的路径提取代码片段可能如下:

```matlab

% 假设 RGBImage 是从相机获取的图像

grayImage = rgb2gray(RGBImage); % 转换为灰度图像

BWImage = edge(grayImage, 'canny'); % 使用 Canny 算子进行边缘检测

% 提取边缘的坐标点

[B, L] = bwboundaries(BWImage, 'noholes');

imshow(label2rgb(L, @jet, [.5 .5 .5]))

hold on

for k = 1:length(B)

boundary = B{k};

plot(boundary(:,2), boundary(:,1), 'w', 'LineWidth', 2)

end

hold off

% 这里可以根据需要使用其他算法进行路径规划

```

### 5.2.2 物体识别与分类系统实例

在自动化生产线中,对物体进行快速准确的识别与分类是提高效率的关键。利用MATLAB强大的图像处理功能,我们可以轻松实现复杂的视觉识别任务。

假设在某自动化生产线上需要对不同大小和颜色的零件进行分类。我们可以使用MATLAB进行如下步骤的操作:

1. **图像采集:** 使用MATLAB与工业相机接口进行图像采集。

2. **图像预处理:** 包括灰度转换、滤波去噪、对比度增强等。

3. **特征提取:** 如使用颜色直方图进行颜色特征提取,使用HOG(Histogram of Oriented Gradients)特征进行形状识别。

4. **分类器设计:** 应用如支持向量机(SVM)或神经网络等机器学习算法进行训练和分类。

具体来说,可以使用MATLAB中的`fitcsvm`函数训练一个SVM分类器,代码大致如下:

```matlab

% 假设已经提取了训练集的特征向量和标签

trainingFeatures = [...]; % 训练特征

trainingLabels = [...]; % 训练标签

% 使用 SVM 进行分类器训练

classifier = fitcsvm(trainingFeatures, trainingLabels);

% 对未知图像数据进行分类

testImage = imread('test_image.jpg');

testFeatures = extractFeatures(testImage); % 假设已经定义了提取特征的函数

predictedLabel = predict(classifier, testFeatures);

% 显示分类结果

disp(['预测标签:', num2str(predictedLabel)]);

```

## 5.3 系统优化与未来展望

### 5.3.1 系统性能评估与优化策略

在项目实施过程中,系统性能评估是持续进行的活动。为了提高系统的识别精度和处理速度,我们可能会采取多种策略进行优化,例如:

- **算法优化:** 通过改进算法逻辑或使用更高效的算法,减少不必要的计算。

- **硬件升级:** 更换更快的相机或提高处理器的计算能力。

- **并行计算:** 利用MATLAB的并行计算工具箱,将计算任务分散到多核处理器或GPU上。

- **代码优化:** 重写代码,消除冗余操作,优化循环等。

评估系统性能时,我们可以使用MATLAB内置的性能分析工具,比如`profiler`,它能够帮助我们识别代码中的瓶颈,从而进行针对性的优化。

### 5.3.2 新技术和新算法在视觉系统中的应用前景

随着计算机视觉技术的迅速发展,新的技术和算法不断涌现,为机器人视觉系统带来更多的可能性。例如:

- **深度学习:** 深度卷积神经网络(CNN)已被证明在图像识别和分类任务中效果显著。

- **增强现实(AR)与虚拟现实(VR):** 与机器人视觉系统结合,可以创建更加直观的用户界面和交互方式。

- **边缘计算:** 将计算任务在数据源附近进行处理,减少延迟,提高实时性能。

MATLAB也在不断地更新其工具箱以支持这些新技术,开发者可以期待利用这些新工具来进一步提升视觉系统的性能。例如,MATLAB的Deep Learning Toolbox提供了深度学习算法的支持,方便开发者快速构建、训练和部署深度学习模型。

通过不断地集成新技术和优化现有系统,机器人视觉系统在未来将变得更加智能和高效,能够处理更复杂的任务并适应更加多变的环境。

0

0