Kafka中的Producer与Consumer详解

发布时间: 2024-05-03 06:22:11 阅读量: 59 订阅数: 61

# 1. Kafka简介**

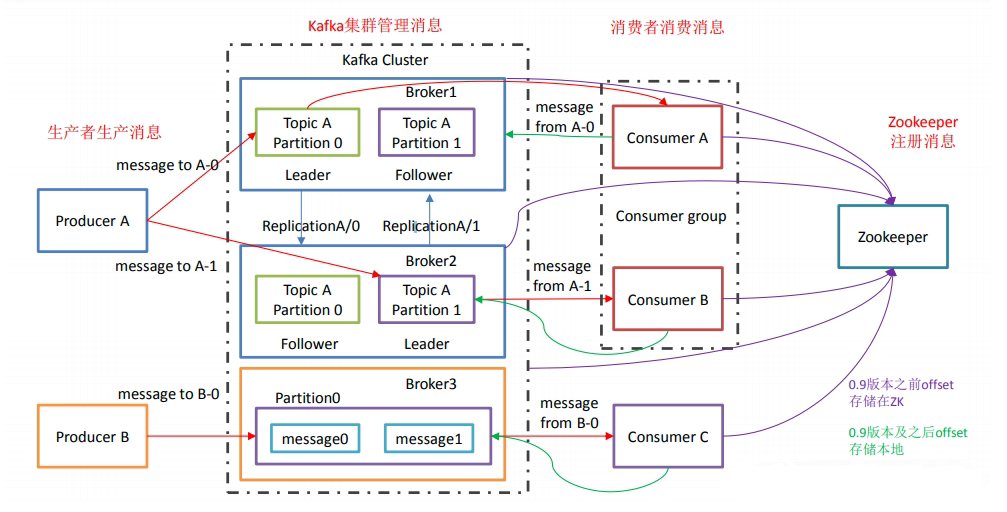

Apache Kafka是一个分布式流处理平台,用于构建实时数据管道和应用程序。它提供了一个可扩展、容错和高吞吐量的平台,用于处理大量数据流。Kafka的核心概念是主题(Topic),它是一个逻辑分组,用于存储和传输相关消息。

Kafka使用生产者(Producer)和消费者(Consumer)模型。生产者将数据写入主题,而消费者从主题中读取数据。Kafka保证消息的顺序和可靠性,即使在发生故障的情况下也是如此。

Kafka广泛应用于各种场景,包括实时数据分析、日志聚合、消息传递和事件流处理。它因其可扩展性、容错性和高吞吐量而受到欢迎,使其成为处理大数据流的理想选择。

# 2. Kafka Producer

### 2.1 Producer基本概念和原理

#### 2.1.1 Producer的配置和初始化

Kafka Producer用于将数据发送到Kafka集群。在使用Producer之前,需要进行配置和初始化。

```java

// 创建Producer配置对象

Properties props = new Properties();

props.put(ProducerConfig.BOOTSTRAP_SERVERS_CONFIG, "localhost:9092");

props.put(ProducerConfig.KEY_SERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringSerializer");

props.put(ProducerConfig.VALUE_SERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringSerializer");

// 创建Producer对象

Producer<String, String> producer = new KafkaProducer<>(props);

```

| 参数 | 说明 |

|---|---|

| BOOTSTRAP_SERVERS_CONFIG | Kafka集群的地址 |

| KEY_SERIALIZER_CLASS_CONFIG | 键序列化器 |

| VALUE_SERIALIZER_CLASS_CONFIG | 值序列化器 |

#### 2.1.2 数据分区的策略

Producer发送数据时,需要将数据分配到不同的分区。Kafka提供了多种分区策略:

* **Round Robin:** 轮询分配数据到分区。

* **Hash:** 根据键的哈希值分配数据到分区。

* **Random:** 随机分配数据到分区。

```java

// 设置分区策略

props.put(ProducerConfig.PARTITIONER_CLASS_CONFIG, "org.apache.kafka.clients.producer.RoundRobinPartitioner");

```

### 2.2 Producer发送消息

#### 2.2.1 同步和异步发送方式

Producer提供了同步和异步两种发送消息的方式:

* **同步发送:** Producer会等待消息发送成功后才返回。

* **异步发送:** Producer不会等待消息发送成功,而是通过回调函数通知发送结果。

```java

// 同步发送

producer.send(record).get();

// 异步发送

producer.send(record, (metadata, exception) -> {

if (exception != null) {

// 发送失败

} else {

// 发送成功

}

});

```

#### 2.2.2 消息的序列化和压缩

Producer发送的消息需要进行序列化和压缩。

* **序列化:** 将消息对象转换为字节数组。

* **压缩:** 减少消息的大小,提高传输效率。

```java

// 设置键序列化器

props.put(ProducerConfig.KEY_SERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringSerializer");

// 设置值序列化器

props.put(ProducerConfig.VALUE_SERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringSerializer");

// 设置压缩器

props.put(ProducerConfig.COMPRESSION_TYPE_CONFIG, "gzip");

```

# 3. Kafka Consumer

### 3.1 Consumer基本概念和原理

#### 3.1.1 Consumer的配置和初始化

Consumer的配置和初始化是使用Kafka消费消息的第一步。主要涉及以下几个方面:

- **Bootstrap Servers:**指定Kafka集群中一个或多个Broker的地址,用于建立连接。

- **Group ID:**标识Consumer所属的消费组,同一个消费组内的Consumer可以并行消费不同分区的数据。

- **Auto Offset Reset:**指定在没有Offset信息时,Consumer从哪里开始消费消息。可选值有"earliest"(从最早的消息开始)和"latest"(从最新消息开始)。

- **Key and Value Deserializers:**指定用于反序列化消息Key和Value的类,以便将字节数组转换为实际对象。

#### 3.1.2 消费组和分区分配

消费组是Kafka中管理Consumer并分配分区的机制。每个消费组可以包含多个Consumer,它们共同消费一个或多个Topic的分区。

分区分配算法决定了每个Consumer消费哪些分区。默认情况下,Kafka使用Round-Robin算法,将分区均匀分配给消费组中的Consumer。但是,也可以通过自定义分区分配器来实现更复杂的分配策略。

### 3.2 Consumer消费消息

#### 3.2.1 同步和异步消费方式

Consumer消费消息有两种方式:同步和异步。

- **同步消费:**Consumer调用`poll()`方法,阻塞等待消息到达,然后处理消息。

- **异步消费:**Consumer注册一个回调函数,当消息到达时,Kafka会调用该回调函数处理消息。

同步消费简单易用,但效率较低,因为Consumer需要阻塞等待消息。异步消费效率更高,但需要处理回调函数的复杂性。

#### 3.2.2 消息的处理和提交

Consumer消费消息后,需要进行处理,然后提交Offset以标记消息已消费。

消息处理通常涉及以下步骤:

- 反序列化消息Key和Value

- 执行业务逻辑

- 根据需要更新数据库或其他系统

Offset提交是通过调用`commit()`方法完成的。提交Offset后,Kafka将不再向该Consumer发送已提交Offset之前的所有消息。

**代码示例:**

```java

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.apache.kafka.clients.consumer.KafkaConsumer;

public class SimpleConsumer {

public static void main(String[] args) {

// 配置Consumer

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("group.id", "test-group");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

// 创建Consumer

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

// 订阅Topic

consumer.subscribe(Collections.singletonList("test-topic"));

// 循环消费消息

while (true) {

ConsumerRecords<String, String> records = consumer.poll(100);

for (ConsumerRecord<String, String> record : records) {

// 处理消息

System.out.println("Received message: " + record.key() + " - " + record.value());

// 提交Offset

consumer.commitSync();

}

}

// 关闭Consumer

consumer.close();

}

}

```

**逻辑分析:**

这段代码创建一个Kafka Consumer,配置了Bootstrap Servers、Group ID、Key和Value的反序列化器。然后,它订阅一个Topic,并循环消费消息。对于每个收到的消息,它打印消息Key和Value,然后提交Offset。最后,它关闭Consumer。

# 4. Producer与Consumer实战

### 4.1 Java Producer示例

#### 4.1.1 Producer的配置和初始化

```java

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

Producer<String, String> producer = new KafkaProducer<>(props);

```

**参数说明:**

* `bootstrap.servers`: Kafka集群的地址列表

* `key.serializer`: 消息键的序列化器

* `value.serializer`: 消息值的序列化器

* `Producer`: Kafka Producer对象

#### 4.1.2 数据的发送和序列化

```java

String key = "key";

String value = "value";

ProducerRecord<String, String> record = new ProducerRecord<>("topic", key, value);

producer.send(record);

producer.close();

```

**逻辑分析:**

1. 创建一个`ProducerRecord`对象,指定主题、键和值。

2. 调用`Producer.send()`方法发送消息。

3. 调用`Producer.close()`方法关闭生产者。

**代码块解释:**

* `ProducerRecord`: 表示要发送到Kafka主题的消息。

* `send()`: 异步发送消息,不会阻塞。

* `close()`: 关闭生产者,释放资源。

### 4.2 Java Consumer示例

#### 4.2.1 Consumer的配置和初始化

```java

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("group.id", "consumer-group");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

Consumer<String, String> consumer = new KafkaConsumer<>(props);

```

**参数说明:**

* `bootstrap.servers`: Kafka集群的地址列表

* `group.id`: 消费组的ID

* `key.deserializer`: 消息键的反序列化器

* `value.deserializer`: 消息值的反序列化器

* `Consumer`: Kafka Consumer对象

#### 4.2.2 消息的消费和处理

```java

consumer.subscribe(Collections.singletonList("topic"));

while (true) {

ConsumerRecords<String, String> records = consumer.poll(100);

for (ConsumerRecord<String, String> record : records) {

System.out.println("Received message: " + record.value());

}

}

```

**逻辑分析:**

1. 调用`Consumer.subscribe()`方法订阅主题。

2. 进入无限循环,每100毫秒调用`Consumer.poll()`方法获取消息。

3. 遍历获取的消息,打印消息值。

**代码块解释:**

* `subscribe()`: 订阅一个或多个主题。

* `poll()`: 从订阅的主题中获取消息。

* `ConsumerRecord`: 表示从Kafka主题中接收到的消息。

# 5.1 Producer性能优化

### 5.1.1 批量发送和压缩

**批量发送**

批量发送可以有效减少网络请求次数,提高吞吐量。Kafka Producer允许将多条消息打包成一个批次发送,以减少网络开销。通过设置`batch.size`和`linger.ms`参数,可以控制批次的大小和等待时间。

**代码示例:**

```java

Properties props = new Properties();

props.put("batch.size", 16384); // 16KB

props.put("linger.ms", 10); // 10毫秒

```

**压缩**

压缩可以减小消息大小,提高网络传输效率。Kafka Producer支持多种压缩算法,如GZIP、Snappy和LZ4。通过设置`compression.type`参数,可以指定压缩算法。

**代码示例:**

```java

Properties props = new Properties();

props.put("compression.type", "snappy");

```

### 5.1.2 异步发送和回调机制

**异步发送**

异步发送允许Producer在不等待服务器响应的情况下发送消息,从而提高吞吐量。通过设置`request.required.acks`参数为`0`,可以启用异步发送。

**代码示例:**

```java

Properties props = new Properties();

props.put("request.required.acks", 0);

```

**回调机制**

回调机制允许Producer在消息发送成功或失败后收到通知。通过实现`Callback`接口,可以注册回调函数。

**代码示例:**

```java

ProducerRecord<String, String> record = new ProducerRecord<>("topic", "key", "value");

producer.send(record, new Callback() {

@Override

public void onCompletion(RecordMetadata metadata, Exception exception) {

// 处理消息发送结果

}

});

```

0

0