CentOS7环境下大数据组件搭建指南:Hadoop、Zookeeper、Hbase、Spark、Kafka

需积分: 16 49 浏览量

更新于2024-07-19

1

收藏 717KB PDF 举报

"大数据平台搭建,包括hadoop集群、zookeeper、hbase、kafka、spark的搭建,基于CentOS7操作系统,详细介绍了每一步的配置过程。"

本文档主要阐述了如何在三台虚拟机上搭建一个完整的大数据处理平台,涵盖了多个核心组件的配置与集成。首先,我们来看一下搭建的基础环境。

一、简介

平台搭建在三台CentOS7系统上的虚拟机中,使用了以下软件版本:

- Hadoop: hadoop-2.7.3

- Hbase: hbase-1.2.6

- Zookeeper: zookeeper-3.4.9

- Spark: spark-2.0.2-bin-hadoop2.7

- Kafka: kafka_2.11-0.9.0.1

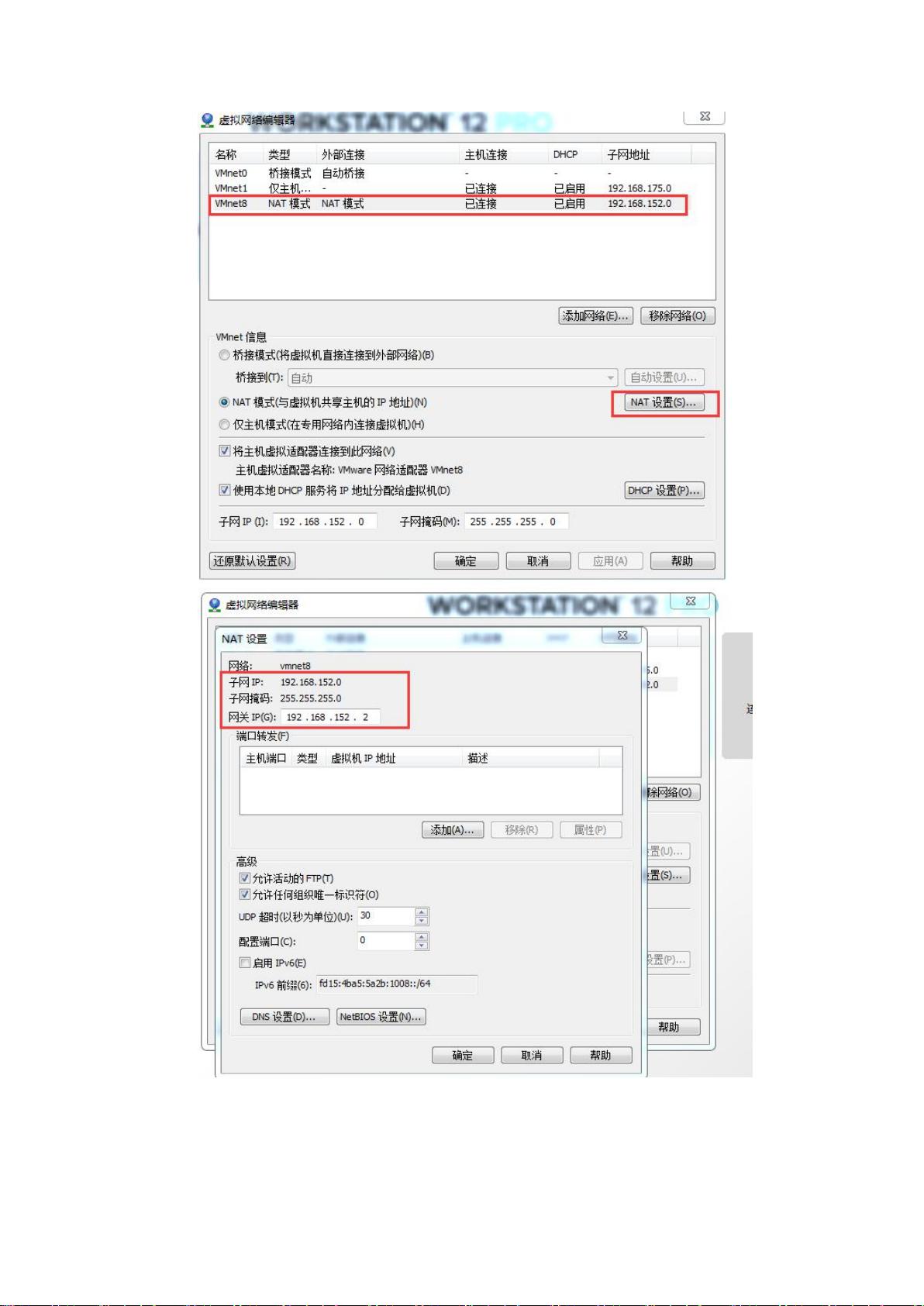

二、虚拟机配置

虚拟机使用VMware12创建,并安装了CentOS7操作系统,命名为master、slave1和slave2,保持用户名一致,以简化后续的配置步骤。

三、配置SSH免登陆

这一步骤是为了解决在多节点间进行命令行操作时,频繁输入密码的问题,通过ssh-keygen生成密钥对,并将公钥复制到其他节点,实现无密码登录。

四、hadoop配置

1. 下载并解压hadoop-2.7.3,配置环境变量,添加到profile或bashrc文件。

2. 修改hadoop的相关配置文件,如core-site.xml、hdfs-site.xml、mapred-site.xml和yarn-site.xml,配置HDFS、MapReduce和YARN的参数。

3. 将配置文件复制到slave1和slave2,确保所有节点配置一致。

4. 启动HDFS和YARN服务,然后停止服务进行验证。

五、Zookeeper配置

1. 在master节点上下载并解压zookeeper-3.4.9。

2. 修改配置文件zoo.cfg,设置数据存储路径和集群配置。

3. 创建myid文件,表示当前节点在集群中的ID。

4. 将zookeeper复制到slave1和slave2,同步配置。

5. 开放防火墙端口,允许集群内部通信。

6. 测试Zookeeper集群是否正常运行。

六、hbase配置

1. 在master节点上下载并解压hbase-1.2.6。

2. 配置环境变量,添加HBASE_HOME。

3. 修改hbase-site.xml配置文件,指定Zookeeper地址等信息。

4. 将配置文件复制到slave1和slave2。

5. 启动和停止HBase服务,验证集群运行状态。

七、spark-on-yarn部署

1. 下载并解压spark-2.0.2-bin-hadoop2.7。

2. 配置环境变量,添加SPARK_HOME。

3. 启动HDFS和YARN服务,为Spark提供计算资源。

4. 在YARN上运行Spark示例程序,测试集群功能。

八、kafka配置

1. 下载并解压kafka_2.11-0.9.0.1。

2. 修改server.properties配置文件,包含broker ID、Zookeeper地址等。

3. 开放必要的端口,如9092,以允许客户端连接。

4. 启动和停止Kafka broker。

5. 使用简单的生产者和消费者程序测试Kafka集群的正确性。

九、总结

本教程详细地介绍了如何构建一个全面的大数据处理环境,每个组件的安装、配置和测试都得到了充分的讲解,对于学习和实践大数据技术的人来说,是一个宝贵的参考资源。通过这样的平台,可以进行数据处理、流式计算和消息传递等多种任务,为实际项目开发打下坚实基础。

2019-05-17 上传

2018-05-12 上传

2023-04-06 上传

2023-06-01 上传

2023-06-13 上传

2024-05-30 上传

2023-05-26 上传

2023-07-15 上传

奋斗的喵

- 粉丝: 3

- 资源: 2

最新资源

- Lombok 快速入门与注解详解

- SpringSecurity实战:声明式安全控制框架解析

- XML基础教程:从数据传输到存储解析

- Matlab实现图像空间平移与镜像变换示例

- Python流程控制与运算符详解

- Python基础:类型转换与循环语句

- 辰科CD-6024-4控制器说明书:LED亮度调节与触发功能解析

- AE particular插件全面解析:英汉对照与关键参数

- Shell脚本实践:创建tar包、字符串累加与简易运算器

- TMS320F28335:浮点处理器与ADC详解

- 互联网基础与结构解析:从ARPANET到多层次ISP

- Redhat系统中构建与Windows共享的Samba服务器实战

- microPython编程指南:从入门到实践

- 数据结构实验:顺序构建并遍历链表

- NVIDIA TX2系统安装与恢复指南

- C语言实现贪吃蛇游戏基础代码