局部加权回归与Logistic回归:非线性拟合与分类技巧

需积分: 48 97 浏览量

更新于2024-07-20

1

收藏 1.8MB PPTX 举报

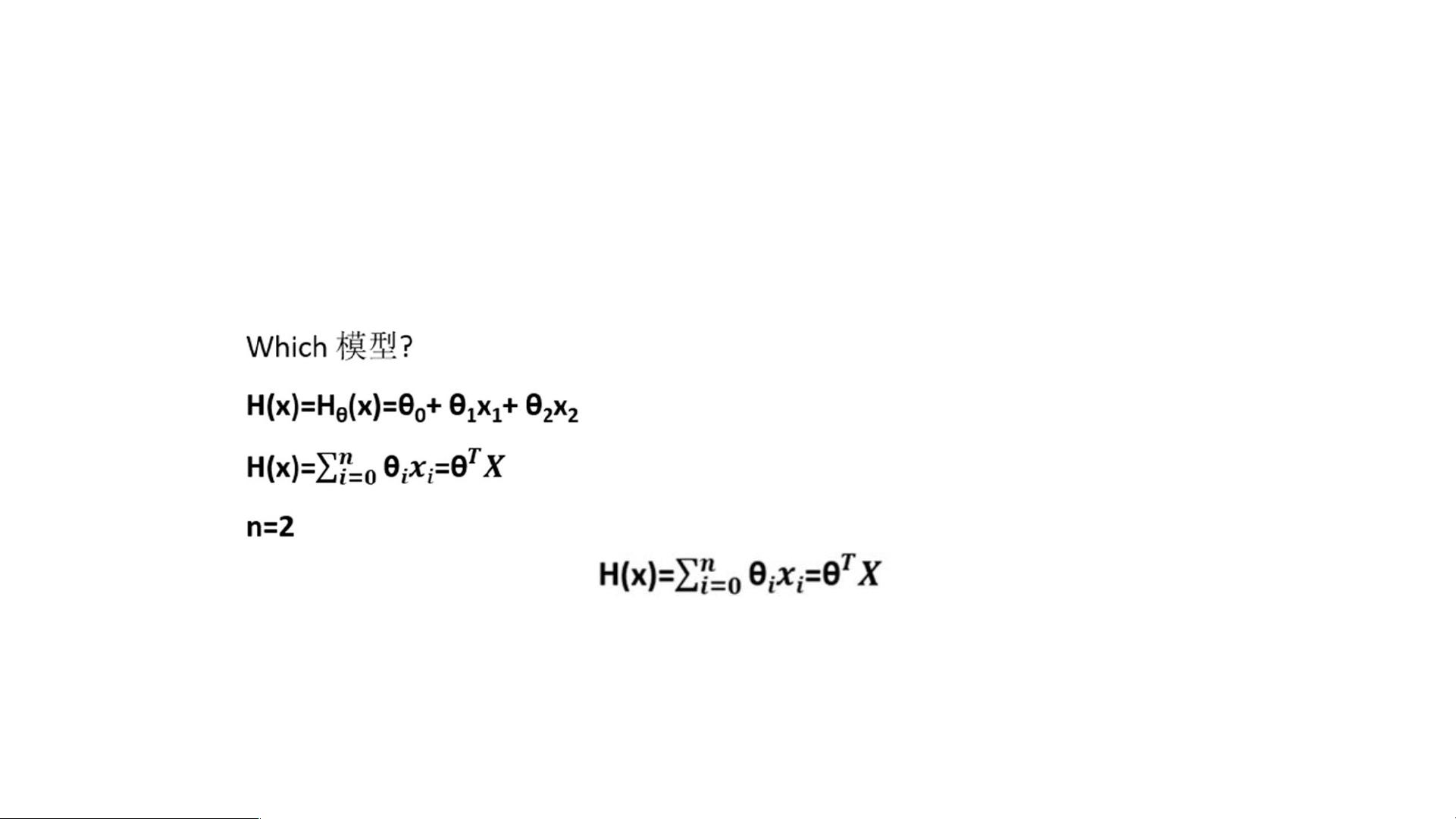

在本次讨论中,我们将聚焦于"logistic回归和局部加权回归"这一主题,这两者都是统计学和机器学习领域中的重要概念。首先,让我们回顾一下线性回归的基本原理。线性回归是一种通过找到一条直线(或超平面)来近似数据之间关系的方法,通常假设目标变量与输入变量之间存在线性关系。然而,当数据呈现非线性趋势或者噪声较大时,传统的线性回归可能无法提供精确的拟合。

局部加权回归(Locally Weighted Regression,LWR)作为一种变种,解决了这些问题。LWR的核心思想是在每个数据点附近使用一个权重函数来构建一个局部模型,这样可以更好地适应数据的复杂变化。它并不像线性回归那样全局拟合,而是更注重个体数据点的局部特性。这种方法的优势在于能够捕捉到数据的非线性和局部依赖性,但其计算成本较高,不太适合处理大规模数据集。

与线性回归相比,LWR的算法流程包括选择合适的带宽(bandwidth),即权重函数的半径,来确定局部模型的范围。带宽的选择对最终结果有显著影响,过大可能导致过拟合,过小则可能欠拟合。针对大数据场景的局限,KD-tree算法被提及作为可能的解决方案,以提高处理效率。

接下来,我们转向logistic回归,这是一种特殊的回归模型,用于处理分类问题。尽管回归通常用于连续变量的预测,logistic回归通过sigmoid函数将线性预测转换为概率形式,使得输出结果落在[0,1]之间,符合二分类问题的逻辑。大牛们警告使用回归做分类可能存在问题,因为回归模型假设连续性,而分类问题本质上是离散的,并且容易受到噪声的影响。

一个简单的例子指出,线性回归的简单线性关系可能不足以准确区分类别,因此logistic回归通过引入非线性转换,解决了这种问题。它在诸如疾病诊断、客户行为预测等领域广泛应用,尤其是在处理非线性分类问题时表现突出。

logistic回归和局部加权回归在不同的场景下各自发挥着作用,前者通过概率映射进行分类,后者通过局部权重适应数据的非线性。理解这两种方法的优缺点以及适用条件,对于提升数据分析和建模能力至关重要。同时,对于大数据背景下,如何优化局部加权方法和选择适当的模型类型,也是现代数据科学中持续探索的问题。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2023-02-06 上传

2017-12-29 上传

2021-10-15 上传

2014-06-20 上传

点击了解资源详情

点击了解资源详情

boat_lee

- 粉丝: 873

- 资源: 6

最新资源

- Chrome ESLint扩展:实时运行ESLint于网页脚本

- 基于 Webhook 的 redux 预处理器实现教程

- 探索国际CMS内容管理系统v1.1的新功能与应用

- 在Heroku上快速部署Directus平台的指南

- Folks Who Code官网:打造安全友好的开源环境

- React测试专用:上下文提供者组件实现指南

- RabbitMQ利用eLevelDB后端实现高效消息索引

- JavaScript双向对象引用的极简实现教程

- Bazel 0.18.1版本发布,Windows平台构建工具优化

- electron-notification-desktop:电子应用桌面通知解决方案

- 天津理工操作系统实验报告:进程与存储器管理

- 掌握webpack动态热模块替换的实现技巧

- 恶意软件ep_kaput: Etherpad插件系统破坏者

- Java实现Opus音频解码器jopus库的应用与介绍

- QString库:C语言中的高效动态字符串处理

- 微信小程序图像识别与AI功能实现源码