Logistic Regression: 从朴素贝叶斯到最大似然估计

需积分: 10 63 浏览量

更新于2024-07-06

收藏 1.56MB PDF 举报

“哈工大机器学习课程的第五部分主要讲解了逻辑回归(Logistic Regression)的概念、模型形式、参数估计方法以及正则化。”

在机器学习领域,逻辑回归(Logistic Regression)是一种广泛使用的分类算法,尤其适用于处理二分类问题。尽管它的名字中含有“回归”,但实际上它是一个分类方法。描述中提到,朴素贝叶斯(Naive Bayes)可以通过学习P(Y)和P(X|Y)来计算条件概率P(Y|X),那么为什么不直接学习P(Y|X)呢?

逻辑回归的想法是构建一个函数f:X → Y,其中X是特征向量,包含n个实值特征X1到Xn,而Y是一个布尔变量。假设所有Xi在给定Y的情况下条件独立,并且模型P(Xi|Y=yk)被建模为高斯分布N(μik, σi),而P(Y)被建模为伯努利分布Bernoulli(π)。这样的设置意味着P(Y|X)将具有特定的形式。

通过推导,可以得出P(Y|X)对于连续特征Xi的表达式,这个表达式通常涉及到逻辑函数,即Sigmoid函数,它将实数值映射到(0,1)之间,非常适合表示概率。因此,逻辑回归模型的预测结果可以解释为类Y为真的概率。

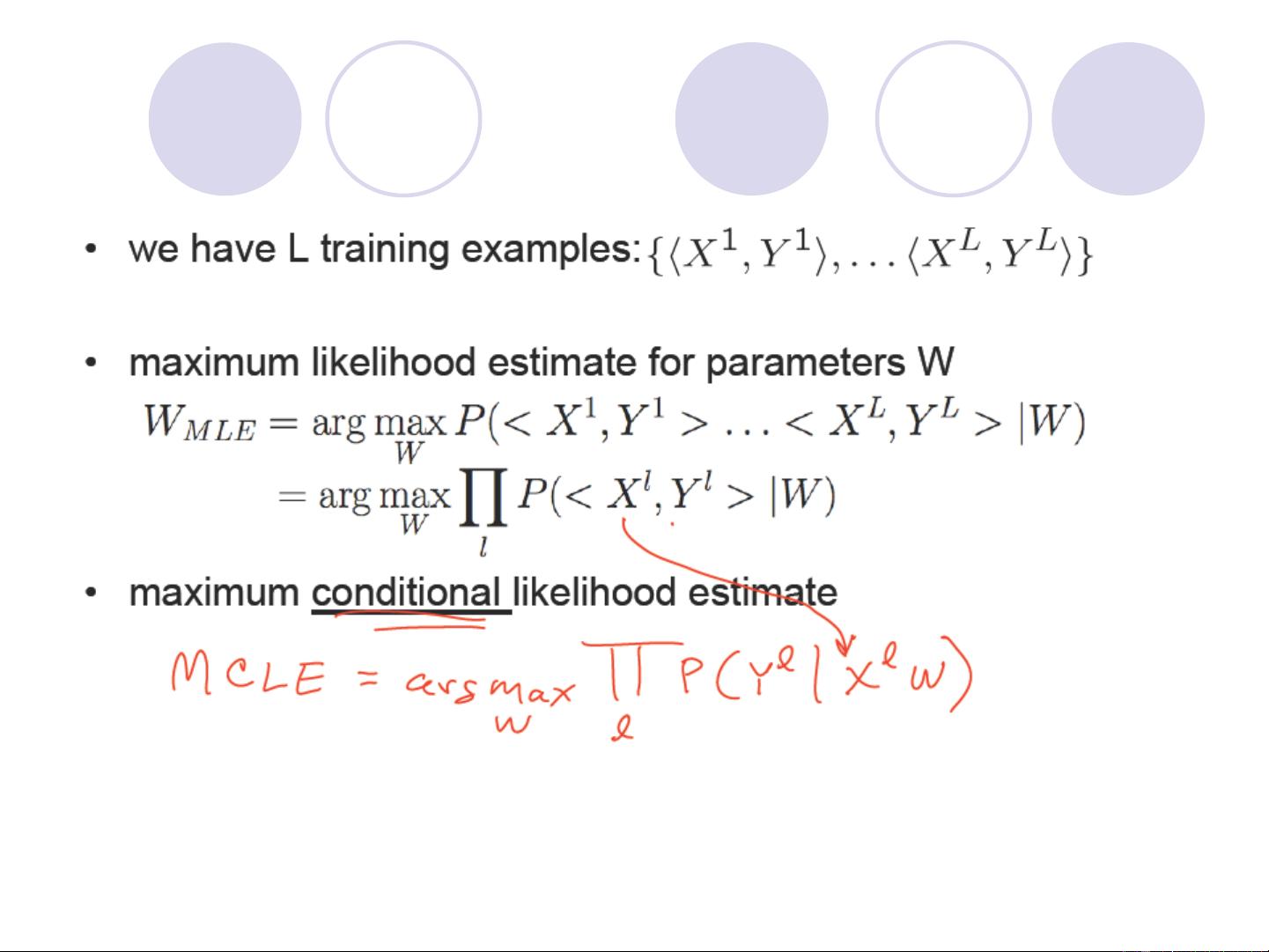

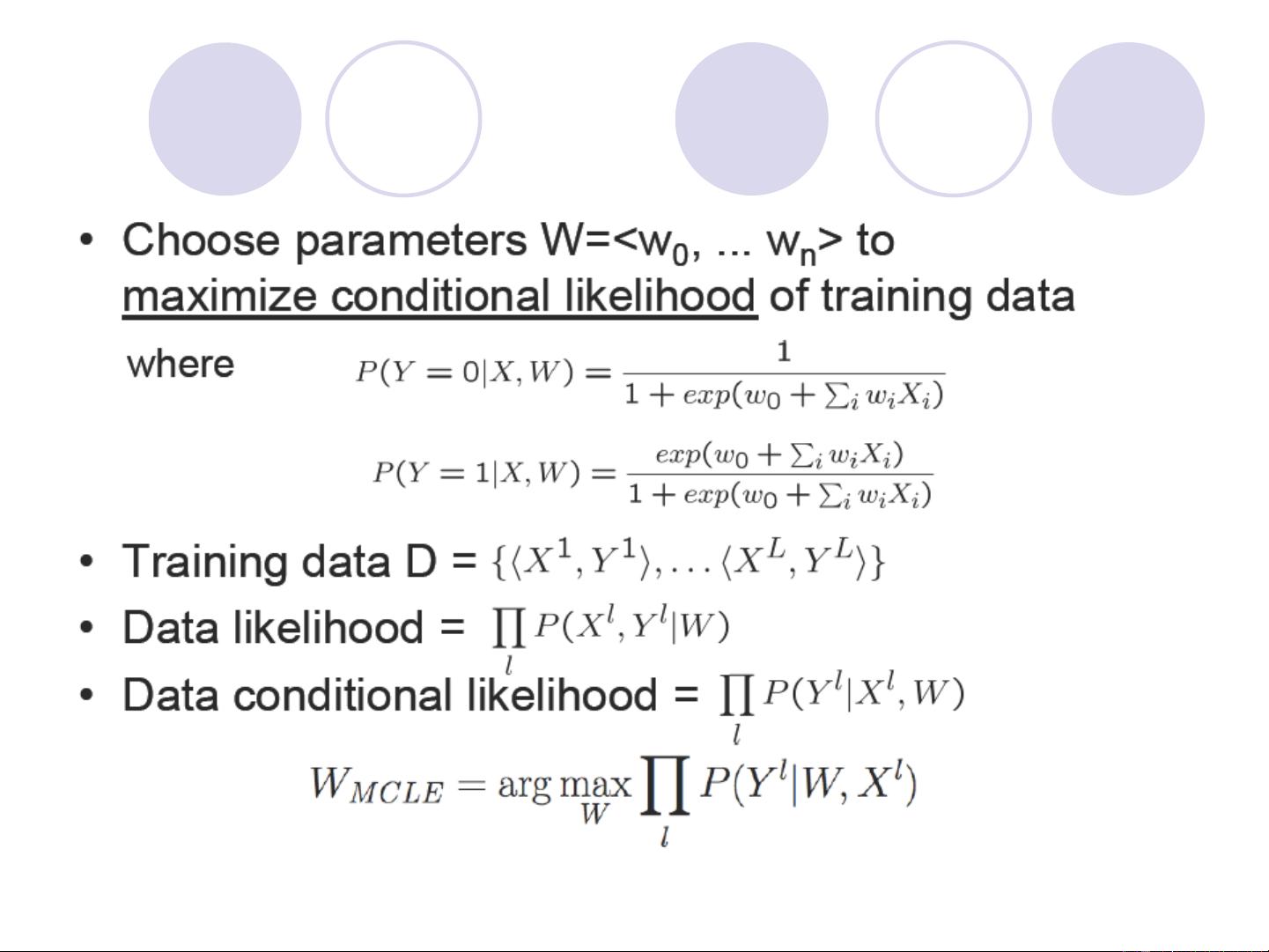

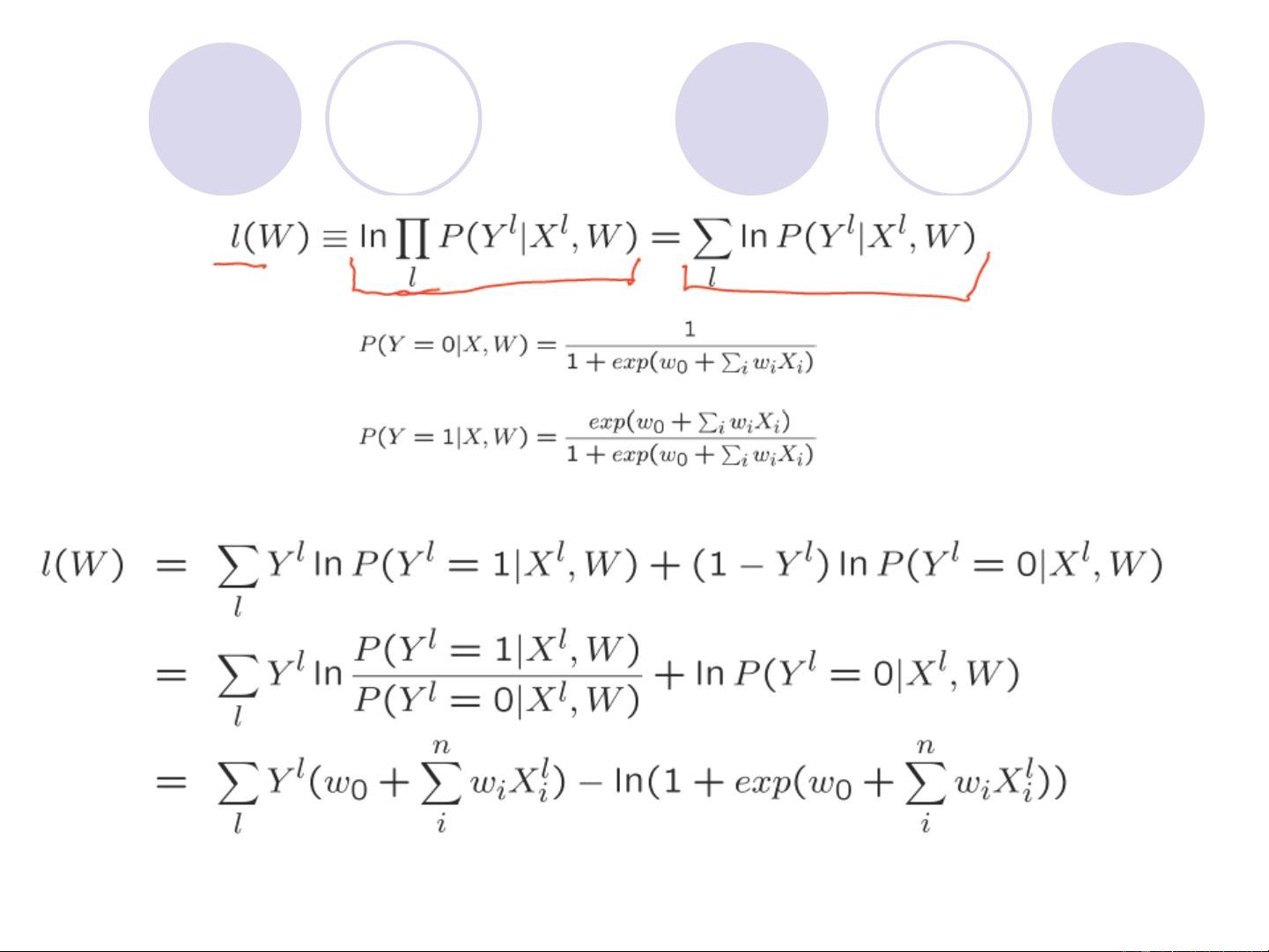

训练逻辑回归模型时,通常采用最大似然估计(Maximum Likelihood Estimation, MLE)或最大后验估计(Maximum A Posteriori, MAP)。MLE通过最大化条件似然对数来找到最佳参数,这一过程可以通过梯度上升法实现。而MAP则引入先验分布来帮助避免过大的权重和过拟合,如使用均值为0、协方差为单位矩阵的高斯分布作为权重W的先验。

比较MLE和MAP,两者都是参数估计的方法,但MAP考虑了先验信息,可以在一定程度上起到正则化的作用,防止模型过于复杂,提高泛化能力。正则化是控制模型复杂度的重要手段,可以避免过拟合,提升模型在未知数据上的表现。

总结来说,哈工大机器学习课件-5主要介绍了逻辑回归的基本思想、模型构建、参数估计方法以及正则化的应用,这些都是理解和应用逻辑回归算法的关键知识点。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2022-01-25 上传

2022-01-25 上传

2022-01-25 上传

2022-01-25 上传

2010-04-01 上传

2024-04-16 上传

sghwjp

- 粉丝: 1

- 资源: 13

最新资源

- MATLAB新功能:Multi-frame ViewRGB制作彩色图阴影

- XKCD Substitutions 3-crx插件:创新的网页文字替换工具

- Python实现8位等离子效果开源项目plasma.py解读

- 维护商店移动应用:基于PhoneGap的移动API应用

- Laravel-Admin的Redis Manager扩展使用教程

- Jekyll代理主题使用指南及文件结构解析

- cPanel中PHP多版本插件的安装与配置指南

- 深入探讨React和Typescript在Alias kopio游戏中的应用

- node.js OSC服务器实现:Gibber消息转换技术解析

- 体验最新升级版的mdbootstrap pro 6.1.0组件库

- 超市盘点过机系统实现与delphi应用

- Boogle: 探索 Python 编程的 Boggle 仿制品

- C++实现的Physics2D简易2D物理模拟

- 傅里叶级数在分数阶微分积分计算中的应用与实现

- Windows Phone与PhoneGap应用隔离存储文件访问方法

- iso8601-interval-recurrence:掌握ISO8601日期范围与重复间隔检查