微软Build 2023:GPT模型预训练数据详解

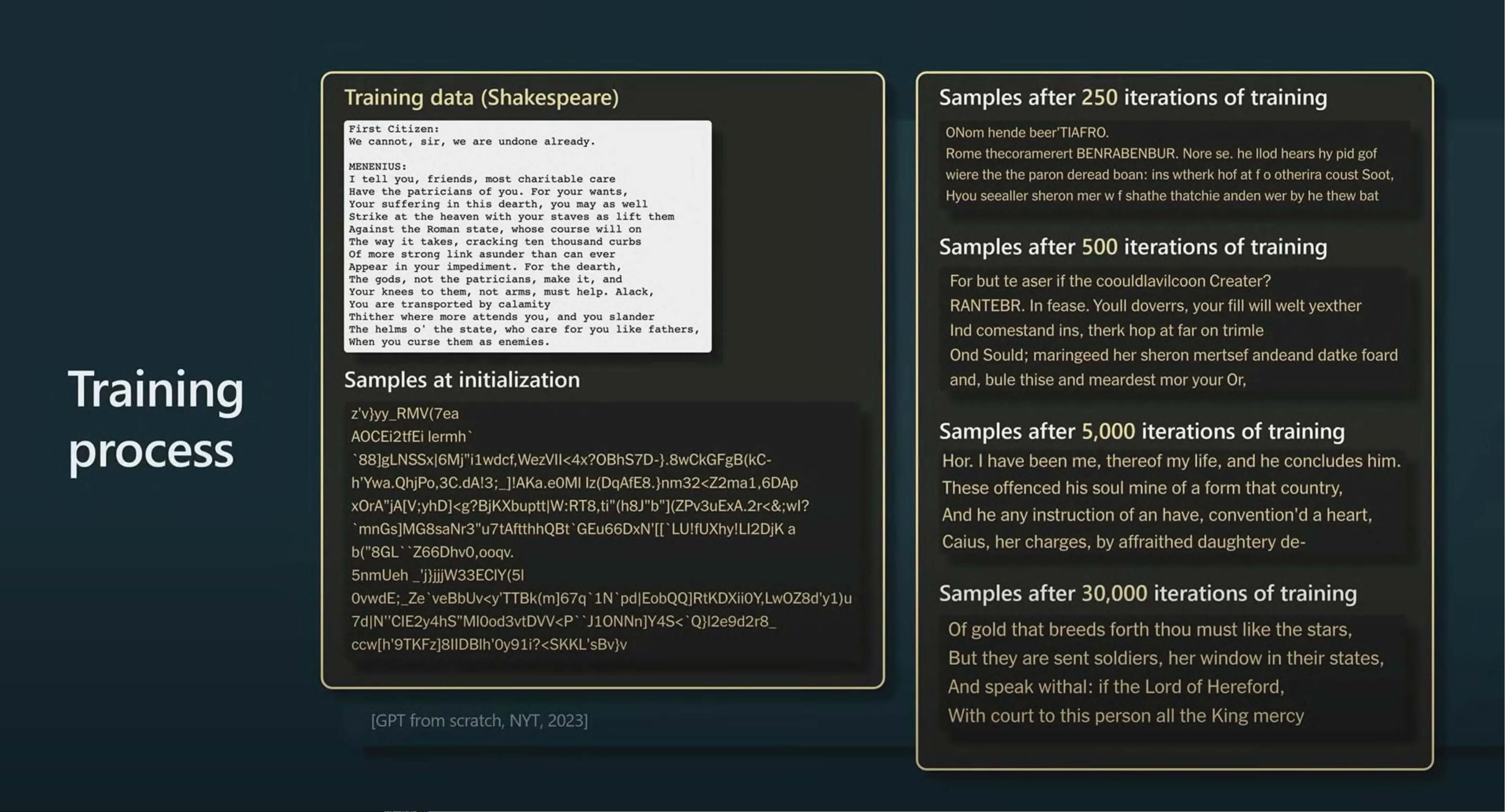

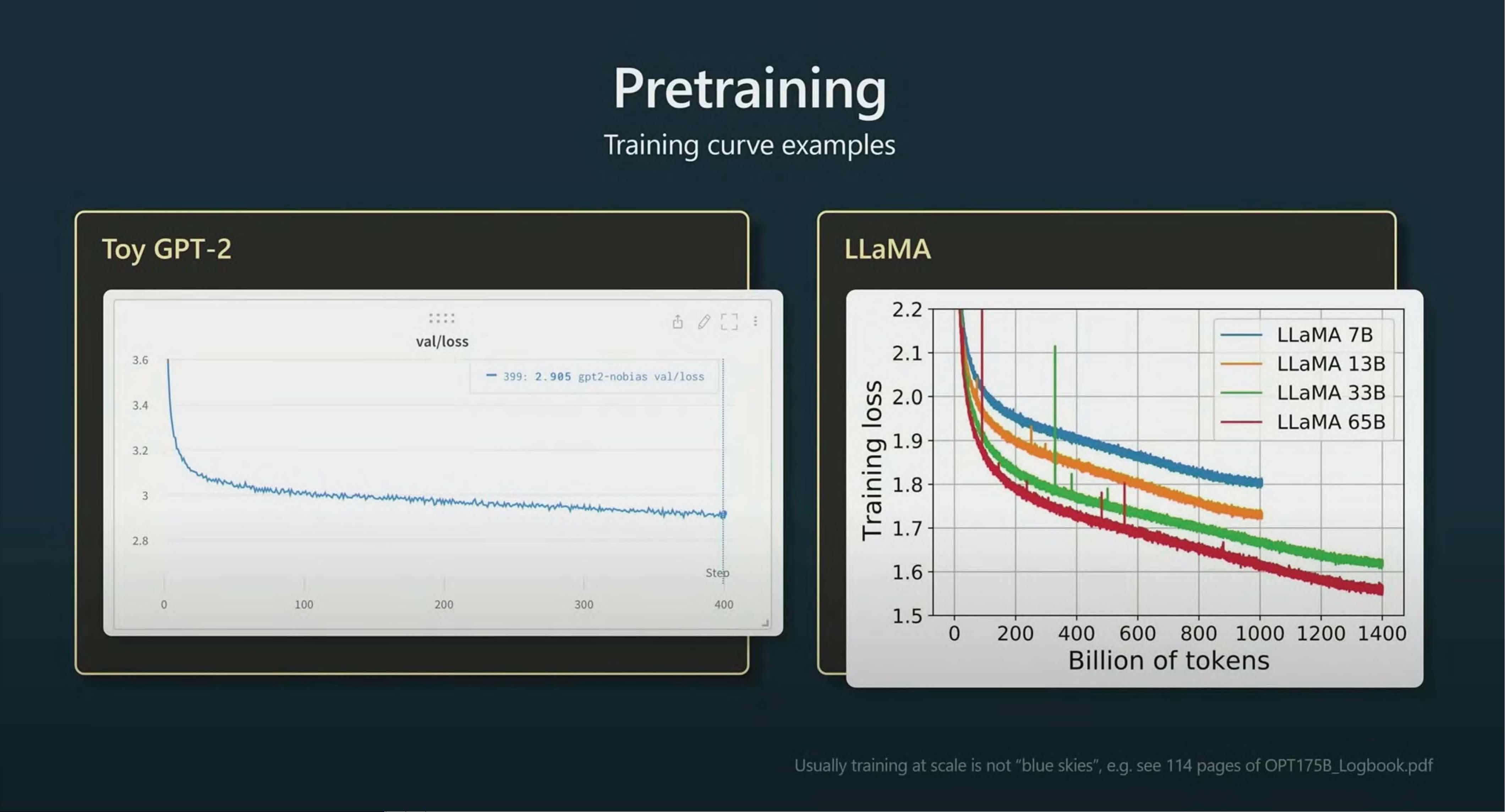

在【R108】State of GPT【Microsoft Build 2023 RD】.pdf文件中,讨论了微软GPT家族模型的数据收集和预训练过程。该研究的重点在于GPT模型如何通过大量的公开可用数据进行训练,以提升其理解和生成文本的能力。这些数据集包括Common Crawl(占比67%,3.3TB)、C4(占比15%,783GB)、GitHub(占比4.5%,328GB)、Wikipedia(占比4.5%,83GB)、书籍(占比4.5%,85GB)、以及ArXiv(占比2.5%,92GB)和StackExchange(占比2.0%,78GB)。这些数据混合用于模型的预训练,每种数据集的采样比例、训练所用的epoch数量以及占用的硬盘空间都有明确列出。 GPT模型的基础是处理文本的基本单位——tokens,这些是文本中常见的字符序列,如字母、数字或标点符号。模型通过理解这些字符序列之间的统计关系,能够预测并生成文本序列中的下一个可能的token。例如,当用户输入一段文本时,GPT API可以将文本分解成tokens,并显示每个token的数量,这对于了解模型如何解析输入信息至关重要。 值得注意的是,虽然预训练是在1.4万亿个token上进行的,但不同数据集的处理方式保持了一致的采样比例。这确保了模型在处理多样化的语言和主题时能获得丰富的上下文信息。通过对这些大规模数据集的学习,GPT系列模型能够展现出强大的文本生成和理解能力,适用于各种自然语言处理任务,如文本生成、对话系统、翻译等。 总结来说,【R108】State of GPT【Microsoft Build 2023 RD】.pdf文件深入剖析了GPT模型的训练基础,展示了数据的来源、处理策略和其对模型性能的影响,强调了数据在现代AI语言模型中的核心作用。对于那些对GPT技术背后工作原理感兴趣的人而言,这份报告提供了深入了解模型内部运作机制的重要资料。

剩余44页未读,继续阅读

- 粉丝: 19

- 资源: 7

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

最新资源

- 计算机人脸表情动画技术发展综述

- 关系数据库的关键字搜索技术综述:模型、架构与未来趋势

- 迭代自适应逆滤波在语音情感识别中的应用

- 概念知识树在旅游领域智能分析中的应用

- 构建is-a层次与OWL本体集成:理论与算法

- 基于语义元的相似度计算方法研究:改进与有效性验证

- 网格梯度多密度聚类算法:去噪与高效聚类

- 网格服务工作流动态调度算法PGSWA研究

- 突发事件连锁反应网络模型与应急预警分析

- BA网络上的病毒营销与网站推广仿真研究

- 离散HSMM故障预测模型:有效提升系统状态预测

- 煤矿安全评价:信息融合与可拓理论的应用

- 多维度Petri网工作流模型MD_WFN:统一建模与应用研究

- 面向过程追踪的知识安全描述方法

- 基于收益的软件过程资源调度优化策略

- 多核环境下基于数据流Java的Web服务器优化实现提升性能

信息提交成功

信息提交成功