Memcached分布式缓存原理详解:应对高并发性能提升

需积分: 0 47 浏览量

更新于2024-08-05

收藏 1.01MB PDF 举报

Memcached分布式缓存实现原理是IT领域中一个重要的话题,尤其是在高并发环境下,为了提高系统性能和响应速度,缓存技术显得尤为关键。在数据库面临大量读写请求的压力时,磁盘I/O成为瓶颈,通过缓存可以显著减少这种延迟。本文主要关注的是Memcached,一个广泛使用的分布式内存对象缓存系统。

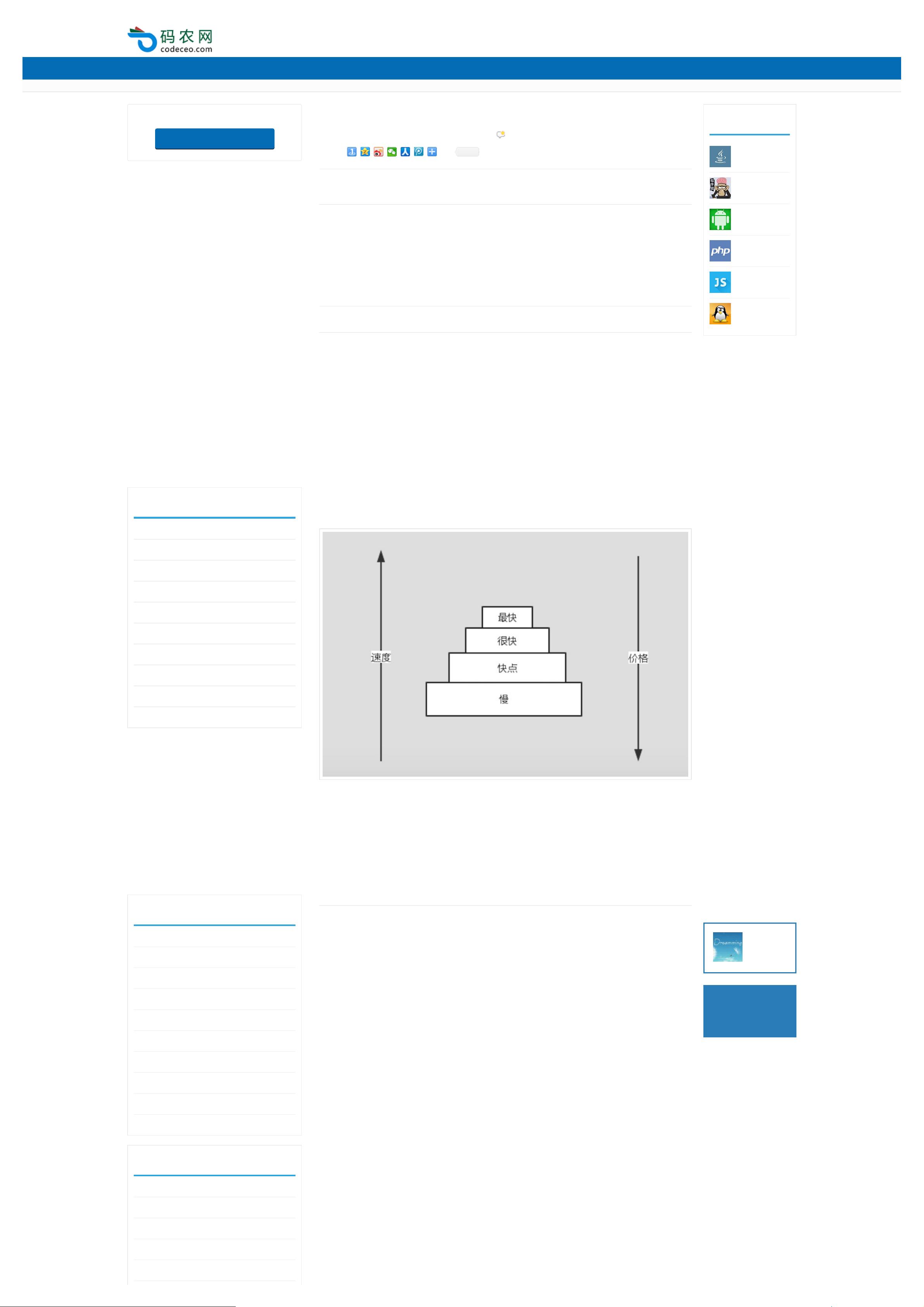

Memcached的基本概念源自计算机体系结构,它将存储体系比喻为一个层级的金字塔,其中最顶层的高速缓存如二级缓存(L2 Cache)和更高级别的存储如寄存器,用于快速提供数据。这些缓存设计的目的是缩短数据访问时间,提升计算效率。在应用层面,缓存被用来作为应用程序和数据库之间的中介,当数据频繁请求但变化不频繁时,可以通过缓存来预先加载,降低对数据库的依赖。

Memcached的分布式实现原理是其核心竞争力之一。分布式缓存允许将数据分散存储在多台服务器上,而不是集中在一个单点,这样即使某一台服务器出现问题,其他节点仍能继续服务,提高了系统的可用性和容错性。分布式缓存的实现基于一致性哈希算法,它能够动态地将数据分配到各个节点,并在节点之间进行负载均衡。当缓存满时,新的请求会根据一致性哈希策略决定将数据存储在哪个节点,而不是简单地选择最早或者最近的一台。

为了实现实时的缓存更新,Memcached采用了主从复制或复制组的机制。当数据在缓存中更新时,主节点会将变更通知给从节点,确保数据的一致性。同时,为了处理网络分区和数据丢失的情况,Memcached还支持分布式锁,以保证并发操作的安全性。

Memcached的设计原则包括简单性、高效性和可伸缩性,它使用二进制协议进行通信,减少了网络开销。由于其轻量级和无状态的特性,Memcached易于部署和管理,适合大规模并发环境下的应用。

在实际使用中,Memcached与Redis等其他分布式缓存产品各有优劣,Memcached以其稳定性、性能和广泛的社区支持受到开发者青睐,尤其适用于对实时性要求不高的场景。了解这些原理有助于开发人员在设计高性能系统时做出明智的选择,并优化应用程序的架构。

Memcached的分布式缓存实现原理是通过一致性哈希、数据复制和分布式锁等技术来提供快速、可靠的服务。掌握这些核心概念,将有助于开发人员在高并发环境中构建出更高效的IT系统。

135 浏览量

130 浏览量

156 浏览量

142 浏览量

125 浏览量

2014-09-23 上传

121 浏览量

111 浏览量

2023-09-17 上传