Keras中实现余弦退火学习率调整策略

版权申诉

148 浏览量

更新于2024-09-10

收藏 186KB PDF 举报

"keras学习率余弦退火CosineAnnealing"

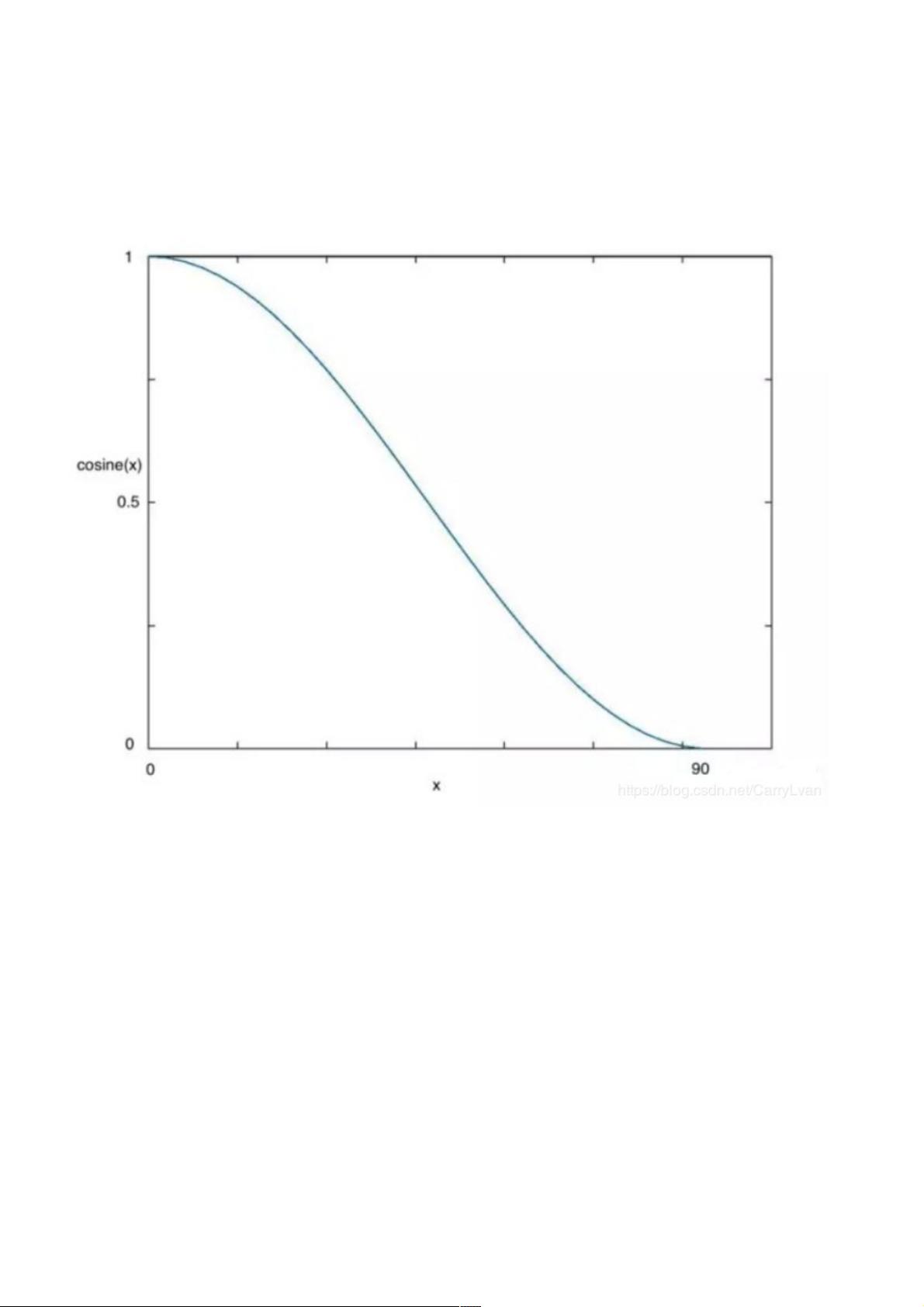

余弦退火(Cosine Annealing)是一种学习率调度策略,常用于深度学习模型的训练过程,旨在优化模型性能。它由《Stochastic Gradient Descent with Warm Restarts》论文提出,结合了余弦函数的特性与学习率调整,帮助模型避免过拟合并探索全局最优解。

1. 引言

在深度学习中,梯度下降是常用的优化算法,通过不断调整权重来最小化损失函数。当模型接近损失函数的全局最小值时,降低学习率可防止模型过度拟合。余弦退火策略模仿了余弦函数的形状,使得学习率随着迭代次数的增加呈周期性变化,从而达到平衡训练速度和模型收敛的目的。

2. 余弦退火的原理

余弦退火的核心思想是将学习率的变化与余弦函数联系起来。学习率 ηtηtηt 在每个周期(也称为run或restart)内按照以下公式变化:

ηt=ηmini+12(ηmaxi−ηmini)(1+cos(TcurTiπ))\eta_t=\eta_{min}^{i}+\frac{1}{2}(\eta_{max}^{i}-\eta_{min}^{i})(1+\cos(\frac{T_{cur}}{T_i}\pi))ηt=ηmini+21(ηmaxi−ηmini)(1+cos(TiTcurπ))

其中:

- ηtηtηt 是在当前迭代步 ttt 时刻的学习率。

- ηminiηmin_iηmini 和 ηmaxiηmax_iηmaxi 分别是当前周期的最小和最大学习率。

- TcurT_{cur}Tcur 是当前迭代步对应的周期内时间步。

- TiT_iTi 是整个周期的总时间步。

- π\piπ 是圆周率。

这个公式确保了学习率在每个周期开始时较高,然后逐渐减小,接近周期结束时再回升,形成一个类似于余弦波形的变化。

3. Keras实现

在Keras中,可以使用`tf.keras.optimizers.schedules.CosineDecay`或`tf.keras.optimizers.schedules.CosineDecayRestarts`来实现余弦退火。前者不包括重启机制,后者则包含重启功能,更接近于论文中的方法。用户需要指定初始学习率、周期长度、总迭代次数等参数来创建调度器,并将其与优化器相结合,例如:

```python

from tensorflow.keras.optimizers import SGD

from tensorflow.keras.optimizers.schedules import CosineDecay

initial_learning_rate = 0.1

decay_steps = 10000

optimizer = SGD(learning_rate=CosineDecay(initial_learning_rate, decay_steps))

```

4. 应用场景与优势

余弦退火学习率策略特别适用于需要长期训练且可能陷入局部最小值的复杂模型。它可以帮助模型跳出局部最优,探索更多可能的解决方案。此外,相比于线性衰减或指数衰减等其他学习率调度策略,余弦退火能够在保持训练效率的同时,更好地控制模型的收敛过程。

总结来说,余弦退火是一种有效的学习率调整策略,通过周期性地改变学习率,可以在深度学习训练过程中平衡模型的收敛速度和泛化能力,尤其适合处理多峰优化问题的模型。在Keras中,它可以通过简单的API调用来实现,方便地集成到训练流程中。

2021-05-01 上传

2022-04-13 上传

2020-11-01 上传

2024-10-26 上传

点击了解资源详情

2024-10-26 上传

2024-10-26 上传

点击了解资源详情

点击了解资源详情

weixin_38672807

- 粉丝: 9

- 资源: 923

最新资源

- JHU荣誉单变量微积分课程教案介绍

- Naruto爱好者必备CLI测试应用

- Android应用显示Ignaz-Taschner-Gymnasium取消课程概览

- ASP学生信息档案管理系统毕业设计及完整源码

- Java商城源码解析:酒店管理系统快速开发指南

- 构建可解析文本框:.NET 3.5中实现文本解析与验证

- Java语言打造任天堂红白机模拟器—nes4j解析

- 基于Hadoop和Hive的网络流量分析工具介绍

- Unity实现帝国象棋:从游戏到复刻

- WordPress文档嵌入插件:无需浏览器插件即可上传和显示文档

- Android开源项目精选:优秀项目篇

- 黑色设计商务酷站模板 - 网站构建新选择

- Rollup插件去除JS文件横幅:横扫许可证头

- AngularDart中Hammock服务的使用与REST API集成

- 开源AVR编程器:高效、低成本的微控制器编程解决方案

- Anya Keller 图片组合的开发部署记录