【调优学习率全攻略】: BP神经网络学习率调整技巧

发布时间: 2024-04-20 10:01:31 阅读量: 728 订阅数: 108

神经网络中学习率的奥秘:影响、调整与优化

# 1. 理解学习率在BP神经网络中的重要性

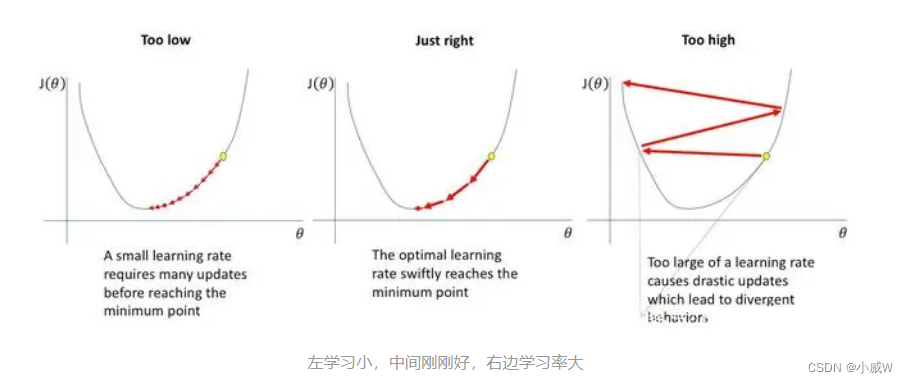

在BP神经网络中,学习率是一个至关重要的超参数,它决定了模型参数在每次迭代时更新的幅度。学习率过大可能导致震荡和不收敛,而学习率过小则会使得模型收敛速度缓慢,甚至陷入局部最优解。正确设置和调整学习率可以有效提高模型的训练效果,加快收敛速度,并避免训练过程中出现的问题。因此,深入理解学习率在BP神经网络中的作用和影响,对于训练高效、准确的神经网络模型至关重要。

# 2. BP神经网络基础知识

### 2.1 剖析BP神经网络结构

在深入学习BP神经网络之前,首先需要了解其基本结构。BP神经网络由输入层、隐藏层和输出层组成,每一层都包含多个神经元节点。让我们逐步剖析这些组成部分的作用:

#### 2.1.1 输入层、隐藏层和输出层的作用

- **输入层(Input Layer)**:输入层负责接收原始数据,并将数据传递给神经网络的下一层即隐藏层。每个输入神经元对应输入数据的一个特征。

- **隐藏层(Hidden Layer)**:隐藏层在神经网络中起着特征提取和数据转换的作用。隐藏层的神经元通过加权和偏置的计算,将输入数据进行非线性映射,从而得到更高级的特征表示。

- **输出层(Output Layer)**:输出层接收来自隐藏层的数据,在分类问题中负责输出预测值,回归问题中输出连续值。通过输出层的激活函数,最终得到神经网络的预测结果。

#### 2.1.2 权重和偏置的概念

- **权重(Weights)**:在神经网络中,每个神经元与上一层的神经元都有连接,这些连接上赋予了权重。权重决定了上一层神经元输出对当前神经元的影响程度,是神经网络中可以学习的参数之一。

- **偏置(Bias)**:偏置是神经元的一个常数项,可以看作是神经元激活函数的阈值。它的作用是对神经元的输入进行调整,从而影响神经元的激活状态。

这些元素共同构成了BP神经网络的基本结构,通过不断迭代训练,网络能够学习到输入数据的特征,并做出相应的预测。接下来,我们将深入了解反向传播算法,进一步探讨神经网络的学习过程。

# 3. 学习率调整方法

### 3.1 固定学习率的优缺点

固定学习率是最简单的学习率调整方法之一,它的优缺点需要我们深入了解和分析。

#### 3.1.1 学习率设置过大的影响

当学习率设置过大时,会导致模型在训练过程中发生震荡,甚至无法收敛到最优解。这种情况下,损失函数的值会出现大幅波动甚至不断增大,模型无法有效学习。

```python

# 代码示例:设置过大的学习率

learning_rate = 1.0 # 学习率设置过大

```

通过降低学习率可以有效避免这种情况,可以采用学习率衰减等方法来动态调整学习率,使模型更加稳定地学习。

#### 3.1.2 学习率设置过小的问题

相反地,如果学习率设置过小,模型参数更新缓慢,训练过程需要更长时间才能收敛到较好的结果。特别是在复杂数据集上,过小的学习率容易陷入局部最优解,难以达到全局最优解。

```python

# 代码示例:设置过小的学习率

learning_rate = 0.001 # 学习率设置过小

```

在实际应用中,要根据具体问

0

0