【BP神经网络解密】: 探秘基本原理及应用

发布时间: 2024-04-20 09:52:46 阅读量: 100 订阅数: 108

BP神经网络基本原理与应用.ppt

# 1. BP神经网络概述

BP神经网络(Back Propagation Neural Network)是一种按照误差反向传播算法训练的多层前馈神经网络。它通过不断调整网络参数来最小化预测输出与实际输出之间的误差,从而实现对复杂非线性关系的建模和学习能力。BP神经网络是深度学习的基础,应用广泛于图像识别、语音处理等领域。

在神经网络训练中,目标是最小化损失函数。调用梯度下降法来更新网络参数,不断优化模型以提高准确性。通过反向传播算法,从输出层逐层向前传播误差,再根据梯度信息更新权重和偏差,使得网络逐渐收敛到最优解。

本章将深入探讨BP神经网络的概念、工作原理及应用场景,为读者提供全面的基础知识。

# 2. 神经网络基础知识

人工神经网络(Artificial Neural Network,简称ANN)作为一种模拟人脑神经系统的计算模型,是深度学习的基础。在本章节中,我们将深入了解神经元模型和神经网络结构。

### 神经元模型

神经元是人工神经网络中的基本单元,可以模拟生物神经元的功能。常见的神经元模型包括感知器模型、Sigmoid神经元和激活函数。

#### 感知器模型

感知器是最简单的神经元模型,它接收多个输入信号,将它们与对应的权重相乘后求和,再加上偏置,通过激活函数处理后输出。其数学表达式为:

y = f(\sum_{i=1}^{n}(w_ix_i) + b)

其中,$w_i$ 是输入的权重,$x_i$ 是输入信号,$b$ 是偏置,$f$ 是激活函数。

#### Sigmoid神经元

Sigmoid神经元是一种常用的激活函数,将输入信号进行加权求和后通过 Sigmoid 函数进行处理,将输出值映射到 (0, 1) 的范围内。其数学表达式为:

\sigma(x) = \frac{1}{1+e^{-x}}

#### 激活函数

激活函数在神经网络中扮演着至关重要的角色,它引入了非线性因素,使得神经网络可以学习非线性关系。常见的激活函数包括 Sigmoid、ReLU、Tanh 等,不同的激活函数适用于不同的场景。

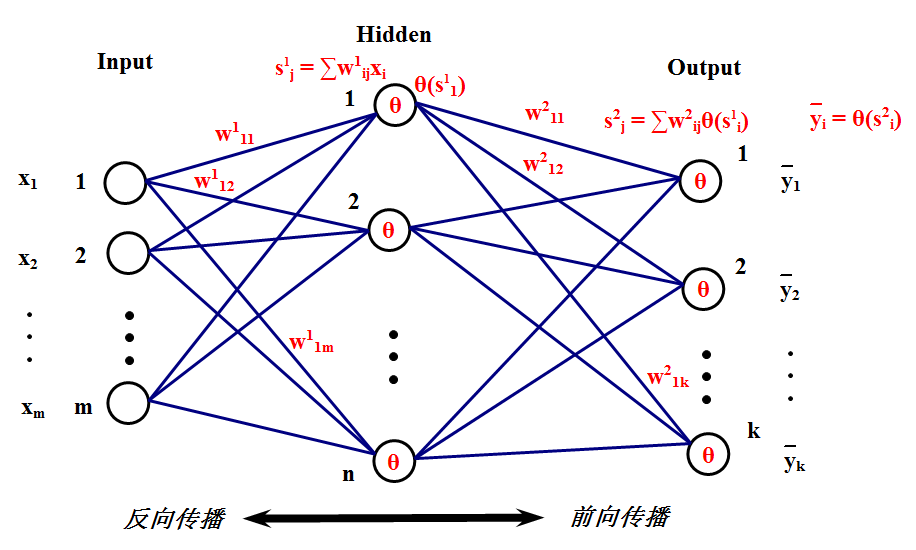

### 神经网络结构

神经网络的结构包括输入层、隐藏层和输出层。在本节中,我们将深入了解神经网络的结构以及前向传播和反向传播过程。

#### 输入层、隐藏层和输出层

- 输入层:负责接收外部输入数据,并将其传递给神经网络。

- 隐藏层:隐藏层位于输入层和输出层之间,负责处理输入数据并提取特征。

- 输出层:输出层负责生成网络的最终输出结果。

#### 前向传播

前向传播是指输入数据从输入层经过隐藏层传递到输出层的过程,神经网络通过前向传播计算得到预测结果。

#### 反向传播

反向传播是指通过计算损失函数对神经网络中的参数进行调整的过程,以减小预测结果与实际结果之间的差距。

在下一节中,我们将详细剖析 BP 神经网络的原理,深入探讨损失函数、优化算法以及参数更新过程。

# 3. BP神经网络原理剖析

### 3.1 损失函数及优化算法

在神经网络的训练过程中,损失函数扮演着至关重要的角色。损失函数的选择直接影响到模型的准确性和收敛速度。同时,为了最小化损失函数,需要使用优化算法来不断调整模型的参数,使得损失函数不断减小。

#### 3.1.1 损失函数类型

常见的损失函数包括均方误差(MSE)、交叉熵损失函数等。均方误差适用于回归问题,而交叉熵损失函数常用于分类问题。具体选择哪种损失函数取决于所解决的任务类型。

以下是一个简单的交叉熵损失函数的示例代码:

```python

def cross_entropy_loss(y_true, y_pred):

epsilon = 1e-10

y_pred = np.clip(y_pred, epsilon, 1. - epsilon)

N = y_pred.shape[0]

ce_loss = -np.sum(y_true * np.log(y_pred + 1e-9)) / N

return ce_loss

```

#### 3.1.2 梯度下降法

梯度下降法是一种常用的优化算法,用于最小化损失函数。通过计算损失函数对模型参数的梯度,然后沿着梯度的反方向更新参数,以达到损失函数最小化的目的。

下面是一个简单的梯度下降法的代码示例:

```python

def gradient_descent(param, learning_rate, grad):

param = param - learning_rate * grad

return param

```

#### 3.1.3 反向传播算法

反向传播算法是计算神经网络模型参数梯度的一种高效方法。在训练过程中,通过正向传播计算损失,然后反向传播梯度更新参数。

具体实现反向传播算法过程中,需要注意梯度的计算以及参数的更新方法,保证模型能够收敛到最优解。

### 3.2 参数更新

在神经网络训练中,参数的更新是通过不断迭代模型的参数,使得模型逐渐收敛到最优解。

#### 3.2.1 权重更新

权重更新是神经网络中最重要的部分之一。通过计算梯度,可以更新神经网络中的权重,以使得模型更好地拟合数据。

以下是一个简单的权重更新的代码示例:

```python

def update_weights(weights, gradients, learning_rate):

updated_weights = weights - learning_rate * gradients

return updated_weights

```

#### 3.2.2 偏差更新

除了权重更新外,偏差的更新也是神经网络中的关键步骤。偏差通常起到调整模型拟合能力的作用,通过更新偏差可以进一步优化模型的性能。

```python

def update_bias(bias, gradients, learning_rate):

updated_bias = bias - learning_rate * gradients

return updated_bias

```

通过以上对神经网络训练过程中损失函数、优化算法、参数更新的剖析,我们能更深入地理解神经网络的训练原理和优化过程。神经网络的训练是一个迭代不断优化模型参数的过程,通过合理选择损失函数和优化算法,并正确更新参数,我们可以训练出性能优秀的神经网络模型。

# 4. BP神经网络应用场景分析

在前面几章,我们已经了解了BP神经网络的基本概念、原理和训练方法。接下来,让我们深入探讨BP神经网络在实际应用中的各种场景,从语音识别到图像识别,看看神经网络是如何在不同领域展现出强大的应用价值的。

### 4.1 语音识别

语音识别是一项被广泛应用的技术,它可以帮助我们将口头语言转换为文字信息,实现自动语音转文字。而BP神经网络正是在这个领域中大放异彩,下面我们将探讨语音识别中两个重要的应用场景。

#### 4.1.1 声纹识别

声纹识别是一种利用个人的声音特征进行身份识别的技术。通过采集个人的语音特征,BP神经网络可以学习和提取声纹中的独特信息,从而实现声纹的准确识别。在声纹识别领域,BP神经网络被广泛应用于安全认证、门禁系统等场景。

#### 4.1.2 语音合成

语音合成是指通过计算机生成人类语音的过程。BP神经网络能够学习语音的声音模式和语调特征,通过合成算法生成自然流畅的语音输出。在语音合成应用中,BP神经网络的应用使得人机交互更加智能和自然。

### 4.2 图像识别

图像识别是机器视觉领域的重要应用,它可以帮助计算机理解和识别图像中的内容,从而实现图像分类、物体检测等任务。下面让我们看看BP神经网络在图像识别中的两个典型应用场景。

#### 4.2.1 物体识别

物体识别是指识别图像中不同物体的类别和位置信息。BP神经网络通过学习大量标注的图像数据,可以准确地识别图像中的各种物体,实现自动化的物体识别和分类。在自动驾驶、工业检测等领域,物体识别技术已经发挥着重要作用。

#### 4.2.2 人脸识别

人脸识别是将摄像头捕获到的人脸图像与数据库中的人脸信息进行匹配识别的技术。BP神经网络在人脸识别中表现出色,能够对人脸特征进行准确提取和匹配,实现高效的人脸辨识。在安防监控、人脸支付等场景中,人脸识别技术已经得到广泛应用。

通过以上的应用场景分析,我们可以看到BP神经网络在语音识别和图像识别领域具有广阔的应用前景和深远的影响力。神经网络的强大学习能力和表示能力使得它成为处理复杂信息任务的重要工具,为人工智能技术的发展注入了持续的动力。

# 5. BP神经网络实践指南

### 5.1 数据预处理

在实践中,对数据进行预处理是非常重要的一步,它可以提高模型的性能和收敛速度。

#### 5.1.1 数据标准化

数据标准化是将数据按照一定的标准进行处理,使得数据具有统一的分布特性,有利于神经网络的训练和收敛。

```python

# 数据标准化代码示例

from sklearn.preprocessing import StandardScaler

scaler = StandardScaler()

X_train_scaled = scaler.fit_transform(X_train)

X_test_scaled = scaler.transform(X_test)

```

#### 5.1.2 数据增强

数据增强是通过对原始数据进行一定的变换和扩充,生成更多的训练样本,从而提高模型的泛化能力。

```python

# 数据增强示例:图像水平翻转

from keras.preprocessing.image import ImageDataGenerator

datagen = ImageDataGenerator(horizontal_flip=True)

datagen.fit(X_train)

```

### 5.2 网络构建与训练

神经网络的构建和训练是实践中最核心的部分,它包括选择模型结构、确定超参数以及进行训练和优化过程。

#### 5.2.1 模型选择

在构建神经网络时,需要选择合适的层数、节点数以及激活函数等,以适应具体的问题和数据特点。

```python

# 神经网络模型构建示例

model = Sequential()

model.add(Dense(128, input_shape=(input_dim,), activation='relu'))

model.add(Dense(64, activation='relu'))

model.add(Dense(output_dim, activation='softmax'))

```

#### 5.2.2 学习率调整

学习率是训练过程中需要调整的关键超参数之一,合适的学习率可以加快模型收敛速度并提高训练效果。

```python

# 学习率调整示例:使用学习率衰减

from keras.callbacks import ReduceLROnPlateau

reduce_lr = ReduceLROnPlateau(monitor='val_loss', factor=0.2, patience=5, min_lr=0.001)

```

### 5.3 模型评估与优化

在训练完成后,需要对模型进行评估和优化,以确保模型具有良好的泛化能力和性能表现。

#### 5.3.1 混淆矩阵分析

混淆矩阵是用于评估分类模型性能的重要工具,可以帮助了解模型的准确率、召回率等指标。

```python

# 混淆矩阵分析示例

from sklearn.metrics import confusion_matrix

y_pred = model.predict(X_test)

cm = confusion_matrix(y_true, y_pred)

```

#### 5.3.2 学习曲线观察

学习曲线可以帮助我们分析模型的训练过程,了解模型的收敛情况和是否出现过拟合或欠拟合等问题。

```python

# 学习曲线观察示例

import matplotlib.pyplot as plt

plt.plot(history.history['loss'], label='train_loss')

plt.plot(history.history['val_loss'], label='val_loss')

plt.legend()

plt.show()

```

0

0