【模型压缩与加速探究】: BP神经网络效率提升策略

发布时间: 2024-04-20 10:24:22 阅读量: 136 订阅数: 108

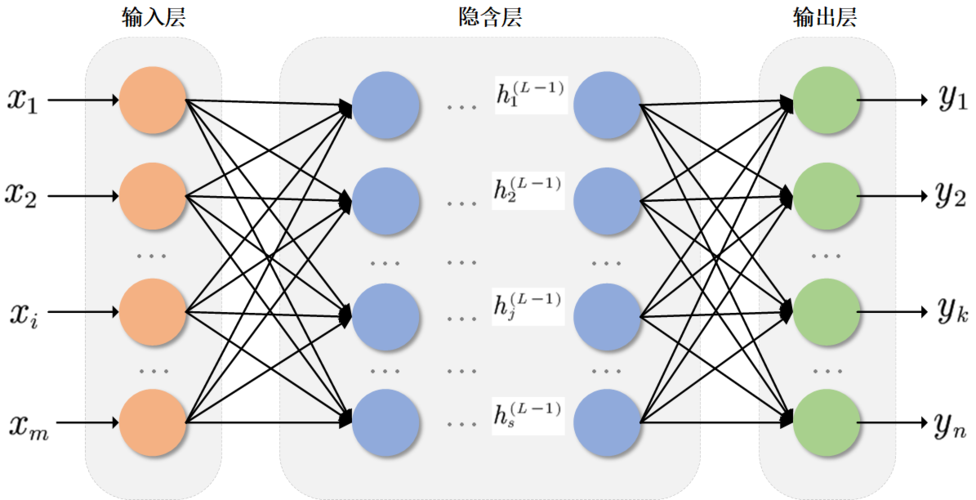

# 1. BP神经网络简介

神经网络是一种模仿人脑神经元连接方式构建的计算模型,其中最典型的神经网络就是BP神经网络(Back Propagation neural network)。BP神经网络通过前向传播计算输出,再通过反向传播调整权重,以不断优化网络结构,实现对复杂问题的学习和预测。其训练过程是通过不断迭代,将网络输出与真实标签进行比较,通过计算损失函数来更新参数,直到达到满意的精度和性能。BP神经网络广泛应用于分类、回归等各种领域,是深度学习的基础算法之一。

# 2. 神经网络模型压缩技术

神经网络模型压缩技术是指通过一系列算法和策略,减少神经网络模型的大小和计算复杂度,从而实现在保持较高性能的同时减少计算资源消耗的目的。本章将深入介绍神经网络模型压缩技术的三种主要方法:神经网络剪枝、权重共享和知识蒸馏。

### 2.1 神经网络剪枝

神经网络剪枝是一种常用的模型压缩方法,通过去除网络中的冗余连接和参数来减小网络规模。具体包括以下步骤。

#### 2.1.1 剪枝策略

剪枝策略主要包括结构化剪枝和非结构化剪枝。结构化剪枝指的是只能剪掉整个通道或过滤器,而非结构化剪枝可以对参数进行逐个剪枝。

#### 2.1.2 剪枝算法实现

常见的剪枝算法有L1正则化、迭代剪枝法等。以L1正则化为例,通过对参数添加L1正则项来实现剪枝。

```python

# 使用L1正则化实现剪枝

prune_model = tf.keras.models.Sequential([

tf.keras.layers.Dense(256, activation='relu', kernel_regularizer=tf.keras.regularizers.l1(0.01)),

tf.keras.layers.Dense(10, activation='softmax')

])

```

#### 2.1.3 剪枝后的网络性能评估

剪枝后需要对网络性能进行评估,包括准确率、推理速度等指标。可以通过测试集进行评估比较剪枝前后的性能差异。

### 2.2 权重共享

权重共享是指多个神经元共享同一份参数,以减少模型中不必要的参数冗余,从而降低模型复杂度。

#### 2.2.1 共享策略

常见的共享策略有局部共享和全局共享。局部共享指在局部范围内共享权重,全局共享则是整个网络共享权重。

#### 2.2.2 共享算法实现

共享算法的实现涉及参数共享的定义和训练过程中的更新方法。以下是一个简单示例:

```python

# 全连接层参数共享示例

shared_layer = tf.keras.layers.Dense(64, activation='relu')

```

#### 2.2.3 共享权重对网络效率的影响

共享权重可以减少模型的参数量和计算量,但同时也会影响模型的表达能力和泛化性能。需要在效率和性能之间做权衡。

### 2.3 知识蒸馏

知识蒸馏通过将一个复杂网络的知识“传输”到一个简单网络中,来提高简单网络的性能,同时减少参数量。

#### 2.3.1 蒸馏方法概述

蒸馏方法包括软标签生成、蒸馏损失设计等。软标签是指使用复杂模型的输出作为标签,而不是原始数据的标签。

#### 2.3.2 蒸馏实践案例分析

在实践中,可以将复杂模型的输出作为软标签,训练简单模型以拟合这些软标签。这样简单模型就能够获得复杂模型的“知识”。

#### 2.3.3 蒸馏后的网络性能对比

通过对比蒸馏前后简单模型的性能表现,可以看出知识蒸馏的效果。通常情况下,蒸馏后的模型在性能上有所提升,同时具有较小的模型体积。

# 3. 神经网络加速技术

神经网络的训练和推理过程需要大量计算资源,而神经网络加速技术旨在提高神经网络的计算效率和速度。本章将介绍神经网络加速技术中的硬件加速和算法加速两个方面。

### 3.1 硬件加速

神经网络的加速可以通过硬件设备来实现,常见的硬件加速器包括GPU、FPGA和ASIC。不同的硬件加速器在加速神经网络计算中各有优劣,下面将逐一介绍它们的应用。

#### 3.1.1 GPU加速

GPU在深度学习领域得到广泛应用,其强大的并行计算能力使得神经网络的训练速度得到显著提升。主要由CUDA和OpenCL等框架来支持GPU加速神经网络的计算,下面简要介绍GPU加速的优势和适用场景。

优势:

- 并行计算能力强,适合大规模数据的训练。

- 易于使用和部署,训练过程相对简单。

- 成本适中,适合中小型团队和研究机构。

应用场景:

- 图像识别、语音识别等大规模数据处理任务。

- 需要快速训练和实验迭代的场景。

```python

# 使用CUDA加速神经网络训练

import torch

if torch.cuda.is_available():

device = torch.device("cuda")

# 将模型移动到GPU上

model.to(device)

# 训练过程中使用GPU加速

for data in train_loader:

inputs, labels = data[0].to(device), data[1].to(device)

optimizer.zero_grad()

outputs = model(inputs)

loss = loss_function(output

```

0

0