企业数据集成:ETL技术详解与关键应用

40 浏览量

更新于2024-08-27

收藏 174KB PDF 举报

面向数据集成的ETL技术研究主要探讨了在现代企业环境中如何有效地整合和管理来自不同源头、格式各异的数据,以促进全面的数据共享和提升商务智能。数据集成是企业数据仓库和商务智能系统的核心组成部分,它解决了由于信息系统孤岛导致的冗余数据和工作效率降低的问题。

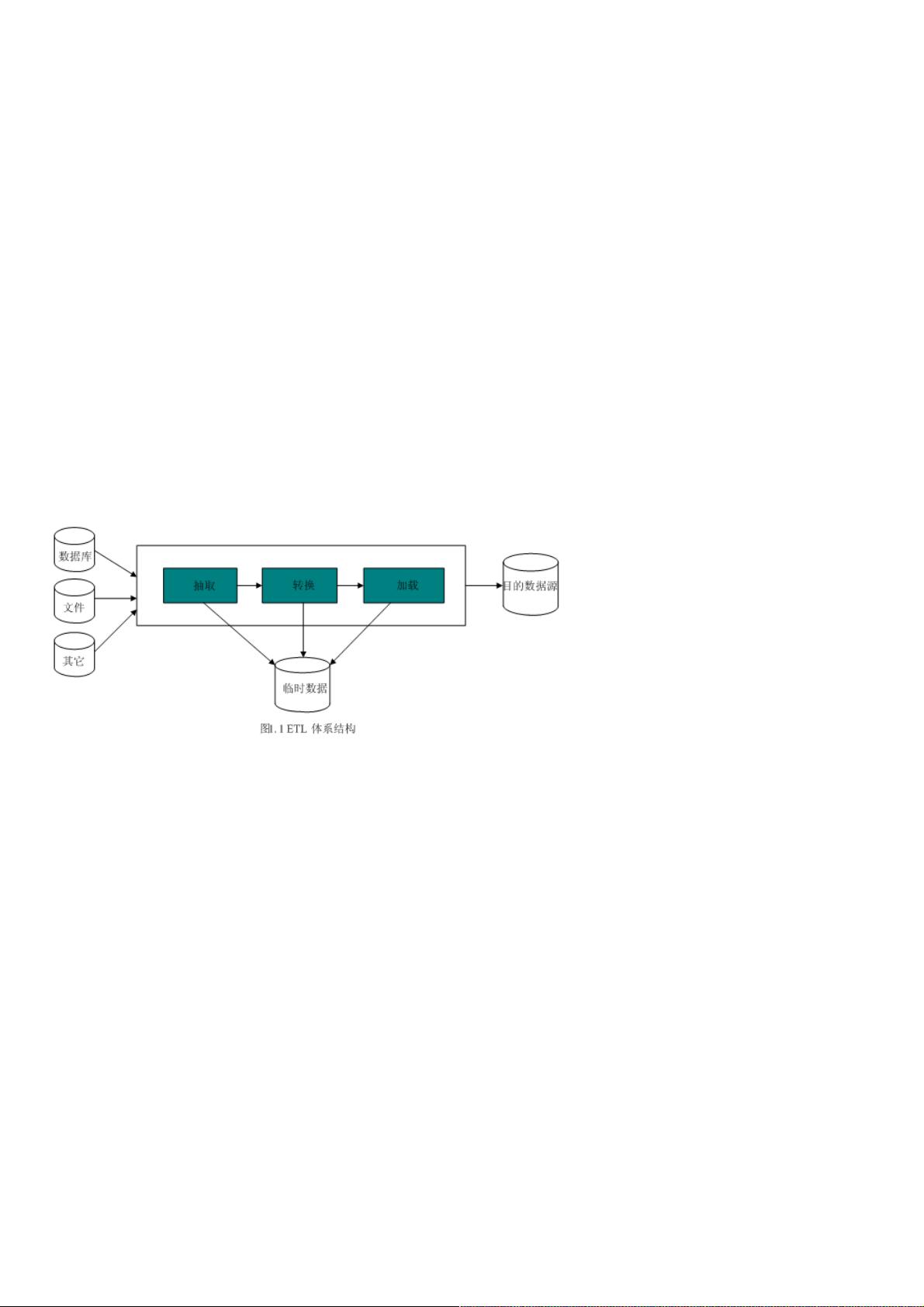

ETL(Extract, Transform, Load)是一个关键概念,它包括三个核心步骤:(1) 数据抽取,即从原始数据源系统中提取所需的数据;(2) 数据转换,对提取的数据进行清洗、格式调整和异常处理,确保数据的一致性和准确性;(3) 数据加载,将处理过的数据准确无误地存入目标数据存储系统,如数据仓库或数据集市。最初,ETL主要用于构建数据仓库的过程,但现在也被广泛应用于企业日常的信息系统中,处理数据迁移、交换和同步任务。

在实施ETL过程中,面临的主要挑战是数据的多样性和质量问题。由于数据来源不同,可能存在格式不一致、数据质量低下等问题,这要求ETL技术必须具备高度的灵活性和适应性,能够处理各种数据类型和清洗复杂的数据。为了克服这些挑战,ETL技术通常依赖于先进的数据清洗工具、元数据管理和ETL工具集,它们能够自动化数据处理流程,提高效率并减少人为错误。

ETL的关键技术包括数据抽取工具的选择,如SQL查询、API抓取或专门的数据抽取软件;数据转换工具,如ETL工具包、编程语言(如Python或Java)编写的脚本,以及数据质量检查算法;以及数据加载工具,如数据库连接器或数据湖技术。此外,ETL还需要与数据仓库设计原则相结合,比如星型或雪花模型,以优化数据存储和查询性能。

在企业应用集成(EAI)的大背景下,ETL技术的重要性进一步凸显,它作为数据集成的核心手段,有助于构建一个高效、统一的数据环境,支持决策制定和业务分析,从而提升企业的竞争力。然而,随着大数据、云计算和人工智能的发展,未来的ETL技术可能会更加智能化,利用机器学习和人工智能自动优化数据处理过程,实现数据集成的自动化和智能化。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-08-09 上传

2010-09-12 上传

2021-08-08 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

weixin_38628647

- 粉丝: 3

- 资源: 968