深度学习优化:梯度下降算法详解与应用

需积分: 1 186 浏览量

更新于2024-08-03

收藏 606KB PDF 举报

"《梯度下降优化算法概述》是一篇深入探讨人工智能领域的论文,着重于介绍和解析梯度下降这一核心优化算法。尽管在深度学习和机器学习中被广泛应用,但人们对其工作原理的理解常常停留在表面,缺乏全面而深入的认识。作者Sebastian Ruder旨在通过这篇文章,提供读者对不同梯度下降变种行为的直观理解,帮助他们更有效地运用这一工具。

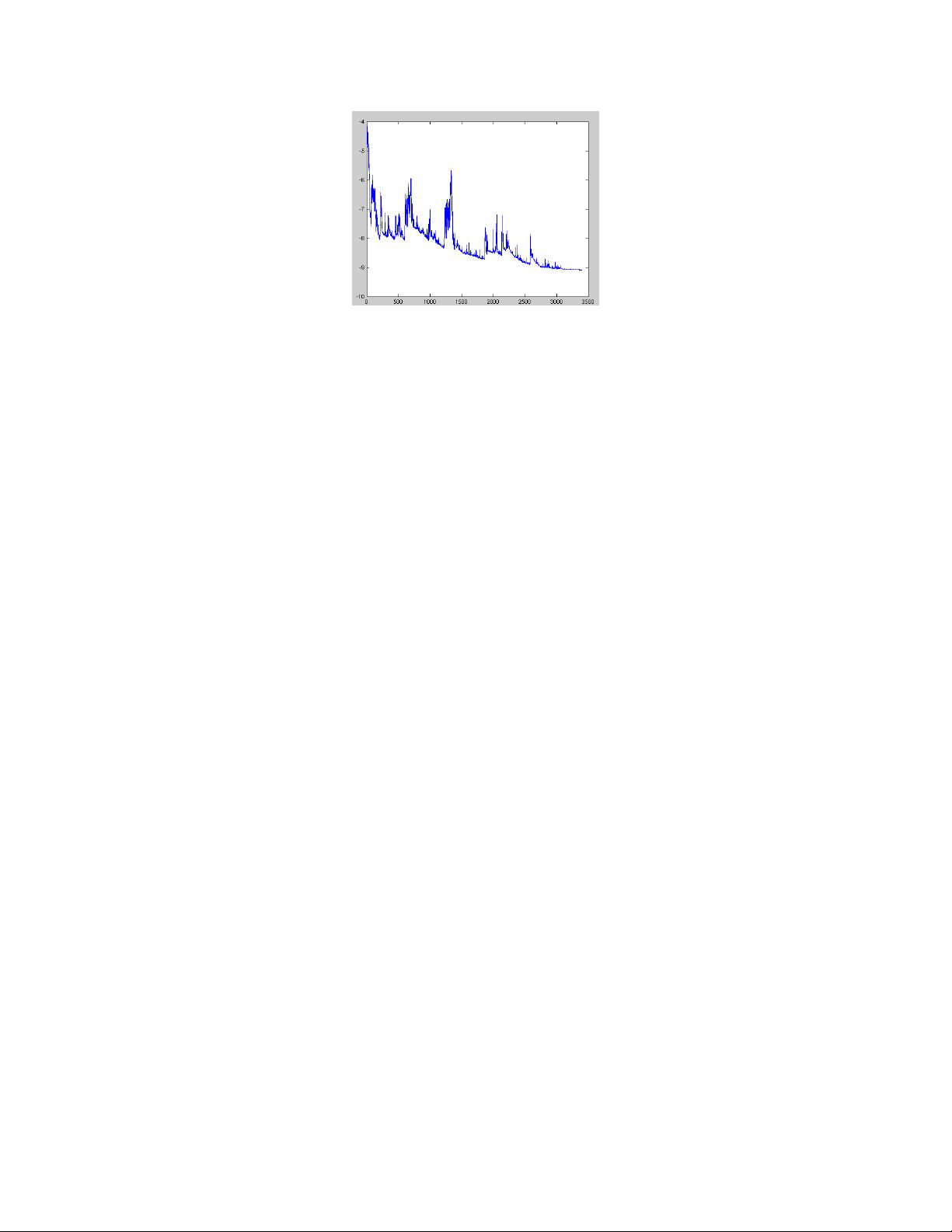

文章首先定义了梯度下降的基本概念,它是一种迭代优化方法,通过沿着函数曲面的负梯度方向逐步调整参数,以最小化损失函数。在实际应用中,它在神经网络训练中的地位无可替代,如Lasagne、Caffe和Keras等深度学习库都提供了丰富的梯度下降算法实现。

接下来,作者详细分析了梯度下降的几种变体,包括批量梯度下降(Batch Gradient Descent)、随机梯度下降(Stochastic Gradient Descent)和小批量梯度下降(Mini-batch Gradient Descent),分别阐述了它们在处理大量数据时的速度与精度平衡。每种方法都有其适用场景,理解这些差异有助于选择最合适的优化策略。

此外,论文还探讨了在并行和分布式环境中优化梯度下降的方法,这是随着硬件发展和大数据需求增加的重要课题。通过并行计算,可以显著减少优化时间,而分布式方法则能处理更大规模的问题,如在多台计算机或GPU上协同工作。

文中还提到了常见的优化算法,如动量法(Momentum)、自适应学习率方法(如Adagrad、RMSprop和Adam)以及Nesterov加速梯度(Nesterov Accelerated Gradient)。这些算法旨在解决梯度下降过程中的问题,如局部最优、收敛速度慢等,提升模型的性能。

最后,论文还讨论了额外的优化策略,比如正则化技术(如L1和L2正则化)以防止过拟合,以及早停策略(Early Stopping)来控制训练的停止条件。这些策略与梯度下降一起,构成了深度学习模型优化的完整框架。

《梯度下降优化算法概述》这篇论文不仅梳理了梯度下降的基本原理,还涵盖了其实现中的挑战、各种变体的比较、并行与分布式优化,以及如何通过附加策略改进算法性能。对于希望深入了解和实践梯度下降优化的人来说,这是一份极具价值的参考资源。"

2019-04-06 上传

2018-03-11 上传

2020-05-27 上传

2023-06-06 上传

点击了解资源详情

点击了解资源详情

112 浏览量

2020-07-03 上传

2019-10-08 上传

UnknownToKnown

- 粉丝: 1w+

- 资源: 773

最新资源

- ES管理利器:ES Head工具详解

- Layui前端UI框架压缩包:轻量级的Web界面构建利器

- WPF 字体布局问题解决方法与应用案例

- 响应式网页布局教程:CSS实现全平台适配

- Windows平台Elasticsearch 8.10.2版发布

- ICEY开源小程序:定时显示极限值提醒

- MATLAB条形图绘制指南:从入门到进阶技巧全解析

- WPF实现任务管理器进程分组逻辑教程解析

- C#编程实现显卡硬件信息的获取方法

- 前端世界核心-HTML+CSS+JS团队服务网页模板开发

- 精选SQL面试题大汇总

- Nacos Server 1.2.1在Linux系统的安装包介绍

- 易语言MySQL支持库3.0#0版全新升级与使用指南

- 快乐足球响应式网页模板:前端开发全技能秘籍

- OpenEuler4.19内核发布:国产操作系统的里程碑

- Boyue Zheng的LeetCode Python解答集