决策树与随机森林详解:从原理到Python实现

20 浏览量

更新于2024-08-28

收藏 555KB PDF 举报

"决策树与随机森林"

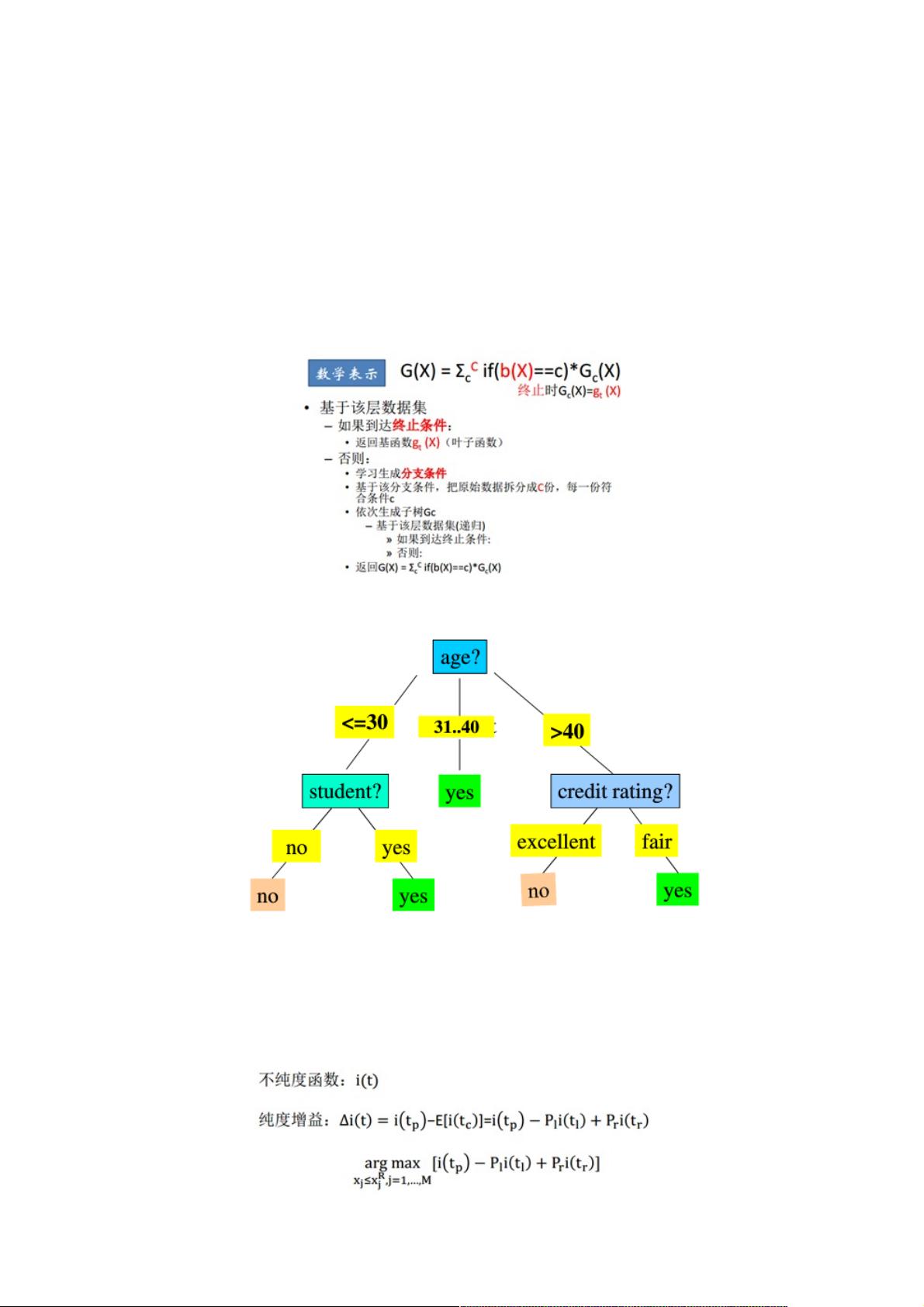

决策树是一种监督学习算法,常用于分类和回归问题。它通过构建一系列规则来做出决策,这些规则基于输入数据的特征。与线性模型不同,决策树不是通过所有特征的加权组合来预测结果,而是通过一系列条件判断(即特征的分割)来逐步划分数据集,直到达到预设的终止条件。

在决策树的生成过程中,关键概念包括根节点、父节点、子节点和叶节点。根节点代表整个数据集,父节点对应一个特征的选择,子节点是基于该特征的不同取值划分出的数据子集,而叶节点则表示最终的分类或预测结果。决策树的生成目标是找到最优的特征和分割点,使得数据集的纯度最大化或者不纯度最小化。

纯度通常由不同的指标来度量,如信息熵、信息增益、信息增益率和基尼指数。ID3算法使用信息增益,C4.5算法采用信息增益率,而CART(Classification And Regression Tree)算法使用基尼系数。在建树过程中,算法会遍历所有特征并选择能带来最大纯度提升的特征作为分割点。之后,数据集会根据该特征的不同取值进一步分割,这个过程不断重复,直到满足停止条件,如达到预设的最大深度、最小样本数或者节点纯度阈值。

剪枝是防止过拟合的重要步骤,它通过去掉部分分支来简化模型。预剪枝是在树构建过程中提前设定停止条件,如达到预定的最小叶子节点样本数;后剪枝则是在树完全构建后,从底部开始删除不会显著降低模型性能的分支。

随机森林是决策树的集成学习版本,通过构建多个决策树并取其平均结果来提高模型的稳定性和预测准确性。在随机森林中,每个树都是独立生成的,通常在每次分裂时只考虑特征子集,并且每个树都会随机采样一部分数据(袋外数据)进行训练。这样可以减少树之间的相关性,增加多样性,从而提升整体模型的泛化能力。

在Python中,可以使用`scikit-learn`库来实现决策树和随机森林的训练与预测。`sklearn.tree.DecisionTreeClassifier`和`sklearn.ensemble.RandomForestClassifier`是常用的类,它们提供了丰富的参数调整选项,以适应各种不同的问题和数据集。

决策树和随机森林因其直观性、可解释性和良好的性能,成为了机器学习中非常受欢迎的工具。它们可以处理非线性关系,适用于特征间存在交互效应的情况,并且对于缺失值有一定的鲁棒性。然而,决策树容易过拟合,随机森林则通过集成方法有效缓解了这一问题,提高了模型的泛化性能。

2021-09-23 上传

2022-08-08 上传

2021-09-11 上传

2021-09-10 上传

2023-02-08 上传

点击了解资源详情

点击了解资源详情

2023-04-22 上传

weixin_38609401

- 粉丝: 5

- 资源: 936

最新资源

- scratchduino-blockly:基于Blockly的ScratchDuino机器人构建套件的可视化编程编辑器

- Java六角结构

- damassh

- rpi-garage-door:树莓派自动车库门控制器

- weex-native-directive:Weex本机指令设计

- Linux驱动开发:Linux内核模块、字符设备驱动、IO模型、设备树、GPIO子系统、中断子系统.zip

- نوسان-crx插件

- yifanchen0811.github.io

- rails-infinite-scroll-posts

- WebServiceProj:这是测试 Web 服务项目。 Spring Data Mongo,泽西岛 JAX-RX

- java web期末考核

- radiopadre:(无线电)Python天文学数据缩减审查员

- everyplay-unity-sdk:Everyplay Unity插件

- grunt-contrib-copy:复制文件和文件夹

- Công cụ đặt hàng Aliviet-crx插件

- paperspeaker.github.io