有赞搜索系统:架构演进与挑战

194 浏览量

更新于2024-08-28

收藏 268KB PDF 举报

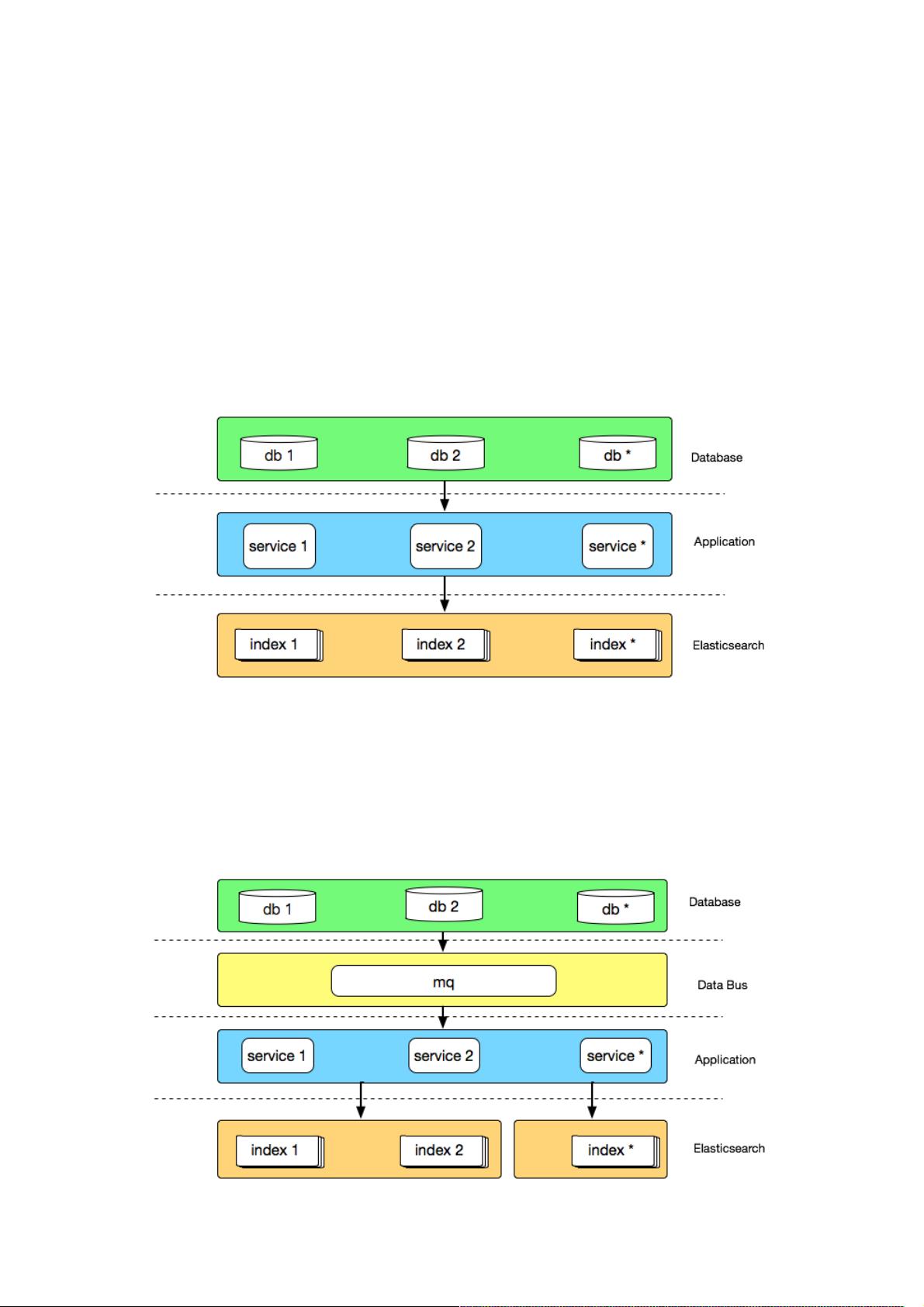

有赞搜索系统的架构演进是一个逐步优化的过程,从早期的挑战到后来的解决方案,体现了技术团队对高效、稳定和可扩展性的追求。最初的架构1.0主要依赖于Elasticsearch集群,该集群由几台高性能虚拟机组成,用于商品和粉丝索引的数据同步。数据通过Canal从数据库实时推送至Elasticsearch,这种架构在业务规模较小的情况下易于部署,但存在明显的局限性。

首先,单体同步应用与业务库紧密耦合,不适应快速变化的数据库结构调整,如库迁移或分库分表,这可能导致性能瓶颈和维护困难。其次,未做物理隔离的Elasticsearch集群在面对大规模数据时,如粉丝促销期间,容易因内存溢出导致服务中断。

为了解决这些问题,有赞搜索团队引入了架构2.0。这一版本的核心改进是引入了数据总线,通过消息队列MQ将数据变更通知给同步应用,实现了与业务数据库的解耦。这样不仅降低了对数据库性能的影响,还避免了多实例监听同一个表的资源浪费。数据总线的设计使得系统更加灵活,能够适应不断变化的业务需求。

随着业务的扩展和复杂性提升,有赞搜索平台引入了高级搜索功能(AdvancedSearch),以满足对搜索结果进行精细化控制的需求。这涉及到对用户行为、产品属性等多维度信息的处理,使得搜索结果更具针对性,提升了用户体验。

此外,有赞搜索团队还专注于平台的性能优化、可扩展性和可靠性,致力于降低运维成本和业务开发成本,确保系统的长期稳定运行。他们在选择基础引擎时,考虑到了Elasticsearch的技术成熟度和活跃的社区支持,但在实际应用中,根据业务需求不断调整和优化架构,以应对不断增长的数据量和多样化检索需求。

有赞搜索系统的架构演进是一个不断迭代、学习和适应的过程,它反映了技术团队对于解决实际业务挑战和提升整体搜索服务效能的深入思考。通过不断的技术革新和实践经验,有赞搜索平台得以支持上百个检索业务,服务着近百亿的数据量,为公司的各项内部搜索应用提供了强大且灵活的支持。

2018-09-30 上传

2018-11-19 上传

2023-12-04 上传

2023-08-02 上传

2023-06-09 上传

2024-01-25 上传

2023-05-15 上传

2023-10-26 上传

2023-09-06 上传

weixin_38688550

- 粉丝: 7

- 资源: 912

最新资源

- 十种常见电感线圈电感量计算公式详解

- 军用车辆:CAN总线的集成与优势

- CAN总线在汽车智能换档系统中的作用与实现

- CAN总线数据超载问题及解决策略

- 汽车车身系统CAN总线设计与应用

- SAP企业需求深度剖析:财务会计与供应链的关键流程与改进策略

- CAN总线在发动机电控系统中的通信设计实践

- Spring与iBATIS整合:快速开发与比较分析

- CAN总线驱动的整车管理系统硬件设计详解

- CAN总线通讯智能节点设计与实现

- DSP实现电动汽车CAN总线通讯技术

- CAN协议网关设计:自动位速率检测与互连

- Xcode免证书调试iPad程序开发指南

- 分布式数据库查询优化算法探讨

- Win7安装VC++6.0完全指南:解决兼容性与Office冲突

- MFC实现学生信息管理系统:登录与数据库操作