ReLU激活函数:深度学习中的简单与美

需积分: 0 19 浏览量

更新于2024-08-05

收藏 1.5MB PDF 举报

"ReLU激活函数在深度神经网络中的应用与优势"

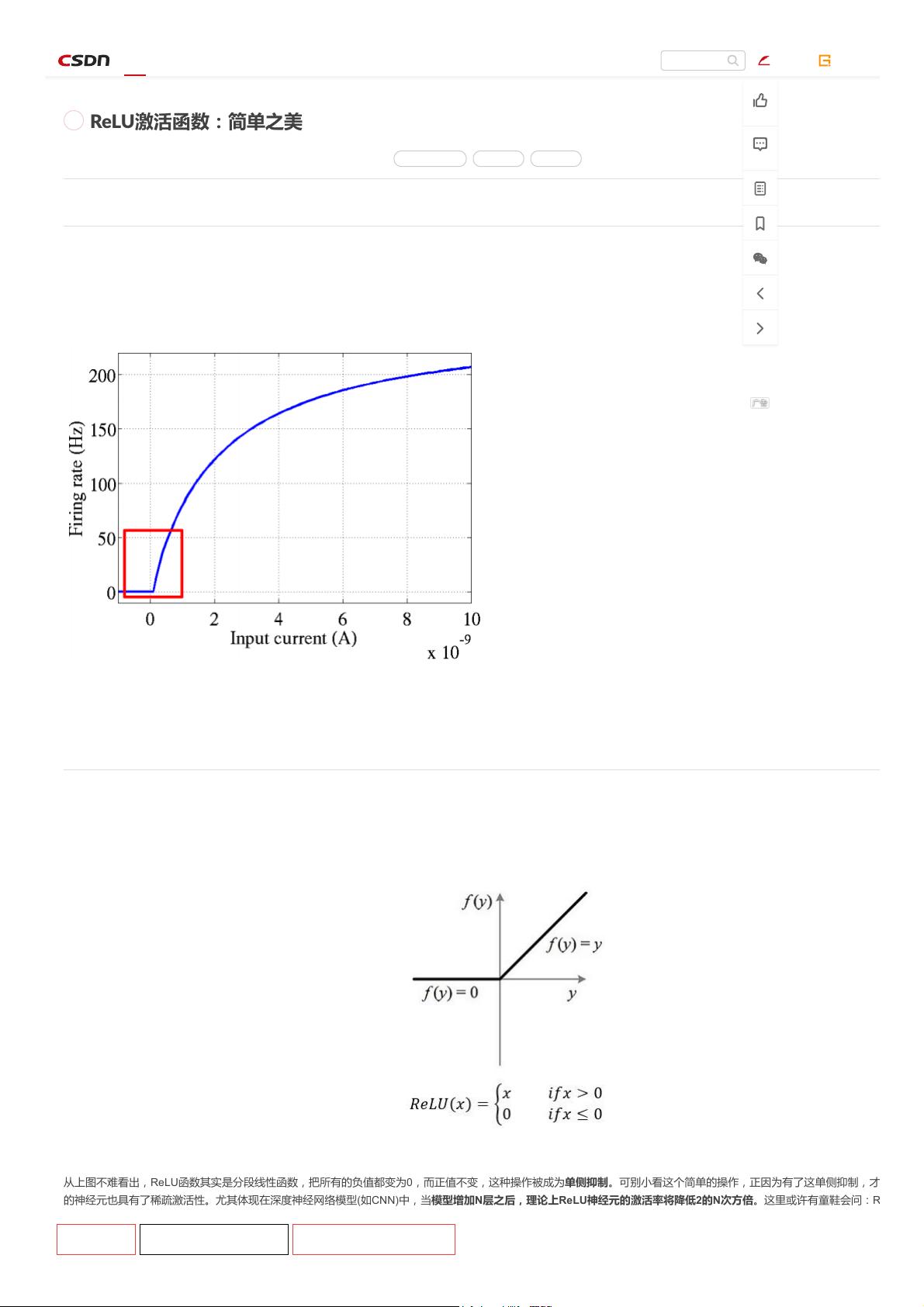

ReLU(修正线性单元)激活函数是神经网络中常用的一种非线性函数,尤其在深度学习领域扮演着重要角色。它由生物神经元的工作机制启发,模拟了神经元在接受信号时的激活模式。ReLU的数学表达式非常简洁,它在x<0时输出0,在x>=0时输出x,这种分段线性的特性赋予了它独特的优点。

1. 稀疏性:ReLU的一个关键特征是它的单侧抑制,即负值部分被截断为0。这种行为在神经网络中引入了稀疏性,意味着在网络的深度增加时,理论上神经元的激活率会显著降低。这有助于减少神经元之间的冗余,提高计算效率,并可能有助于模型的泛化能力。

2. 避免梯度消失:相比于sigmoid和tanh等饱和型激活函数,ReLU在正区间内的梯度恒为1,避免了梯度消失问题。这在训练深层网络时至关重要,因为梯度消失可能导致深层神经元的权重无法得到有效的更新,从而影响网络的训练效果。

3. 计算效率:ReLU的计算简单,没有复杂的指数运算,因此在大规模神经网络中可以显著提高计算速度。

4. 变种形式:虽然ReLU的基本形式是x >= 0时输出x,x < 0时输出0,但还有其他的变种,比如Leaky ReLU和参数化ReLu (PReLU),它们在负区间内不是完全零,而是具有一个小的斜率,以解决ReLU的“死亡ReLU”问题。死亡ReLU是指某些ReLU神经元可能会因为长期处于负区间的输入而永久性地停止学习。

5. 生物学解释:ReLU的设计灵感来源于神经科学,它的形状被认为更接近生物神经元的实际工作模式,尽管这并不是其设计的必要条件,更多的是为了帮助理解和解释其功能。

在实际应用中,ReLU已成为许多深度学习模型(如卷积神经网络CNN)的首选激活函数,它能够有效提升模型的性能和训练速度。然而,ReLU也并非完美无缺,例如在训练初期可能会遇到“死亡ReLU”问题,即某些神经元可能永远不会被激活,这需要通过调整学习率、初始化策略或使用变种形式来缓解。

ReLU激活函数以其简单而强大的特性,极大地推动了深度学习的发展,使得构建和训练深层神经网络变得更加可行和高效。在人工智能领域,尤其是神经网络的设计和优化中,理解并掌握ReLU的原理和作用至关重要。

367 浏览量

229 浏览量

189 浏览量

289 浏览量

点击了解资源详情

321 浏览量

369 浏览量

438 浏览量

2023-05-10 上传