Logistic Regression: 极大似然选择与sigmoid函数解析

需积分: 0 115 浏览量

更新于2024-08-05

收藏 410KB PDF 举报

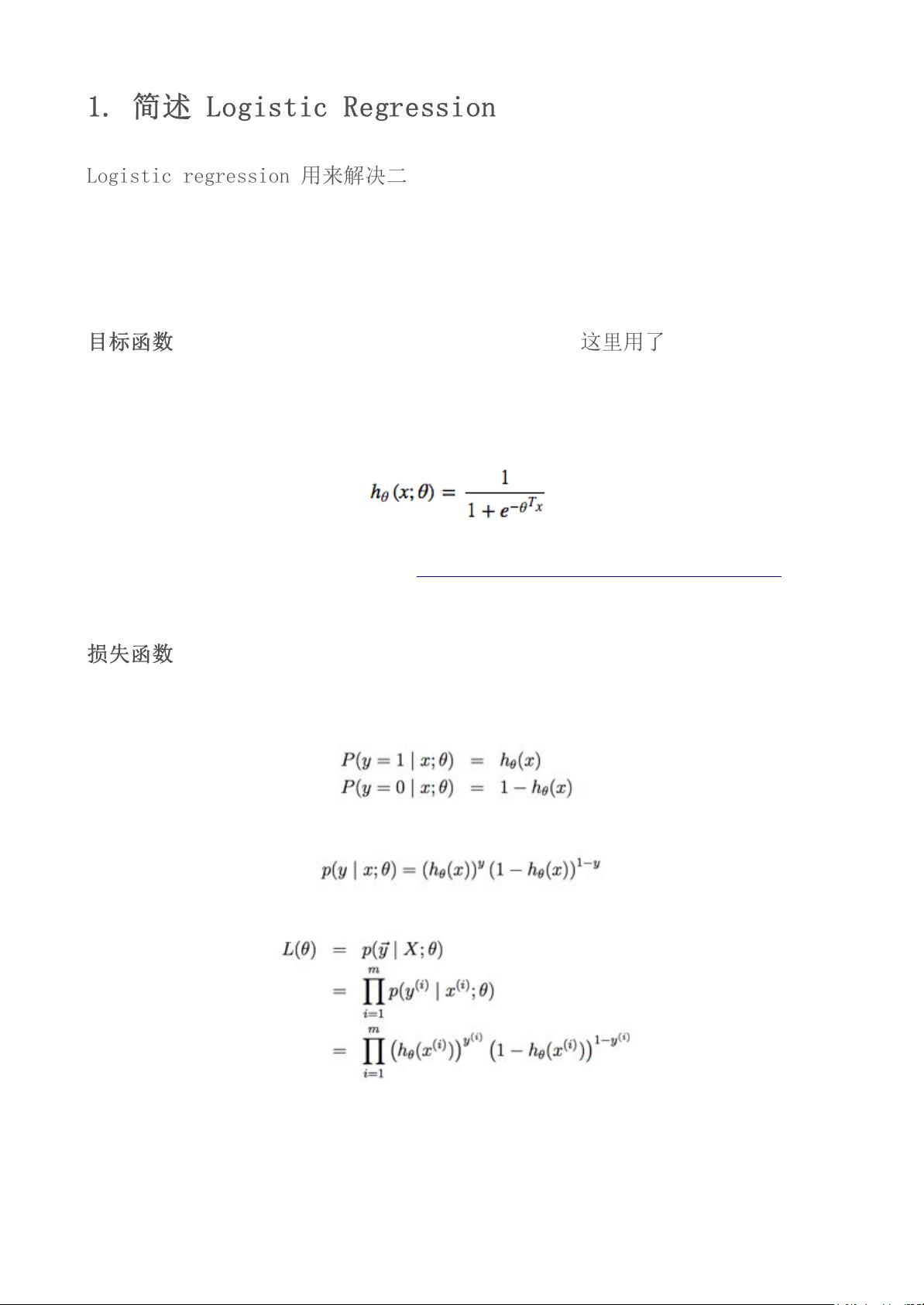

Logistic Regression是一种广泛应用于二分类问题的统计模型,它基于概率论中的伯努利分布假设,认为输入特征与输出类别之间存在一定的线性关系,通过sigmoid函数将线性结果转换为介于0和1之间的概率估计。sigmoid函数的选择是为了确保输出的概率在合理范围内,并且便于数学处理。

损失函数是评估模型性能的关键,LR使用极大似然函数作为其优化目标,这个选择源于其自然的优化倾向。极大似然函数的目标是最大化所有样本的预测概率之积,这样每个样本都被赋予了最大的可能性,从而更好地反映了模型的预测性能。对数似然函数是极大似然函数的对数形式,它在求解过程中表现出较好的计算效率,梯度更新仅依赖于输入特征x和实际标签y,这使得算法的收敛性和稳定性得以提高。

与平方损失函数相比,后者在sigmoid函数下可能会导致梯度更新速度减慢,因为sigmoid函数的导数在定义域内有上限,这限制了优化过程。此外,平方损失使得损失函数对参数θ是非凸的,这意味着在局部最优处可能不是全局最优,而对数损失函数由于其凸性,有助于找到全局最小值。

常见的其他损失函数,如0-1损失、绝对值损失、平方损失、对数损失(即逻辑损失)、Hinge损失和指数损失,各有其适用场景和特点。例如,0-1损失适用于简单分类问题,而Hinge损失则更适合支持向量机(SVM)的结构风险最小化。这些损失函数的图形特性也影响了模型的训练策略和性能。

总结来说,Logistic Regression之所以选择极大似然函数,是出于对模型预测准确性的追求,以及对数损失函数在优化上的优势。这种选择对于保证模型在二分类问题中的稳定性和有效性至关重要。同时,理解不同损失函数的性质和适用场景,有助于在实际应用中根据问题特性和需求做出最佳选择。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2022-08-03 上传

2022-08-03 上传

2024-07-07 上传

2023-05-18 上传

2023-03-16 上传

2022-04-25 上传

丛乐

- 粉丝: 38

- 资源: 312

最新资源

- Getting started with db2 ExpressC V95(zh_CN).pdf

- 思科ASA和PIX防火墙配置手册

- AT89C51单片机实验指导教程

- LED点阵设计毕业论文

- J2ME游戏开发(第一版).pdf

- eclipse中文教程

- 电力系统暂态分析精华#

- GPU_Programming_Guide_Chinese

- oracle的 logminer如何安装配置使用

- Oracle语句优化53个规则详解

- ENGLISH STUDY

- EV1527编码方法及应用

- 多平台移动数据库系统的自由软件实现

- MFC实用教程(pdf)

- EVMDM6437-关于DSP的设计开发

- ssha 最新配置文件