Spark Shuffle深入解析:Reduce阶段揭秘

201 浏览量

更新于2024-08-29

收藏 454KB PDF 举报

"SparkShuffle过程分析:Reduce阶段处理流程"

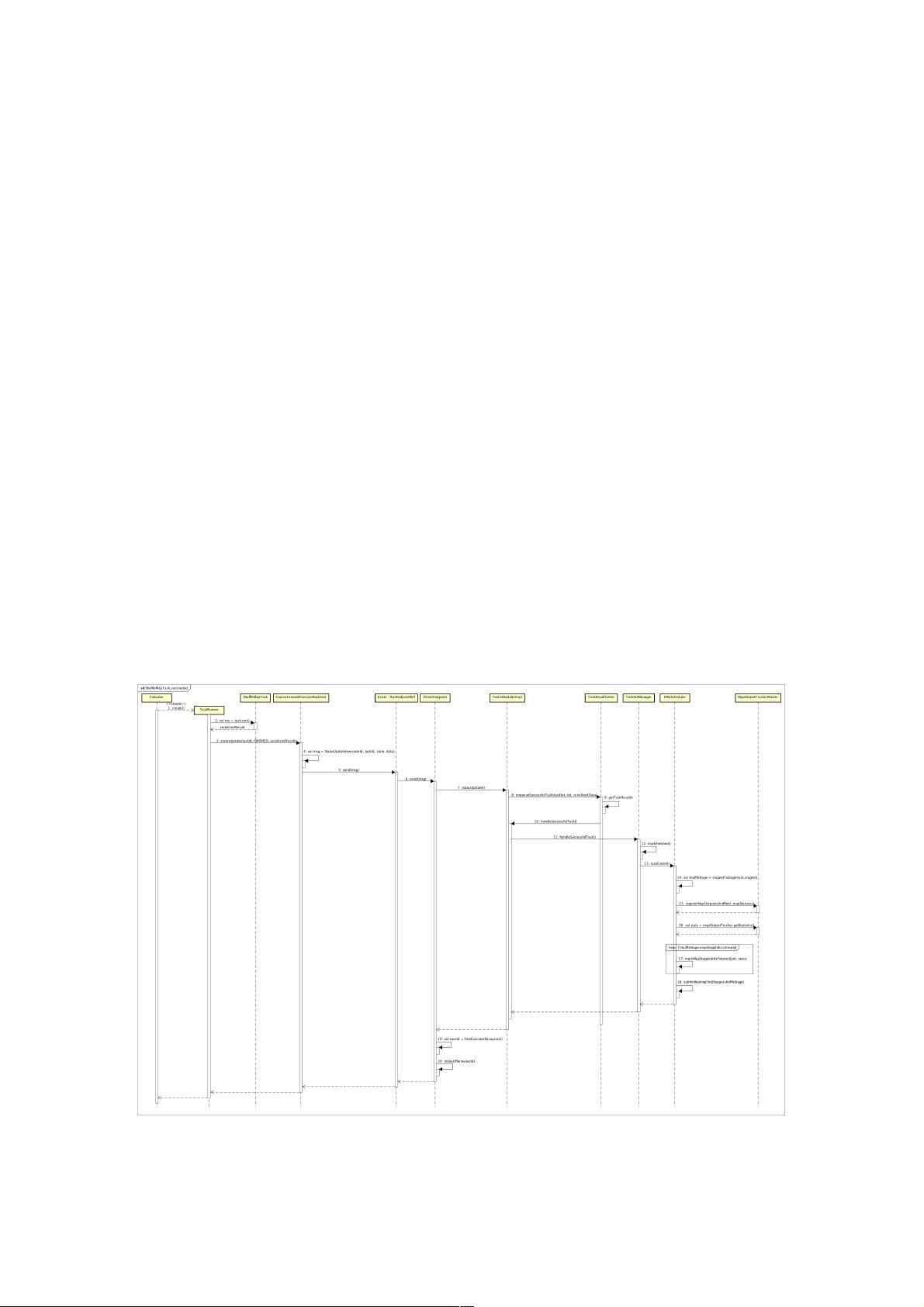

在Spark计算框架中,Shuffle是一个至关重要的过程,它发生在Map阶段和Reduce阶段之间,用于重新组织数据,确保相同键的数据被分发到同一个Reducer上进行处理。本篇文章将深入探讨Spark Shuffle过程中的Reduce阶段处理流程,以及ShuffleMapTask执行后的结果处理。

在Map阶段,每个ShuffleMapTask执行完毕后,会生成两个关键文件:.data和.index。.data文件存储了经过排序的键值对,而.index文件记录了这些键值对在磁盘上的位置信息。MapStatus对象是ShuffleMapTask执行的结果,它包含了运行该任务的BlockManager的地址和每个ResultTask所需的Map输出大小。

MapStatus的创建发生在SortShuffleWriter的write()方法中,该方法负责将数据写入磁盘并生成索引。根据Partition的数量,MapStatus可能创建为HighlyCompressedMapStatus或CompressedMapStatus,这两种实现旨在优化内存和磁盘使用。

接下来,我们通过一个简单的SparkApplication示例来理解Shuffle过程。假设我们有一个使用`reduceByKey()`操作的Spark应用,这会导致数据Shuffle。`reduceByKey()`会创建一个ShuffledRDD,该RDD在执行时会触发Shuffle操作。

在SparkApplication提交后,会生成ShuffleMapStage和ResultStage。ShuffleMapStage包含了一组ShuffleMapTask,这些任务必须全部成功完成,才能进入Reduce阶段。TaskSetManager负责管理和调度这些Task。只有当所有ShuffleMapTask执行完毕并返回MapStatus,Reduce阶段的ResultTask才会开始执行。ResultTask会根据MapStatus中的信息去对应的Executor获取数据,进行Reduce操作。

Reduce阶段的处理流程如下:

1. ResultTask从BlockManager中读取MapStatus,获取数据的分区信息。

2. 根据.index文件定位到具体的数据块(.data文件)。

3. 使用ShuffleClient从远程Executor拉取数据,如果是本地Executor则直接从内存或磁盘读取。

4. ReduceTask按照预设的Reduce函数聚合相同键的数据。

5. 最终,Reducer的输出会被写入到输出RDD,准备进行下一步的操作或者输出。

Spark的Shuffle机制对于大规模数据处理的效率和正确性至关重要。理解这一过程有助于优化应用程序性能,避免不必要的数据传输和提高整体计算效率。在实际应用中,可以通过调整Shuffle相关的参数,如减少shuffle partitions、启用压缩等策略来优化性能。

410 浏览量

288 浏览量

576 浏览量

点击了解资源详情

点击了解资源详情

点击了解资源详情

132 浏览量

145 浏览量

点击了解资源详情

weixin_38619613

- 粉丝: 6

- 资源: 947

最新资源

- gpegrid-服务器端

- bocco:从Markdown生成API文档

- Gifl-crx插件

- log4[removed]这是 sourceforge 上 log4javascript 的一个分支(http

- springboot工程自定义response注解、自定义规范化返回数据结构

- 蓝灰扁平化商务汇报图表大全PPT模板

- sbsShop:基于ThinkPHP开发的微信小程序外卖应用(微信小程序).zip

- tinyspec:用于描述REST API的简单语法

- nlp-study:每个人的实验室从零开始

- AngularHelloWorld

- SpringCloudAlibaba六微服务架构下的秒杀案例

- 北京市出租车轨迹点数据

- 第二届全国大学生工业化建筑与智慧建造竞赛B赛道智慧生产与施工建筑unity模型工程文件.zip

- node-dagskammtur

- Santas Sleigh-crx插件

- 电脑软件AIDA64-Extreme-v5.97- 测试软硬件系统信息.rar