【MapReduce与Spark对比】:Reduce阶段的异同点与最佳实践

发布时间: 2024-10-31 01:08:19 阅读量: 38 订阅数: 21

MapReduce与Spark异同点和优势比较

# 1. MapReduce与Spark简介

在大数据处理的领域中,MapReduce和Spark是两种广泛使用的技术。MapReduce是一个由Google发明的编程模型和处理大数据集的相关实现。它主要用于大规模数据集的并行运算。而Spark,作为一种更先进的大数据处理框架,同样采用MapReduce的编程模型,但对它进行了优化,以提供更快的处理速度和更灵活的数据处理能力。

## 1.1 大数据处理技术的发展历程

大数据技术的发展经历了从简单的批处理,到复杂的流处理的演进过程。MapReduce作为早期的大数据处理技术,对大数据的发展产生了深远的影响。它将复杂的数据处理任务分解为两个步骤:Map(映射)和Reduce(归约),使开发者能够以相对简单的方式处理海量数据。

## 1.2 MapReduce与Spark的核心区别

Spark的出现被视为对MapReduce的一种进化。与MapReduce相比,Spark不仅支持批处理,还支持流处理、交互式查询和机器学习等多种数据处理方式。Spark的一个核心概念是RDD(弹性分布式数据集),它提供了一种容错的、并行的数据操作方式,大大提高了数据处理的灵活性和效率。

## 1.3 Spark的兴起原因与应用

Spark之所以能够迅速流行起来,其主要原因在于它的高效率。Spark可以将中间计算结果存储在内存中,避免了MapReduce进行磁盘I/O操作的开销。此外,Spark拥有丰富的API和易于理解的编程模型,这使得数据科学家和工程师能够更快速地开发和运行应用。

以上内容为第一章的概览,接下来的章节将深入探讨MapReduce与Spark在Reduce阶段的工作原理、编程实践对比以及优化策略。

# 2. MapReduce与Spark在Reduce阶段的理论对比

### 2.1 MapReduce的Reduce阶段深入分析

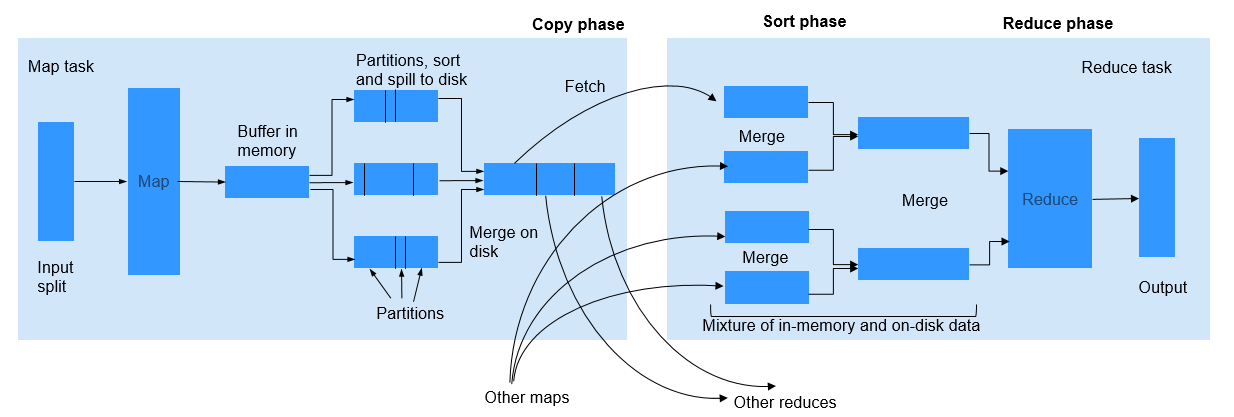

#### 2.1.1 MapReduce的工作原理

MapReduce是一种编程模型,用于处理和生成大规模数据集。Map阶段处理输入数据,产生中间键值对;Reduce阶段则将具有相同键的值合并起来。这个模型被Hadoop框架广泛采用,成为处理大数据的关键技术之一。

MapReduce的工作流程可划分为几个阶段:

1. **输入分片**:输入数据被分割成多个小块,称为输入分片(input splits),每个分片由一个Map任务处理。

2. **Map函数处理**:Map任务读取输入分片并处理。Map函数处理数据并输出键值对。

3. **Shuffle过程**:系统自动进行Shuffle过程,它负责排序和分组。Shuffle过程将所有相同键(key)的值(value)集合起来,确保后续的Reduce任务可以接收到所有相关数据。

4. **Reduce函数处理**:Reduce任务接收Shuffle后的数据,对相同键的所有值进行聚合操作。

5. **输出**:最后的输出被保存到HDFS或其他存储系统。

```java

// MapReduce示例代码(Java)

public class MyMapper extends Mapper<LongWritable, Text, Text, IntWritable> {

public void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

// 处理逻辑

}

}

public class MyReducer extends Reducer<Text, IntWritable, Text, IntWritable> {

public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {

// 聚合逻辑

}

}

```

在上述代码中,`Mapper` 和 `Reducer` 是实现自Hadoop API的两个关键类。在`Mapper`中,键值对被处理并输出;在`Reducer`中,对应键的所有值被处理。

#### 2.1.2 Reduce阶段的核心角色与作用

Reduce阶段的核心角色是`Reducer`,它负责聚合所有具有相同键的值。在MapReduce的工作原理中,Reduce阶段的作用可以总结为以下几点:

- **数据聚合**:将分散在多个节点上的相同键的数据进行合并。

- **排序与分组**:通过Shuffle过程保证具有相同键的数据会发送到同一个Reducer,且数据已经排序。

- **输出结果**:最终输出的是经过聚合后的数据,通常更小,但更有用。

- **容错性**:如果某个Reducer失败,系统可以重新调度任务到其他节点执行。

在实际操作中,Reduce阶段也暴露出一些问题,比如性能瓶颈、数据倾斜等。这些挑战通常需要在设计MapReduce作业时就考虑并加以优化。

### 2.2 Spark的RDD转换与行动操作

#### 2.2.1 RDD的概念及特性

弹性分布式数据集(Resilient Distributed Dataset,RDD)是Spark中用于处理大规模数据的核心抽象。RDD是不可变的分布式对象集合,支持并行操作。它具有以下几个关键特性:

- **不可变性**:一旦创建,无法更改。

- **分区**:数据分布在集群的多个节点上。

- **依赖关系**:记录不同RDD之间的转换关系,形成一个有向无环图(DAG),用于任务调度和故障恢复。

- **分区器**:定义数据如何在RDD之间分区。

```scala

// RDD示例代码(Scala)

val lines = sc.textFile("data.txt")

val lineLengths = lines.map(s => s.length)

val totalLength = lineLengths.reduce((a, b) => a + b)

```

在上面的Scala代码中,`lines`是一个文本文件的RDD表示,`map`和`reduce`操作用于获取每行的长度并累加它们。

#### 2.2.2 Spark中的行动操作对比MapReduce的Reduce

行动操作(Action)是触发Spark作业执行的操作,与MapReduce中的Reduce操作有相似之处,但行动操作更加灵活且功能更丰富。行动操作会触发实际的计算过程,并返回结果到驱动程序或者持久化到外部存储系统。

与MapReduce的Reduce操作相比,Spark中的行动操作具有以下不同:

- **直接返回结果**:行动操作可以直接返回计算结果,如列表、求和等。

- **无需显式Shuffle**:Spark会自动管理Shuffle过程,无需开发者指定。

- **多种数据输出方式**:结果可以被保存到HDFS、Cassandra、S3等多种存储系统。

```scala

// Spark行动操作示例代码(Scala)

// 计算元素数量

val count = lineLengths.count()

// 收集结果到列表

val lengthsList = lineLengths.collect()

```

在这些示例中,`count()`和`collect()`是Spark的行动操作。`count()`返回RDD中元素的数量,而`collect()`将所有数据收集到驱动程序的内存中。

### 2.3 理论层面的Reduce阶段对比

#### 2.3.1 MapReduce与Spark在数据处理上的差异

MapReduce和Spark

0

0