MapReduce中的Combiner与Reducer选择策略:如何判断何时使用Combiner

发布时间: 2024-10-31 04:14:27 阅读量: 38 订阅数: 33

# 1. MapReduce框架基础

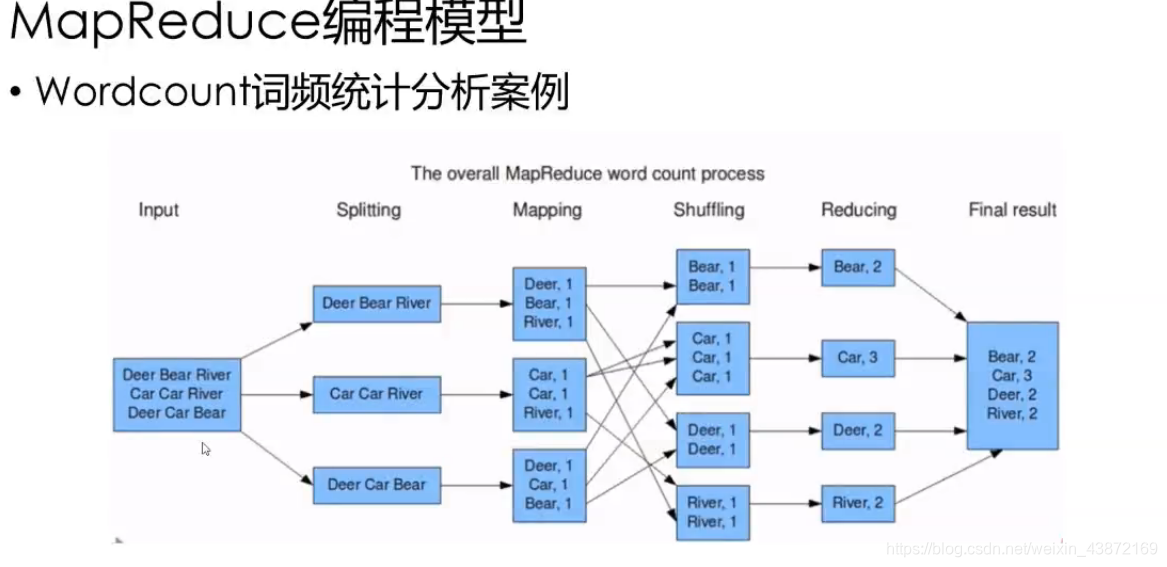

MapReduce 是一种编程模型,用于处理大规模数据集的并行运算。它通常用于执行数据密集型任务,如日志文件分析、统计、数据清洗等。该模型由两部分组成:Map 和 Reduce。

## 1.1 MapReduce 框架的组成

### 1.1.1 Map 阶段

Map 阶段主要负责处理输入的数据,并以键值对的形式输出。Map 任务可以并行处理,每个 Map 实例通常对应输入数据的一个分片。

```java

// Map 函数的伪代码示例

map(String key, String value):

// key: 输入数据的标识

// value: 输入数据的内容

emit(key, value)

```

### 1.1.2 Reduce 阶段

Reduce 阶段接收 Map 阶段输出的键值对,并对具有相同键的值集合进行合并操作。该阶段通常涉及大量的排序和聚合工作。

```java

// Reduce 函数的伪代码示例

reduce(String key, Iterator values):

// key: Map 阶段输出的键

// values: 拥有相同键的所有值的迭代器

result = new Result()

for each value in values:

result += value

emit(key, result)

```

### 1.1.3 MapReduce 的工作流程

整个 MapReduce 工作流程如下图所示:

```mermaid

graph LR

A[开始] --> B[Map 阶段]

B --> C[Shuffle 阶段]

C --> D[Reduce 阶段]

D --> E[结果输出]

```

MapReduce 框架通过分而治之的方式有效地处理大规模数据集。Map 阶段将任务分散处理,然后通过 Shuffle 阶段将相同键的值整理到一起,最后由 Reduce 阶段汇总处理结果。这个过程不仅并行化程度高,而且框架还提供了容错机制,保证了处理的可靠性。

以上就是 MapReduce 框架的基础介绍,后续章节将深入探讨 Combiner 组件的作用与原理。

# 2. Combiner组件的作用和原理

## 2.1 Combiner在MapReduce中的角色

### 2.1.1 Combiner与Mapper的关系

在MapReduce框架中,Combiner组件的作用是减少Map任务输出数据量,进而减轻网络传输的压力,提升整体作业效率。与Mapper紧密相连,Combiner本质上是一个简化的Reducer。它在Mapper和Reducer之间执行部分合并工作,但并不替代Reducer的角色。

具体地,当Map任务完成数据处理后,会输出大量的中间键值对数据。如果直接将这些数据传输到Reducer,会导致大量的网络带宽消耗和网络延迟。此时,Combiner起作用,它在每个Map节点上对输出的键值对进行预聚合处理。通过这种方式,相同键的值可以被合并(或聚合),减少数据量,使得网络传输更加高效。Combiner的操作使得那些拥有相同键的数据在传输到Reducer之前就已经被部分合并,从而减少了Reducer接收到的数据量。

### 2.1.2 Combiner的优化原理

Combiner的优化原理基于这样的事实:很多MapReduce作业存在数据冗余,尤其是对于那些具有相同键值的数据。在没有Combiner的情况下,这些相同键值对应的所有值都将被完整地传递到Reducer。Combiner通过局部聚合这些数据,减少了网络带宽的消耗和Reducer的处理负担。

从优化的角度来看,Combiner的应用可以提升作业的执行效率,具体体现在:

- 减少网络传输的数据量:在Map端的局部聚合减少了整体数据的传输量。

- 提高Reducer的处理速度:由于Reducer接收到的中间数据量减少,其处理速度自然提升。

- 缩短整体作业时间:网络传输和数据处理速度的双重提升,直接导致作业完成时间的缩短。

接下来,我们将深入探讨Combiner与Reducer的区别,以及它们在功能和适用场景上的异同。

## 2.2 Combiner与Reducer的区别

### 2.2.1 功能上的异同

Combiner和Reducer在某些功能上具有相似性,但它们在应用上有所不同。它们都可以作为映射到输出键的一组值的归约操作,但Reducer是在所有Map任务完成后执行,而Combiner则是在Map阶段完成后立即在各个Map节点上执行。

关键差异点包括:

- 执行时机不同:Reducer在整个Map任务完成后执行,而Combiner则是在单个Map任务完成后立即执行。

- 作用范围不同:Reducer作用于所有Map任务的输出,而Combiner仅作用于单个Map任务的输出。

- 输出结果不同:尽管两者都产生键值对,但Reducer输出结果为最终结果,而Combiner输出结果将被进一步送往Reducer。

### 2.2.2 适用场景的比较

选择使用Combiner还是Reducer取决于特定的MapReduce作业需求和数据特点。Combiner适用于数据具有局部聚集性的场景,即在Map任务的输出中存在大量重复键值对应的数据。在这种情况下,Combiner可以有效地减少网络传输的数据量和Reducer的计算负担。

例如,当我们进行单词计数(Word Count)任务时,每个单词的计数可以在Map输出时进行合并,因为这些计数最终都会累加到同一个键上。然而,对于某些作业,如需要精确计算每个键对应的所有值,或者没有可应用的合并函数(比如求和、计数等)的作业,使用Combiner就不再适合。此时,Reducer是必要的步骤,因为它会处理最终的输出。

为了更好地理解Combiner的内部工作机制,我们继续探索其输入输出流程及函数实现原理。

## 2.3 Combiner的内部工作机制

### 2.3.1 Combiner的输入输出流程

Combiner的输入输出流程可以被分解为以下步骤:

1. 每个Mapper完成数据处理后输出键值对数据。

***biner接收这些键值对作为输入。

***biner对这些键值对进行合并操作,通常是将相同键的值进行合并(例如,对数值进行累加)。

4. 合并后的键值对成为Combiner的输出,然后被传输到Reducer。

这一过程在每个Mapper节点上独立发生,且通常Combiner的输入输出键值对数据结构是一致的。值得注意的是,并不是所有的MapReduce作业都适合使用Combiner,其使用依赖于作业的特定需求和数据的聚集特性。

### 2.3.2 Combiner函数的实现原理

在MapReduce中,Combiner函数的实现原理非常直观。考虑一个典型的Combiner使用案例:单词计数。在Map端,每个单词及其出现的次数(通常是一个计数1)被输出。若没有Combiner,这些值将在网络中被直接发送到Reducer。通过使用Combiner,相同的单词及其对应的所有计数在发送之前被合并。

在实现上,Combiner通常被定义为一个实现了Reducer接口的类,但它的特殊之处在于它在每个Map任务输出之前进行调用。这个类需要重写`reduce`方法,以便对输入的键值对执行合并操作。代码示例可能如下所示:

```java

public class MyCombiner extends Reducer<Text, IntWritable, Text, IntWritable> {

@Override

protected void reduce(Text key, Iterable<IntWritable> values, Context context)

throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

context.write(key, new IntWritable(sum));

}

}

```

以上代码展示了如何在Mapper输出后,针对同一个单词的多个计数值进行累加操作。使用Combiner函数后,最终发送到Reducer的数据量会显著减少,因为相同键的值已经被合并。

接下来,我们将详细探讨Reducer组件的深入剖析,深入了解它在MapReduce中的作用和优化策略。

# 3. Reducer组件的深入剖析

## 3.1 Reducer的工作原理

### 3.1.1 Reducer的输入输出处理

Reducer组件是MapReduce框架中负责“归约”操作的模块,其核心职责是将Mapper的中间输出进行合并处理。Reducer接收到的输入是经过Shuffle过程排序和分组后的数据,这些数据以键值对的形式存在,其中键是相同的数据项被“合并”的依据,值是实际的数据内容。

Reducer处理流程大致分为三个步骤:读取输入、进行归约处理和输出结果。首先,Reducer会读取由Shuffle过程分发来的数据。随后,Reducer会对这些数据进行迭代,针对每个唯一的键,调用用户定义的Reducer函数处理与该键相关联的所有值。最终,Reducer输出处理结果。

### 3.1.2 Reducer任务的调度和执行

Reducer任务的调度和执行涉及到资源管理和任务分配。在Hadoop中,JobTracker负责资源管理和任务调度,它将Reducer任务分配给TaskTracker执行。Reducer任务执行时,首先会创建Reducer实例,然后通过InputFormat读取数据,并逐步迭代处理数据,直至所有数据处理完毕。

Reducer执行的过程中,它会从多个Mapper的输出中读取数据,这要求Reducer必须能够处理多个输入流。MapReduce框架会保证所有具有相同键的值都会被发送到同一个Reducer,这就要求框架在Shuffle阶段对数据进行正确的排序和分组。

## 3.2 Reducer的优化策略

### 3.2.1 缓存机制和数据本地性优化

为了提高Reducer处理数据的效率,Hadoop引入了缓存机制,允许用户将小的数据集或者辅助数据缓存在集群的各个节点上,以便Reducer在其运行的节点上直接访问这些数据,避免了网络传输的开销。

数据本地性是另一个重要的优化手段。Hadoop通过优先调度任务到包含相关数据的节点上执行来充分利用数据本地性。这样可以减

0

0