MapReduce自定义Partitioner指南:根据需求定制数据分区策略的5大步骤

发布时间: 2024-10-31 04:09:48 阅读量: 4 订阅数: 4

# 1. MapReduce基本概念和原理

## MapReduce简介

MapReduce是一种编程模型,用于处理大规模数据集的并行运算。最初由Google提出,现在已经成为处理大数据的标准解决方案之一。

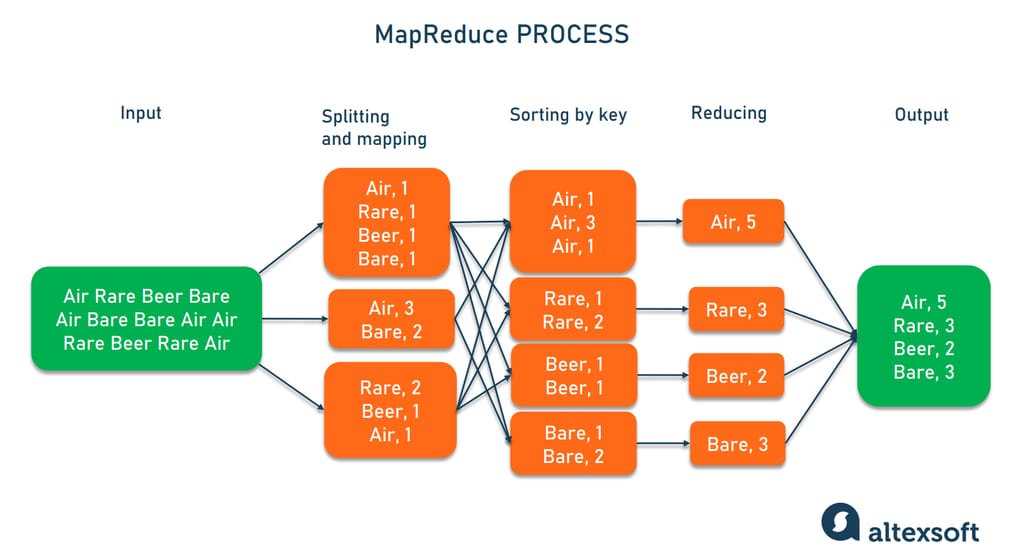

## MapReduce的运行原理

MapReduce模型分为两个阶段:Map阶段和Reduce阶段。在Map阶段,输入数据被处理成一系列键值对;然后通过一个分区函数,将键值对分配到不同的Reduce任务。在Reduce阶段,具有相同键的所有键值对会一起被处理,输出结果。

## MapReduce的优势和应用场景

MapReduce模型的优势在于其对数据处理的高度并行化和扩展性。它适用于需要处理大量数据并进行复杂计算的场景,如日志文件分析、大规模数据集排序、搜索索引构建等。

# 2. 深入理解MapReduce中的Partitioner

## 2.1 Partitioner的作用和影响

### 2.1.1 数据分区的基本概念

在MapReduce框架中,数据分区(Partitioning)是一个将Map任务输出的中间键值对根据键值分配到不同Reducer上处理的过程。通过合理地分配数据分区,可以确保数据处理的负载均衡,从而提高整体的处理效率。分区的作用不仅限于均匀分布数据,还包括影响数据处理的并行度、减少网络传输以及防止数据倾斜问题。

数据分区涉及到的另一个核心概念是键(Key),键是数据在Map输出时的分类依据,它决定了数据将被发送到哪个Reducer。因此,Partitioner的作用就是决定每一个键值对(key-value pair)应该被分到哪个分区中。

### 2.1.2 默认Partitioner的工作机制

Hadoop的MapReduce框架中有一个默认的Partitioner实现,它基于键的哈希值进行分区。默认Partitioner使用的哈希函数对键的字节进行哈希计算,并将结果与可用Reducer数量进行模运算。这样,结果哈希值相同的键都会被发送到同一个Reducer。

默认Partitioner的实现简单,但在某些特定情况下可能会导致数据倾斜。数据倾斜是指数据在Reducer之间分配不均匀,这可能导致某些Reducer的任务量远大于其他Reducer,从而影响了整体作业的执行效率。

## 2.2 分区策略的选择标准

### 2.2.1 负载均衡的重要性

负载均衡是选择合适分区策略的关键因素之一。理想情况下,所有Reducer在处理数据时应该有大致相同的执行时间。这需要数据在各个Reducer之间尽可能均匀分布,保证每个Reducer处理的数据量大致相同。

在实际应用中,如果选择不当的分区策略,可能导致某些Reducer处理的数据量过大,而其他Reducer则处理较少的数据,从而导致整体作业的执行时间被延长。实现负载均衡的方法多种多样,例如可以通过自定义Partitioner根据实际的数据分布情况来分配数据。

### 2.2.2 数据倾斜的避免方法

数据倾斜是MapReduce中常见的性能问题,特别是在处理具有高度重复键值的数据集时更为明显。为了避免数据倾斜,可以采取以下几种策略:

- **使用随机前缀**:给键添加随机前缀,可以打乱数据,分散重复键值对。

- **数据预处理**:在Map阶段对数据进行预处理,比如对键值进行分组聚合,减少同一键值的重复数据。

- **多级分区策略**:采用复合Partitioner,先按某种规则进行一次分区,再对每个分区进行二次分区。

- **合理选择键**:对于可能出现的数据倾斜问题,可以选择不易重复的键,或者通过改变键的数据类型来避免。

## 2.3 分区策略的性能影响

分区策略的优劣直接影响到MapReduce作业的性能。选择合适的分区策略可以显著提高MapReduce作业的效率,主要表现在以下几个方面:

- **执行时间**:合适的分区策略能够减少Reducer之间的数据处理量差距,从而减少整体的执行时间。

- **资源利用**:均衡的负载分配可以更充分地利用集群的计算资源,避免某些节点处理能力的浪费。

- **稳定性**:减少因数据倾斜导致的个别Reducer任务失败或延迟,提高作业的稳定性。

自定义Partitioner可以更精确地控制键值对的分配逻辑,以适应不同数据分布特性。一个好的分区策略应该是灵活的,能够应对各种业务场景和数据分布情况。

# 代码块和逻辑分析

下面是一个简单的自定义Partitioner的代码示例,用于展示如何通过继承和覆盖Partitioner类来自定义分区逻辑:

```java

public class CustomPartitioner extends Partitioner<Text, IntWritable> {

@Override

public int getPartition(Text key, IntWritable value, int numPartitions) {

// 自定义分区逻辑,例如根据键的第一个字符

if (key.charAt(0) <= 'M') {

return 0 % numPartitions;

} else {

return 1 % numPartitions;

}

}

}

```

在这段代码中,`getPartition`方法根据键(key)的第一个字符来决定该键值对应该发送到哪个分区。在这个例子中,只有两个分区,其中键值以字母'M'之前(包括'M')的字符开头的键值对会被发送到第一个分区,而其他的则被发送到第二个分区。

这个简单的分区策略虽然简单,但在处理包含大量以'M'开头的键的大量数据时,可能会导致第一个分区的数据量远大于第二个分区。为了实现更好的负载均衡,可以将键的范围进一步细化,或者采用更复杂的分区规则。

## 2.3 集成自定义Partitioner到MapReduce作业

在设计好自定义Partitioner之后,接下来需要将其集成到MapReduce作业中。以下是如何在MapReduce作业中配置自定义Partitioner的步骤:

### 2.3.1 配置MapReduce作业使用自定义Partitioner

```java

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "CustomPartitioner Example");

job.setJarByClass(YourDriverClass.class);

job.setMapperClass(YourMapperClass.class);

job.setPartitionerClass(CustomPartitioner.class);

job.setNumReduceTasks(2); // 设置Reducer的数量

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

```

0

0