MapReduce作业优化方案:根据业务需求调整Map和Reduce数量的最佳实践

发布时间: 2024-10-31 03:52:01 阅读量: 2 订阅数: 5

# 1. MapReduce作业优化基础

在当今大数据处理领域,MapReduce模型依旧扮演着举足轻重的角色。优化MapReduce作业是提升大数据处理效率和系统性能的重要手段。本章将介绍MapReduce作业优化的基本概念和原则,为接下来的深入分析奠定基础。

## 1.1 优化的重要性

优化MapReduce作业对减少作业执行时间和资源消耗至关重要。通过精心设计的优化策略,可以显著提高数据处理效率,从而在大规模数据处理场景中取得更好的性能。

## 1.2 优化的基本思路

MapReduce作业优化主要包括以下思路:

- 合理配置Map和Reduce任务的参数,如内存和CPU资源;

- 优化数据倾斜问题,减少单个任务的负载过重;

- 利用MapReduce的高级特性,如Combiner和Partitioner来减少数据传输量。

优化MapReduce作业需要对整体工作流程、任务分配机制以及性能监控有深入的理解。接下来的章节将详细展开介绍这些核心组件及其优化方法。

# 2. 理解MapReduce的核心组件

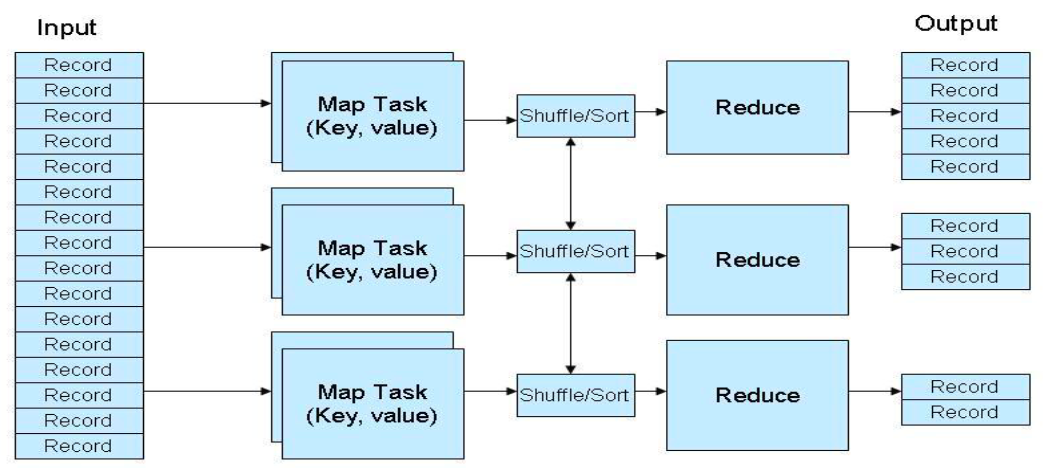

MapReduce是一种编程模型,它简化了大规模数据集的并行运算。其核心组件包括Map任务和Reduce任务,以及负责调度和管理任务的组件。深入理解这些组件的工作原理对于优化MapReduce作业至关重要。

### 2.1 MapReduce的工作原理

MapReduce作业的工作原理可以分解为两个主要阶段:Map阶段和Reduce阶段。理解这两个阶段如何协同工作是优化MapReduce作业的关键。

#### 2.1.1 Map阶段的工作流程

Map阶段是数据处理的起始点,它的主要任务是处理输入数据,并产生一系列中间键值对(key-value pairs)。这些键值对是后续Reduce阶段处理的基础。

- **数据读取**:Map阶段开始时,首先读取数据输入,通常这些数据存储在Hadoop文件系统(HDFS)中。Map函数的任务就是对这些数据进行处理。

- **键值对生成**:在Map任务中,对每一条输入数据执行用户定义的Map函数,从而生成一系列的键值对。

- **排序和分组**:生成的键值对会被自动排序,键值相同的键值对会合并在一起,并传递给同一个Reduce任务。排序和分组阶段是MapReduce框架自动完成的,无需用户手动编写代码。

```java

// 示例代码:Java Map函数示例

public static class TokenizerMapper extends Mapper<Object, Text, Text, IntWritable> {

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context) throws IOException, InterruptedException {

StringTokenizer itr = new StringTokenizer(value.toString());

while (itr.hasMoreTokens()) {

word.set(itr.nextToken());

context.write(word, one);

}

}

}

```

在上述Java代码中,`TokenizerMapper`类定义了Map操作,`map`方法接受一个键(通常是文件名)和一个值(文件中的行),并输出中间键值对。

#### 2.1.2 Reduce阶段的工作流程

Reduce阶段负责汇总由Map阶段输出的中间键值对,并将它们缩减为最终结果。这个阶段分为三步:Shuffle、Sort、Reduce。

- **Shuffle**:这是将Map输出的数据按照键的排序结果传输到正确的Reduce任务的过程。这个过程由MapReduce框架管理,确保每个Reduce任务接收到所有具有相同键的数据。

- **Sort**:传输到Reduce任务的键值对会自动根据键进行排序。这一步骤是排序和分组的一部分,上一阶段中已经提及。

- **Reduce**:最后,Reduce函数被应用到每个唯一的键以及该键对应的值列表上。Reduce函数的目的是对这些值进行归约操作,产生最终输出。

```python

# 示例代码:Python Reduce函数示例

def reducer(k, vs):

for v in vs:

yield (k, v)

# 在MapReduce框架中,Reducer通常在所有Map任务完成后被调用

```

这段Python代码简单地展示了Reduce函数的工作方式,对所有相同键的值进行处理并产生最终输出。

### 2.2 Map和Reduce的任务分配机制

#### 2.2.1 数据分割与任务并行化

为了提高效率,MapReduce框架将输入数据分割成独立的块,这些数据块可以并行处理。每个Map任务处理一个数据块,并生成中间输出。Reduce任务则根据中间输出的键范围进行分配。

- **输入数据分割**:大文件被分割为多个块(block),HDFS中默认的块大小是128MB。每个块由一个Map任务处理。

- **任务并行化**:并行化的目的是让Map任务能够在不同的节点上同时运行,从而利用集群的计算能力。

#### 2.2.2 资源调度与任务管理

MapReduce框架负责资源调度和任务管理,包括监控任务执行状态,处理故障,并在必要时重新调度任务。

- **任务调度**:任务调度器负责决定哪个Map任务或Reduce任务可以运行在哪个节点上。它根据节点的资源使用情况和任务优先级来做出调度决策。

- **任务管理**:任务管理器监控任务的执行状态,如果发现任务失败,则会重新启动任务。此外,它还负责处理作业的生命周期事件,如任务完成、任务失败等。

本章节深入探讨了MapReduce的核心组件,包括Map阶段和Reduce阶段的工作流程,以及如何进行任务分配和管理。下一章节中,我们将分析如何根据业务需求调整Map和Reduce的数量来优化MapReduce作业。

# 3. 业务需求与MapReduce参数调整

业务需求对于MapReduce作业的优化至关重要

0

0