MapReduce容错机制深度解析:保障数据处理的9大可靠性策略

发布时间: 2024-10-31 03:58:45 阅读量: 2 订阅数: 5

# 1. MapReduce容错机制概述

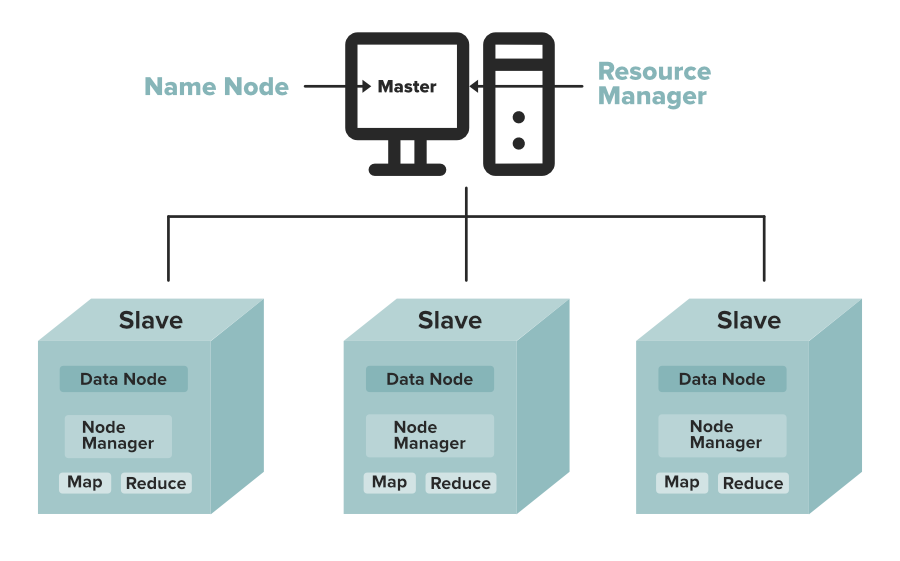

MapReduce作为一种分布式计算模型,其设计核心之一就是容错机制。容错对于处理大规模数据集的集群环境至关重要。在这一章节中,我们将概览MapReduce的容错特性,以及它如何在运行过程中应对硬件故障、网络问题和其他潜在错误。我们将解析MapReduce如何确保每个任务在出现故障时能够重新执行,以及它在数据处理过程中的可靠性策略,为后续章节的深入分析打下基础。

接下来,第二章将详细介绍MapReduce数据处理的基础,包括其工作原理、输入输出模型等,为理解容错机制在实际数据处理中的应用铺垫必要的知识。

# 2. ```

# 第二章:MapReduce数据处理的基础

## 2.1 MapReduce工作原理简析

### 2.1.1 Map和Reduce任务的执行流程

MapReduce框架的设计目标是为了简化大规模数据集的并行运算。其核心是将计算任务分解为两个阶段:Map阶段和Reduce阶段。用户需要实现的Map函数和Reduce函数会被框架调用执行计算任务。

Map任务主要负责读取输入数据,并对数据进行处理,例如,将输入数据解析为键值对(key-value pairs)。这些键值对经过排序和分组后,相同键(key)的数据会聚集到一起,并传递给Reduce任务。

Reduce任务接收来自Map任务的输出,处理具有相同键的数据。通常,它会对这些数据执行某种聚合操作,如求和、计数或其它用户定义的归约操作。最后,Reduce任务的输出被写入到输出文件中。

```java

// 一个简单的MapReduce作业示例

public class WordCount {

public static class TokenizerMapper

extends Mapper<Object, Text, Text, IntWritable>{

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context

) throws IOException, InterruptedException {

String[] words = value.toString().split("\\s+");

for (String str : words) {

word.set(str);

context.write(word, one);

}

}

}

public static class IntSumReducer

extends Reducer<Text, IntWritable, Text, IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values,

Context context

) throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result);

}

}

}

```

### 2.1.2 数据流与任务调度机制

在MapReduce框架中,数据流是一个连续的数据处理过程。Map任务通常由输入文件的不同块(split)触发,并且并行运行。每个Map任务处理分配给它的数据,并生成中间键值对作为输出。

在Map阶段完成后,所有产生的键值对会通过一个排序和分组的过程,该过程通常发生在Map和Reduce任务之间的Shuffle阶段。这个阶段确保了所有具有相同键的数据项被发送到相同的Reduce任务。

Reduce任务接收这些已经排序好的键值对,然后对每个键下的值列表执行用户定义的归约操作,将结果输出到最终的输出文件中。

任务调度是由框架内的调度器完成的,该调度器负责监控集群资源和任务状态,并根据配置策略分配任务给可用的节点。常见的调度策略包括FIFO、容量调度器、公平调度器等。

## 2.2 MapReduce的输入输出模型

### 2.2.1 输入格式与数据分割

MapReduce的输入模型非常灵活,支持各种格式的数据,包括文本文件、二进制文件等。输入数据通常会被分割成多个小块(split),每个Map任务处理一个或多个split。数据分割的策略对性能有着直接的影响,合理的数据分割可以保证负载均衡,并行处理效率最大化。

```java

// 自定义InputFormat示例

public class CustomInputFormat extends FileInputFormat<Text, NullWritable> {

@Override

public RecordReader<Text, NullWritable> createRecordReader(

InputSplit split, TaskAttemptContext context) {

return new CustomRecordReader();

}

}

```

### 2.2.2 输出格式与数据聚合

MapReduce的输出模型通过OutputFormat类和RecordWriter类来定义,它决定了如何写入输出数据。输出格式定义了输出键值对的组织方式,如文本输出、二进制输出或者特定格式的数据(如Avro)。输出数据在写入时,需要进行合理的排序和归并,以保证数据的有序性和完整性。

```java

// 自定义OutputFormat示例

public class CustomOutputFormat extends FileOutputFormat<Text, IntWritable> {

@Override

public RecordWriter<Text, IntWritable> getRecordWriter(

FileSystem fs, JobConf job, String name, Progressable progress)

throws IOException {

return new CustomRecordWriter(fs, job, name, progress);

}

}

```

MapReduce框架通过一个作业配置对象(JobConf)来管理输入输出格式的设置。开发者可以通过修改这个对象来定制自己的输入输出处理逻辑,以适应特定的数据处理需求。

# 3. MapReduce的9大可靠性策略

在分布式计算中,容错机制是确保数据处理准确性和系统稳定性的关键因素。MapReduce作为一种成熟的分布式计算框架,拥有自己独特的一套策略来保证计算任务在面对硬件故障、网络问题等异常情况时的可靠性。本章将深入探讨MapReduce设计的9大可靠性策略,从数据备份与副本机制到任务调度的容错策略,再到性能与容错的平衡艺术。

## 3.1 数据备份与副本机制

数据备份与副本机制是容错的基础。MapReduce通过在不同的节点之间复制数据,确保单个节点的失败不会导致数据丢失,从而保证整个计算任务的可靠性。

### 3.1.1 数据节点间的复制策略

在MapReduce框架中,数据的副本策略主要是由Hadoop的HDFS(Hadoop Distributed File System)来实现的。HDFS将每个文件分割成一系列的块(blocks),默认情况下,每个块会有3个副本,分布在不同的数据节点上。

```mermaid

flowchart LR

subgraph "HDFS Block Replication"

direction LR

B1[Block] -->|Replica 1| N1[Data Node 1]

B1 -->|Replica 2| N2[Data Node 2]

B1 -->|Replica 3| N3[Data Node 3]

end

```

副本的创建和放置由NameNode统一管理,它根据网络拓扑和存储能力来决定副本的位置。通过这种方式,即使某个数据节点发生故障,系统也能从其他副本所在的数据节点中读取数据,确保数据不会丢失。

### 3.1.2 故障节点的数据恢复

当检测到某个数据节点发生故障时,系统会启动数据恢复流程。首先,会重新在其他健康的数据节点上创建一个新的副本,以保证总副本数达到配置的水平。这个过程对用户来说是透明的,不会影响正在进行的计算任务。

```mermaid

flowchart LR

Fault[Data Node Fault] --> Detect(Detect Fault)

Detect -->|Generate new replica| Recovery(Recover Data)

Recovery -->|Restore to 3 replicas| Stable(Restore to Stable State)

```

这个数据恢复机制确保了整个分布式系统的高可用性。为了加快恢复速度,MapReduce通常会采用心跳检测机制,实时监控各个节点的

```

0

0