MapReduce Shuffle容错机制深度解析:保障处理稳定性策略

发布时间: 2024-10-30 22:46:57 阅读量: 4 订阅数: 7

# 1. MapReduce Shuffle机制概述

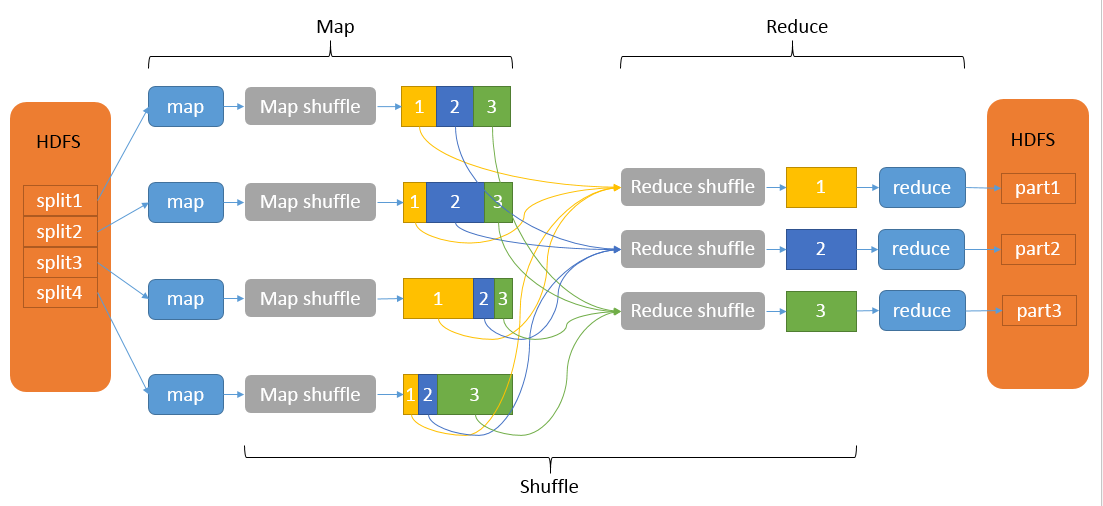

MapReduce框架是一个广泛应用于大数据处理的编程模型,其中Shuffle机制是保证Map和Reduce阶段数据正确传输与排序的关键过程。在这一章节中,我们将对Shuffle机制进行一个基础性的概览,为接下来深入探讨Shuffle过程中的关键组件、容错机制、实践应用及其面临的挑战和未来发展趋势打下基础。

Shuffle机制的核心目的是将Map任务的输出数据高效地传输到Reduce任务中,实现数据的重新组织和分配。整个Shuffle过程涉及数据的分区、排序、传输和合并等操作。理解Shuffle机制的工作原理,有助于我们更好地优化MapReduce作业的性能,尤其是在处理大规模数据集时。

Shuffle机制的工作流程可从Map端开始,通过Shuffle过程传输数据,并在Reduce端完成数据的接收与处理。在Map端,数据会被分割并输出到本地文件系统中,等待Shuffle过程的进一步处理。接下来的内容将详细介绍Shuffle机制中的各个组成部分及其在大数据处理中的重要性。

# 2. Shuffle过程中的关键组件

### 2.1 Map阶段的数据处理

#### 2.1.1 Map端的输出格式

Map阶段是MapReduce工作流的第一个阶段,在这个阶段中,输入的数据被处理,并输出中间键值对(key-value pairs)供Shuffle阶段使用。Map端的输出格式非常关键,因为它们直接关系到Shuffle过程的效率和性能。

Map端的输出通常是一个键值对列表。每个键值对的键(key)由应用逻辑决定,而值(value)通常包含在原始数据中或者是由Map函数生成的。这些键值对需要进行排序和分区,以便于后续可以有效地传输到相应的Reduce任务。

在Apache Hadoop框架中,Map输出的键值对是序列化的,并保存在内存缓冲区中。当缓冲区满了,这些数据会被写入磁盘,形成一系列的文件。这些文件通常很小,且被分成多个部分(spills),目的是为了方便后续的排序和合并操作。

接下来是分区(Partitioning)过程,它决定了哪些键值对会被发送到哪个Reduce任务。在Hadoop中,这个过程是通过Partitioner类实现的,它会根据键的哈希值和其他逻辑来决定分区。

```java

// 伪代码示例展示Map任务输出过程

public void map(...) {

// 应用逻辑处理输入数据,生成键值对

for (/* 某种迭代 */) {

String key = /* 处理数据得出键 */;

String value = /* 处理数据得出值 */;

// 将键值对写入输出集合

context.write(key, value);

}

}

```

在上面的伪代码中,`context.write(key, value)` 会触发Map端输出操作。`key` 和 `value` 的选择取决于Map函数的业务逻辑。输出键值对的排序和分区将由后续的Shuffle组件处理。

#### 2.1.2 Partitioner的作用

Partitioner在MapReduce Shuffle过程中起着至关重要的作用。它的职责是将Map阶段的输出键值对均匀地分配到各个Reduce任务中。在数据处理中,分区是关键步骤,它直接影响到负载均衡和任务执行的效率。

在Hadoop中,默认的Partitioner是根据键的哈希值来决定分区的,基本上使用`key.hashCode() % numPartitions`来计算。然而,这种方式有时会导致数据倾斜,因为一些键的哈希值可能集中在某一个范围,造成某些Reduce任务处理的数据量远大于其他任务。

为了避免这种情况,可以自定义Partitioner来优化数据分布。例如,如果知道特定键值的分布特性,就可以根据这些特征来设计更合适的分区策略。良好的分区策略能减少数据倾斜带来的性能瓶颈。

```java

// 自定义Partitioner的伪代码示例

public class CustomPartitioner extends Partitioner<Text, IntWritable> {

@Override

public int getPartition(Text key, IntWritable value, int numPartitions) {

// 使用键的特定属性来决定分区,例如前缀或字符集

if (isKeyPrefix(key)) {

return 0; // 所有特定前缀的键值对都去第一个分区

}

// 使用默认的哈希分区逻辑

return (key.hashCode() & Integer.MAX_VALUE) % numPartitions;

}

}

```

在上面的代码中,如果键符合某种特定条件(例如,有特定的前缀),我们就可以强制将它发送到特定的分区。这提供了针对特定数据模式优化Shuffle过程的灵活性。

### 2.2 Shuffle过程中的数据传输

#### 2.2.1 数据排序和合并

Shuffle过程中的排序和合并是MapReduce框架中保证数据有序性和高效性的关键步骤。排序发生在Map任务的输出阶段,而合并则在数据被传输到Reduce端之前。通过排序和合并,Shuffle确保了每个Reduce任务可以接收到有序的数据流,这样可以加快数据处理速度并减少内存消耗。

排序操作通常发生在Map端输出的内存缓冲区填满并写入磁盘后。由于Map输出是分散在多个文件中的,因此Shuffle过程需要先对这些文件进行排序。在Hadoop中,这个过程被称为Spill阶段,它将内存中的输出数据写到磁盘,并生成一个有序的文件。

Shuffle阶段的排序是基于Map输出键(key)的。在Map任务完成后,这些有序文件会从磁盘中读取,并通过网络传输到相应的Reduce任务节点。传输之前,通常会有一个合并过程,将多个有序的文件合并为一个有序的大文件,从而减少网络传输的次数和总体的数据量。

```bash

# 示例Hadoop命令,演示Map输出文件的排序和合并

hadoop jar /path/to/hadoop-mapreduce-examples.jar sort \

-input /path/to/input_data \

-output /path/to/output_data

```

在上述命令中,`sort`是一个MapReduce程序,用于模拟排序过程。实际上,在真正的MapReduce作业中,排序和合并是由框架在后台自动完成的。

排序和合并的关键在于确保数据流的有序性,这对于Reduce任务正确处理数据至关重要。因此,排序算法的选择和合并策略的效率直接影响到整个作业的性能。

#### 2.2.2 网络通信与缓冲

Shuffle过程中网络通信是关键的一环,它涉及到Map任务输出文件的传输。数据从Map节点传输到Reduce节点时,需要高效地管理网络带宽和内存缓冲区,以确保数据传输的稳定性和流畅性。

在Hadoop中,网络通信是通过一个叫做"任务tracker"的组件来管理的。它负责调度任务并收集状态信息。当Reduce任务准备就绪后,任务tracker会向相应的Map任务发起数据拉取请求。Map任务的输出被分割成多个片段(通常称为"分片"),并异步地通过网络发送给Reduce任务。

为了避免网络拥塞和提高传输效率,Hadoop使用了多种优化技术,如心跳机制、数据压缩和流量控制。心跳机制确保了节点之间的持续通信,并提供了任务状态的及时更新。数据压缩减少了传输的数据量,而流量控制则通过控制发送速率来避免网络过载。

```java

// 伪代码示例展示网络通信中的关键步骤

public class NetworkManager {

// 节点间的通信方法

public void sendMapOutputToReduce(...) {

// 确定要发送的数据分片

DataChunk dataChunk = ...;

// 异步发送数据分片到Reduce任务

asyncSendData(dataChunk, reduceTaskAddress);

// 更新传输状态,处理可能出现的错误或重试逻辑

updateTransferStatus(dataChunk);

}

}

```

在上面的代码中,`send

0

0