MapReduce Shuffle效率提升:中间文件压缩的高招与资源节省技巧

发布时间: 2024-10-30 22:28:21 阅读量: 20 订阅数: 27

【MapReduce篇08】MapReduce优化1

# 1. MapReduce Shuffle机制概述

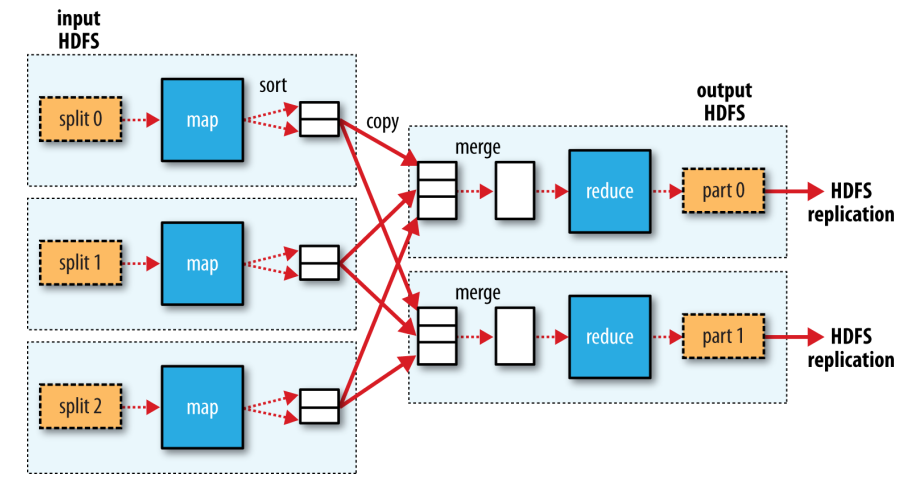

MapReduce作为大数据处理的重要框架,其Shuffle过程是保证数据处理效率的关键环节。Shuffle在MapReduce任务中负责数据的划分、排序、合并、传输等重要功能,是连接Map阶段和Reduce阶段的桥梁。该过程中,中间文件的生成和管理是 Shuffle操作的核心,它直接关系到数据处理的性能和系统资源的利用效率。本文将深入探讨MapReduce Shuffle机制的工作流程,分析中间文件在其中扮演的角色,并探索如何通过压缩技术优化中间文件的处理,从而提升整个大数据处理系统的性能。接下来的章节将详细解析中间文件的作用、挑战以及压缩技术在其中的应用,为大数据从业者提供理论和实践层面的深入理解。

# 2. MapReduce Shuffle中的中间文件分析

### 2.1 中间文件的作用与挑战

#### 2.1.1 中间文件的产生过程

MapReduce的Shuffle过程是连接Map和Reduce阶段的关键环节,它涉及到大量的数据传输和排序。在这个过程中,中间文件扮演了至关重要的角色。中间文件主要是由Map阶段输出的数据临时存储在磁盘上的文件。Map任务完成后,其输出结果需要被传输到Reduce任务,这一过程通常涉及大量的数据复制和网络传输。为了控制内存压力并降低网络传输量,Map任务会先将数据写入磁盘,形成中间文件。

在这个过程中,中间文件需要满足几个关键的要求:

- **数据持久化**:中间文件需要保证数据不因任务失败而丢失。

- **数据格式化**:中间文件需要具有良好的结构,以便于Reduce任务能够方便地读取和解析。

- **排序**:为了能够进行有效的归并操作,中间文件中的数据通常需要按键排序。

中间文件产生过程大致如下:

1. Map任务执行时,其输出数据首先存储在内存中,一旦内存达到一定阈值或者Map任务结束,内存中的数据就会被写入磁盘。

2. 写入磁盘的数据通常先存储在环形缓冲区(Spill)中,进行局部排序。

3. 排序后的数据被序列化并分割成多个片段,写入到最终的中间文件中。

4. 一旦Map任务全部完成,中间文件会被标记为可读,并通知Reduce任务来拉取数据。

#### 2.1.2 常见的中间文件问题

中间文件虽然对于整个Shuffle过程至关重要,但也存在一些常见的问题:

- **磁盘I/O瓶颈**:大量的中间文件写入操作可能会导致磁盘I/O成为性能瓶颈。

- **资源浪费**:如果中间文件的存储没有得到妥善管理,可能会导致大量的磁盘空间浪费。

- **数据传输开销**:在Shuffle过程中,大量的数据传输需要消耗大量网络资源,且在网络带宽有限的情况下,传输效率可能不高。

为了解决这些问题,就需要深入了解中间文件的压缩技术,并合理地运用压缩算法来优化整个Shuffle过程。压缩技术不仅能减少磁盘I/O的次数,还能在降低网络传输压力的同时,提升整体的计算效率。

### 2.2 压缩技术的理论基础

#### 2.2.1 压缩算法的基本原理

数据压缩算法的目的是减少数据的存储空间或传输时间,其基本原理是利用数据冗余性。数据冗余可以分为以下几种类型:

- **编码冗余**:在数据编码时,某些符号或序列出现的频率不同,可以通过更短的编码来表示高频率的符号或序列。

- **空间冗余**:相邻数据往往存在相似性或可预测性,可以通过某种方式记录差异而不是完全复制。

- **时间冗余**:在时间序列数据中,前后数据往往存在相关性,当前数据可以通过引用前面的数据加上差异来表示。

压缩算法通常分为无损压缩和有损压缩两大类:

- **无损压缩**:在不丢失任何信息的前提下减少数据量,常用的无损压缩算法包括Huffman编码、LZ77、LZ78和Deflate等。

- **有损压缩**:在允许损失一些信息的前提下大幅度减少数据量,常见的有损压缩算法包括JPEG、MP3、H.264等。

#### 2.2.2 压缩算法的性能比较

不同的压缩算法在效率、压缩率和资源消耗等方面都有所不同。性能比较通常涉及以下几个方面:

- **压缩速度**:压缩算法压缩数据的速率,通常由压缩算法的复杂度和硬件性能决定。

- **压缩率**:压缩后数据与原始数据大小的比值,压缩率越高说明压缩效果越好。

- **解压速度**:还原压缩数据到原始形式的速率。

- **内存消耗**:在压缩和解压过程中,算法对内存资源的需求。

实际应用中,需要根据不同的使用场景选择合适的压缩算法。例如,在对存储空间有限制的环境下,可以选择压缩率较高的算法;在网络带宽紧张的情况下,则需要侧重于提升压缩速度和解压速度。

### 2.3 压缩对MapReduce性能的影响

#### 2.3.1 压缩带来的资源节省

压缩技术可以在多个方面带来资源的节省:

- **磁盘空间**:通过压缩,中间文件占用的磁盘空间可以显著减少,从而降低磁盘存储压力。

- **内存使用**:在Shuffle过程中,对中间文件进行压缩可以减少内存中的数据量,降低内存资源的消耗。

- **网络带宽**:压缩数据可以减少数据在网络中的传输量,从而降低网络负载。

#### 2.3.2 压缩对Shuffle性能的双重影响

虽然压缩技术带来了资源节省的好处,但它也可能对性能产生双重影响:

- **正面影响**:

- 减少磁盘I/O操作,因为压缩后的数据体积更小,磁盘读写次数减少。

- 提高网络传输效率,压缩减少了传输的数据量,缩短了网络延迟。

- **负面影响**:

- 增加CPU计算开销,因为压缩和解压都需要额外的CPU资源。

- 可能会影响处理速度,尤其是当CPU资源成为瓶颈时。

在实际部署时,应当权衡压缩带来的优势和劣势,并适当调整压缩参数,以达到最优的性能平衡点。这需要对业务场景和硬件环境进行充分的了解,并通过测试来找到最佳的压缩配置。

# 3. 中间文件压缩技术实践应用

## 3.1 选择合适的压缩算法

### 3.1.1 压缩算法的选择标准

压缩算法的选择对于MapReduce作业的性能至关重要。合适的压缩算法可以显著减少中间文件的大小,从而减少I/O操作和网络传输的开销,提升整体性能。以下是选择压缩算法时应考虑的一些标准:

- **压缩比率**:算法的压缩效率决定了中间文件的最终大小,高比率压缩意味着更少的数据需要被处理。

- **压缩/解压速度**:在MapReduce中,压缩和解压操作是在数据传输和存储之前后进行,因此压缩和解压的速度直接影响着性能。

- **资源消耗**:压缩和解压操作会消耗CPU和内存资源,算法的选择应考虑到集群中资源的可用性和限制。

- **兼容性**:确保所选的压缩算法与Hadoop生态系统中的其他组件兼容。

- **可靠性**:压缩算法应保证数据完整性,避免压缩和解压过程中的数据损坏。

### 3.1.2 常见压缩算法在MapReduce中的应用案例

下面是一些在MapReduc

0

0