MapReduce Shuffle集群效率提升:任务并行度调整实战攻略

发布时间: 2024-10-30 22:36:16 阅读量: 21 订阅数: 29

MapReduce---CS6240:使用 MapReduce 进行并行数据处理

# 1. MapReduce Shuffle机制深度解析

MapReduce Shuffle是大数据处理中非常核心的一个环节,它负责数据的局部排序和数据传输,是保证任务高效执行的关键。在本章中,我们将深入了解MapReduce Shuffle的工作流程、数据如何在Map和Reduce之间流动,以及在此过程中可能遇到的问题和解决方案。

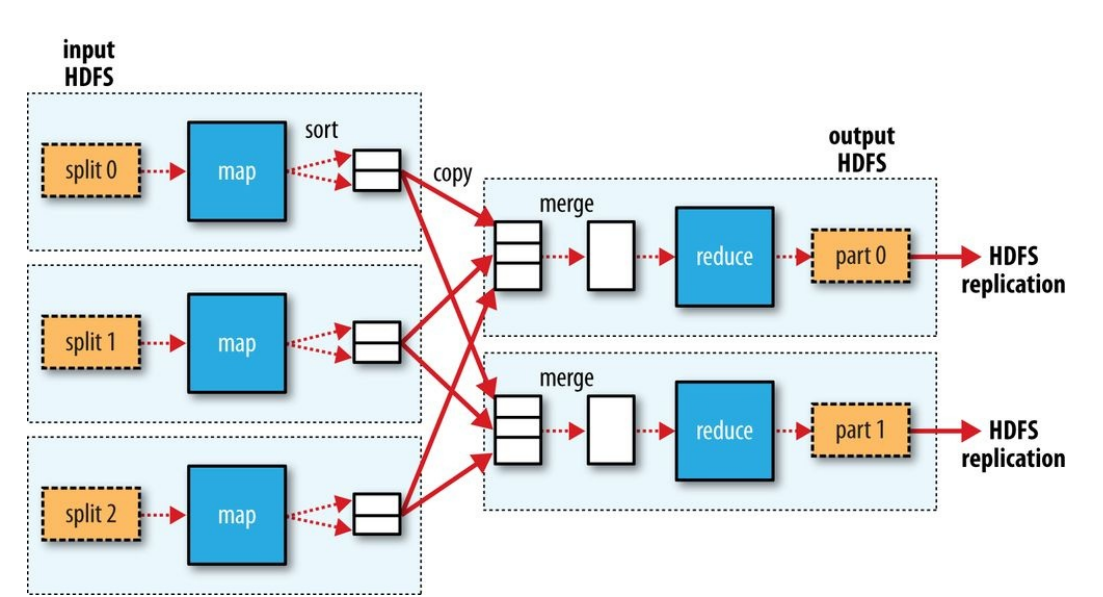

## 1.1 Shuffle流程简述

Shuffle过程涉及到了几个关键步骤:Map输出、Map输出排序、Shuffle、排序和合并、Reduce输入。Map阶段的输出文件首先会经过分区和排序,使得相同key的数据聚集在一起。之后,这些数据会被传输到Reduce任务,并在Reduce端进行合并和最终的计算处理。

## 1.2 Shuffle的关键组件

在深入分析Shuffle流程时,需要了解几个关键组件:

- **缓冲区(Buffer)**:Map输出的数据首先被写入缓冲区,在达到一定阈值后才会开始溢写到磁盘。这个阈值可以通过参数`io.sort.factor`进行设置。

- **溢写(Spill)**:当缓冲区的数据达到溢写阈值后,系统会将缓冲区的数据写入到本地磁盘上,这个过程称为溢写。

- **分区(Partitioning)**:Map输出的数据会根据key经过分区函数进行分区,确保具有相同key的数据发送到同一个Reduce任务。

- **排序(Sorting)**:Shuffle过程中,每个分区的数据都会进行排序,确保在传输到Reduce端之前,每个分区内的数据是有序的。

- **合并(Merging)**:为了减少网络传输的数据量,Shuffle过程中会对数据进行合并操作,通常在Reduce任务拉取数据之前进行。

## 1.3 Shuffle性能优化

Shuffle性能优化是一个关键环节,优化Shuffle可以显著提高大数据处理的效率。在实际应用中,可以通过调整Map和Reduce任务的内存大小、缓冲区大小、溢写比例等参数进行优化。需要注意的是,在进行Shuffle优化时,需要根据实际业务的需求和集群的配置来调整参数,以达到最佳效果。

通过本章的学习,你将掌握Shuffle的核心机制,并且学会如何从参数和资源管理两个方面来优化Shuffle过程,从而提升MapReduce作业的性能。接下来的章节将深入到任务并行度的理论基础,进一步剖析如何调整并行度来提升整个集群的资源利用率。

# 2. 任务并行度的理论基础

在大数据处理的背景下,MapReduce任务的并行度是一个关键的性能指标,它直接影响了作业的处理速度和集群的资源利用率。理解并行度的基础知识和对集群性能的影响,对于优化MapReduce作业至关重要。

## 2.1 MapReduce任务执行流程

### 2.1.1 Map阶段任务处理

Map阶段是MapReduce的第一阶段,主要任务是对输入数据进行处理,生成中间键值对。该过程涉及数据的读取、解析和初步的计算。

#### 数据读取与解析

在Map阶段,每个Map任务读取一部分输入数据块,并对数据进行解析。解析过程中,按照设定的输入格式对数据进行处理,通常会将数据分割成记录。这些记录是键值对(key-value pairs),它们被传递给用户编写的Map函数。

```java

// 示例代码:Map任务数据读取与解析的简化版本

public class MyMap {

public static class TokenizerMapper

extends Mapper<Object, Text, Text, IntWritable>{

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context

) throws IOException, InterruptedException {

// 将输入行分割成单词

String[] words = value.toString().split("\\s+");

// 输出单词和计数值1

for (String str : words) {

word.set(str);

context.write(word, one);

}

}

}

}

```

在上述示例代码中,Mapper类中的map方法读取文本输入数据,并将其分割成单词,然后为每个单词输出一个键值对。

#### Map阶段的并行处理

Map任务在多个节点上并行执行,因此可以大大提高数据处理速度。并行度是指Map任务的个数,它根据输入数据量以及集群资源进行调整。合理的并行度设置可以充分利用集群的计算能力,避免资源浪费或过载。

### 2.1.2 Reduce阶段任务处理

Reduce阶段的任务是处理Map阶段输出的中间键值对,然后输出最终结果。

#### 数据分组与排序

Reduce阶段开始之前,Map输出的中间数据会被传输到Reduce任务节点,然后按照键进行分组和排序。这个过程确保了具有相同键的键值对会被发送到同一个Reduce任务进行处理。

```java

// 示例代码:Reduce任务数据处理的简化版本

public class MyReduce {

public static class IntSumReducer

extends Reducer<Text, IntWritable, Text, IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values,

Context context

) throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result);

}

}

}

```

在上述示例代码中,Reducer类的reduce方法接收具有相同键的键值对列表,并对值进行求和操作。

#### 并行度的最终输出

在Reduce阶段,由于数据已经分组,因此可以并行地在多个Reduce任务上执行相同的操作。并行度的选择不仅影响处理速度,还可能影响输出结果的排序,尤其是当Reduce任务的数量不同时,输出结果的顺序可能会不同。

## 2.2 并行度对集群性能的影响

### 2.2.1 并行度定义和计算方式

并行度是指同时运行的任务数量。在MapReduce作业中,它通常指Map任务和Reduce任务的数量。并行度可以根据输入数据量、集群的CPU、内存和磁盘I/O资源等因素来决定。

#### 定义并行度的参数

在Hadoop中,`mapreduce.job.maps`参数用于设置Map任务的并行度,而`mapreduce.job.reduces`用于设置Reduce任务的并行度。这些参数可以通过命令行、API调用或在作业配置文件中设置。

```bash

# 设置并行度的命令行示例

$ hadoop jar

```

0

0