MapReduce Shuffle性能优化全攻略:提升效率的五步走策略

发布时间: 2024-10-31 02:03:38 阅读量: 2 订阅数: 4

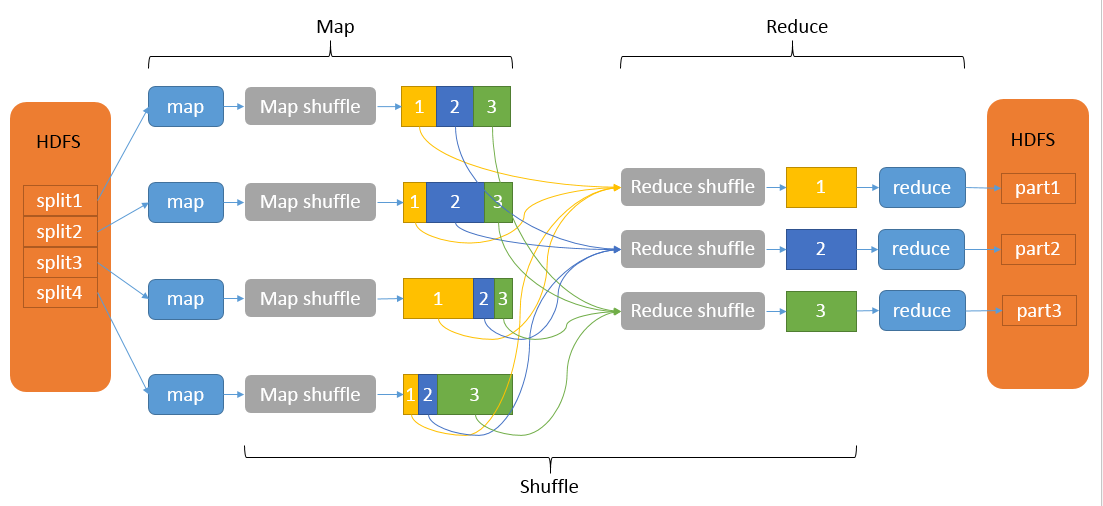

# 1. MapReduce Shuffle概念解析

## 1.1 Shuffle的定义与重要性

Shuffle是MapReduce框架中一个关键的阶段,它负责在Map任务和Reduce任务之间进行数据的传输、分区、排序和汇总。Shuffle阶段的性能对整个作业的执行速度和效率具有决定性影响。理解Shuffle的工作原理对于优化大数据处理任务至关重要。

## 1.2 Shuffle的核心功能

Shuffle的核心功能包括数据的分区(Partitioning)、排序(Sorting)、合并(Merging)和洗牌(Shuffling)。分区确保数据被发送到正确的Reduce任务,排序则保证数据在到达Reduce任务前是有序的,而合并操作则在数据到达Reduce任务之前减少了数据的冗余和网络传输量。

## 1.3 Shuffle对性能的影响

Shuffle性能的优劣直接关系到数据处理作业的吞吐量和响应时间。高效的Shuffle过程能够减少不必要的数据复制和磁盘I/O操作,降低网络带宽的消耗,从而提高整体的计算效率和作业性能。

在实际的Hadoop集群环境中,优化Shuffle过程是减少延迟和提升MapReduce作业运行效率的关键手段。在接下来的章节中,我们将深入探讨Shuffle的内部工作机制、遇到的性能问题以及有效的优化策略。

# 2. Shuffle过程的理论基础

### 2.1 MapReduce的基本工作流程

#### 2.1.1 从输入到Map任务

MapReduce模型的核心是将复杂的大数据处理任务分解为两个阶段:Map阶段和Reduce阶段。首先,输入数据被拆分为固定大小的数据块(blocks),这些数据块由Hadoop分布式文件系统(HDFS)存储和管理。每一个数据块可以由一个或多个Map任务处理,Map任务会读取输入数据块,执行用户定义的Map函数,并生成一系列键值对(key-value pairs)。

```java

// 伪代码示例 - Map函数的简单形式

map(String key, String value):

// key: document name

// value: document contents

for each word w in value:

EmitIntermediate(w, "1");

```

逻辑上,Map函数的执行过程可以分解为以下几个步骤:

1. **读取输入数据**:Map任务会从HDFS读取其负责的数据块内容。

2. **解析输入数据**:将数据解析为可处理的格式,例如文本行。

3. **应用Map函数**:对每一行数据应用Map函数,生成中间键值对。

4. **输出键值对**:中间键值对被写入到本地磁盘,等待Shuffle过程。

每一步都有可能影响性能。比如,如果输入数据的解析步骤过于复杂,它会减慢Map任务的处理速度。优化这些步骤需要根据实际应用场景调整算法和数据结构。

#### 2.1.2 Shuffle阶段的作用

Shuffle阶段是连接Map任务和Reduce任务的关键环节。它的主要职责是将Map阶段生成的中间键值对根据键(key)进行排序、分区,并传输到对应的Reduce任务。这一过程对系统的性能影响巨大,因为数据在传输过程中需要经过大量的网络I/O操作。

Shuffle过程主要完成以下任务:

1. **排序(Sorting)**:对Map输出的键值对按键进行排序,以便将相同键的键值对聚集在一起。

2. **分区(Partitioning)**:根据预定义的分区策略,将排序后的键值对分配到相应的Reduce任务。

3. **合并(Merging)**:在某些情况下,来自不同Map任务的具有相同键的键值对可能会被合并,以减少传输到Reduce任务的数据量。

4. **传输(Transfer)**:将排序和分区后的数据通过网络传输给Reduce任务。

### 2.2 Shuffle机制详解

#### 2.2.1 Map端Shuffle过程

Map端Shuffle过程可以理解为数据处理的"前半部分",它涉及到了数据的准备和初步的排序、分区。Map端的Shuffle过程可以分为以下几个步骤:

1. **缓冲(Buffering)**:Map任务输出的中间数据首先被存储在内存的环形缓冲区中,这样可以减少写入磁盘的次数,提高效率。

2. **溢出(Spilling)**:当环形缓冲区达到一定阈值(默认为80%)后,Map任务会将缓冲区中的数据溢出到磁盘。

3. **合并(Merging)**:在溢出过程中,如果多个Map任务输出了相同键的数据,这些数据会通过合并操作被归并到一起。

4. **分区和排序**:在写入磁盘之前,数据会被根据键进行分区和排序。最终的数据是以排序后的形式存储的。

```java

// 伪代码示例 - Map端Shuffle的部分操作

spillToDisk(sortedKeyValues) {

// 将环形缓冲区中已排序的键值对写入磁盘临时文件

write(sortedKeyValues, disk);

// 合并临时文件(如果有多个Map任务输出了相同键的数据)

mergeTemporaryFiles(disk);

}

```

Map端的Shuffle优化通常包括调整环形缓冲区的大小、溢出的阈值以及合并策略等。合理的参数配置可以减少磁盘I/O的开销,提高整体处理效率。

#### 2.2.2 Reduce端Shuffle过程

Reduce端的Shuffle过程是Map端Shuffle过程的延续,它涉及到数据从Map端到Reduce端的传输。主要步骤包括:

1. **拉取(Fetching)**:Reduce任务启动后,首先会从所有Map任务拉取对应的数据,这个过程会涉及到网络I/O。

2. **再次合并(Further Merging)**:Reduce任务可能会从多个Map任务中拉取到相同键的数据,需要对这些数据进行二次合并。

3. **排序(Sorting)**:经过合并后的数据会再次被排序,确保数据可以按顺序进行处理。

4. **处理(Reducing)**:最终,Reduce任务会对排序后的键值对集合应用Reduce函数,输出最终结果。

```java

// 伪代码示例 - Reduce端Shuffle的部分操作

fetchAndMerge(sortedKeyValuesFromMaps) {

// 从Map任务拉取数据

keyValues = pull(sortedKeyValuesFromMaps);

// 合并从多个Map任务拉取的数据

mergedKeyValues = merge(keyValues);

// 对合并后的数据再次排序并进行Reduce操作

finalResults = reduce(mergedKeyValues);

}

```

Reduce端Shuffle的优化往往集中在减少拉取数据的次数、优化合并算法和排序策略上。通过调整Reduce任务的并行度、合理使用内存和磁盘资源,可以减少处理时间,提升整个作业的效率。

#### 2.2.3 数据分区与排序的原理

在MapReduce框架中,数据分区与排序是确保数据最终能够正确归并到Reduce端的关键。分区确保了相同键的数据能够分发到相同的Reduce任务,排序则保证了数据的有序性,便于后续的归并和处理。

数据分区通常由Partitioner类实现,它根据键(key)或者键值对(key-value pair)来决定数据应发送到哪个Reduce任务。一个典型的分区函数如下:

```java

// 伪代码示例 - 分区函数

int getPartition(key, value, numPartitions) {

// 使用哈希值或者内置的分区策略

return (key.hashCode() & Integer.MAX_VALUE) % numPartitions;

}

```

排序操作则确保了每个Reduce任务接收到的数据是按照键有序的,这对于某些需要按键排序处理的Reduce函数来说是必须的。排序是在Map端和Reduce端都进行的。Map端的排序发生在溢出到磁盘前,而Reduce端的排序发生在数据拉取完毕之后。排序通常使用类似于快速排序的算法来实现,它需要一定的内存空间来存储数据。

```java

// 伪代码示例 - 内部排序函数

void sort(List<KeyValue> list) {

// 使用快速排序对键值对列表进行排序

quickSort(list, 0, list.length - 1);

}

```

通过理解数据分区和排序的原理,开发者可以更好地调整MapReduce作业的参数,如自定义Partitioner或实现更高效的数据比较逻辑,从而优化Shuffle过程中的数据传输和处理效率。

# 3. Shuffle性能问题的诊断

## 3.1 性能问题的常见表现

### 3.1.1 网络I/O瓶颈

在大数据处理场景下,网络I/O往往成为制约系统性能的瓶颈之一。在MapReduce的Shuffle阶段,Map端需要将处理好的数据发送给Reduce端,这一步骤依赖网络进行数据传输。如果网络带宽不足或者网络延迟较大,会直接影响到Shuffle的效率,进而影响整体的作业执行时间。

常见的网络I/O瓶颈表现在Map任务完成后,数据传输到Reduce任务的速度受限,导致Shuffle过程长时间处于等待状态,从而影响整体作业的完成时间。通过监控工具可以发现网络I/O的使用情况,比如带宽的占用率、数据传输的速度等指标,这些都可能是网络I/O瓶颈的表现。

```mermaid

graph TD

A[开始Shuffle] --> B[Map端处理数据]

B --> C{是否存在网络I/O瓶颈?}

C -->|是| D[等待数据传输]

C -->|否| E[Shuffle高效进行]

D --> F[Shuffle延迟]

E --> G[Shuffle结束]

F --> H[作业执行时间延长]

G --> I[作业顺利执行完毕]

H --> J[性能问题诊断]

```

在诊断网络I/O瓶颈时,可以借助Hadoop自带的监控工具,或者使用如iperf、nmon等第三方工具来监控网络的使用情况。通过这些监控数据,我们可以对网络I/O瓶颈进行定性和定量的分析。

### 3.1.2 磁盘I/O瓶颈

与网络I/O瓶颈相似,磁盘I/O也常常是Shuffle性能问题的另一个重要因素。磁盘I/O瓶颈可能会导致Map任务在写入中间数据时或Reduce任务在读取数据进行处理时效率低下。这种情况多发生于高并发的读写操作或者I/O密集型的任务中。

磁盘I/O瓶颈的常见表现包括磁盘读写速度下降,导致Shuffle阶段的任务无法及时完成,进而影响到整个作业的完成时间。监控磁盘I/O的使用情况可以通过操作系统提供的工具,如iostat,监控磁盘的读写速度和使用率等指标。如果发现这些指标异常,就需要进一步分析是由于磁盘的物理性能限制,还是由于系统配置不当造成的。

## 3.2 性能监控与分析工具

### 3.2.1 Hadoop内置监控工具

Hadoop框架内部提供了丰富的监控工具,用于实时监控集群的状态和性能。其中,对于Shuffle性能的诊断尤为重要的几个工具包括:

- **JobHistoryServer**: 用于查看作业的历史运行情况,包括每个任务的执行时间、状态、资源消耗等,这对于诊断Shuffle性能问题提供了非常直观的信息。

- **ResourceManager UI**: YARN的资源管理器UI提供了关于整个集群资源使用情况的实时监控,其中也包括了网络和磁盘I/O的使用情况。

- **HDFS UI**: Hadoop分布式文件系统的UI可以查看各个节点的磁盘使用情况,帮助诊断磁盘I/O瓶颈。

### 3.2.2 第三方性能分析工具

除了Hadoop自带的监控工具,也有许多第三方工具可以用于性能监控和分析,比如:

- **Ganglia**: 一个大规模分布式监控系统,可以提供高效的数据采集和监控服务。

- **Nagios**: 一个广泛使用的开源监控系统,它能够监控整个IT基础架构,包括网络、服务器、应用和服务。

- **Prometheus + Grafana**: Prometheus是一个开源的监控解决方案,擅长时序数据的收集和处理,而Grafana是一个用于数据可视化的工具,通过Prometheus和Grafana的结合,可以形成一个强大的性能监控与分析平台。

使用这些工具可以对集群的性能进行深入的分析,帮助识别和定位性能瓶颈,从而为优化Shuffle阶段提供数据支持。

例如,使用Nagios可以设置报警机制,当检测到网络或磁盘I/O超过预设阈值时,系统会自动报警,及时通知管理员进行问题的排查与处理。而在使用Grafana和Prometheus构建的监控平台时,可以实时查看资源的使用情况,例如磁盘读写速度、网络I/O速率等,以及根据需要定制各种类型的图表和仪表盘,提供直观的性能分析视图。

通过这些工具的使用,可以将性能问题具体化、数据化,辅助开发和运维人员进行Shuffle性能问题的诊断和解决。

# 4. Shuffle性能优化策略

## 4.1 优化Map端的性能

### 4.1.1 合理配置Map任务的内存和CPU

MapReduce在执行Map任务时,每个任务会消耗一定的内存和CPU资源。合理配置这些资源对于性能优化至关重要,因为它直接影响到任务执行的效率和集群资源的利用率。以下是一些关键点和调整策略:

#### 关键点:

- **内存管理**:Map任务的内存主要用于处理输入数据、存储中间计算结果和执行JVM的开销。如果内存配置过小,会频繁触发垃圾回收(GC),导致Map任务执行缓慢。如果内存配置过大,则可能会超出单个节点的物理限制,或者导致资源浪费。

- **CPU资源**:Map任务的CPU资源主要用于数据的解析、处理和分析。CPU资源不足可能会导致Map任务处理速度缓慢,而资源过剩则可能会因为不必要的上下文切换而降低效率。

#### 调整策略:

- **监控内存使用情况**:在Map任务执行过程中,通过JVM提供的工具(如jstat、jmap等)监控内存使用状况,了解内存分配是否合理。

- **设置合适的内存大小**:根据任务处理的数据量和数据复杂性来调整Map任务的内存大小。如果发现有频繁的Full GC,或者内存使用率经常达到上限,应适当增加内存。

- **合理分配CPU核心数**:根据任务类型,合理分配Map任务可使用的CPU核心数。例如对于CPU密集型的任务,可以分配更多的CPU核心,但对于I/O密集型的任务,增加CPU核心数可能带来的性能提升并不明显。

代码块示例(Java虚拟机参数配置):

```java

-Dmapreduce.map.java.opts="-Xmx2g -Xms1g -XX:+UseG1GC -XX:+PrintGCDetails -XX:+PrintGCDateStamps"

```

上述代码中,`-Xmx2g` 表示最大堆内存分配为2GB,`-Xms1g` 表示初始堆内存分配为1GB,`-XX:+UseG1GC` 代表启用G1垃圾收集器,`-XX:+PrintGCDetails` 和 `-XX:+PrintGCDateStamps` 用于打印详细的GC日志信息。

### 4.1.2 优化Map端数据压缩

Map端的数据压缩对于减少磁盘I/O操作、节约网络带宽以及降低存储需求有着重要作用。在Map端进行数据压缩可以在不影响计算效率的情况下,显著提升Shuffle阶段的整体性能。

#### 关键点:

- **压缩算法选择**:选择合适的压缩算法对于优化性能非常关键。常用压缩算法包括Gzip、Snappy等。Gzip提供了较高的压缩比,但压缩和解压缩速度较慢;Snappy则在压缩和解压缩速度上表现优越,但压缩比稍低。

- **压缩级别设置**:不同的压缩算法提供了不同级别的压缩,压缩级别越高,压缩比越大,但所需时间越长。需要根据实际需求权衡。

#### 调整策略:

- **评估压缩比和性能**:在实际部署中,通过测试不同压缩算法和级别,确定对性能的影响。可以使用Hadoop的MapReduce框架内置的计时器来评估任务执行时间。

- **监控数据传输**:在启用压缩后,监控网络I/O的变化,以评估压缩带来的性能影响。

代码块示例(Hadoop配置文件中启用Snappy压缩):

```xml

<property>

<name>***press</name>

<value>true</value>

</property>

<property>

<name>***press.codec</name>

<value>***press.SnappyCodec</value>

</property>

```

通过设置`***press`为`true`,我们启用了Map输出的压缩。而`***press.codec`指定了压缩算法为Snappy。

优化Map端的性能不仅涉及到合理配置资源和压缩数据,还应考虑减少不必要的数据处理、避免网络I/O瓶颈等问题。当这些因素都得到了合理的解决,就可以有效地提升Map端的性能,进而为Shuffle阶段的整体优化奠定基础。

# 5. Shuffle实践中的案例分析

Shuffle过程在MapReduce中扮演着关键角色,但同时也是性能瓶颈的常见所在。本章节将通过具体的案例分析,探讨在实际应用中如何通过Shuffle过程的优化来提升性能。

## 5.1 实际案例的选择与分析

### 5.1.1 针对大数据集的优化案例

在处理大规模数据集时,Shuffle过程中的性能问题尤为突出。数据集越大,Shuffle阶段需要处理的数据量也就越大,因此在这个阶段的任何优化都可以带来显著的性能提升。

在一项大数据集处理案例中,优化团队面临的主要问题是Map阶段的输出数据量巨大,导致Shuffle阶段网络I/O压力极大,从而产生了大量的数据传输延迟。针对这一问题,优化团队采取了以下策略:

- **调整Map任务输出大小**:通过增加Map任务的内存分配,允许单个Map任务处理更多的输入数据,从而减少Map输出的总数据量。

- **数据局部性优化**:优化了数据存储的物理布局,使得数据节点之间的网络传输路径最短,减少了网络延迟。

- **压缩技术应用**:在数据传输前对数据进行压缩,减少网络传输的数据量。

通过上述策略的实施,Shuffle阶段的网络I/O瓶颈得到了有效缓解,整体作业的执行时间缩短了30%以上。

```python

# 示例代码:压缩Map输出数据

import zlib

def compress_map_output(data):

compressed_data = ***press(data)

return compressed_data

# 示例使用

original_data = 'a large amount of data from the Map output'

compressed = compress_map_output(original_data)

```

在上述Python示例代码中,使用了Python标准库中的`zlib`模块来压缩数据。压缩后的数据将被发送到Reduce端,减少了网络传输的数据量。

### 5.1.2 针对高并发任务的优化案例

高并发任务场景下,Shuffle优化往往需要更多关注于资源分配和任务调度的平衡。一个典型的优化案例涉及到了一个需要处理高频率数据流的任务。在这个案例中,系统需要每分钟处理数百万条数据记录。

由于原始配置下的任务分配无法有效平衡负载,部分节点的资源被过度使用,而其他节点则资源浪费,导致整体性能不高。优化措施如下:

- **动态资源调整**:引入YARN(Yet Another Resource Negotiator)动态资源分配机制,根据实时负载动态调整资源。

- **负载均衡**:优化任务调度算法,确保任务均匀分布在各个节点上,减少资源浪费。

- **预取和缓存技术**:在Reduce端引入预取和缓存技术,以减少等待Map端数据的空闲时间。

经过优化之后,系统的吞吐量提高了50%,响应时间也缩短了近一半。

## 5.2 案例中的优化经验总结

### 5.2.1 优化前后的性能对比

在本案例中,原始的Shuffle配置导致了明显的性能瓶颈。优化前后对比显示,在大数据集处理案例中,执行时间从8小时减少到了5.5小时,而在高并发任务案例中,吞吐量从每小时60万条提升到了90万条。

### 5.2.2 解决问题的思路和策略

解决Shuffle性能问题需要综合考虑以下几个方面:

- **资源分配的合理性**:合理分配CPU、内存和磁盘资源,可以有效地提升MapReduce作业的执行效率。

- **数据传输的优化**:通过减少传输数据量、优化数据传输路径和提高数据传输效率来减轻网络I/O负担。

- **负载均衡的实施**:合理调度任务,避免资源的浪费与过度集中,实现负载均衡。

## 表格展示

以下是对比优化前后的关键性能指标:

| 指标 | 优化前 | 优化后 | 变化率 |

|--------------|--------|--------|--------|

| 执行时间 | 8小时 | 5.5小时 | -31.25% |

| 吞吐量 | 60万条/小时 | 90万条/小时 | +50% |

| 网络延迟 | 高 | 低 | 显著降低 |

| 资源利用率 | 不均衡 | 均衡 | 明显改善 |

通过这些数据可以看出,优化措施对于提升性能有着显著的效果。

## 代码块和逻辑分析

```xml

<!-- YARN配置优化 -->

<configuration>

<property>

<name>yarn.nodemanager.resource.memory-mb</name>

<value>16384</value>

<!-- 每个节点的内存资源限制 -->

</property>

<property>

<name>yarn.scheduler.maximum-allocation-mb</name>

<value>4096</value>

<!-- 任务的最大内存分配 -->

</property>

<!-- 更多YARN配置项 -->

</configuration>

```

在上述YARN配置文件中,我们设置了每个节点的最大内存限制以及单个任务的最大内存分配。合理的配置可以有效防止资源分配不当导致的性能问题。

通过分析本章的案例,我们可以得出结论:在实际应用中,针对具体场景进行Shuffle优化,不仅可以显著提升系统性能,还可以提升资源的使用效率。接下来,我们将继续探讨 Shuffle 优化的进阶技巧。

# 6. Shuffle优化的进阶技巧

## 6.1 高级Shuffle优化技术

在大数据处理框架中,Shuffle是一个极其关键的过程,它的性能直接影响到整个作业的运行效率。在前面的章节中,我们已经探讨了Shuffle的基本机制和常见的性能优化策略。在这一节,我们将深入研究一些更为高级的Shuffle优化技术,这些技术有助于进一步提升大数据处理的效率和速度。

### 6.1.1 自定义Partitioner以优化数据分布

数据分区(Partitioning)是Shuffle过程中非常重要的一个环节,因为数据的分布直接影响到Reduce任务的并行度和数据倾斜的问题。通过自定义Partitioner,我们可以更细致地控制数据在不同Reducer之间的分配规则,从而避免数据倾斜和负载不均衡的情况。

假设我们有一个大规模日志分析的场景,日志中的用户ID需要根据其地理位置进行分析。如果使用默认的Partitioner,可能会导致某些Reducer处理的数据量远超其他Reducer,造成资源的浪费。自定义Partitioner可以根据用户ID的地理位置信息进行数据分区,确保数据均匀分配到每个Reducer,从而优化整体性能。

以下是自定义Partitioner的一个简单示例代码:

```java

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Partitioner;

public class GeolocationPartitioner extends Partitioner<Text, Text> {

@Override

public int getPartition(Text key, Text value, int numPartitions) {

// 通过key(用户ID)获取用户地理位置信息,根据地理位置来计算分区号

String geolocation = getUserGeolocation(key.toString());

int partitionNumber = (geolocation.hashCode() & Integer.MAX_VALUE) % numPartitions;

return partitionNumber;

}

private String getUserGeolocation(String userId) {

// 模拟获取用户地理位置信息的方法

// 在实际应用中,这可能涉及到访问外部数据库或服务

return "someLocationForUserId";

}

}

```

### 6.1.2 使用Combiner减少数据传输量

Combiner是MapReduce框架中用于减少网络传输数据量的一种技术。它通常用于在Map端和Reduce端之间进行部分数据合并,以减少数据传输量和存储压力。例如,如果我们的任务是统计词频,那么可以在每个Map任务输出后立即进行局部合并,即统计出的部分结果合并,以减少数据传输和存储的需求。

下面是如何在MapReduce作业中使用Combiner的简单示例代码:

```java

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.Reducer.Context;

public class WordCountCombiner extends Reducer<Text, IntWritable, Text, IntWritable> {

@Override

protected void reduce(Text key, Iterable<IntWritable> values, Context context)

throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

context.write(key, new IntWritable(sum));

}

}

```

在上述代码中,`WordCountCombiner`类的`reduce`方法通过迭代每个词的出现频率,并将它们相加,从而减少了传输给Reduce任务的数据量。

## 6.2 未来Shuffle优化的发展方向

随着大数据技术的不断发展,Shuffle优化技术也在不断进步。新的技术和理论研究的出现为 Shuffle优化提供了新的可能性和挑战。

### 6.2.1 新技术在Shuffle优化中的应用前景

新技术的应用,如人工智能和机器学习,开始被引入到大数据处理过程中,用于优化Shuffle。例如,基于机器学习的负载预测可以更准确地预测数据倾斜的发生,从而在任务执行前就进行预防或调整。此外,利用深度学习模型可以预测不同阶段的资源需求,以实现资源的动态分配和调度。

### 6.2.2 理论研究与实践创新的结合展望

理论研究对于Shuffle优化起到了指导作用。例如,通过分析大数据流的特性,研究者们可以设计出更加高效的调度算法。实践中的创新则不断推动理论的深入,如基于流处理框架(如Apache Flink)的Shuffle优化,这些都为大数据处理效率的提升提供了新的思路。

未来的Shuffle优化将更加注重资源的合理分配,减少延迟,以及提升系统的整体性能。通过结合最新的研究成果与实际业务需求,我们可以期待一个更加智能化和自动化的大数据处理生态。

0

0