MapReduce Shuffle终极指南:掌握数据流动的十大秘诀

发布时间: 2024-10-31 01:56:28 阅读量: 23 订阅数: 27

掌握 MapReduce 核心:ReduceTask 数据处理全解析

# 1. MapReduce Shuffle原理概述

MapReduce Shuffle是Hadoop框架中一个核心组件,它负责对Map阶段输出的数据进行排序、分区和传输,确保Reduce阶段能够正确地接收和处理相应的数据片段。Shuffle过程通常被认为是MapReduce性能的瓶颈之一,因此理解其原理对于优化MapReduce作业至关重要。

## 1.1 Shuffle过程的必要性

Shuffle过程涉及到大量的网络传输和磁盘I/O操作,这些操作对于处理大规模数据集至关重要。如果Shuffle过程管理不当,就会导致数据传输缓慢或磁盘I/O饱和,从而降低整体作业效率。

## 1.2 Shuffle的主要步骤

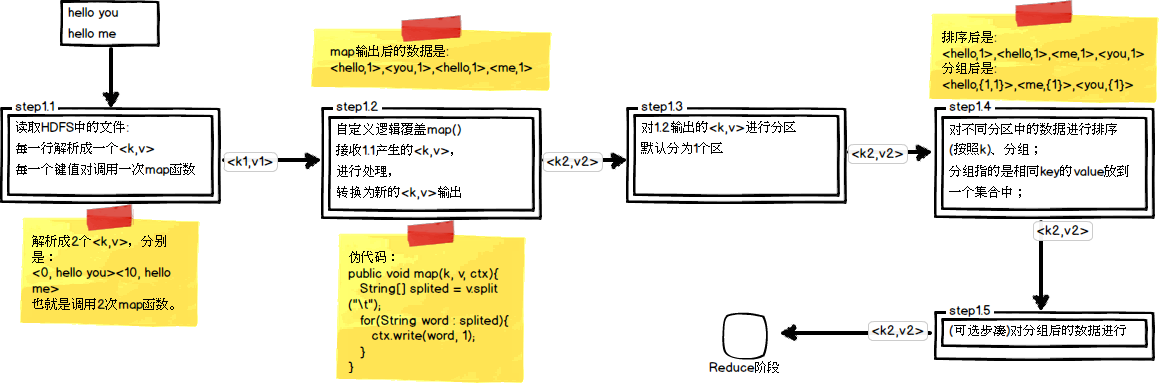

Shuffle过程可以概括为以下几个主要步骤:

- **Map端处理**:Map任务处理输入数据后,会按照一定的规则将中间结果写入到本地磁盘。

- **Shuffle操作**:Map端的输出文件被分割成数据块,这些数据块被传输到Reduce端。

- **Reduce端处理**:Reduce任务读取传输过来的数据块,对数据进行合并、排序,并进行最终的处理。

理解这些步骤有助于我们更好地进行Shuffle优化,以提高作业性能。接下来的章节中,我们将详细探讨Shuffle的理论基础和实践技巧,帮助读者深入挖掘MapReduce Shuffle的潜能。

# 2. MapReduce Shuffle的理论基础

### 2.1 数据局部性原理

#### 2.1.1 数据局部性原理简介

数据局部性原理是计算机系统设计和优化中的一个重要概念,它描述了程序在执行过程中对数据访问的局部性特征。该原理通常分为时间局部性和空间局部性两个方面。时间局部性指的是如果一个数据项被访问,那么它在近期很可能再次被访问。空间局部性指的是如果一个数据项被访问,那么它附近的数据项也很可能在不久的将来被访问。

在MapReduce Shuffle过程中,数据局部性原理被用来减少数据传输和提高处理效率。例如,在Map阶段,数据通常会就近读取和处理,而不需要远程传输,这样可以大大减少网络I/O的压力。同样,在Reduce阶段,数据的局部性也影响着排序和合并的效率。

#### 2.1.2 数据局部性与Shuffle性能关系

Shuffle性能的优劣直接影响到MapReduce作业的最终性能。数据局部性的运用可以显著提升Shuffle阶段的效率。如果数据局部性差,大量数据需要跨网络传输,会增加延迟,并影响到整个作业的吞吐量。

### 2.2 Shuffle的关键组件

#### 2.2.1 Map端组件分析

在MapReduce框架中,Map端的主要组件包括InputFormat、Mapper以及输出到磁盘的缓存机制。

- **InputFormat**: 定义了如何读取输入数据。它决定了数据将如何分割成输入分片(input splits),以及如何创建记录读取器(record reader)来读取数据。

- **Mapper**: 处理输入分片中的数据,并输出键值对(key-value pairs)。Mapper的输出会被Shuffle过程收集并传送到Reduce任务。

- **缓存机制**: 在Map端,有一个缓冲区用于存储中间结果。当缓冲区快满时,会触发溢写操作,将数据写入磁盘,避免内存溢出。

#### 2.2.2 Reduce端组件分析

Reduce端的主要组件包括Shuffle过程、Reducer以及输出机制。

- **Shuffle过程**: 负责收集Map端的输出结果,通过网络传输到Reduce任务。这个过程中包括数据的排序、分区以及聚合操作。

- **Reducer**: 对每个分区中的数据进行处理,它读取的是经过Shuffle排序和分区后的数据。

- **输出机制**: Reduce任务的输出可以是HDFS、HBase等存储系统,也可以输出为新的MapReduce作业的输入。

### 2.3 数据排序和分区机制

#### 2.3.1 排序过程详解

排序是Shuffle过程中至关重要的一步,它确保了数据能够以一种有序的方式发送到Reduce任务中。

Map端排序发生在数据写入到磁盘之前,Map任务输出的数据首先会经过一个排序过程,通常称为"局部排序"。这个过程确保了每个Map输出文件中的数据是有序的。

在Reduce端,Shuffle过程会读取来自各个Map任务的输出文件,并将数据根据key进行合并排序,形成最终的有序数据流。这个过程需要将来自不同Map任务的数据进行全局排序。

#### 2.3.2 分区策略及其作用

分区是将数据均匀分配给不同Reduce任务的过程。在Shuffle过程中,分区策略决定了某个key将被发送到哪个Reduce任务。

分区机制通常基于key的哈希值进行分区,以确保相同key的数据总是被发送到同一个Reduce任务。这样的策略有利于保证输出数据的顺序性和一致性。

分区策略影响着数据在Reduce端的分布均匀性,对于性能有着直接的影响。如果某个Reduce任务接收到的数据量过大,可能会成为瓶颈,影响整个作业的性能。

```markdown

| 分区策略 | 描述 | 优点 | 缺点 |

|-----------|------|------|------|

| 哈希分区 | 根据key的哈希值进行分区 | 实现简单,能够保证相同key的数据聚集在一起 | 不同分区的数据量可能不均衡 |

| 范围分区 | 根据key的范围划分分区 | 数据分布更均匀 | 需要提前知道数据的分布范围 |

| 自定义分区 | 根据特定需求定制分区逻辑 | 灵活性高,可满足复杂场景的需求 | 实现复杂度高,需要深入了解数据特性 |

```

通过合理设计分区策略,可以优化MapReduce作业的性能,避免数据倾斜问题,提升数据处理效率。

# 3. MapReduce Shuffle实践技巧

## 3.1 优化Map端Shuffle

### 3.1.1 缓冲机制与溢写策略

在MapReduce框架中,Map端Shuffle的一个关键优化点是其缓冲机制。为了减少对磁盘I/O的冲击,Map任务会将输出的键值对先存储在内存的缓冲区中,直到达到一定的阈值(通常为80%的内存容量)。然后,这些键值对会被批量写入到磁盘,这个过程称为溢写(spill)。溢写操作是影响Map端Shuffle性能的重要因素,因此合理的溢写策略对性能至关重要。

为了优化溢写过程,可以采取以下措施:

- **增加缓冲区大小**:通过增加缓冲区的大小,可以存储更多的数据,从而减少溢写的次数。但是,过大的缓冲区会增加内存压力,甚至可能导致内存溢出错误(OOM)。

- **调整溢写阈值**:调整触发溢写的阈值可以优化性能。如果阈值设置得太高,可能会导致内存不够用;如果设置得太低,则可能增加溢写次数,从而降低性能。

- **选择合适的压缩算法**:对缓冲区中的数据进行压缩可以减少对磁盘的写入量,但是会增加CPU的使用率。需要根据实际情况权衡内存使用、CPU消耗和磁盘I/O。

下面是一个简单的Java代码示例,用于展示如何在MapReduce作业中调整缓冲区大小和溢写阈值:

```java

// 设置Map端的缓冲区大小为256MB

conf.setInt("mapreduce.task.io.sort.mb", 256);

// 设置溢写的阈值为缓冲区大小的80%

conf.setFloat("mapreduce.map.sort.spill.percent", 0.8f);

```

通过以上参数调整,可以有效控制内存的使用情况和溢写的频率,从而提高Map端Shuffle的效率。

### 3.1.2 压缩技术的选择与应用

在MapReduce的Shuffle过程中,数据压缩可以显著减少网络传输和磁盘I/O的负担。选择合适的压缩技术可以提高整体的数据处理速度。常用的压缩技术包括LZO、Snappy和Gzip等。

在Map端进行压缩的主要优点有:

- **减少磁盘占用**:压缩后的数据占用更少的磁盘空间,节省存储资源。

- **加快写入速度**:由于数据量减少,磁盘写入速度会变快。

- **减少网络带宽使用**:在Shuffle过程中,压缩的数据减少了网络传输的数据量。

然而,压缩技术也有其缺点:

- **增加CPU使用率**:压缩和解压缩数据需要额外的CPU资源。

- **可能降低处理速度**:如果压缩速度赶不上数据产生速度,可能会导致Map任务的输出缓冲区溢出,从而增加溢写次数。

选择压缩技术时,需要根据具体的应用场景和资源情况来决定。例如,如果磁盘I/O成为瓶颈,可以使用LZO或Snappy这种压缩速度快、压缩率适中的算法。如果网络带宽是瓶颈,那么使用Gzip这种压缩率更高但速度稍慢的算法可能更合适。

下面是一个代码示例,演示如何在MapReduce作业中指定使用Snappy压缩算法:

```java

// 设置Map端输出压缩类型为Snappy

conf.set("***press.codec", "***press.SnappyCodec");

```

通过合理配置和选择压缩技术,可以进一步提升Map端Shuffle的性能。

## 3.2 优化Reduce端Shuffle

### 3.2.1 合并排序与内存管理

Reduce端Shuffle的性能主要取决于合并排序过程和内存管理。在Shuffle阶段,所有Map任务输出的数据会通过网络传输到Reduce任务节点。Reduce任务需要对这些数据进行排序和合并,以便进行后续处理。

合并排序是指在数据到达Reduce端之前,对Map输出的数据进行局部排序和合并,以减少Reduce任务需要处理的数据量。这一过程对内存的需求较高,因此合理的内存管理非常关键。

为了优化合并排序和内存管理,可以采取以下措施:

- **设置合理的内存和CPU资源**:确保Reduce任务有足够的内存和CPU资源来处理数据排序和合并。

- **调整缓冲区大小**:通过调整Reduce任务的缓冲区大小,可以控制内存中保留的数据量。

- **使用内存中的数据结构**:利用内存中的数据结构(如堆)进行数据合并和排序,可以提高效率。

- **增加并行处理任务**:通过调整Reduce任务的并行度,可以更合理地分配和使用资源。

下面是一个配置示例,展示如何在MapReduce作业中调整Reduce端的缓冲区大小:

```java

// 设置Reduce端的缓冲区大小为512MB

conf.setInt("mapreduce.reduce.sort.buffer.size", 512 * 1024 * 1024);

```

通过上述优化措施,可以提升Reduce端Shuffle的性能,进而加快整个MapReduce作业的执行速度。

### 3.2.2 Reduce任务的并行度调控

Reduce任务的并行度是指同时运行的Reduce任务的数量。并行度设置过高或过低都可能影响MapReduce作业的性能。

- **过低的并行度**:会导致Reduce任务处理时间增长,进而导致整个作业的完成时间变长。

- **过高的并行度**:可能会导致集群资源利用不均衡,增加任务调度和管理的开销。

合理调整Reduce任务的并行度,需要根据集群资源和作业特性综合考虑。通常,可以依据以下标准进行调整:

- **数据量大小**:数据量大的情况下,增加并行度可以加快数据处理速度。

- **集群资源**:考虑集群的CPU、内存等资源使用情况,确保资源充分利用,但又不至于过载。

- **任务特性**:对于需要大量CPU处理或者复杂计算的任务,降低并行度以保证足够的资源分配给每个Reduce任务。

可以通过下面的代码示例,展示如何在MapReduce作业中动态设置Reduce任务的并行度:

```java

// 假设集群资源充足,且预计数据量较大,可以设置较高的并行度

JobConf job = new JobConf();

job.setNumReduceTasks(50); // 设置Reduce任务的并行度为50

```

通过合理设置Reduce任务的并行度,可以有效提升MapReduce作业的总体性能。

## 3.3 Shuffle过程的监控与诊断

### 3.3.1 关键性能指标监控

为了确保MapReduce作业能够高效运行,监控Shuffle过程中的关键性能指标至关重要。关键的性能指标主要包括:

- **任务运行时间**:包括Map任务和Reduce任务的运行时间。长时间运行的任务可能表明存在问题。

- **网络I/O**:Shuffle过程中,网络传输的数据量和速度是影响性能的关键因素。

- **磁盘I/O**:磁盘的读写速度会直接影响Map端和Reduce端的Shuffle性能。

- **内存使用情况**:内存的使用情况,尤其是缓冲区的使用情况,对Shuffle性能有直接影响。

- **CPU负载**:CPU的使用率过高可能表明Shuffle过程中的某些环节存在瓶颈。

为了监控这些性能指标,可以使用Hadoop自带的监控工具,如JobHistoryServer,或者第三方的监控平台,如Ganglia和Nagios。这些工具可以提供实时监控,并能生成历史报告,便于分析和诊断。

### 3.3.2 常见问题的诊断与解决

在MapReduce的Shuffle过程中,可能会遇到各种性能问题。一些常见的问题及其诊断和解决方法如下:

- **内存溢出问题**:如果Map端或Reduce端的缓冲区过小,可能会导致内存溢出错误。解决方法是适当增加缓冲区大小或调整溢写策略。

- **网络带宽饱和问题**:如果Shuffle过程中的网络传输量过大,可能会导致网络带宽饱和。解决方法是优化Shuffle过程中的数据传输策略,比如调整压缩算法、减少不必要的数据传输等。

- **磁盘I/O瓶颈问题**:过高的磁盘I/O负载可能会导致Shuffle性能下降。解决方法是增加磁盘I/O资源,比如使用更快的SSD磁盘,或者优化数据读写策略。

- **数据倾斜问题**:数据倾斜会使得某些Reduce任务的处理时间远高于其他任务。解决方法是进行数据预处理,比如使用自定义的Partitioner来更均匀地分配数据。

通过以上监控和诊断方法,可以有效地识别和解决MapReduce Shuffle过程中的性能问题,确保作业的高效运行。

# 4. MapReduce Shuffle高级应用

在第三章我们了解了MapReduce Shuffle的实践技巧,并对优化技术和监控诊断有了初步的掌握。现在我们将深入探讨一些高级应用,这将帮助我们更好地理解Shuffle机制以及如何在复杂场景中运用它。

## 4.1 自定义Partitioner

MapReduce框架通过Partitioner组件决定Map输出的中间数据传输到哪个Reduce任务。默认情况下,MapReduce使用哈希分区策略,但根据特定的业务需求,我们可以自定义Partitioner来控制数据的分配。

### 4.1.1 Partitioner的作用与设计

Partitioner的作用是在Map输出和Reduce输入之间建立映射关系。这允许开发者根据业务逻辑优化数据的分布,提高数据处理的效率。

```java

public class CustomPartitioner extends Partitioner<Text, IntWritable> {

@Override

public int getPartition(Text key, IntWritable value, int numPartitions) {

// 自定义分区逻辑

int hash = key.hashCode();

return hash % numPartitions;

}

}

```

逻辑分析:上面的代码展示了如何实现一个简单的自定义Partitioner。在这里,Partitioner通过取key的哈希值,并使用模运算得到一个介于0到numPartitions-1之间的整数,代表不同的Reduce任务索引。

参数说明:`numPartitions`参数表示Reduce任务的数量,这是在初始化作业时设置的。`key`和`value`是Map输出键值对,键值对将被分配到相应的Reduce任务中。

### 4.1.2 自定义Partitioner案例分析

让我们来看一个更具体的案例,比如处理日志文件时,我们可能希望将同一IP地址的日志数据分配到同一个Reducer上进行处理。

```java

public class LogPartitioner extends Partitioner<IPWritable, LogWritable> {

@Override

public int getPartition(IPWritable key, LogWritable value, int numPartitions) {

// 用IP地址的哈希值进行分区

return Math.abs(key.getIP().hashCode()) % numPartitions;

}

}

```

逻辑分析:`IPWritable`和`LogWritable`分别代表了自定义的键和值类型。`IPWritable`包含IP地址信息,我们使用其哈希值来决定数据应该传输到哪个Reducer。

这个案例展示了自定义Partitioner的灵活性和实用性,根据业务需求,Partitioner可以设计得非常复杂,以解决特定的数据处理问题。

## 4.2 自定义WritableComparable

自定义数据类型是MapReduce编程中的另一个高级话题。`WritableComparable`接口继承自`Writable`和`Comparable`,允许开发者定义如何序列化和比较键值对数据。

### 4.2.1 WritableComparable接口详解

`WritableComparable`接口提供了`write(DataOutput out)`和`readFields(DataInput in)`方法,用于序列化和反序列化数据。同时,它也提供了`compareTo(WritableComparable o)`方法,用于定义键的排序逻辑。

```java

public class CustomWritable implements WritableComparable<CustomWritable> {

private IntWritable customKey;

private Text customValue;

@Override

public void write(DataOutput out) throws IOException {

customKey.write(out);

customValue.write(out);

}

@Override

public void readFields(DataInput in) throws IOException {

customKey.readFields(in);

customValue.readFields(in);

}

@Override

public int compareTo(CustomWritable o) {

***pareTo(o.customKey);

}

}

```

逻辑分析:在这个例子中,我们定义了一个自定义的Writable类型`CustomWritable`,它包含一个`IntWritable`类型的`customKey`和一个`Text`类型的`customValue`。我们覆写了`compareTo`方法,使得我们可以对`customKey`进行排序。

### 4.2.2 自定义数据类型实现高级功能

自定义数据类型的主要优势在于可以利用`WritableComparable`接口来实现一些高级功能,例如自定义排序规则。

```java

public class CustomWritable implements WritableComparable<CustomWritable> {

// ... (省略其他方法实现)

@Override

public int compareTo(CustomWritable o) {

int thisValue = customKey.get();

int thatValue = o.customKey.get();

return (thisValue < thatValue ? -1 : (thisValue == thatValue ? 0 : 1));

}

}

```

逻辑分析:在这个重写的`compareTo`方法中,我们定义了以`customKey`的自然顺序进行排序,这表明自定义Writable类型可以与Java的比较机制无缝集成。

## 4.3 Shuffle流的优化技术

在Shuffle过程中,优化数据流的传输对性能至关重要。高效的Shuffle流优化可以减少网络I/O,提高整体处理速度。

### 4.3.1 网络带宽优化策略

合理分配网络资源是优化网络带宽的关键。为了减少Map到Reduce的数据传输量,我们可以通过减少中间数据的大小来实现。

```java

// 使用Map输出压缩

conf.setBoolean("***press", true);

conf.setClass("***press.codec",

***press.SnappyCodec.class,

***pressionCodec.class);

```

逻辑分析:在这个配置中,我们设置了Map输出的压缩选项,这样可以减少写入到磁盘的数据量,进而降低网络传输的压力。

### 4.3.2 远程写入性能提升技巧

对于大规模的MapReduce作业,远程写入可能会成为瓶颈。通过优化网络协议和调整参数,可以显著提高性能。

```java

// 使用高速网络传输协议

conf.set("fs.defaultFS", "hdfs://高性能集群地址");

```

逻辑分析:设置高性能的HDFS集群地址可以提高数据读写的效率,因为这涉及到数据在网络中的传输速度。

在本章节中,我们探讨了MapReduce Shuffle高级应用,包括自定义Partitioner、自定义WritableComparable以及Shuffle流的优化技术。通过这些高级技巧,我们可以进一步提升MapReduce作业的性能,并满足更复杂的数据处理需求。在下一章节,我们将把目光转向MapReduce Shuffle在大数据处理中的应用,探索它在真实场景中的调优和集成技巧。

# 5. MapReduce Shuffle在大数据处理中的应用

## 5.1 大数据处理中的Shuffle调优

### Shuffle调优原则与方法

在大数据处理中,Shuffle阶段是性能调优的关键。为了达到最优的性能,我们应当遵循以下调优原则和方法:

1. **减少数据倾斜**:数据倾斜是Shuffle阶段性能下降的主要原因之一。通过合理设计Map和Reduce任务的键值,可以避免数据倾斜现象,使数据更均匀地分布在各个Reducer上。

2. **合理设置内存大小**:适当增加Map和Reduce任务可用的内存大小可以减少磁盘I/O操作,但要注意不要设置过大,避免触发JVM的垃圾回收机制。

3. **选择合适的压缩格式**:根据数据特点选择合适的压缩格式可以减少数据在网络中的传输量,从而提高Shuffle的效率。

4. **调整Map和Reduce的数量**:合理配置Map和Reduce任务的数量,可以平衡任务负载,避免某些任务执行过慢成为瓶颈。

### 案例研究:如何调优大数据作业

在进行大数据作业调优时,可以采用以下步骤进行:

1. **分析作业执行计划**:利用Hadoop的作业历史服务器或者第三方监控工具,对已完成作业的执行计划进行分析,找到可能的性能瓶颈。

2. **数据倾斜诊断**:检查是否有某些键值对应的数据量特别大,导致对应的任务执行时间远高于其他任务。

3. **调整Shuffle参数**:针对发现的问题,可以适当调整Shuffle相关的参数,比如调整`mapreduce.job.reduces`来改变Reducer的数量,或者修改`io.sort.factor`来改变合并文件的数量。

4. **重新编译和测试**:对作业进行重新编译,然后在开发环境中测试调优的效果。

5. **监控性能变化**:在生产环境中部署调优后的作业,并密切监控性能指标是否有所提升。

6. **持续优化**:根据监控结果,持续进行调优,直至达到最佳状态。

## 5.2 Shuffle在复杂数据处理场景中的应用

### 分布式排序应用

分布式排序是Shuffle的一个典型应用场景。在MapReduce中实现分布式排序时,Map任务对输入数据进行排序并输出中间键值对,Shuffle阶段将具有相同键的数据分组到同一个Reducer上进行进一步排序和处理。在这一过程中,Shuffle的性能直接影响排序速度和结果准确性。

### 联合查询与数据聚合

在需要进行大量数据联合查询和聚合的场景中,MapReduce的Shuffle同样扮演着重要角色。通过Shuffle阶段,数据能够按照关联的键值重新组织,从而使得Map和Reduce任务能够正确执行联合查询和聚合计算。Shuffle效率的高低直接影响着查询和聚合操作的性能。

## 5.3 Shuffle与其他大数据技术的集成

### 与Hive、Pig的集成案例

Hive和Pig作为Hadoop生态中的两个重要组件,它们在内部使用了MapReduce的Shuffle机制。这些组件在执行用户定义的操作时,会将操作转化为MapReduce作业,利用Shuffle机制进行数据的传输和分组。与Hive、Pig的集成可以使得在进行复杂数据查询和分析时,能够更有效地利用Shuffle性能。

### 与Spark Shuffle的比较与集成

Spark作为一个快速的分布式计算系统,同样拥有自己的Shuffle机制,称为Spark Shuffle。Spark Shuffle与MapReduce Shuffle有显著不同,主要表现在数据的处理和传输方式上。MapReduce Shuffle通常涉及磁盘I/O操作,而Spark Shuffle在内存管理上做了优化,尽可能在内存中处理数据,以提高性能。在大数据实践中,将MapReduce Shuffle与Spark Shuffle进行有效集成,可以实现两者优势的互补,针对不同的应用场景选择合适的计算引擎。

在了解了MapReduce Shuffle在大数据处理中的应用后,可以预见,在大数据分析和处理领域,Shuffle机制仍然占据核心地位。通过对Shuffle的深入理解,并结合不同场景的应用,可以大幅提升数据处理的效率和质量。

# 6. MapReduce Shuffle未来展望与趋势

随着数据量的爆炸式增长和计算需求的不断提升,MapReduce Shuffle机制作为大数据处理中的核心环节,其优化和未来发展一直是研究和产业界关注的焦点。本章将探讨Shuffle优化的未来方向,并关注学术界与工业界的最新研究进展以及创新点在Shuffle优化中的实际应用。

## 6.1 Shuffle优化的未来方向

### 6.1.1 新兴技术对Shuffle的影响

随着云计算、边缘计算、以及物联网等新兴技术的发展,数据的生成和处理模式也在发生变化。这些技术带来的分布式数据存储和处理需求,促使 ***e 机制不得不适应更广范围的网络环境和更复杂的数据流动模式。例如,边缘计算环境下,数据可能需要在资源有限的边缘节点上进行初步处理,这就要求 Shuffle 机制能够在资源受限的条件下也能高效运行。

### 6.1.2 预测Shuffle技术的发展趋势

未来的Shuffle技术有望更加智能化和自适应。随着机器学习技术的融合,Shuffle过程中可能会引入智能调度器,根据历史运行数据自动调整Shuffle参数以达到最优性能。同时,随着硬件技术的进步,比如更快的网络设备、大容量SSD存储,Shuffle机制可能会更加倚重于硬件特性,实现更高速度的数据传输和处理。

## 6.2 研究与创新

### 6.2.1 学术界和工业界的研究进展

在学术界,研究人员正在尝试使用新型数据结构和算法来优化Shuffle过程。例如,通过优化数据结构来减少内存的复制开销,或是开发新的通信协议以减少网络传输中的冗余。在工业界,一些大型科技公司如Google和Facebook已经开始设计和部署自有的大规模分布式计算系统,并对其Shuffle机制进行深入的研究与定制化改造。

### 6.2.2 创新点在Shuffle优化中的应用

创新点如使用FPGA(现场可编程门阵列)加速Shuffle操作,或者将AI技术融入Shuffle调度中实现自适应优化。以FPGA为例,它可以在硬件级别实现数据预处理,减少CPU的负担并提高数据处理速度。此外,利用AI对Shuffle行为进行建模和预测,可以实现对Shuffle瓶颈的智能识别和性能优化,这对于大规模机器学习工作负载尤其有价值。

通过上述内容,我们可以看到MapReduce Shuffle机制的发展正面临着新的机遇和挑战。优化Shuffle不仅能够提高大数据处理的效率,还将影响整个数据处理生态系统的性能和可靠性。随着技术的不断进步,未来Shuffle机制有望变得更加高效、智能和灵活,从而更好地服务于日益增长的大数据需求。

0

0