网络优化大师:MapReduce Shuffle数据传输损耗最小化

发布时间: 2024-10-31 02:06:34 阅读量: 30 订阅数: 27

# 1. MapReduce Shuffle机制概述

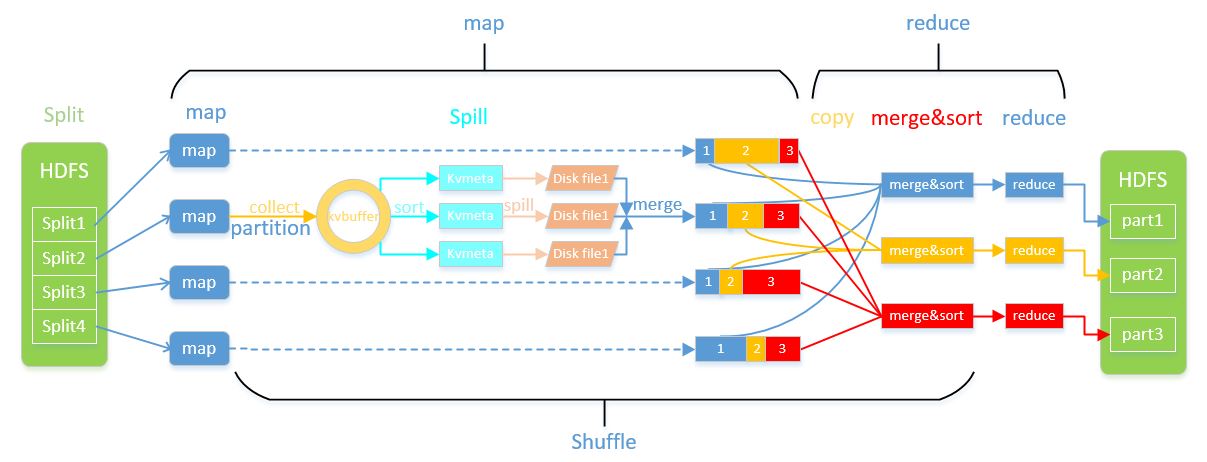

MapReduce是Hadoop的核心组件,而Shuffle是MapReduce的重要组成部分,负责在Map和Reduce阶段之间传输中间数据。理解Shuffle机制对于优化大数据处理性能至关重要。

## 1.1 Shuffle的基本原理

Shuffle的基本原理是将Map任务产生的键值对按照key进行排序、分组,然后将这些数据传输到对应的Reduce任务中去。这一过程包括了数据的排序、合并、传输等关键步骤。

## 1.2 Shuffle的目的与重要性

Shuffle的主要目的在于对数据进行重新分布和整合,为后续的数据处理提供高效的数据访问。一个性能良好的Shuffle机制能够显著减少数据在网络中的传输量,降低处理时间,从而提高整个MapReduce作业的执行效率。

## 1.3 Shuffle过程中的关键挑战

Shuffle过程面临许多挑战,包括如何有效管理内存,如何避免数据倾斜,以及如何选择适当的压缩算法以减少I/O开销。下一章我们将深入探讨Shuffle流程以及这些挑战如何被解决。

# 2. 理解数据传输损耗的原理

### 2.1 MapReduce Shuffle流程解析

#### 2.1.1 Shuffle的定义和作用

Shuffle是MapReduce处理过程中的关键阶段,它位于Map任务和Reduce任务之间。Shuffle的定义涉及到数据在Map和Reduce任务间的传输和排序。Shuffle的作用主要体现在以下几个方面:

1. 数据重新分布:通过Shuffle阶段,Map输出的数据根据键值对被重新分发到相应的Reduce任务上。

2. 网络优化:Shuffle对数据进行网络传输前的排序和分组,减少了网络传输的数据量。

3. 数据聚合:Shuffle阶段还涉及到了数据的聚合操作,即将相同键值的数据聚合成一个整体。

#### 2.1.2 Shuffle的主要阶段

Shuffle阶段可以分为以下几个主要步骤:

1. Map输出写入磁盘:Map任务执行完毕后,输出的数据首先写入本地磁盘,而不是直接发送到Reduce端。

2. Partition和Sort:对Map输出的数据进行分区处理,并进行排序,确保相同键值的数据在同一个分区。

3. 数据传输:完成排序的分区数据被传输到对应的Reduce任务。

4. Shuffle文件合并:Reduce任务从各个Map节点获取数据后,进行合并,并再次排序。

5. Reduce处理:最终,合并后的数据被送入Reduce任务中进行处理。

### 2.2 数据传输损耗的种类

#### 2.2.1 网络拥塞和带宽限制

网络拥塞是数据传输损耗的常见原因之一。由于大数据处理通常涉及大规模的数据传输,节点间的网络带宽可能成为瓶颈。在网络带宽有限的情况下,过多的数据传输请求会导致队列拥塞,降低数据传输效率。

为解决网络拥塞问题,可以:

- 优化数据传输路径,减少网络跳数。

- 使用带宽预留机制,确保重要数据流的传输优先级。

- 在数据传输策略上实施负载均衡,避免单一节点过载。

#### 2.2.2 数据序列化和反序列化的开销

数据在传输过程中需要经过序列化和反序列化的处理。序列化将对象转换成字节流,而反序列化则是相反的过程。这个过程需要额外的CPU资源,尤其在处理大量数据时,会成为性能瓶颈。

对于序列化和反序列化的优化可以包括:

- 选择高效的序列化框架,例如Avro、Thrift或Protocol Buffers。

- 尽可能减少数据传输量,例如只传输必要的字段。

- 优化数据结构设计,降低序列化与反序列化的复杂度。

#### 2.2.3 系统缓冲和处理延迟

系统缓冲和处理延迟会导致数据传输的时间延长。例如,当数据写入磁盘时,需要在磁盘缓冲区等待I/O操作完成,这个过程会带来延迟。

为了减轻系统缓冲和处理延迟,可以:

- 使用高性能的存储介质,如SSD来降低I/O延迟。

- 优化系统的缓冲策略,通过动态调整缓冲区大小来适应不同工作负载。

- 使用异步I/O操作来提高系统的吞吐量。

### 2.3 数据传输损耗的监测和评估

为了监测和评估数据传输损耗,通常需要借助性能监控工具和性能指标分析。评估数据传输损耗的常见指标包括:

- 数据传输速率:即单位时间内传输的数据量。

- 吞吐量:即整个系统在单位时间内处理的数据量。

- 延迟:包括数据从开始传输到到达目的地所需的时间。

通过这些指标,我们可以定量分析数据传输的性能表现,找出可能存在的问题,并制定相应的优化策略。在后续章节中,我们会进一步探讨如何减少数据传输损耗以及实施高级实践技巧。

# 3. 减少数据传输损耗的策略

## 3.1 数据本地化和预合并技术

### 3.1.1 本地化数据处理的优化

在大数据处理中,数据传输是耗时的主要原因之一。MapReduce的Shuffle过程不可避免地涉及数据在网络中的传输,因此优化这一过程可以显著提升整体性能。数据本地化是减少数据传输损耗的关键技术之一,它指的是尽量将数据处理工作分配到存储该数据的机器上进行。

数据本地化的实现通常依赖于作业调度系统。例如,在Hadoop中,通过心跳机制,每个DataNode定期向NameNode报告本地存储的数据块信息,而TaskTracker(在YARN中是NodeManager)则负责分配任务到资源可用的节点上。这种机制可以最大限度地减少跨节点的数据传输。

```mermaid

flowchart LR

subgraph 节点A[DataNode]

hdfsA[(HDFS Block)] --> mapA[Map Task]

end

subgraph 节点B[DataNode]

hdfsB[(HDFS Block)] --> mapB[Map Task]

end

subgraph 节点C[DataNode]

hdfsC[(HDFS Block)] --> mapC[Map Task]

end

mapA --> shuffleA[Shuffle]

mapB --> shuffleA

mapC --> shuffleA

shuffleA --> reduce[Reduce Task]

style shuffleA fill:#f9f,stroke:#333,stroke-width:2px

```

在上述流程图中,每个Map任务在本地节点上处理其存储的数据块,然后将结果输出到Shuffle阶段,从而减少了跨节点的数据传输。

### 3.1.2

0

0