排序算法详解:MapReduce Shuffle如何实现部分排序优化

发布时间: 2024-10-31 02:20:29 阅读量: 24 订阅数: 27

用MapReduce实现KMeans算法

# 1. 排序算法基础知识

排序算法是计算机科学中最基本和最重要的算法之一。它广泛应用于数据处理、数据库管理、信息检索、以及在更高级别的问题中进行预处理。了解排序算法有助于优化程序性能,提高数据处理效率。

## 1.1 排序算法的基本概念

### 1.1.1 什么是排序

排序是一种将元素集合按照一定的顺序重新排列的过程。在计算机科学中,排序通常指的是对数字或者字符等数据元素进行升序或降序排列。排序算法的效率直接影响到数据处理的速度和系统性能。

### 1.1.2 排序算法的分类和比较

根据排序时数据移动的特点,排序算法可以分为比较排序和非比较排序。比较排序的时间复杂度下限为O(n log n),非比较排序(如计数排序、基数排序)则不受此限制。在不同的应用场景中,选择合适的排序算法可以显著提升效率。

## 1.2 常见排序算法分析

### 1.2.1 冒泡排序与选择排序

冒泡排序是通过相邻元素的比较和交换来达到排序目的,其时间复杂度为O(n^2),适用于小规模数据集。选择排序则通过不断选择剩余元素中的最小者来实现排序,性能与冒泡排序类似。

### 1.2.2 插入排序与快速排序

插入排序通过构建有序序列,对于未排序数据,在已排序序列中从后向前扫描,找到相应位置并插入,其时间复杂度同样为O(n^2),但对于部分有序的数组表现较好。快速排序是基于分治策略的排序算法,平均时间复杂度为O(n log n),是目前效率最高的排序算法之一。

### 1.2.3 归并排序与堆排序

归并排序采用了分治的思想,将数组分成两部分递归排序,然后合并结果。虽然平均和最坏情况下的时间复杂度均为O(n log n),但需要额外的存储空间。堆排序利用堆这种数据结构所设计的一种排序算法,它在处理大量数据时也能保持较好的性能。

# 2. MapReduce shuffle机制剖析

## 2.1 MapReduce框架概述

### 2.1.1 MapReduce的工作原理

MapReduce是一个编程模型,用于处理和生成大数据集。用户只需要编写Map和Reduce函数,框架会自动处理并行计算、数据分布、错误恢复等底层细节。

```java

public static class MyMapper extends Mapper<LongWritable, Text, Text, IntWritable> {

public void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

// 用户自定义的map处理逻辑

}

}

public static class MyReducer extends Reducer<Text, IntWritable, Text, IntWritable> {

public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {

// 用户自定义的reduce处理逻辑

}

}

```

在这段代码中,`Mapper`和`Reducer`类定义了用户需要实现的逻辑。MapReduce框架将处理数据的读取、分割、排序、分组,并最终将结果输出。

### 2.1.2 Shuffle的作用与流程

Shuffle是MapReduce中极为关键的一个环节,它负责从Map任务输出的数据中,提取数据并传输给Reduce任务。Shuffle过程包括数据的排序、分组、以及网络传输。

```mermaid

graph LR

A[Map输出] --> B[Map端排序]

B --> C[Map端写入磁盘]

C --> D[Shuffle网络传输]

D --> E[Reduce端读取数据]

E --> F[Reduce端排序]

F --> G[Reduce处理]

```

在上述流程中,每个步骤都至关重要。Map端排序确保了数据在写入磁盘之前是有序的,而Reduce端排序则是为了保证Reduce任务能以正确的顺序处理数据。

## 2.2 Shuffle的各个阶段详细解析

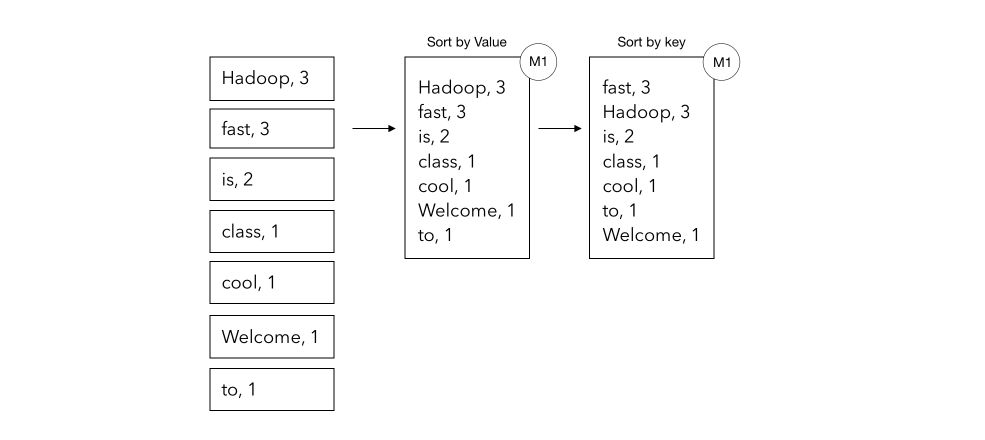

### 2.2.1 Map端的输出与排序

Map端的主要任务是处理输入数据并输出中间键值对。这些键值对需要经过排序以便于Shuffle传输。

```java

context.write(key, value);

```

Map任务在完成后,会根据key进行排序,保证相同key的值能够连续输出。这是通过构建一个内存中的优先队列(小顶堆)来实现的。

### 2.2.2 Shuffle网络传输

排序之后,数据会进行分区处理,以确保相同分区编号的数据会发送到同一个Reduce任务。

```java

partitioner.getPartition(key, value, numPartitions);

```

分区函数`getPartition`决定了数据应该传送到哪一个Reduce任务。完成分区后,数据通过网络传输到对应的Reduce节点。

### 2.2.3 Reduce端的输入处理

在Reduce端,接收到的数据需要先进行合并和排序,因为来自不同Map任务的数据可能包含相同的key。

```java

for (Entry<K,V> entry : data) {

list.add(entry);

}

Collections.sort(list);

```

Reduce任务会对输入数据进行合并排序,确保每个key对应的值都是有序的。然后,Reduce函数开始对每个key的值进行处理,最终输出结果。

在解析MapReduce的Shuffle机制时,我们了解了它的工作原理和详细的Shuffle流程。Map端的输出与排序、Shuffle的网络传输、以及Reduce端的输入处理是整个过程的关键环节。这些操作的优化对性能提升至关重要,第三章将继续深入分析Shuffle过程中部分排序的实现。

# 3. Shuffle过程中部分排序的实现

## 3.1 部分排序的定义与重要性

### 3.1.1 为何需要部分排序

在分布式计算中,MapReduce框

0

0