【数据序列化与反序列化优化】:MapReduce Shuffle机制中的性能关键点

发布时间: 2024-10-30 22:05:30 阅读量: 6 订阅数: 8

# 1. 数据序列化与反序列化基础

在现代信息技术中,数据序列化与反序列化是数据存储与传输的关键环节。简单来说,序列化是将数据结构或对象状态转换为可存储或传输的格式的过程,而反序列化则是这个过程的逆过程。通过这种方式,复杂的对象状态可以被保存为字节流,然后再通过反序列化还原成原始结构。

序列化是构建分布式系统时不可或缺的一环,比如在Web服务、远程过程调用、消息队列等场景中,数据对象都需要被序列化后在网络上传输,然后在接收端进行反序列化,以恢复为可用的数据结构。选择合适的序列化与反序列化方式,能够提高数据处理的效率和系统的可扩展性。

本章将从基础概念入手,探讨序列化与反序列化的原理,以及影响其性能的关键因素,为后续章节中对MapReduce Shuffle机制的深入分析和性能优化提供坚实的理论基础。

# 2. MapReduce Shuffle机制详解

### 2.1 Shuffle机制的工作流程

Shuffle是MapReduce框架中一个复杂且关键的阶段,它涉及到数据的排序、分组和网络传输等多个操作。理解Shuffle机制的工作流程对于优化MapReduce作业的性能至关重要。

#### 2.1.1 Map阶段的数据输出

在Map阶段,Map任务对输入的数据进行处理后,输出的是键值对(key-value pairs)。每个Map任务完成后,这些键值对需要被发送到Reduce任务以供进一步处理。但在发送之前,这些数据需要经过一个排序的过程。

##### 数据排序

Shuffle的开始通常涉及到Map输出的局部排序。为了减少网络带宽的消耗并提高整体效率,通常在Map端对输出的键值对进行排序,这样相同键的值会被组织在一起。这一步骤是Shuffle机制的一个重要环节,因为它确保了在Shuffle阶段传输到Reduce端的数据已经是有序的。

##### 写入磁盘

排序完成后,键值对会被写入到磁盘上。由于Map任务的输出通常是海量的,所以需要将这些数据暂时写入磁盘以避免内存溢出。这个过程中,可能会采取一定的策略(比如溢写策略)来优化内存和磁盘的使用。

```java

// 示例代码:排序后写入磁盘的简化逻辑

// 注意:实际代码会更加复杂,并且会处理大量异常和边界情况

// 假设pairList是已经排序好的键值对列表

List<Pair> pairList = ...;

// 将键值对写入到磁盘文件

for (Pair pair : pairList) {

磁盘写入(pair.getKey(), pair.getValue());

}

```

#### 2.1.2 Shuffle阶段的中间数据传输

Map端排序后的数据准备好后,Shuffle阶段开始进入数据的传输阶段。这包括Map端的输出数据传输到Reduce端的过程。该过程是通过网络进行的,也是Shuffle性能的一个瓶颈所在。

##### 网络传输

排序后的数据通过网络被发送到Reduce任务。由于数据量可能非常庞大,网络I/O成为了Shuffle性能的关键限制因素之一。MapReduce框架采用多种策略来缓解网络压力,比如合并小文件、使用压缩技术、调整数据传输的缓冲区大小等。

##### Reduce端的接收和处理

Reduce任务接收到来自Map任务的数据后,需要对这些数据进行合并和排序,以便进行后续的合并和最终的聚合计算。

```java

// 示例代码:Reduce端合并数据的简化逻辑

// 假设mapOutputData是从各个Map任务获取到的数据

List<Pair> mapOutputData = ...;

// 合并数据

List<Pair> mergedData = mergeData(mapOutputData);

// 排序合并后的数据

Collections.sort(mergedData, (pair1, pair2) -> pair1.getKey().compareTo(pair2.getKey()));

// 处理排序后的数据

for (Pair pair : mergedData) {

reduce(pair.getKey(), pair.getValue());

}

```

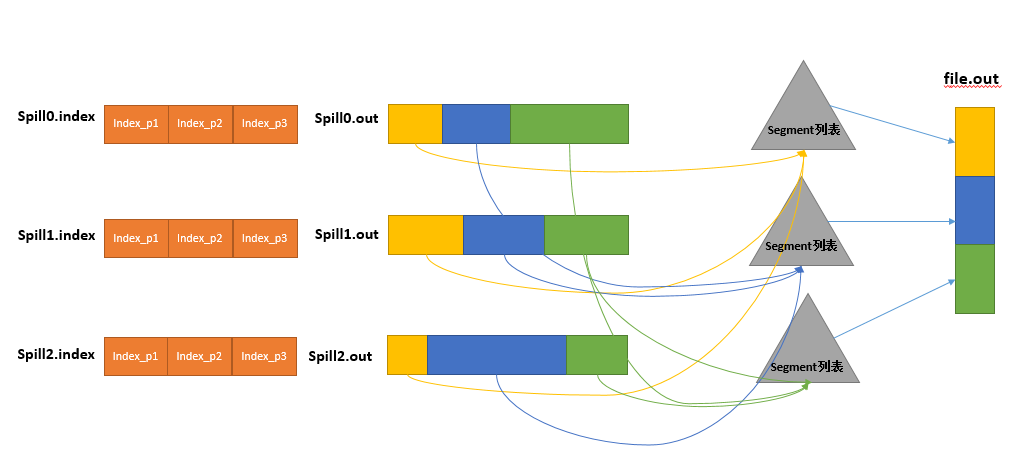

### 2.2 Shuffle阶段的关键组件

Shuffle机制中包含多个关键组件,它们共同协作以确保数据能够高效且正确地从Map端传输到Reduce端。

#### 2.2.1 Partitioner的作用与实现

Partitioner是决定一个键值对会被发送到哪一个Reduce任务的关键组件。通过自定义Partitioner,我们可以控制数据的分布情况,这对于优化性能和负载平衡至关重要。

##### Partitioner的基本原理

Partitioner通常是根据键的值来决定数据的分区。默认情况下,MapReduce使用哈希分区(HashPartitioner),它将键哈希后对Reduce任务数取模得到分区号。

```java

// 示例代码:HashPartitioner的基本逻辑

public class HashPartitioner extends Partitioner<Text, IntWritable> {

public int getPartition(Text key, IntWritable value, int numPartitions) {

// 对key的哈希码进行取模操作得到分区号

return (key.hashCode() & Integer.MAX_VALUE) % numPartitions;

}

}

```

##### 自定义Partitioner

根据业务需求自定义Partitioner可以实现更复杂的数据分区逻辑。比如,你可以根据业务逻辑将数据分配到特定的Reduce任务,或者按照特定的策略实现更均衡的数据分布。

#### 2.2.2 Combiner的优化原理及应用

Combiner在MapReduce中是一个可选组件,它在Map阶段对输出的数据执行局部归约操作,以减少传输到Reduce端的数据量。

##### Combiner的作用

Combiner的作用是减少Shuffle过程中需要传输的数据量。它通常实现与Reduce函数相同的逻辑,但是是在局部数据上执行,从而减少了网络传输的负载和数据传输的成本。

```java

// 示例代码:自定义Combiner的简化逻辑

public static class MyCombiner extends Reducer<Text, IntWritable, Text, IntWritable> {

public void r

```

0

0