MapReduce Reduce端Join:深入理解与性能优化

发布时间: 2024-10-30 16:46:58 阅读量: 21 订阅数: 37

# 1. MapReduce Reduce端Join基础

MapReduce框架通过分布式处理为大数据分析提供了强大的支持,而Reduce端Join是其在处理复杂数据关联场景下的一个重要应用。在这一章中,我们将介绍Reduce端Join的基础知识,并概述其在数据处理中的核心地位。Reduce端Join允许开发者在一个作业中处理多个数据源的数据,并通过合并操作得到有用的洞察。其本质是利用Reduce阶段的键值对(key-value pairs)来整合数据,从而实现两个或多个数据集之间的关系连接。对于初学者而言,了解Reduce端Join是深入学习大数据处理技术的必要步骤。而对于资深开发者来说,掌握其高级应用和优化技巧,能够显著提升数据处理效率和项目质量。

# 2. 理论篇 - Reduce端Join的工作原理

### 2.1 MapReduce编程模型概述

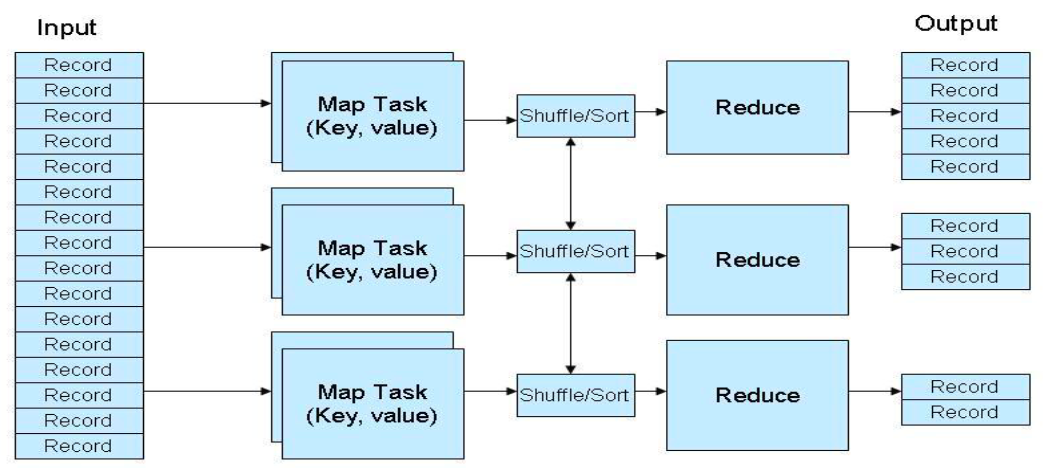

MapReduce是一个编程模型,它允许开发者通过编写一个Map函数和一个Reduce函数来处理大规模数据集。这个模型将复杂的数据处理过程分解为两个主要阶段,Map阶段和Reduce阶段。它广泛用于各种大数据处理任务,如数据排序、数据聚合、数据分类、数据连接(Join)等。

#### 2.1.1 MapReduce的核心组件

在MapReduce模型中,有两个核心组件:Mapper和Reducer。

- **Mapper**: Mapper的主要任务是处理输入数据,它按照给定的输入格式读取数据,然后对数据进行处理,输出键值对(key-value pairs)作为中间结果。

- **Reducer**: Reducer则处理Mapper输出的中间结果,它会对具有相同键(key)的所有值(values)进行某种形式的合并操作,并生成最终输出结果。

#### 2.1.2 MapReduce数据流与任务调度

MapReduce的数据流与任务调度过程如下:

1. 输入数据被分割为多个片段(splits),每个片段由一个Mapper处理。

2. Mapper读取输入数据,执行用户定义的Map函数,并将输出的中间键值对写入本地磁盘。

3. 在Map阶段完成后,系统会对所有的中间输出进行排序,使得所有具有相同键(key)的值(values)聚集到一起,这个过程称为shuffle。

4. Reducer读取排序后的中间数据,通过网络传输获取所有具有相同键的数据片段。

5. Reducer处理这些数据,执行用户定义的Reduce函数,并将最终结果写入到输出文件。

### 2.2 Reduce端Join的机制分析

#### 2.2.1 Join操作在MapReduce中的角色

在MapReduce中,Join操作是将两个或多个数据集合并为一个数据集的过程。Reduce端Join是一种常见的Join策略,它将Join操作延迟到Reduce阶段执行,通常适用于大表与小表或者具有共同属性的大表之间的Join操作。

#### 2.2.2 Reduce端Join的数据组织和处理流程

Reduce端Join的数据组织和处理流程大致如下:

1. **Map阶段**: 每个Map任务读取一个或多个输入文件,对文件中的记录进行解析,并根据Join条件将记录分组到不同的键下。

2. **Shuffle阶段**: 系统自动将所有Mapper输出的中间结果根据键进行排序并分组,使得相同键的数据发送到同一个Reducer。

3. **Reduce阶段**: Reducer接收到所有具有相同键的数据,并执行用户定义的Join逻辑,将相关联的数据合并到一起,最后输出到结果文件。

### 2.3 Reduce端Join的理论优化策略

#### 2.3.1 分区与排序对Join性能的影响

在Reduce端Join中,正确的数据分区和排序能够显著影响Join操作的性能。

- **分区策略**: 使用合适的分区函数,可以确保数据均匀地分布到各个Reducer,防止某个Reducer处理过多的数据而成为瓶颈。

- **排序策略**: 如果在Map端完成排序,可以减少Reducer端的数据合并量,提高Join效率。

#### 2.3.2 小文件问题对Reduce端Join的影响及应对策略

小文件问题是指在MapReduce作业中,大量的小文件会导致启动过多的Map任务,增加了任务调度和管理的开销,同时也会降低整个作业的执行效率。

- **应对策略**: 可以采取合并小文件的预处理操作,或者通过自定义InputFormat来优化小文件的处理方式。

在下一章节中,我们将深入探讨Reduce端Join的实现技巧,包括核心代码解析、性能提升技巧以及调试与优化的常见问题解决方案。

# 3. 实践篇 - Reduce端Join的实现技巧

## 3.1 编码实践 - 核心代码解析

### 3.1.1 Map端的数据准备和格式化

在MapReduce的Reduce端Join操作中,Map端的主要工作是为数据分组和格式化,确保Reduce端能够正确地进行Join操作。以下是Map端数据准备和格式化的代码示例:

```java

public static class JoinMapper extends Mapper<LongWritable, Text, Text, Text> {

private Text outKey = new Text();

private Text outValue = new Text();

public void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

String[] parts = value.toString().split(","); // 假设数据字段由逗号分隔

String joinKey = parts[0]; // 假设第一个字段是join key

String record = parts[1]; // 假设第二个字段是要join的数据

outKey.set(joinKey);

outValue.set(record);

context.write(outKey, outValue);

}

}

```

在Map端,我们首先解析输入的文本行,并将Join的关键字段(joinKey)设置为输出键(outKey),将要join的数据设置为输出值(outValue)。这样可以确保具有相同joinKey的所有记录在Reduce阶段都会被聚集到一起。

### 3.1.2 Reduce端的Join逻辑实现

```java

public static class JoinReducer extends Reducer<Text, Text, Text, Text> {

private Text result = new Text();

public void reduce(Text key, Iterable<Text> values, Context context) throws IOException, InterruptedException {

String secondaryData = "";

for (Text val : values) {

secondaryData += val.toString() + ",";

}

secondaryData = seconda

```

0

0