MapReduce计数器使用:全面解读监控与调试作业的方法

发布时间: 2024-10-30 16:20:04 阅读量: 37 订阅数: 28

# 1. MapReduce计数器的介绍与作用

MapReduce是一个编程模型,用于处理和生成大数据集的并行运算。该模型由Google提出,并被广泛应用于Hadoop等框架中。在大数据处理的上下文中,MapReduce计数器是一种强大的工具,用于监控任务执行的状态,评估处理过程的质量,并帮助开发者优化程序性能。

计数器在MapReduce作业中扮演着至关重要的角色。它们不仅仅是统计信息的提供者,更是作业监控、性能调优和故障排查的关键工具。通过计数器,开发者可以获得作业中各种关键性能指标的数据,比如已处理的记录数、错误数或者特定事件发生的频率。这些数据对于确保数据处理的正确性和效率至关重要。接下来的章节将深入探讨计数器的理论基础和实践操作,以及如何将计数器应用于复杂作业的高级场景。

# 2. MapReduce计数器的理论基础

### 2.1 MapReduce的基本概念

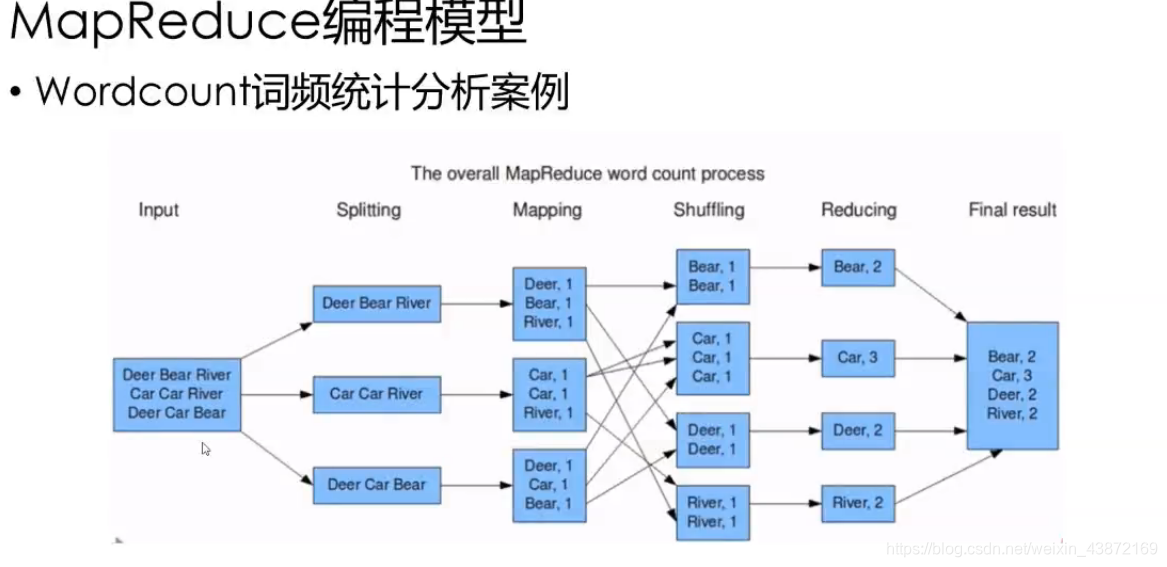

MapReduce是一种编程模型,用于在大量计算节点上处理和生成大数据集。它将任务分为两个阶段:Map阶段和Reduce阶段。Map阶段处理输入数据,生成中间键值对;Reduce阶段则对所有具有相同键的中间值进行合并处理。

#### 2.1.1 MapReduce的工作原理

在MapReduce模型中,输入数据被分割成固定大小的块,这些块被分配给Map任务进行并行处理。Map任务处理输入数据块并输出一系列中间键值对。这些中间键值对被分组并传输到Reduce任务,后者对具有相同键的值进行归约操作,最终生成输出数据。

```python

# 伪代码展示MapReduce的处理流程

def map(input_data):

for record in input_data:

key, value = process(record)

emit(key, value)

def reduce(key, values):

result = process_values(values)

emit(key, result)

```

Map阶段的任务是提取数据并为Reduce阶段准备数据。Reduce阶段则将相同键的数据合并起来。这个模型极大地简化了在分布式环境中对大数据集的处理。

#### 2.1.2 Map和Reduce的执行流程

MapReduce的工作流程包括数据分片、Map任务、Shuffle过程、Reduce任务四个主要步骤。

- **数据分片**:数据被分割成块,通常按块大小进行分割。

- **Map任务**:每个Map任务处理一个数据块,并生成中间键值对。

- **Shuffle过程**:将Map任务输出的键值对按键排序并分发到相应的Reduce任务。

- **Reduce任务**:根据键对值进行合并操作,并输出最终结果。

### 2.2 计数器的功能与类型

MapReduce计数器用于监控作业的执行过程,提供有关作业运行状态的关键指标。

#### 2.2.1 内置计数器和自定义计数器的区别

内置计数器是由Hadoop框架提供的,用于追踪Map和Reduce任务的执行情况,如处理的记录数、输入输出字节等。自定义计数器由用户定义,用于计算特定于应用程序的指标,如错误类型、状态标志等。

自定义计数器为开发者提供了更具体地监控和评估作业执行情况的能力,以便在作业执行过程中进行调整。

#### 2.2.2 常见的计数器类型和应用场景

- **内置计数器**:比如`MAP_INPUT_RECORDS`、`REDUCE_OUTPUT_RECORDS`等,它们提供了作业级别的性能指标。

- **自定义计数器**:比如在文本分析中,可以定义计数器来统计不同词频的数量,或在数据清洗作业中统计被过滤掉的记录数量。

### 2.3 计数器在作业监控中的重要性

计数器是监控和诊断MapReduce作业问题的重要工具。

#### 2.3.1 作业性能监控

通过计数器收集的信息可以帮助我们评估Map和Reduce任务的性能。例如,记录处理的数据量和完成的任务数量可以用来评估作业是否运行正常。

#### 2.3.2 错误和异常的诊断

计数器可以帮助开发者快速定位作业中的错误和异常。例如,在Map阶段统计读取文件失败的次数,在Reduce阶段统计未匹配的键的数量。

```mermaid

graph TD

A[开始] --> B[Map阶段]

B --> C{Shuffle过程}

C --> D[Reduce阶段]

D --> E[结束]

B -->|收集计数器信息| F[监控和诊断]

D -->|收集计数器信息| F

```

计数器的收集信息流程嵌入在整个作业执行流程中,可为作业的监控和诊断提供实时数据支持。

# 3. MapReduce计数器的实践操作

## 3.1 使用内置计数器进行作业监控

在实际的MapReduce作业中,内置计数器扮演着不可或缺的角色。它们由Hadoop框架提供,可以帮助开发者或运维人员监控作业的健康状况,识别瓶颈,以及评估性能。本节将详细介绍如何获取内置计数器的数据及其解读与应用。

### 3.1.1 如何获取内置计数器的数据

获取内置计数器的数据通常涉及到Hadoop作业的运行时监控。可以通过多种方式来收集这些数据,包括但不限于使用命令行工具、编写监控脚本或集成第三方监控系统。以下是使用Hadoop命令行获取计数器数据的一个简单示例:

```bash

hadoop job -list # 列出所有作业

hadoop job -list-rik <job-id> # 获取指定作业的计数器

hadoop job -counter <job-id> <group-name> <counter-name> # 查询具体计数器的值

```

这些命令将展示出每个作业、每个计数器组以及每个计数器的当前值,从而允许用户对作业的执行情况有一个全面的了解。

### 3.1.2 内置计数器数据的解读与应用

内置计数器提供了大量关于任务执行的细节信息,例如输入输出记录的数量、数据的洗牌(Shuffle)和排序的次数等。理解这些计数器可以帮助我们对MapReduce作业的性能做出正确的判断。下面是一些常见的内置计数器实例及其含义:

| 计数器组 | 计数器名称 | 描述 |

|----------------------|---------------------------|------------------------------------------------------------|

| File Input Format Counters | Bytes Read | 输入文件的总字节数读取量 |

| File Output Format Counters | Bytes Written | 输出文件的总字节数写入量 |

| Job Counters | Map-Input records | Map任务的输入记录数 |

| Job Counters | Reduce shuffle bytes | Reduce任务从Map任务中拉取的中间数据字节数 |

| Map-Reduce Framework | CPU time spent (ms) | Map或Reduce任务消耗的CPU时间(毫秒)

0

0