MapReduce技巧提升:如何利用Combiner成为处理效率的高手

发布时间: 2024-10-30 16:00:34 阅读量: 30 订阅数: 37

# 1. MapReduce框架概述

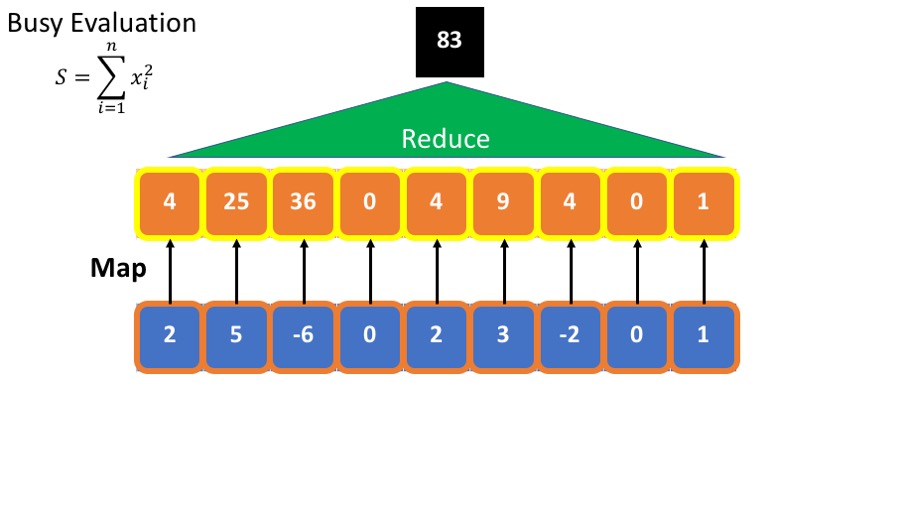

MapReduce是Apache Hadoop项目中的核心组件,旨在简化大规模数据集的并行运算。作为分布式数据处理的一个编程模型,它允许开发者通过Map和Reduce两个操作来处理数据。Map阶段负责处理输入数据,生成键值对中间数据,而Reduce阶段则对这些中间数据进行汇总,得出最终结果。

MapReduce的成功在于其高容错性和可伸缩性,使得它非常适合于处理大规模数据集。它由一个主节点(Master Node)和多个工作节点(Worker Node)组成。主节点负责资源管理与调度,而工作节点负责实际的计算任务。

尽管MapReduce在处理小数据集时效率不高,但其强大的扩展能力使它在处理PB级别的数据时表现出色。它通过数据本地化和负载均衡等机制优化性能,确保了整个处理过程的高效和稳定。

理解MapReduce的基础知识,是深入学习其高级组件如Combiner的前提。接下来,我们将探讨Combiner组件,它是优化MapReduce作业性能的关键环节。

# 2.

## 第二章:深入理解Combiner组件

### 2.1 Combiner的原理分析

#### 2.1.1 Combiner的角色和作用

Combiner组件在MapReduce编程模型中扮演了一个辅助的角色。它主要在Map任务完成后,对输出结果进行局部合并,减少数据传输量,从而提高整个MapReduce作业的执行效率。在某种程度上,Combiner可以看作是Mini-Reducer。

具体来说,Combiner会在Map任务的输出数据发送到Reduce端之前,利用同一Map任务输出的相同key的数据进行局部合并。这样,只有合并后的数据才会被传送到Reduce任务,减少了网络I/O开销,并且由于减少了传输的数据量,还能在一定程度上加快Map任务的结束时间。

#### 2.1.2 Combiner与Map和Reduce的关联

Combiner的执行是在Map任务和Reduce任务之间的一个优化环节。它并没有改变MapReduce的总体执行逻辑,但通过优化数据传输和处理的效率,间接影响了整个作业的性能。

在数据流中,Combiner的输出是Map任务的输出,同时也是Reduce任务的输入。为了保持数据的一致性和准确性,Combiner的输出结果应该与Reduce函数的输入兼容,即Combiner的逻辑必须是Reduce逻辑的一个子集。

### 2.2 Combiner在数据处理中的应用

#### 2.2.1 标准Combiner使用场景

标准Combiner通常是MapReduce框架自带的一些内置Combiner实现,如用于求和、计数等场景的Combiner。在许多标准的数据处理任务中,如WordCount,Combiner可以有效减少传输的数据量。

例如,在WordCount任务中,Map阶段的输出可能包含大量的重复单词计数,如果不使用Combiner,每个Map都会向Reduce端发送相同单词的计数。但如果使用Combiner,在Map端进行部分合并后,相同的单词只会有一次计数发送到Reduce端,大大减少了网络负载。

```java

// WordCount示例中的Combiner伪代码

public static class IntSumCombiner extends Reducer<Text, IntWritable, Text, IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values, Context context)

throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result);

}

}

```

#### 2.2.2 自定义Combiner的实现与优化

除了标准Combiner,开发者根据特定需求也可以自定义Combiner。这允许在更多样化的数据处理场景中发挥Combiner的作用。

在设计自定义Combiner时,必须保证Combiner的逻辑与Reduce逻辑兼容。例如,在计数累加的场景下,Combiner可以实现一个合并函数,将相同key的数据值合并为一个,然后传递到Reduce阶段进行最终的聚合计算。

```java

// 自定义Combiner示例

public static class CustomCombiner extends Reducer<Text, IntWritable, Text, IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values, Context context)

throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result);

}

}

```

在实际的代码中,自定义的Combiner函数需要在Job的配置中指定。

```java

// 配置Job使用自定义Combiner

job.setCombinerClass(CustomCombiner.class);

```

需要注意的是,Combiner虽然可以提升性能,但并不适用于所有MapReduce作业。对于那些在合并过程中不满足交换律和结合律的操作,使用Combiner可能会产生错误的结果。因此,在使用Combiner时,开发者必须仔细考虑其适用性。

此外,为有效利用Combiner,开发者还应该进行充分的测试和性能评估,确保其实施效果符合预期。

通过本章节的介绍,我们已经对Combiner组件有了一个全面的了解,下一章节我们将继续深入探讨如何在实践中选择和应用Combiner函数。

# 3. Combiner实践技巧

## 3.1 如何选择合适的Combiner函数

### 3.1.1 确定Combiner适用性

Combiner组件在MapReduce中扮演着重要的角色,它在Map阶段的输出和Reduce阶段的输入之间进行局部合并操作,以此减少传输到Reduce阶段的数据量,提高整体处理效率。确定合适的Combiner函数并非总是直截了当的,因为它依赖于数据的特性及处理逻辑。

选择合适的Combiner函数需要考虑以下几个因素:

- **数据的特性**:对于某些数据类型,如频率统计问题,Combiner能起到明显的优化作用。如果Map的输出是键值对形式,且相同的键对应多个值,使用Combiner能有效减少网络传输和磁盘IO。

- **MapReduce的中间输出格式**:如果中间输出数据量非常大,那么引入Combiner是明智的。但要注意,Combiner处理的是单个Map任务的输出,如果Map任务的输出数据本身就不大,那么引入Combiner可能并不会带来性能上的提升。

- **Combiner和Reducer的逻辑一致性**:Combiner的逻辑应当与Reducer的逻辑相同或兼容,这样Combiner的预处理结果在最终的Reduce阶段可以无缝对接。

### 3.1.2 参数设置和性能评估

为了更好地使用Combiner并评估其性能,需要进行一些参数设置和性能测试:

- **Combiner配置**:在Hadoop中,可以通过设置`***biner.input.window.factor`参数来控制Combiner的输入窗口比例。

- **性能测试**:进行性能测试以评估Combiner带来的性能提升。可以使用Hadoop自带的`mapred.job.tracker.administrative sağlıkl`工具,或者是自定义的测试脚本来比较引入Combiner前后的数据处理时间、IO读写量等指标。

- **监控和日志分析**:监控集群的性能指标,分析Combiner操作前后的日

0

0